Classification avec AutoML

Utilisez AutoML pour rechercher automatiquement le meilleur algorithme de classification et la configuration d’hyperparamètres pour prédire l’étiquette ou la catégorie d’une entrée donnée.

Configurer l’expérience de classification avec l’interface utilisateur

Vous pouvez configurer un problème de classification à l’aide de l’interface utilisateur AutoML en procédant comme suit :

Dans la barre latérale, sélectionnez Expériences.

Dans la carte de classification, sélectionnez Démarrer l’entraînement.

La page Configurer l’expérimentation AutoML s’affiche. Dans cette page, vous configurez le processus AutoML, en spécifiant le jeu de données, le type de problème, la cible ou la colonne d’étiquette à prédire, la mesure à utiliser pour évaluer et noter les exécutions d’expérimentation, ainsi que les conditions d’arrêt.

Dans le champ calcul, sélectionnez un cluster exécutant Databricks Runtime ML.

Sous Jeu de données, sélectionnez Parcourir.

Accédez à la table que vous souhaitez utiliser, puis cliquez sur Sélectionner. Le schéma de la table s’affiche.

- Dans Databricks Runtime 10.3 ML et les versions ultérieures, vous pouvez spécifier les colonnes qu’AutoML doit utiliser pour la formation. Vous ne pouvez pas supprimer la colonne sélectionnée en tant que cible de prédiction ou colonne de temps pour fractionner les données.

- Dans Databricks Runtime 10.4 LTS ML et les versions ultérieures, vous pouvez spécifier la façon dont les valeurs nulles sont imputées en effectuant une sélection dans la liste déroulante Imputer avec. Par défaut, AutoML sélectionne une méthode d’imputation en fonction du type et du contenu de la colonne.

Notes

Si vous spécifiez une méthode d’imputation autre que celle par défaut, AutoML n’effectue pas la détection de type sémantique.

Cliquez dans le champ cible de prédiction. Une liste déroulante apparaît et répertorie les colonnes affichées dans le schéma. Sélectionnez la colonne que le modèle doit prédire.

Le champ Nom de l'expérience affiche le nom par défaut. Pour le modifier, tapez le nouveau nom dans le champ.

Vous pouvez également :

- Spécifiez des options de configuration supplémentaires.

- Utilisez des tables de caractéristiques existantes dans le magasin de caractéristiques pour augmenter le jeu de données d’entrée d’origine.

Configurations avancées

Ouvrez la section Configuration avancée (facultative) pour accéder à ces paramètres.

- La mesure d’évaluation est la métrique principale utilisée pour noter les exécutions.

- Dans Databricks Runtime 10.4 LTS ML et versions ultérieures, vous pouvez exclure des infrastructures d’apprentissage. Par défaut, AutoML forme les modèles à l’aide d’infrastructures listées sous algorithmes AutoML.

- Vous pouvez modifier les conditions d’arrêt. Les conditions d’arrêt par défaut sont :

- Pour les expériences de prévision, arrêtez après 120 minutes.

- Dans Databricks Runtime 10.4 LTS ML et versions antérieures, pour les expériences de classification et de régression, arrêtez au bout de 60 minutes ou après avoir effectué 200 essais, selon la situation qui se produit en premier. Pour Databricks Runtime 11.0 ML et les versions ultérieures, le nombre d’essais n’est pas utilisé comme condition d’arrêt.

- Dans Databricks Runtime 10.4 LTS ML et versions ultérieures, pour les expériences de classification et de régression, AutoML intègre des arrêts précoces. il arrête les modèles d’apprentissage et d’ajustage si la mesure de validation ne s’améliore plus.

- Dans Databricks Runtime 10.4 LTS ML et versions ultérieures, vous pouvez sélectionner une

time columnoption permettant de fractionner les données pour l’apprentissage, la validation et les tests dans l’ordre chronologique (s’applique uniquement à la classification et à la régression). - Databricks recommande de ne pas remplir le champ répertoire de données. Cela déclenche le comportement par défaut qui consiste à stocker de manière sécurisée le jeu de données en tant qu’artefact MLflow. Un chemin d’accès DBFS peut être spécifié, mais dans ce cas, le jeu de données n’hérite pas des autorisations d’accès de l’expérience AutoML.

Exécuter l’expérience et vérifier les résultats

Pour démarrer l’expérience AutoML, cliquez sur Démarrer AutoML. L’expérimentation commence à s’exécuter et la page de formation AutoML s’affiche. Cliquez sur le  pour actualiser la liste.

pour actualiser la liste.

Afficher la progression de l’expérience

À partir de cette page, vous pouvez :

- Arrêtez l’expérience à tout moment.

- Ouvrez le bloc-notes d'exploration des données.

- Surveiller les exécutions.

- Accédez à la page d’exécution de toutes les exécutions.

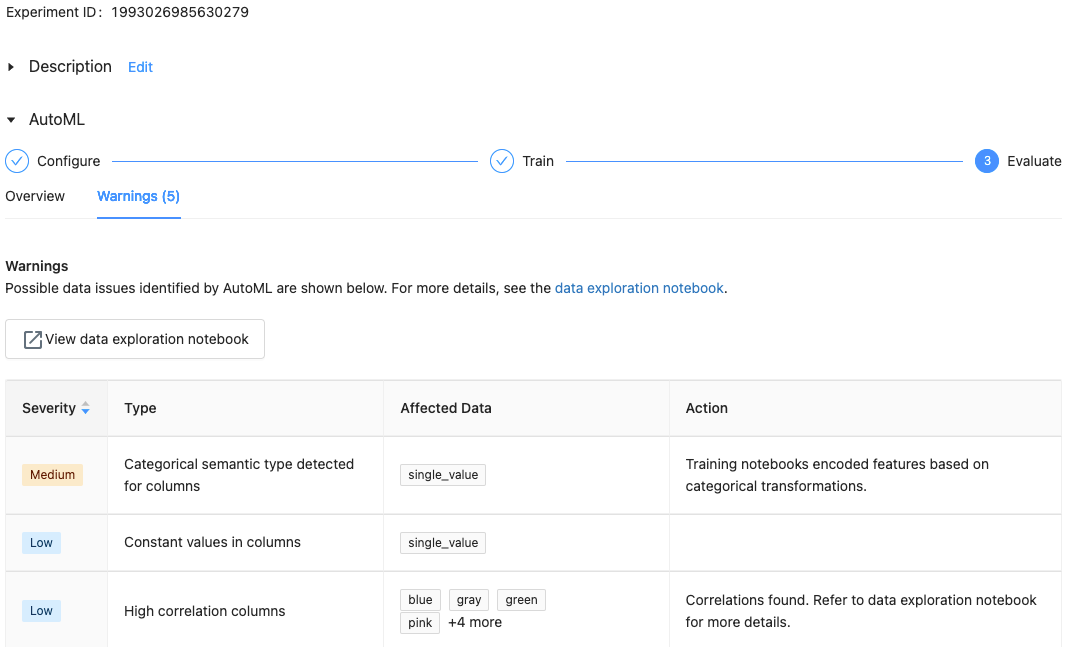

Avec Databricks Runtime 10.1 ML et versions ultérieures, AutoML affiche des avertissements pour les problèmes potentiels liés au jeu de données, tels que les types de colonnes non pris en charge ou les colonnes de cardinalité élevée.

Notes

Databricks fait de son mieux pour indiquer des erreurs ou des problèmes potentiels. Toutefois, cela n’est peut-être pas complet. Il est possible que les problèmes ou les erreurs que vous recherchez ne soient pas pris en compte.

Pour voir les avertissements du jeu de données, cliquez sur l’onglet Avertissements dans la page de formation, ou dans la page d’expérience une fois l’expérience terminée.

Afficher les résultats

Une fois l’expérience terminée, vous pouvez :

- Enregistrer et déployez l’un des modèles avec MLflow.

- Sélectionnez Afficher le notebook pour obtenir le meilleur modèle pour vérifier et modifier le notebook qui a créé le meilleur modèle.

- Sélectionnez afficher le notebook d’exploration des données pour ouvrir le notebook exploration de données.

- Recherchez, filtrez et triez les exécutions dans le tableau des exécutions.

- Affichez les détails de toutes les exécutions :

- Le notebook généré contenant du code source pour une exécution d’évaluation est disponible en cliquant sur l’exécution de MLflow. Le notebook est enregistré dans la section Artefacts de la page d’exécution. Vous pouvez télécharger ce notebook et l’importer dans l’espace de travail, à condition que le téléchargement des artefacts soit activé par les administrateurs de votre espace de travail.

- Pour voir les résultats de l’exécution, cliquez sur la colonne Modèles ou la colonne Heure de début. La page d’exécution apparaît, et affiche des informations sur l’exécution d’essai (par exemple les paramètres, les métriques et les balises) ainsi que les artefacts créés par l’exécution, notamment le modèle. Cette page comprend également des extraits de code que vous pouvez utiliser pour faire des prédictions avec le modèle.

Pour revenir à cette expérience AutoML ultérieurement, recherchez-la dans le tableau de la page expérimentations. Les résultats de chaque expérience AutoML, y compris les carnets d'exploration des données et d'entraînement, sont stockés dans un dossierdatabricks_automl du dossier personnel de l'utilisateur qui a réalisé l'expérience.

Inscrire et déployer un modèle

Vous pouvez inscrire et déployer votre modèle avec l’interface utilisateur AutoML :

- Sélectionnez le lien dans la colonne modèles pour le modèle à inscrire. À la fin d’une exécution, la ligne supérieure représente le meilleur modèle (en fonction de la métrique principale).

- Sélectionnez le

pour enregistrer le modèle dans le registre des modèles.

pour enregistrer le modèle dans le registre des modèles. - Sélectionnez

Modèles dans la barre latérale pour accéder au registre des modèles.

Modèles dans la barre latérale pour accéder au registre des modèles. - Sélectionnez le nom de votre modèle dans la table modèle.

- À partir de la page du modèle enregistré, vous pouvez mettre en service le modèle avec Mise en service de modèles.

Aucun module nommé 'pandas.core.indexes.numeric

Lors de la distribution d’un modèle créé à l’aide d’AutoML avec le service de modèle, vous pouvez obtenir l’erreur suivante : No module named 'pandas.core.indexes.numeric.

Cela est dû à une version pandas incompatible entre AutoML et l’environnement de point de terminaison de service du modèle. Vous pouvez résoudre cette erreur en exécutant le script add-pandas-dependency.py. Le script modifie requirements.txt et conda.yaml pour que votre modèle journalisé inclue la version de dépendance appropriée pandas : pandas==1.5.3

- Modifiez le script pour inclure le

run_idde l’exécution MLflow où votre modèle a été journalisé. - Réinscrire le modèle dans le registre de modèles MLflow.

- Essayez de servir la nouvelle version du modèle MLflow.