Architecture de cluster AKS Arc sur VMware (préversion) et cluster de charge de travail

S’applique à : AKS activé par Azure Arc sur VMware (préversion)

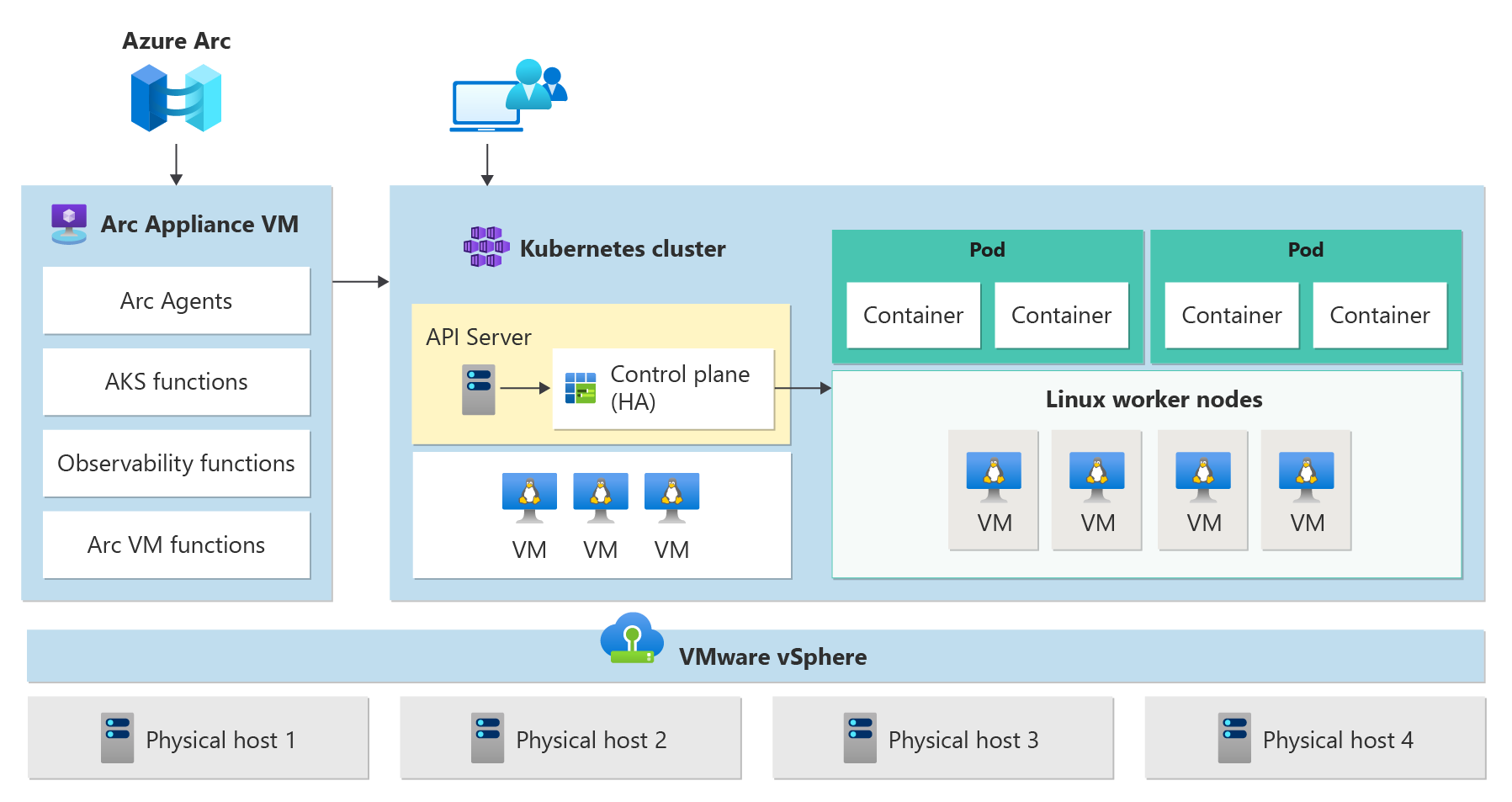

Cet article fournit une vue d’ensemble de l’architecture de cluster et des composants d’infrastructure clés de Kubernetes, tels que le plan de contrôle et les nœuds Worker, pour AKS activé par Azure Arc sur VMware.

Architecture du cluster

Un cluster Azure Kubernetes Service comprend les composants suivants :

- Arc Resource Bridge (également appelé appliance Arc) fournit le mécanisme d’orchestration et l’interface de base pour le déploiement et la gestion d’un ou plusieurs clusters de charge de travail.

- Les clusters de charge de travail (également appelés clusters cibles) sont l’endroit où les applications conteneurisées sont déployées.

AKS Arc utilise un ensemble d’options de configuration prédéfinies pour déployer efficacement des clusters Kubernetes et avec scalabilité à l’esprit. Une opération de déploiement crée plusieurs machines virtuelles Linux et les joint pour créer un ou plusieurs clusters Kubernetes.

Pont de ressources Arc

Arc Resource Bridge connecte un cloud privé (par exemple, Azure Local, VMWare/vSphere ou SCVMM) à Azure et active la gestion des ressources locales à partir d’Azure. Une fois connecté, vous pouvez configurer la plateforme d’orchestration de conteneurs dans AKS sur un environnement vSphere, qui est la plateforme de virtualisation VMware. Les deux principaux composants de vSphere sont ESXi et vCenter.

Azure Arc Resource Bridge offre la ligne de vue sur les clouds privés requis pour gérer des ressources telles que des clusters Kubernetes locaux via Azure. Arc Resource Bridge inclut les principaux composants AKS Arc suivants :

- Extensions de cluster AKS Arc : une extension de cluster est l’équivalent local d’un fournisseur de ressources Azure Resource Manager. Tout comme le fournisseur de ressources Microsoft.ContainerService gère les clusters AKS dans Azure, le fournisseur de ressources Microsoft.HybridContainerService permet à l’extension de cluster AKS Arc de gérer les clusters Kubernetes via Azure lorsqu’ils sont ajoutés à votre pont de ressources Arc.

- Emplacement personnalisé : un emplacement personnalisé est l’équivalent local d’une région Azure et est une extension de la construction d’emplacement Azure. Les emplacements personnalisés permettent aux administrateurs clients d’utiliser leur centre de données avec les extensions appropriées installées, en tant qu’emplacements cibles pour le déploiement d’instances de service Azure.

- Ressource vCenter : VMware vCenter est un logiciel de gestion de serveur qui fournit une plateforme centralisée pour contrôler les environnements vSphere. Les extensions Arc Resource Bridge et AKS communiquent avec le vCenter via l’API de cluster fournie par vSphere (CAPv), ce qui facilite la création de clusters de charge de travail. Chacune des ressources d’emplacement personnalisées est mappée à une instance de vCenter. Lorsque vous connectez votre vCenter à Azure, vous inscrivez également votre vCenter en tant que ressource Azure, qui est la ressource vCenter.

Pour obtenir une vue d’ensemble architecturale d’Azure Arc Resource Bridge, consultez la vue d’ensemble d’Azure Arc Resource Bridge. Pour chaque pont de ressources Azure Arc, vous pouvez gérer plusieurs instances vCenter en créant des ressources vCenter avec les emplacements personnalisés correspondants. Il existe une relation de mappage un-à-un entre les ressources vCenter et les emplacements personnalisés.

Clusters de charge de travail

Un cluster de charge de travail comporte de nombreux composants, comme décrit dans les sections suivantes.

Plan de contrôle

- Serveur d’API : le serveur d’API active l’interaction avec l’API Kubernetes. Ce composant fournit l’interaction pour les outils de gestion, tels qu’Azure CLI ou kubectl.

- Etcd : Etcd est un magasin de clés-valeur distribué qui stocke les données requises pour la gestion du cycle de vie du cluster. Il stocke l’état du plan de contrôle.

Équilibreur de charge

L’objectif principal d’un équilibreur de charge est de distribuer le trafic entre plusieurs nœuds dans un cluster Kubernetes. Cet équilibrage de charge peut aider à prévenir les temps d’arrêt et à améliorer les performances globales des applications.

La préversion d’AKS Arc sur VMware prend en charge les options suivantes pour déployer un équilibreur de charge pour votre cluster Kubernetes :

- Apportez votre propre équilibreur de charge tiers.

Nœuds worker

Pour exécuter vos applications et les services de prise en charge, vous avez besoin d’un nœud Kubernetes. Un cluster de charge de travail AKS a un ou plusieurs nœuds Worker. Les nœuds Worker agissent en tant que machines virtuelles qui exécutent les composants de nœud Kubernetes et hébergent les pods et les services qui composent la charge de travail de l’application.

Il existe des composants de charge de travail Kubernetes de base que vous pouvez déployer sur des clusters de charge de travail AKS, tels que des pods et des déploiements.

Avertissement

Pendant la préversion, la création et la gestion des pools de nœuds Windows ne sont pas prises en charge.

Gestion du cycle de vie

Azure Arc est automatiquement activé sur tous vos clusters Kubernetes créés à l’aide d’AKS Arc. Vous pouvez utiliser votre identité Microsoft Entra pour vous connecter à vos clusters depuis n’importe où. Azure Arc vous permet d’utiliser des outils familiers comme Azure CLI et les modèles Azure Resource Manager pour créer et gérer vos clusters Kubernetes.

Étapes suivantes

- Pour comprendre l’échelle de déploiement prise en charge pour l’exécution d’AKS Arc sur VMware, consultez l’échelle de déploiement prise en charge.

- Si votre vCenter n’est pas connecté à Azure Arc et que vous souhaitez ajouter l’extension AKS, consultez le guide de démarrage rapide : Connecter VMware vCenter Server à Azure Arc à l’aide du script d’aide.

- Si vous avez déjà connecté vCenter à Azure Arc et que vous souhaitez ajouter l’extension AKS, découvrez comment activer l’extension Kubernetes pour les opérateurs AKS Arc.