Déployer des modèles en tant qu’API serverless

Dans cet article, vous apprenez à déployer un modèle depuis le catalogue de modèles en tant qu’API serverless, avec un paiement basé sur l’utilisation et les jetons.

Important

Les modèles qui sont en préversion comportent la mention préversion sur leur carte dans le catalogue de modèles.

Certains modèles du catalogue de modèles peuvent être déployés en tant qu’API serverless avec facturation avec paiement à l’utilisation. Ce type de déploiement permet de consommer des modèles en tant qu’API sans les héberger sur votre abonnement, tout en conservant la sécurité et la conformité de l’entreprise dont les organisations ont besoin. Cette option de déploiement ne nécessite pas de quota à partir de votre abonnement.

Cet article utilise un déploiement de modèle Meta Llama en guise d’illustration. Toutefois, vous pouvez utiliser les mêmes étapes pour déployer l’un des modèles du catalogue de modèles disponibles pour le déploiement d’API serverless.

Prérequis

Un abonnement Azure avec un moyen de paiement valide. Les abonnements Azure gratuits ou d’essai ne fonctionnent pas. Si vous ne disposez pas d’un abonnement Azure, commencez par créer un compte Azure payant.

Les contrôles d’accès en fonction du rôle Azure (RBAC Azure) sont utilisés pour accorder l’accès aux opérations dans le portail Azure AI Foundry. Pour effectuer les étapes décrites dans cet article, votre compte d’utilisateur doit avoir le Rôle de développeur Azure AI sur le groupe de ressources. Pour plus d’informations sur les autorisations, consultez Contrôle d’accès en fonction du rôle dans le portail Azure AI Foundry.

Vous devez installer le logiciel suivant pour utiliser Azure AI Foundry :

Vous pouvez utiliser n’importe quel navigateur web compatible pour naviguer dans Azure AI Foundry.

Rechercher votre modèle et votre ID de modèle dans le catalogue de modèles

- Connectez-vous à Azure AI Foundry.

- Si vous n’êtes pas déjà dans votre projet, sélectionnez-le.

- Sélectionnez Catalogue de modèles dans le volet de navigation gauche.

Remarque

Pour les modèles proposés par le biais de la Place de marché Azure, vérifiez que votre compte dispose des autorisations de rôle Développeur Azure AI sur le groupe de ressources, ou que vous respectez les autorisations requises pour vous abonner aux offres de modèle.

Les modèles proposés par des fournisseurs autres que Microsoft (par exemple, les modèles Llama et Mistral) sont facturés via la Place de marché Azure. Pour ces modèles, vous devez abonner votre projet à l’offre de modèle spécifique. Les modèles proposés par Microsoft (par exemple, les modèles Phi-3) n’ont pas cette exigence, car la facturation est effectuée différemment. Pour plus d’informations sur la facturation du déploiement serverless de modèles dans le catalogue de modèles, consultez Facturation pour les API serverless.

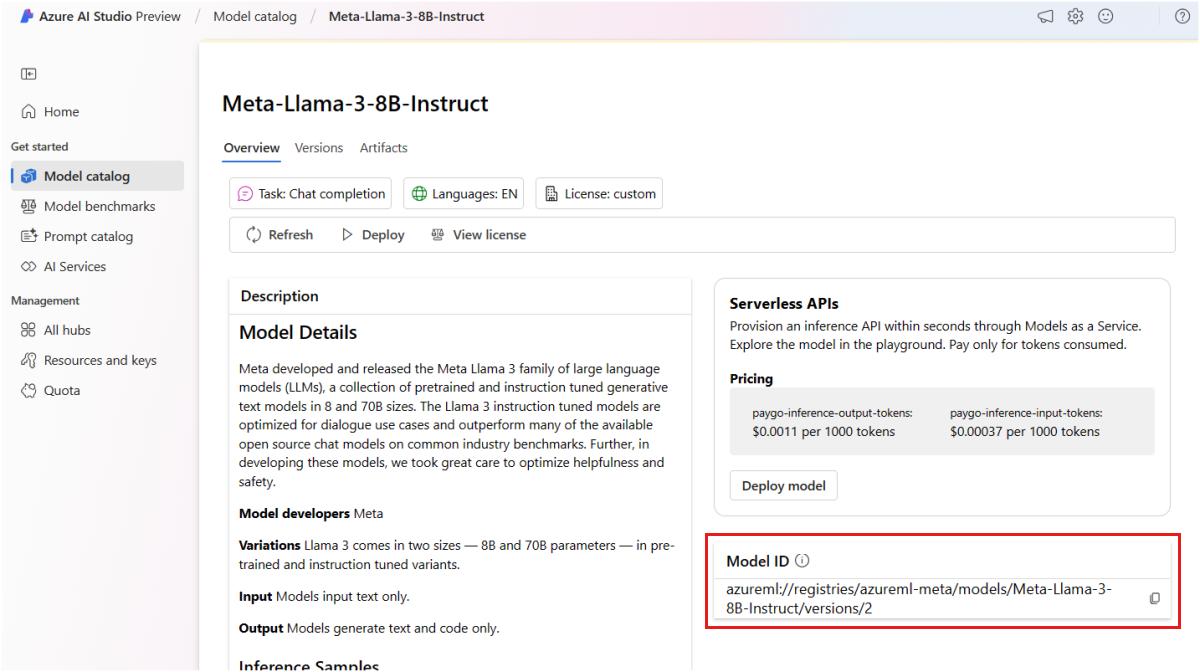

Sélectionnez la carte de modèle du modèle que vous souhaitez déployer. Dans cet article, vous sélectionnez un modèle Meta-Llama-3-8B-Instruct.

Si vous déployez le modèle en utilisant Azure CLI, Python ou ARM, copiez l’ID de modèle.

Important

N’incluez pas la version lors de la copie de l’ID de modèle. Les points de terminaison d’API serverless déploient toujours la version du modèle la plus récente disponible. Par exemple, pour l’ID de modèle

azureml://registries/azureml-meta/models/Meta-Llama-3-8B-Instruct/versions/3, copiezazureml://registries/azureml-meta/models/Meta-Llama-3-8B-Instruct.

La section suivante décrit les étapes d’abonnement de votre projet à une offre de modèle. Vous pouvez ignorer cette section et accéder à Déployer le modèle sur un point de terminaison d’API serverless, si vous déployez un modèle Microsoft.

Abonnez votre projet à l’offre de modèles

Les points de terminaison de l’API Serverless peuvent déployer à la fois des modèles proposés par Microsoft et des modèles non Microsoft. Pour les modèles Microsoft (tels que les modèles Phi-3), vous n’avez pas besoin de créer un abonnement Place de marché Azure et vous pouvez les déployer directement vers des points de terminaison d’API Serverless pour consommer leurs prévisions. Pour les modèles non-Microsoft, vous devez d’abord créer l’abonnement. Si c’est la première fois que vous déployez le modèle dans le projet, vous devez abonner votre projet à l’offre de modèle spécifique depuis la Place de marché Azure. Chaque projet a son propre abonnement à l’offre du modèle spécifique de la Place de marché Azure, ce qui vous permet de contrôler et de suivre les dépenses.

Conseil

Ignorez cette étape si vous déployez des modèles à partir de la famille de modèles Phi-3. Déployez directement le modèle sur un point de terminaison d’API serverless.

Remarque

Les modèles proposés via la Place de marché Azure peuvent être déployés vers des points de terminaison d’API serverless dans des régions spécifiques. Vérifiez la Disponibilité des régions et des modèles des déploiements d’API serverless pour vérifier quels régions et modèles sont disponibles. Si celle dont vous avez besoin n’est pas listée, vous pouvez déployer sur un espace de travail d’une région prise en charge, puis utiliser des points de terminaison d’API serverless depuis un autre espace de travail.

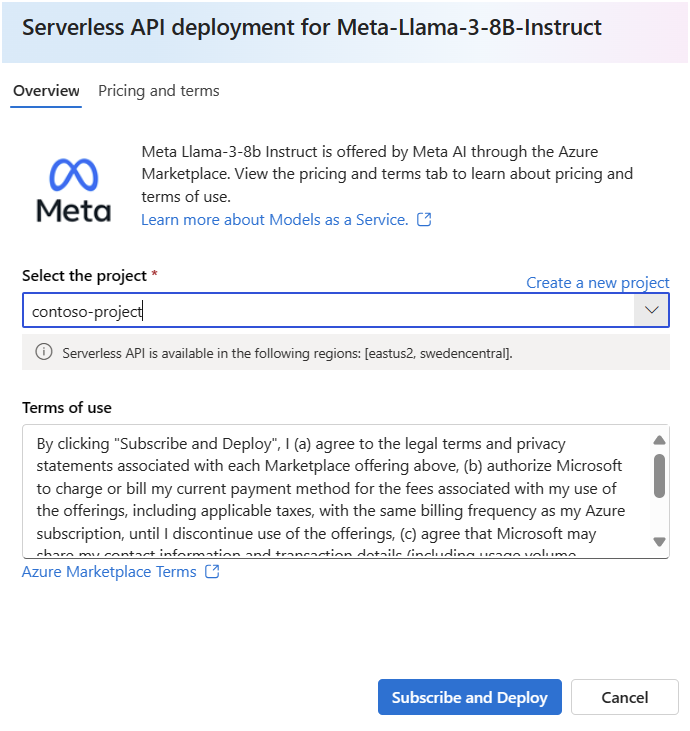

Créer l’abonnement à la Place de marché du modèle. Lorsque vous créez un abonnement, vous acceptez les conditions générales associées à l’offre de modèle.

Dans la page Détails du modèle, sélectionnez Déployer. Une fenêtre Options de déploiement s’ouvre et vous donne le choix entre un déploiement d’API serverless et un déploiement utilisant un calcul managé.

Remarque

Pour les modèles qui peuvent être déployés uniquement via un déploiement d’API serverless, l’Assistant Déploiement d’API serverless s’ouvre juste après que vous avez sélectionné Déployer dans la page des détails du modèle.

Sélectionnez API serverless avec Azure AI Sécurité du Contenu (préversion) pour ouvrir l’Assistant Déploiement d’API serverless.

Sélectionnez le projet dans lequel vous souhaitez déployer vos modèles. Pour utiliser l’offre de modèle de déploiement d’API serverless, votre projet doit appartenir à l’une des régions prises en charge pour le déploiement serverless pour le modèle particulier.

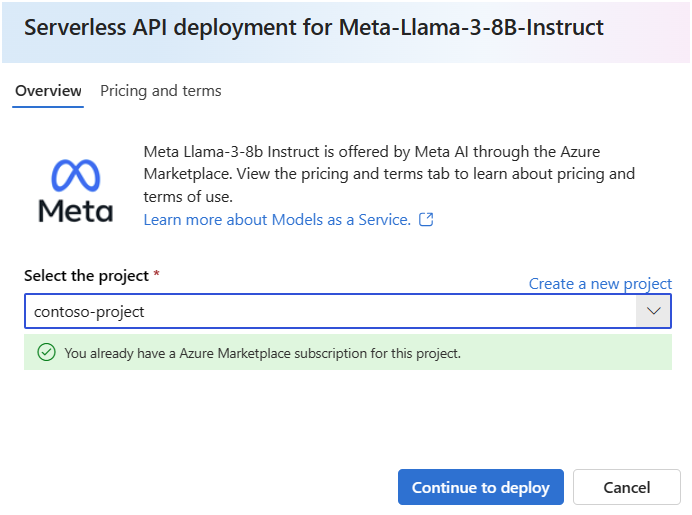

Si vous voyez la note Vous disposez déjà d’un abonnement à la Place de marché Azure pour ce projet, vous n’avez pas besoin de créer l’abonnement, car vous en avez déjà un. Vous pouvez continuer vers Déployer le modèle sur un point de terminaison d’API serverless.

Dans l’Assistant Déploiement, sélectionnez le lien vers les Conditions d’utilisation de la Place de marché Azure pour en savoir plus sur les conditions d’utilisation. Vous pouvez également sélectionner l’onglet Tarification et conditions pour en savoir plus sur la tarification du modèle sélectionné.

Sélectionnez S’abonner et se Déployer.

Une fois que vous avez abonné le projet à l’offre spécifique de la Place de marché Azure, les déploiements suivants de la même offre dans le même projet ne nécessitent pas un nouvel abonnement.

À tout moment, vous pouvez consulter les offres de modèle auxquelles votre projet est actuellement abonné :

Accédez au portail Azure.

Accédez au groupe de ressources auquel appartient le projet.

Dans le filtre Type, sélectionnez SaaS.

Vous voyez toutes les offres auxquelles vous êtes actuellement abonné.

Sélectionnez n’importe quelle ressource pour en afficher les détails.

Déployer le modèle sur un point de terminaison d’API serverless

Une fois que vous avez créé un abonnement pour un modèle autre que Microsoft, vous pouvez déployer le modèle associé sur un point de terminaison d’API serverless. Pour les modèles Microsoft (tels que les modèles Phi-3), vous n’avez pas besoin de créer d’abonnement.

Le point de terminaison d’API serverless fournit un moyen d’utiliser des modèles en tant qu’API sans les héberger dans votre abonnement, tout en conservant le niveau de sécurité professionnel et la conformité dont les organisations ont besoin. Cette option de déploiement ne nécessite pas de quota à partir de votre abonnement.

Dans cette section, vous allez créer un point de terminaison portant le nom meta-llama3-8b-qwerty.

Créer le point de terminaison serverless

Pour déployer un modèle Microsoft qui ne nécessite pas d’abonnement à une offre de modèle :

- Sélectionnez Déployer, puis API serverless avec Azure AI Sécurité du Contenu (préversion) pour ouvrir l’Assistant Déploiement.

- Sélectionnez le projet dans lequel vous souhaitez déployer votre modèle. Remarque : toutes les régions ne sont pas prises en charge.

Sinon, pour un modèle autre que Microsoft qui nécessite un abonnement à un modèle, si vous venez d’abonner votre projet à l’offre de modèle dans la section précédente, continuez à sélectionner Déployer. Vous pouvez également sélectionner Continuer à déployer (si votre Assistant Déploiement avait la note Vous disposez déjà d’un abonnement Place de marché Azure pour ce projet).

Donnez un nom au déploiement. Ce nom va faire partie de l’URL de l’API de déploiement. Cette URL doit être unique dans chaque région Azure.

Conseil

L’option Filtre de contenu (préversion) est activée par défaut. Conservez le paramètre par défaut pour le service afin de détecter des contenus dangereux tels que la haine, l’automutilation, le contenu sexuel et la violence. Pour plus d’informations sur le filtrage de contenu (préversion), consultez Filtrage de contenu dans le portail Azure AI Foundry.

Sélectionnez Déployer. Une fois que le déploiement est prêt, vous êtes redirigé vers la page Déploiements.

À tout moment, vous pouvez voir les points de terminaison déployés sur votre espace de travail :

Accédez à votre projet.

Dans la section Mes ressources , sélectionnez Modèles + points de terminaison.

Des points de terminaison d’API serverless sont affichés.

Le point de terminaison créé utilise une authentification par clé pour l’autorisation. Procédez comme suit pour obtenir les clés associées à un point de terminaison donné.

Vous pouvez sélectionner le déploiement et noter l’URL cibleet la clé du point de terminaison. Utilisez-les pour appeler le déploiement et générer des prédictions.

Remarque

Lorsque vous utilisez le Portail Azure, les points de terminaison d’API serverless ne sont pas affichés par défaut sur le groupe de ressources. Utilisez l’option Afficher les types masqués pour les afficher sur le groupe de ressources.

À ce stade, votre point de terminaison est prêt à être utilisé.

Si vous devez utiliser ce déploiement depuis un autre projet ou hub, ou si vous envisagez d’utiliser un flux d’invite pour créer des applications intelligentes, vous devez créer une connexion au déploiement d’API serverless. Pour savoir comment configurer un point de terminaison d’API serverless existant sur un nouveau projet ou hub, consultez la section Utiliser des points de terminaison d’API serverless déployés depuis un autre projet ou depuis un flux d’invite.

Conseil

Si vous utilisez un flux d’invite dans le même projet ou hub que celui où le déploiement a été déployé, vous devez toujours créer la connexion.

Utiliser le point de terminaison d’API serverless

Les modèles déployés dans Azure Machine Learning et Azure AI Foundry dans des points de terminaison d’API serverless prennent en charge l’API Inférence de modèle Azure AI, qui expose un ensemble commun de fonctionnalités pour les modèles fondamentaux et qui peut être utilisée par les développeurs pour consommer de façon uniforme et cohérente des prédictions provenant d’un ensemble varié de modèles.

En savoir plus sur les fonctionnalités de cette API et découvrir comment vous pouvez l’utiliser lors de la création d’applications.

Isolement réseau

Les points de terminaison pour les modèles déployés en tant qu’API serverless suivent la valeur de l’indicateur d’accès au réseau public (PNA) du hub du portail Azure AI Foundry dans lequel se trouve le déploiement. Pour sécuriser votre point de terminaison MaaS, désactivez l’indicateur accès au réseau public sur votre hub Azure AI Foundry. Vous pouvez sécuriser la communication entrante d’un client vers votre point de terminaison à l’aide d’un point de terminaison privé pour le hub.

Pour définir l’indicateur d’accès au réseau public pour le hub Azure AI Foundry :

- Accédez au portail Azure.

- Recherchez le groupe de ressources auquel appartient le hub, puis sélectionnez le hub Azure AI dans les ressources listées pour ce groupe de ressources.

- Dans la page Vue d’ensemble du hub dans le menu de gauche, sélectionnez Paramètres>Mise en réseau.

- Sous l’onglet Accès public, vous pouvez configurer les paramètres de l’indicateur d’accès réseau public.

- Enregistrez vos modifications. Vos modifications peuvent prendre jusqu’à cinq minutes pour se propager.

Supprimer des points de terminaison et des abonnements

Vous pouvez supprimer les abonnements et les points de terminaison de modèle. La suppression d’un abonnement à un modèle rend tout point de terminaison associé non sain et inutilisable.

Pour supprimer un point de terminaison d’API serverless :

Accédez à Azure AI Foundry.

Accédez à votre projet.

Dans la section Mes ressources , sélectionnez Modèles + points de terminaison.

Ouvrez le déploiement à supprimer.

Sélectionnez Supprimer.

Pour supprimer l’abonnement au modèle associé :

Accédez au Portail Azure.

Accédez au groupe de ressources auquel appartient le projet.

Dans le filtre Type, sélectionnez SaaS.

Sélectionnez l’abonnement à supprimer.

Sélectionnez Supprimer.

Considérations relatives aux coûts et aux quotas pour les modèles déployés en tant que points de terminaison d’API serverless

Le quota est géré par déploiement. Chaque déploiement a une limite de débit de 200 000 jetons par minute et 1 000 requêtes d’API par minute. Toutefois, nous limitons actuellement un déploiement par modèle par projet. Contactez le Support Microsoft Azure si les limites de débit actuelles ne suffisent pas pour vos scénarios.

Coût des modèles Microsoft

Vous trouverez les informations de tarification sous l’onglet Tarification et conditions de l’Assistant Déploiement lors du déploiement de modèles Microsoft (tels que les modèles Phi-3) en tant que points de terminaison d’API serverless.

Coût pour les modèles autres que Microsoft

Les modèles non-Microsoft déployés en tant que points de terminaison d’API serverless sont proposés via la Place de marché Azure et intégrés à Azure AI Foundry pour y être utilisés. Vous trouverez la tarification de la Place de marché Azure lors du déploiement ou de l’optimisation de ces modèles.

Chaque fois qu’un projet s’abonne à une offre donnée à partir de la Place de marché Azure, une nouvelle ressource est créée pour suivre les coûts associés à sa consommation. La même ressource est utilisée pour suivre les coûts associés à l’inférence et à l’optimisation ; plusieurs compteurs sont cependant disponibles pour suivre chaque scénario indépendamment.

Pour plus d’informations sur le suivi des coûts, consultez Surveiller les coûts des modèles proposés via la Place de marché Azure.

Autorisations requises pour s’abonner aux offres de modèles

Les contrôles d’accès en fonction du rôle Azure (RBAC Azure) sont utilisés pour accorder l’accès aux opérations dans le portail Azure AI Foundry. Pour effectuer les étapes de cet article, votre compte d’utilisateur doit avoir le rôle Propriétaire,Contributeur ou Développeur Azure AI attribué pour l’abonnement Azure. Une autre possibilité est que votre compte dispose d’un rôle personnalisé avec les autorisations suivantes :

Sur l’abonnement Azure – pour abonner l’espace de travail à l’offre de la Place de marché Azure, une fois pour chaque espace de travail, par offre :

Microsoft.MarketplaceOrdering/agreements/offers/plans/readMicrosoft.MarketplaceOrdering/agreements/offers/plans/sign/actionMicrosoft.MarketplaceOrdering/offerTypes/publishers/offers/plans/agreements/readMicrosoft.Marketplace/offerTypes/publishers/offers/plans/agreements/readMicrosoft.SaaS/register/action

Sur le groupe de ressources – pour créer et utiliser la ressource SaaS :

Microsoft.SaaS/resources/readMicrosoft.SaaS/resources/write

Sur l’espace de travail – pour déployer des points de terminaison (le rôle Scientifique des données Azure Machine Learning a déjà ces autorisations) :

Microsoft.MachineLearningServices/workspaces/marketplaceModelSubscriptions/*Microsoft.MachineLearningServices/workspaces/serverlessEndpoints/*

Pour plus d’informations sur les autorisations, consultez Contrôle d’accès en fonction du rôle dans le portail Azure AI Foundry.