Comment configurer des filtres de contenu avec Azure AI Foundry

Le système de filtrage de contenu intégré dans Azure AI Foundry s’exécute en même temps que les modèles de base, notamment les modèles de génération d’image DALL-E. Il utilise un ensemble de modèles de classification multiclasse pour détecter quatre catégories de contenu dangereux (violence, haine, sexualité et automutilation) à quatre niveaux de gravité respectivement (sûr, faible, moyen et élevé) et des classificateurs binaires facultatifs pour détecter le risque de jailbreak, le texte existant et le code dans les référentiels publics.

La configuration du filtrage du contenu par défaut est définie pour filtrer au niveau de gravité moyen pour les quatre catégories de contenu pour les invites et les achèvements. Par conséquent, le contenu détecté au niveau de gravité moyen ou élevé est filtré, tandis que le contenu détecté au niveau de gravité faible ou sûr n’est pas filtré par les filtres de contenu. En savoir plus sur les catégories de contenu, les niveaux de gravité et le comportement du système de filtrage de contenu ici.

La détection des risques de jailbreak et les modèles de texte et de code protégés sont des modèles facultatifs et désactivés par défaut. Pour les modèles de texte et de code matériels de jailbreak et protégés, la fonctionnalité de configuration permet à tous les clients d’activer et de désactiver les modèles. Les modèles sont désactivés par défaut et peuvent être activés selon votre scénario. Certains modèles doivent être activés pour certains scénarios afin de conserver la couverture en vertu de l’Engagement de copyright du client.

Remarque

Tous les clients ont la possibilité de modifier les filtres de contenu et de configurer les seuils de gravité (bas, moyen, élevé). Une autorisation est requise pour désactiver partiellement ou totalement les filtres de contenu. Seuls les clients gérés peuvent demander un contrôle de filtrage de contenu complet via ce formulaire : Révision d’accès limité Azure OpenAI : filtres de contenu modifiés. Il n’est pas possible de devenir un client géré à l’heure actuelle.

Les filtres de contenu peuvent être configurés au niveau de la ressource. Une fois qu’une configuration est créée, elle peut être associée à un ou plusieurs déploiements. Pour plus d’informations sur le déploiement de modèle, consultez le guide de déploiement de ressources.

Prérequis

- Pour configurer les filtres de contenu, vous devez disposer d’une ressource Azure OpenAI et d’un déploiement de grands modèles de langage (LLM). Pour bien démarrer, suivez un guide de démarrage rapide.

Comprendre la configuration du filtre de contenu

Azure OpenAI Service intègre des paramètres de sécurité par défaut appliqués à tous les modèles, à l’exception d’Azure OpenAI Whisper. Ces configurations vous offrent une expérience responsable par défaut, notamment des modèles de filtrage de contenu, des listes de blocage, la transformation d’invites, desles modèles de filtrage de contenu, et bien d’autres encore. Apprenez-en plus à ce sujet ici.

Tous les clients peuvent également configurer des filtres de contenu et créer des stratégies de sécurité personnalisées adaptées aux exigences de leurs cas d’utilisation. La fonctionnalité de configurabilité permet aux clients d’ajuster les paramètres, séparément pour les prompts et les achèvements, afin de filtrer le contenu pour chaque catégorie de contenu à différents niveaux de gravité, comme décrit dans le tableau ci-dessous. Le contenu détecté au niveau de gravité « sûr » est étiqueté dans les annotations, mais n’est pas soumis à un filtrage et n’est pas configurable.

| Gravité filtrée | Configurable pour les invites | Configurable pour la saisie semi-automatique | Descriptions |

|---|---|---|---|

| Faible, moyen, élevé | Oui | Oui | Configuration de filtrage la plus stricte. Le contenu détecté aux niveaux de gravité bas, moyen et élevé est filtré. |

| Moyen, élevé | Oui | Oui | Le contenu détecté au niveau de gravité faible n’est pas filtré. Le contenu moyen et élevé est filtré. |

| Élevé | Oui | Oui | Le contenu détecté aux niveaux de gravité faible et moyen n'est pas filtré. Seul le contenu au niveau de gravité élevé est filtré. |

| Aucun filtre | En cas d’approbation1 | En cas d’approbation1 | Aucun contenu n’est filtré quel que soit le niveau de gravité détecté. Nécessite une approbation1. |

| Annoter seulement | En cas d’approbation1 | En cas d’approbation1 | Désactive la fonctionnalité de filtrage de sorte que le contenu n’est pas bloqué, mais les annotations sont retournées par la réponse de l’API. Nécessite une approbation1. |

1 Pour les modèles Azure OpenAI, seuls les clients qui ont été approuvés pour le filtrage de contenu modifié disposent d’un contrôle total du filtrage de contenu et peuvent désactiver les filtres de contenu. Demander des filtres de contenu modifiés via ce formulaire : Révision d’accès limité Azure OpenAI : filtres de contenu modifiés. Pour les clients Azure Government, appliquez des filtres de contenu modifiés via ce formulaire : Azure Government – Demander un filtrage de contenu modifié pour Azure OpenAI Service.

Les filtres de contenu configurables pour les entrées (prompts) et les sorties (complétions) sont disponibles pour les modèles Azure OpenAI suivants :

- Série de modèles GPT

- Disponibilité générale* GPT-4 Turbo Vision (

turbo-2024-04-09) - GPT-4o

- GPT-4o mini

- DALL-E 2 et 3

Les filtres de contenu configurables ne sont pas disponibles pour

- o1-preview

- o1-mini

*Disponible uniquement pour GPT-4 Turbo Vision GA, ne s’applique pas à la préversion de GPT-4 Turbo Vision

Les configurations de filtrage de contenu sont créées dans une ressource dans le portail Azure AI Foundry et peuvent être associées à des déploiements. Apprenez-en plus sur la configuration ici.

Les clients sont chargés de s’assurer que les applications intégrant Azure OpenAI sont conformes au Code de conduite.

Comprendre les autres filtres

En plus des catégories de filtres par défaut, vous pouvez configurer les catégories de filtres suivantes.

| Catégorie de filtre | État | Paramètre par défaut | Appliqué à l’invite ou à la saisie semi-automatique ? | Description |

|---|---|---|---|---|

| Boucliers contre les prompts utilisés pour les attaques directes (jailbreak) | GA | Activé | Invite utilisateur | Filtre/annote les prompts utilisateur susceptibles de présenter un risque de jailbreak. Pour plus d’informations sur les annotations, consultez Filtrage de contenu d’Azure AI Foundry. |

| Boucliers contre les prompts utilisés pour les attaques indirectes | GA | Désactivé | Invite utilisateur | Filtre/annote les attaques indirectes, également appelées attaques par prompt indirectes ou attaques par injection de prompt inter-domaines, une vulnérabilité potentielle dans laquelle des tiers placent des instructions malveillantes à l’intérieur de documents auxquels le système d’IA générative peut accéder et traiter. Nécessite : Incorporation et mise en forme de documents. |

| Matériel protégé – code | GA | Activé | Completion | Filtre le code protégé ou obtient l’exemple de citation et les informations de licence dans les annotations pour les extraits de code qui correspondent à n’importe quelle source de code publique (avec GitHub Copilot). Pour plus d’informations sur l’utilisation des annotations, consultez le guide des concepts de filtrage de contenu |

| Matériel protégé – texte | GA | Activé | Completion | Identifie et bloque l’affichage de texte connu dans la sortie du modèle (par exemple, les paroles de chansons, les recettes et le contenu web sélectionné). |

| Fondement* | Aperçu | Désactivé | Completion | Détecte si les réponses textuelles des grands modèles de langage (LLM) sont fondées sur les documents sources fournis par les utilisateurs. L’absence de fondement fait référence aux instances où les LLM produisent des informations non factuelles ou inexactes à partir de ce que contenaient les documents sources. Nécessite : Incorporation et mise en forme de documents. |

Créer un filtre de contenu dans Azure AI Foundry

Pour n’importe quel modèle de déploiement dans Azure AI Foundry, vous pouvez utiliser directement le filtre de contenu par défaut, mais vous souhaiterez peut-être avoir plus de contrôle. Par exemple, vous pouvez rendre un filtre plus ou moins strict, ou activer des fonctionnalités plus avancées telles que les boucliers d’invite et la détection de matériel protégé.

Conseil

Pour obtenir des conseils d’aide sur les filtres de contenu dans votre projet Azure AI Foundry, consultez Filtrage de contenu Azure AI Foundry.

Pour créer un filtre de contenu, effectuez les étapes suivantes :

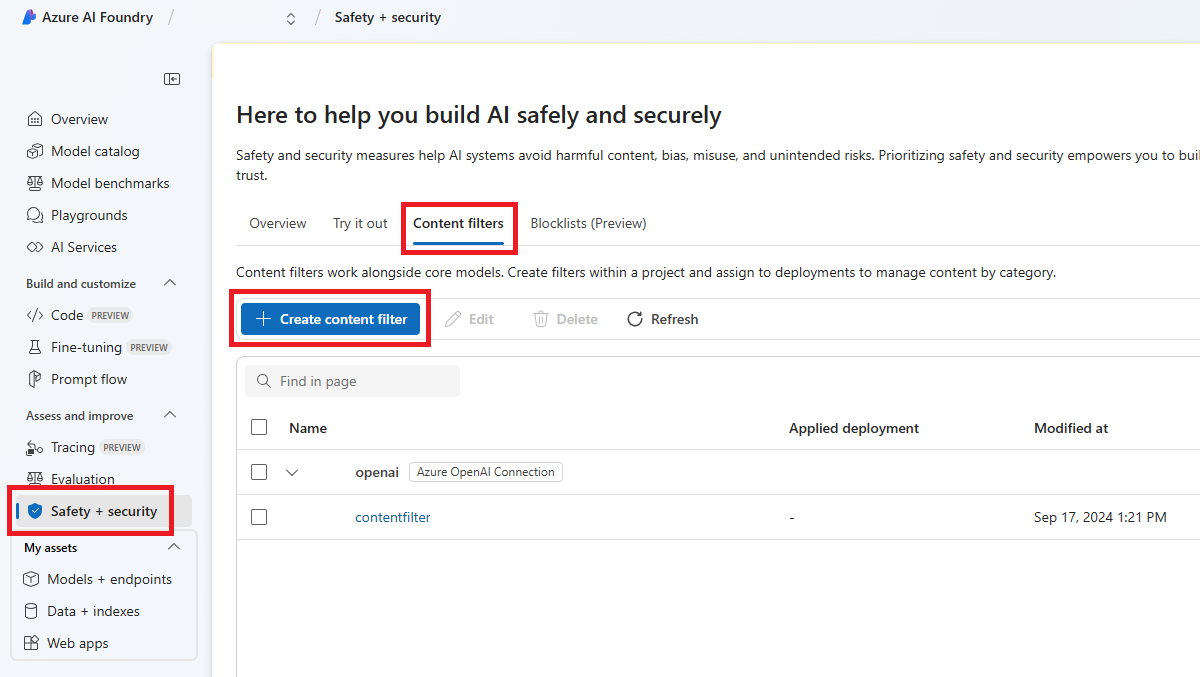

Accédez à Azure AI Foundry et naviguez jusqu’à votre projet. Sélectionnez ensuite la page Sécurité dans le menu de gauche, puis l'onglet Filtres de contenu.

Sélectionnez + Créer un filtre de contenu.

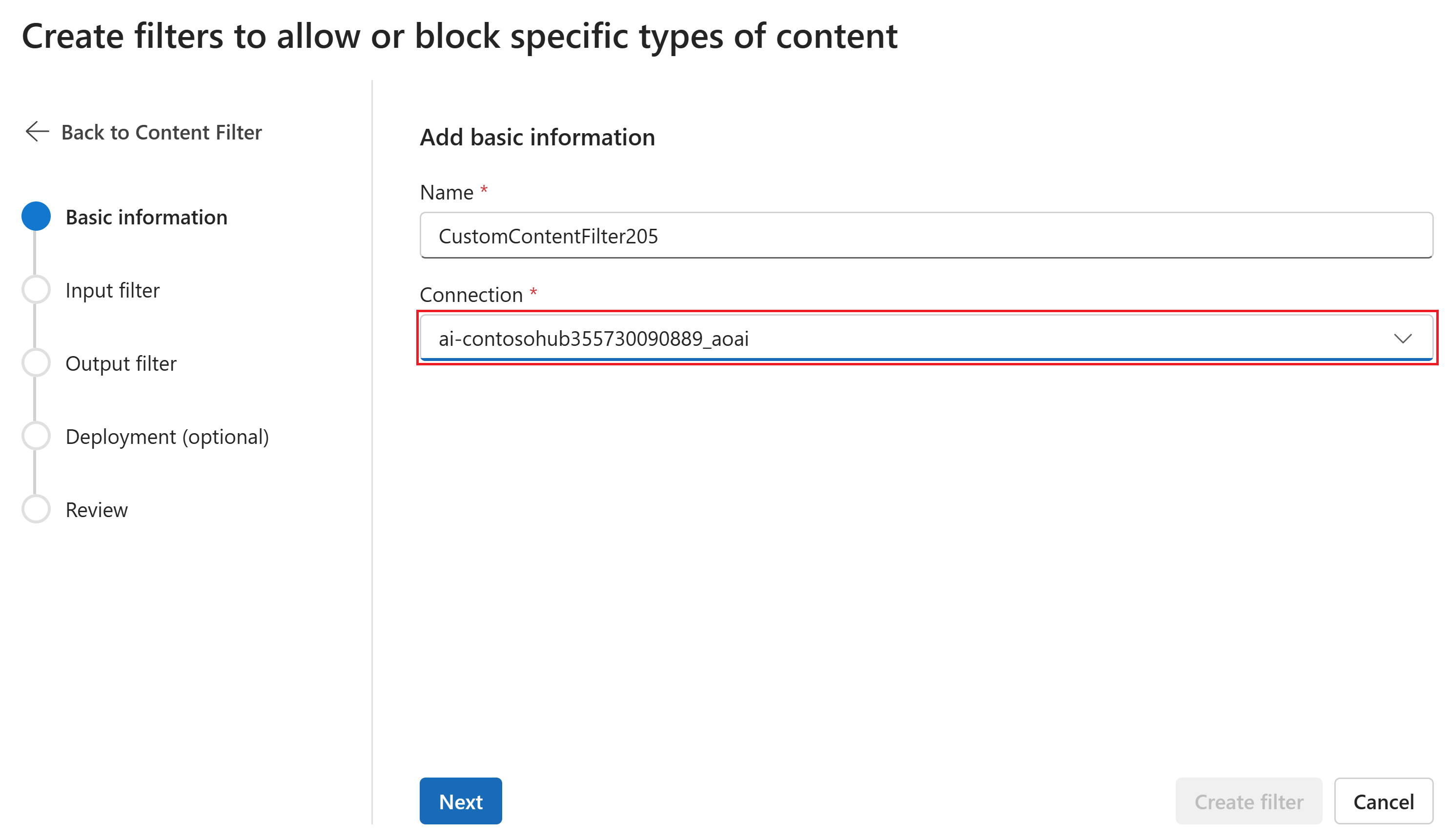

Sur la page Informations de base, saisissez un nom pour votre configuration de filtrage de contenu. Sélectionnez une connexion à associer au filtre de contenu. Sélectionnez ensuite Suivant.

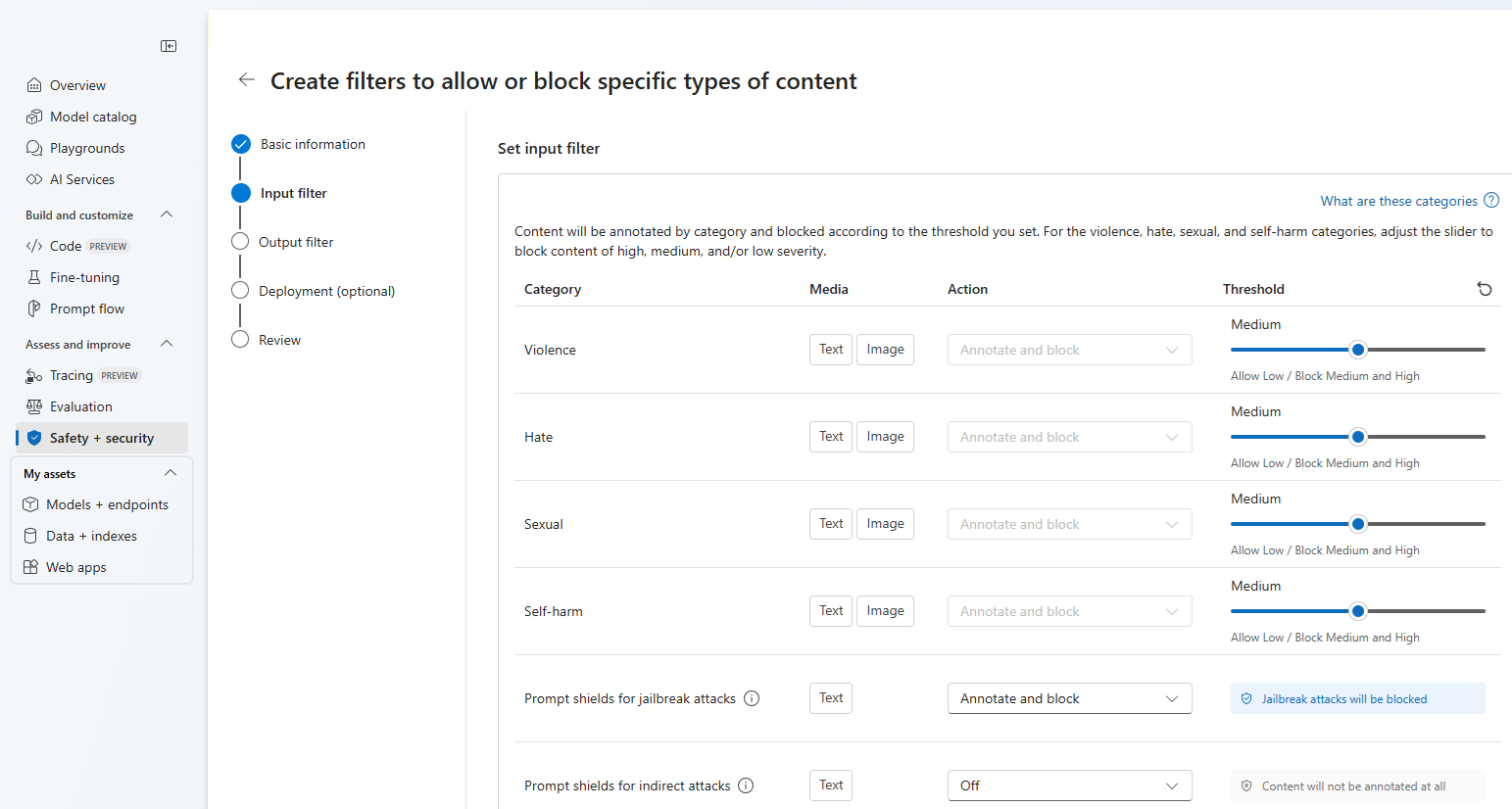

Vous pouvez maintenant configurer les filtres d'entrée (pour les invites utilisateur) et les filtres de sortie (pour l'achèvement du modèle).

Sur la page Filtres d’entrée, vous pouvez définir le filtre pour l’invite d’entrée. Pour les quatre premières catégories de contenu, il existe trois niveaux de gravité configurables : faible, moyen et élevé. Vous pouvez utiliser les curseurs pour définir le seuil de gravité si vous déterminez que votre application ou votre scénario d’utilisation nécessite un filtrage différent des valeurs par défaut. Certains filtres, par exemple les boucliers de requête et la détection de matériel protégé, vous permettent de déterminer si le modèle doit annoter et/ou bloquer le contenu. Le fait de sélectionner Annoter seulement permet d’exécuter le modèle correspondant et de retourner les annotations via la réponse d’API, mais cela n’entraîne pas de filtrage du contenu. En plus d’annoter, vous pouvez également choisir de bloquer du contenu.

Si votre cas d’usage a été approuvé pour les filtres de contenu modifiés, vous disposez d’un contrôle total sur les configurations de filtrage de contenu, et vous avez le choix entre désactiver partiellement ou totalement le filtrage, ou activer seulement l’annotation pour les catégories de contenu nuisible (violence, haine, contenu à caractère sexuel et automutilation).

Le contenu est annoté par catégorie et bloqué en fonction du seuil que vous définissez. Pour les catégories violence, haine, sexuel et automutilation, ajustez le curseur pour bloquer le contenu de gravité haute, moyenne ou faible.

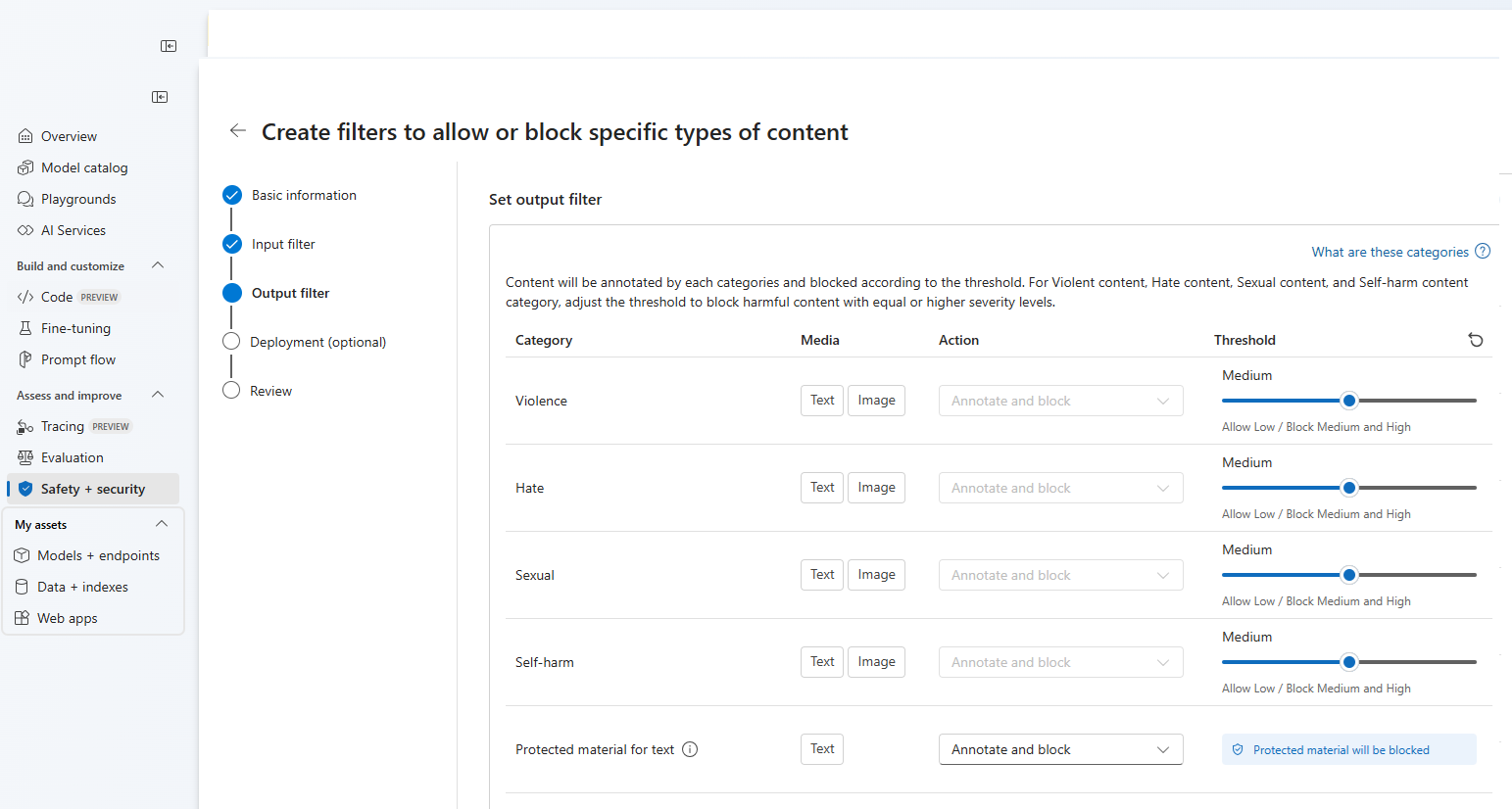

Sur la page Filtres de sortie, vous pouvez configurer le filtre de sortie, qui sera appliqué à tout le contenu de sortie généré par votre modèle. Configurez les filtres individuels comme avant. Cette page propose également l’option Mode de diffusion en continu, qui vous permet de filtrer le contenu en quasi-temps réel au fur et à mesure qu’il est généré par le modèle, réduisant ainsi la latence. Lorsque vous avez terminé, sélectionnez Suivant.

Le contenu est annoté pour chaque catégorie et bloqué en fonction du seuil. Pour le contenu violence, haine, sexuel et automutilation, ajustez le seuil pour bloquer le contenu dangereux avec des niveaux de gravité égaux ou supérieurs.

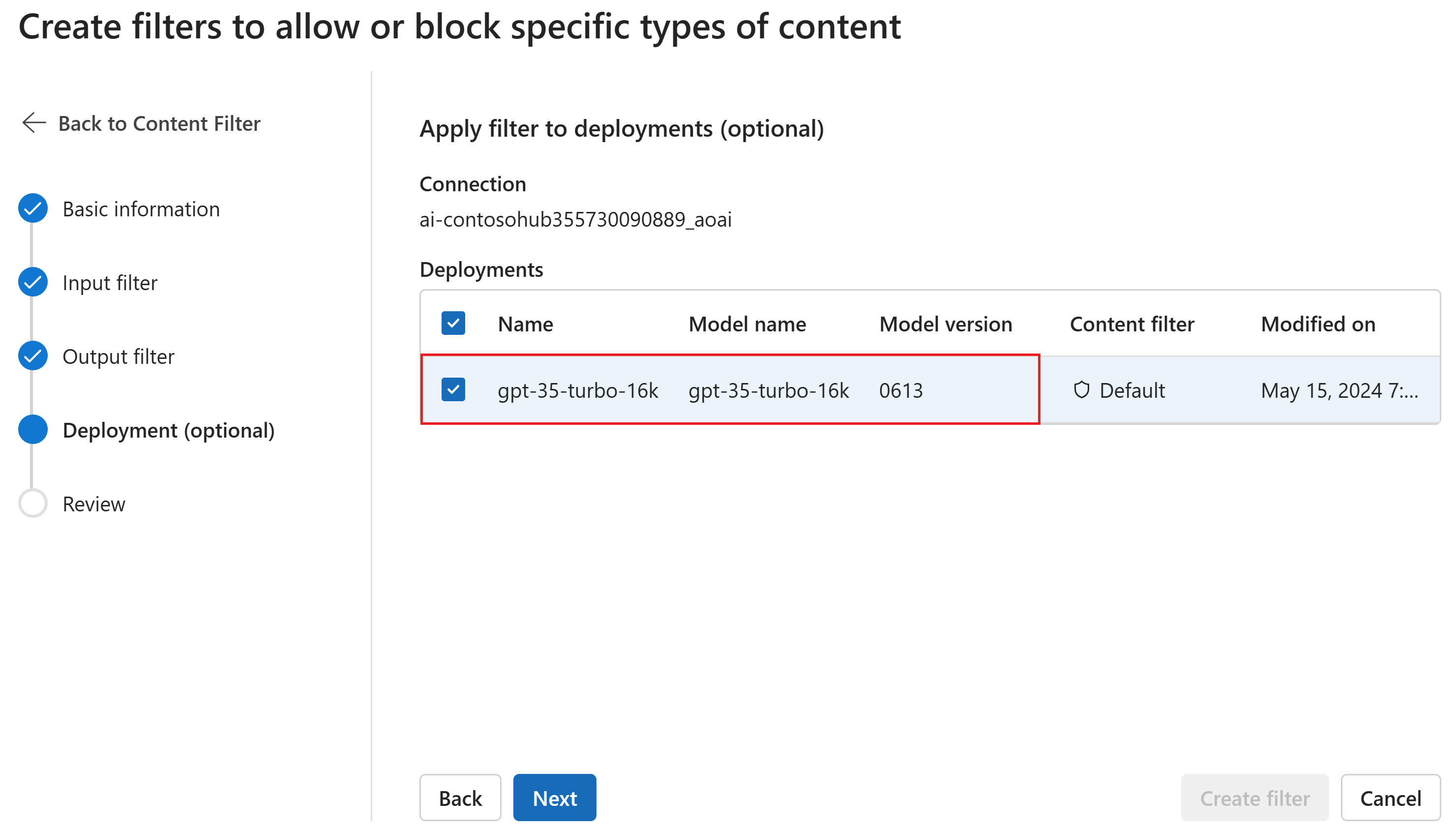

Si vous le souhaitez, sur la page Déploiement, vous pouvez associer le filtre de contenu à un déploiement. Si un déploiement sélectionné a déjà un filtre attaché, vous devez confirmer que vous souhaitez le remplacer. Vous pouvez également associer le filtre de contenu à un déploiement ultérieurement. Sélectionnez Créer.

Les configurations de filtrage de contenu sont créées au niveau du hub dans le portail Azure AI Foundry. En savoir plus sur les possibilités de configuration dans le service de documentation Azure OpenAI Service.

Sous l’onglet Vérifier, passez en revue les paramètres, puis sélectionnez Créer le filtre.

Utilisation d’une liste de blocage comme filtre

Vous pouvez appliquer une liste de blocage en tant que filtre d’entrée ou de sortie, ou les deux. Activez l’option Liste de blocage sur la page Filtre d’entrée et/ou Filtre de sortie. Sélectionnez une ou plusieurs listes de blocage dans la liste déroulante, ou utilisez la liste de blocage de profanité intégrée. Vous pouvez combiner plusieurs listes de blocage dans le même filtre.

Application d’un filtre de contenu

Le processus de création de filtre vous donne la possibilité d’appliquer le filtre aux déploiements que vous souhaitez. Vous pouvez également modifier ou supprimer les filtres de contenu de vos déploiements à tout moment.

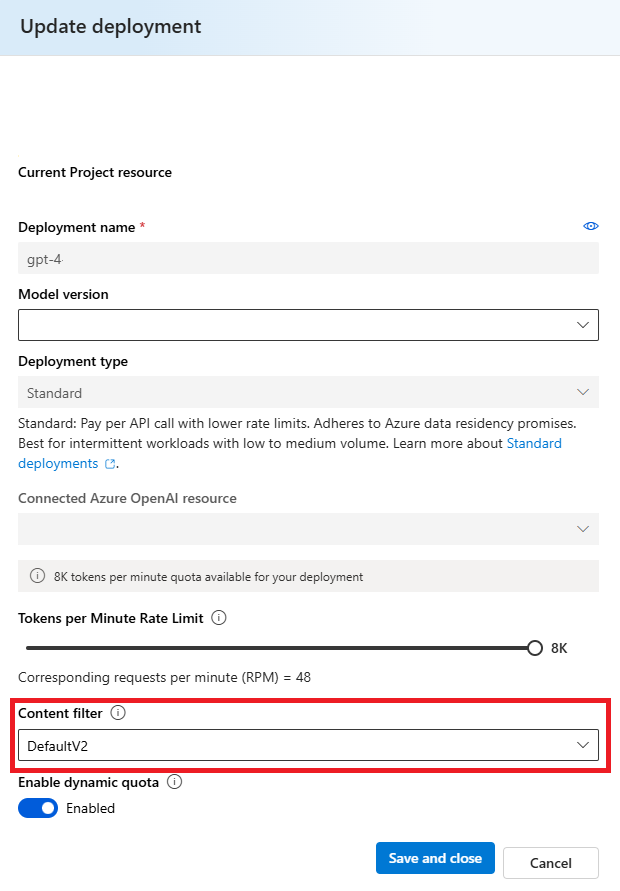

Procédez comme suit pour appliquer un filtre de contenu à un déploiement :

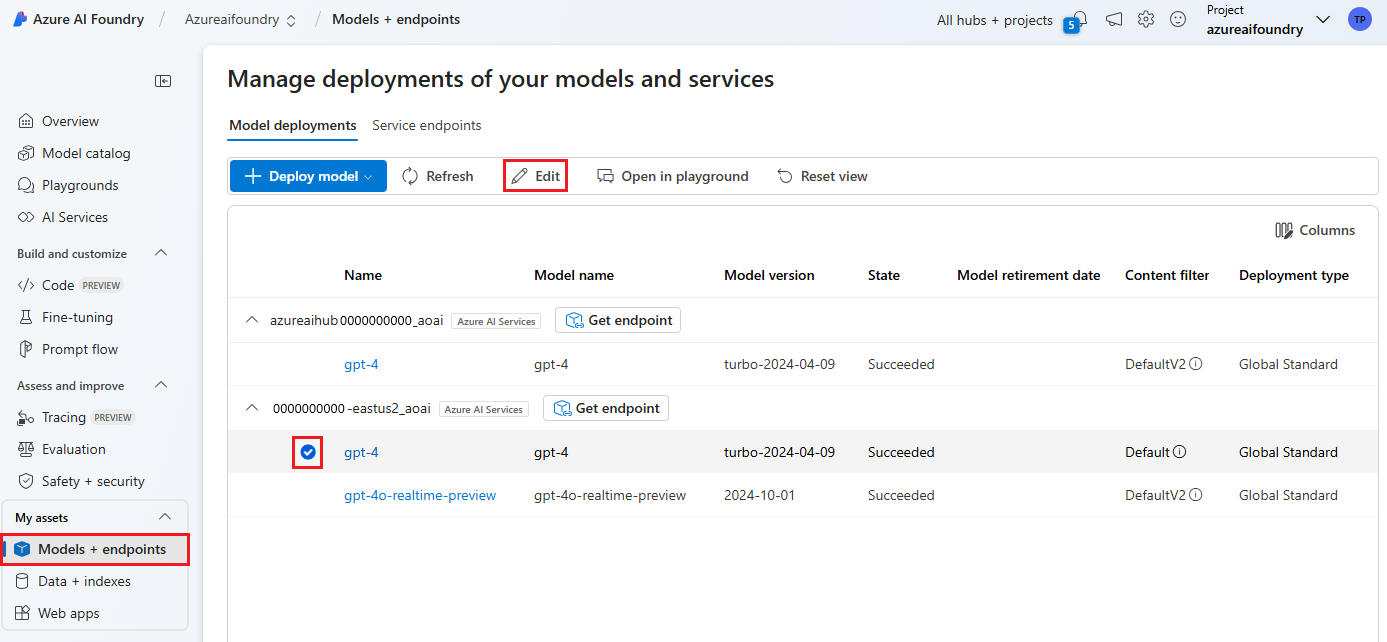

Accédez à Azure AI Foundry et sélectionnez un projet.

Sélectionnez Modèles + points de terminaison dans le volet gauche, puis choisissez l’un de vos déploiements, puis sélectionnez Modifier.

Dans la fenêtre Mettre à jour le déploiement, sélectionnez le filtre de contenu que vous souhaitez appliquer au déploiement. Sélectionnez ensuite Enregistrer et fermer.

Vous pouvez également modifier et supprimer une configuration de filtre de contenu si nécessaire. Avant de supprimer une configuration de filtrage de contenu, vous devez cesser de l’affecter et la remplacer dans tous les déploiements sous l’onglet Déploiements.

Maintenant, vous pouvez accéder au terrain de jeu pour tester si le filtre de contenu fonctionne comme prévu.

Envoyer des commentaires sur le filtrage de contenu

Si vous rencontrez un problème de filtrage de contenu, sélectionnez le bouton Envoyer des commentaires en haut du playground. Cette option est activée dans le terrain de jeu Images, conversation et génération.

Quand la boîte de dialogue s’affiche, sélectionnez le problème de filtrage de contenu approprié. Incluez autant de détails que possible concernant votre problème de filtrage de contenu, par exemple la requête exacte et l’erreur de filtrage de contenu spécifique que vous avez rencontrées. N’incluez aucune information privée ou sensible.

Pour accéder au support, soumettez un ticket de support.

Suivre les bonnes pratiques

Nous vous recommandons de prendre vos décisions de configuration de filtrage de contenu sur la base d’une identification itérative (par exemple, des tests d’équipe rouge, des tests de contrainte et l’analyse) et d’un processus de mesure pour résoudre les dommages potentiels pertinents pour un modèle, une application et un scénario de déploiement spécifiques. Après avoir implémenté des atténuations telles que le filtrage de contenu, répétez la mesure pour tester l’efficacité. Vous trouverez des recommandations et des meilleures pratiques pour l’IA responsable pour Azure OpenAI, qui sont ancrées dans la norme d’IA responsable de Microsoft dans Vue d’ensemble de l’IA responsable pour Azure OpenAI.

Contenu connexe

- En savoir plus sur les pratiques d’IA responsable pour Azure OpenAI : Vue d’ensemble des pratiques d’IA responsable pour les modèles Azure OpenAI.

- En savoir plus sur les catégories de filtrage de contenu et les niveaux de gravité avec Azure AI Foundry.

- Pour en savoir plus sur le « red teaming », consultez notre article Introduction aux modèles LLM (Large Language Models) Red Teaming.