Apache Sparkin laskutus ja käyttöraportointi Microsoft Fabricissa

Koskee seuraavia:✅ Microsoft Fabricin tietotekniikka ja datatiede

Tässä artikkelissa esitellään ApacheSparkin tietojenkäsittelyn käyttö ja raportointi, joka hyödyntää Microsoft Fabricin Fabric-tietotekniikka- ja tiedekuormituksia. Laskenta sisältää Lakehouse-toiminnot, kuten taulukon esikatselun, kuormituksen deltaan, muistikirjasuoritukset liittymästä, ajoitetut suoritukset, muistikirjavaiheiden käynnistämät suoritukset jaksoissa ja Apache Spark -työmäärityksen suoritukset.

Kuten muissakin Microsoft Fabricin käyttökokemuksissa, tietotekniikka käyttää myös työtilaan liittyvää kapasiteettia näiden töiden suorittamiseen, ja yleiset kapasiteettimaksusi näkyvät Azure-portaali Microsoft Cost Management -tilauksessasi. Lisätietoja Fabric-laskutuksen käytöstä on artikkelissa Tutustu Azure-laskuusi Fabric-kapasiteetissa.

Fabric-kapasiteetti

Sinä voit käyttäjänä ostaa Fabric-kapasiteettia Azuresta määrittämällä sen Azure-tilauksen avulla. Kapasiteetin koko määrittää käytettävissä olevan laskentatehon määrän. Jos kyseessä on Apache Spark for Fabric, jokainen ostettu CU tarkoittaa 2 Apache Spark VCorea. Jos esimerkiksi ostat Fabric-kapasiteetin F128, se tarkoittaa 256 SparkVCorea. Fabric-kapasiteetti jaetaan kaikkiin siihen lisättyihin työtiloihin, ja siinä sallittu Apache Spark -laskennan kokonaismäärä jaetaan kaikkiin työtiloihin, jotka on lähetetty kaikista kapasiteettiin liittyvistä työtiloista. Lisätietoja eri varastointiyksiköistä, ytimien varaamisesta ja spark-rajoituksen rajoittamisesta on artikkelissa Samanaikaisuusrajat ja jonottaminen Microsoft Fabricin Apache Sparkissä.

Spark-käsittelymääritykset ja ostettu kapasiteetti

Apache Spark -käsittely kankaalle tarjoaa kaksi vaihtoehtoa käsittelymäärityksen suhteen.

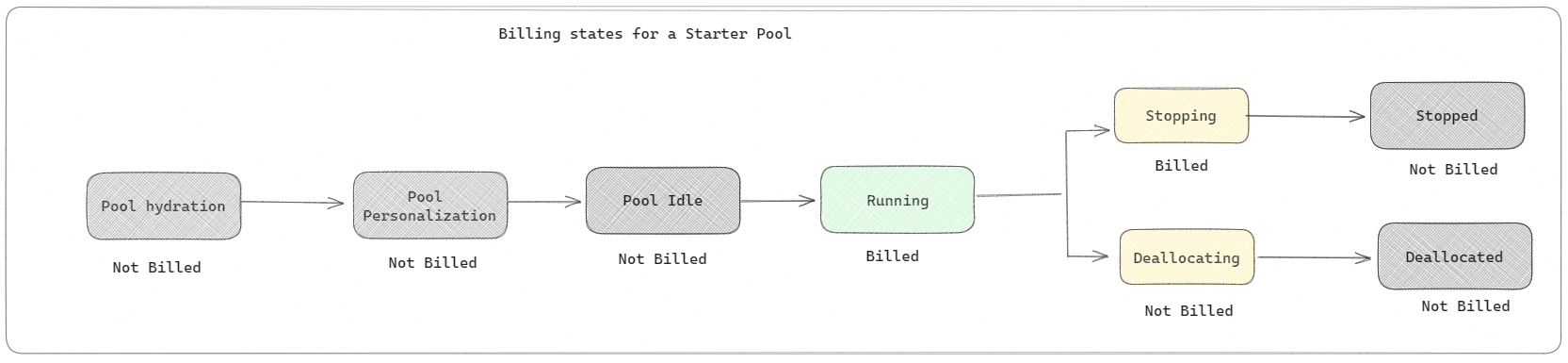

Aloitusaltaat: Nämä oletusaltaat ovat nopea ja helppo tapa käyttää Sparkiä Microsoft Fabric -ympäristössä sekunneissa. Spark-istuntoja voi käyttää heti sen sijaan, että odottaisit Sparkin määrittävän solmut puolestasi. Tämä auttaa sinua käyttämään tietoja entistä enemmän ja saamaan merkityksellisiä tietoja nopeammin. Laskutuksen ja kapasiteetin kulutuksen osalta sinua veloitetaan, kun aloitat muistikirjan, Spark-työmäärityksen tai lakehouse-toiminnon suorittamisen. Sinulta ei veloiteta aikaa, jolloin klusterit ovat käyttämättömänä altaassa.

Jos esimerkiksi lähetät muistikirjatyön aloitussarjaan, sinua laskutetaan vain siltä ajanjaksolta, jolloin muistikirjaistunto on aktiivinen. Laskutettu aika ei sisällä käyttämättömyysaikaa tai aikaa, joka istunnon mukauttamiseen Spark-kontekstissa kuluu. Jos haluat lisätietoja Starter-uima-altaan määrittämisestä ostetun Fabric-kapasiteetin SKU:n perusteella, siirry artikkeliin Fabric-kapasiteettiin perustuvien Starter-uima-altaiden määrittäminen

Spark-varannot: Nämä ovat mukautettuja altaita, joissa voit mukauttaa tietoanalyysitehtäviin tarvittavien resurssien kokoa. Voit antaa Spark-varannolle nimen ja valita, montako solmua (työkoneet) ovat ja kuinka suuria solmut ovat. Voit myös määrittää Sparkille, miten voit säätää solmujen määrää sen mukaan, kuinka paljon työtä sinulla on. Spark-varannon luominen on maksutonta; Maksat vain, kun suoritat Spark-työn altaassa, ja tämän jälkeen Spark määrittää solmut puolestasi.

- Mukautetun Spark-varannon solmujen koko ja määrä määrä määräytyvät Microsoft Fabric -kapasiteetin mukaan. Näiden Spark-näennäisytimien avulla voit luoda erikokoisia solmuja mukautetulle Spark-varannolle, kunhan Spark-näennäisytimien kokonaismäärä ei ylitä 128:aa.

- Spark-altaita laskutetaan kuin aloitusaltaita; Et maksa luomistasi mukautetuista Spark-altaista, ellei sinulla ole aktiivista Spark-istuntoa, joka on luotu muistikirjan tai Spark-työmäärityksen suorittamista varten. Sinua laskutetaan vain työn suoritusajan ajalta. Sinua ei laskuteta vaiheista, kuten klusterin luonnista ja uudelleensijoittamisesta työn valmistumisen jälkeen.

Jos esimerkiksi lähetät muistikirjatyön mukautettuun Spark-varantoon, sinulta veloitetaan vain siltä ajanjaksolta, kun istunto on aktiivinen. Muistikirjaistunnon laskutus päättyy, kun Spark-istunto on loppunut tai vanhentunut. Sinulta ei veloiteta aikaa, joka kuluu klusteriesiintymien hankkimiseen pilvipalvelusta tai Spark-kontekstin alustamiseen kuluvasta ajasta. Saat lisätietoja Spark-altaiden määrittämisestä ostetun Fabric-kapasiteetti-SKU:n perusteella artikkelista Poolien määrittäminen Fabric-kapasiteetin perusteella

Huomautus

Luomiesi aloituspoolien ja spark-varannon oletusaikaistunnon vanhentumisaika on 20 minuuttia. Jos et käytä Spark-poolia kahteen minuuttiin istunnon päättymisen jälkeen, Spark-varannon varaus poistetaan. Jos haluat lopettaa istunnon ja laskutuksen, kun muistikirja on suoritettu loppuun ennen istunnon vanhentumisajankohtaa, voit joko napsauttaa muistikirjojen Aloitus-valikon stop-istuntopainiketta tai siirtyä valvontakeskuksen sivulle ja pysäyttää istunnon siellä.

Spark-käsittelykäytön raportointi

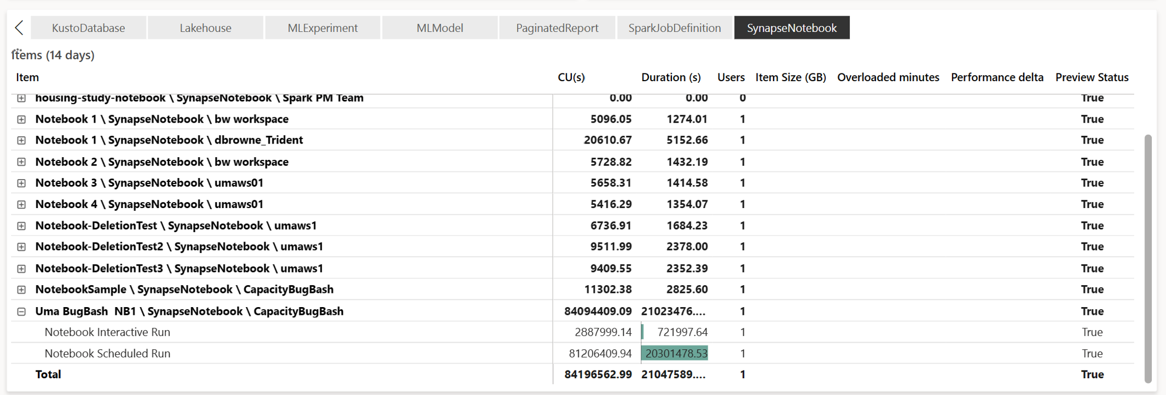

Microsoft Fabric Capacity Metrics -sovellus tarjoaa yhteen paikkaan näkyvyyden kaikkien Fabric-kuormitusten kapasiteetin käyttöön. Kapasiteetin järjestelmänvalvojat valvovat sen avulla kuormitusten suorituskykyä ja niiden käyttöä ostettuun kapasiteettiin verrattuna.

Kun sovellus on asennettu, valitse kohdetyyppi Notebook,Lakehouse,Spark Job Definition avattavasta Valitse kohdelaji: -luettelosta. Monimetrisen nauhakaavion kaavio voidaan nyt säätää haluttuun aikaväliin, jotta ymmärrät näiden kaikkien valittujen kohteiden käytön.

Kaikki Sparkiin liittyvät toiminnot luokitellaan taustatoiminnoiksi. Spark-kaavion kapasiteetin kulutus näkyy muistikirjan, Spark-työn määrityksen tai lakehousen alla, ja se koostetaan toiminnon nimen ja kohteen mukaan. Esimerkiksi: Jos suoritat muistikirjatyön, näet muistikirjan suorituksen, muistikirjan käyttämät CUs-tietokoneet (Total Spark VCores/2, kun 1 CU antaa 2 Spark VCorea), kesto, jonka työ on otettu raportissa.

Lisätietoja Spark-kapasiteetin käyttöraportoinnista on artikkelissa Apache Spark -kapasiteetin kulutuksen valvonta

Lisätietoja Spark-kapasiteetin käyttöraportoinnista on artikkelissa Apache Spark -kapasiteetin kulutuksen valvonta

Esimerkki laskutusmallista

Esimerkkitilanne:

Käytössä on kapasiteetti C1, joka isännöi Fabric-työtilaa W1, ja tämä työtila sisältää Lakehouse LH1:n ja Notebook NB1:n.

- Kaikki spark-toiminnot, jotka muistikirja (NB1) tai lakehouse(LH1) suorittaa, ilmoitetaan kapasiteetista C1.

Tämän esimerkin laajentaminen skenaarioon, jossa on toinen Kapasiteetti C2, joka isännöi Fabric-työtilaa W2, ja antaa tämän työtilan sisältää Spark-työmäärityksen (SJD1) ja Lakehousen (LH2).

- Jos työtilan (W2) Spark Job Definition (SDJ2) lukee tietoja Lakehousesta (LH1), käyttö ilmoitetaan sitä kapasiteettia C2 vastaan, joka liittyy kohdetta isännöivään työtilaan (W2).

- Jos muistikirja (NB1) suorittaa lukutoiminnon Lakehouse(LH2)-kohdasta, kapasiteetin kulutus raportoidaan sitä kapasiteettia C1 varten, joka toimii muistikirjakohdetta isännöivässä työtilassa W1.