Mikä on Apache Spark -käsittely Microsoft Fabricissa?

Koskee seuraavia:✅ Microsoft Fabricin tietotekniikka ja datatiede

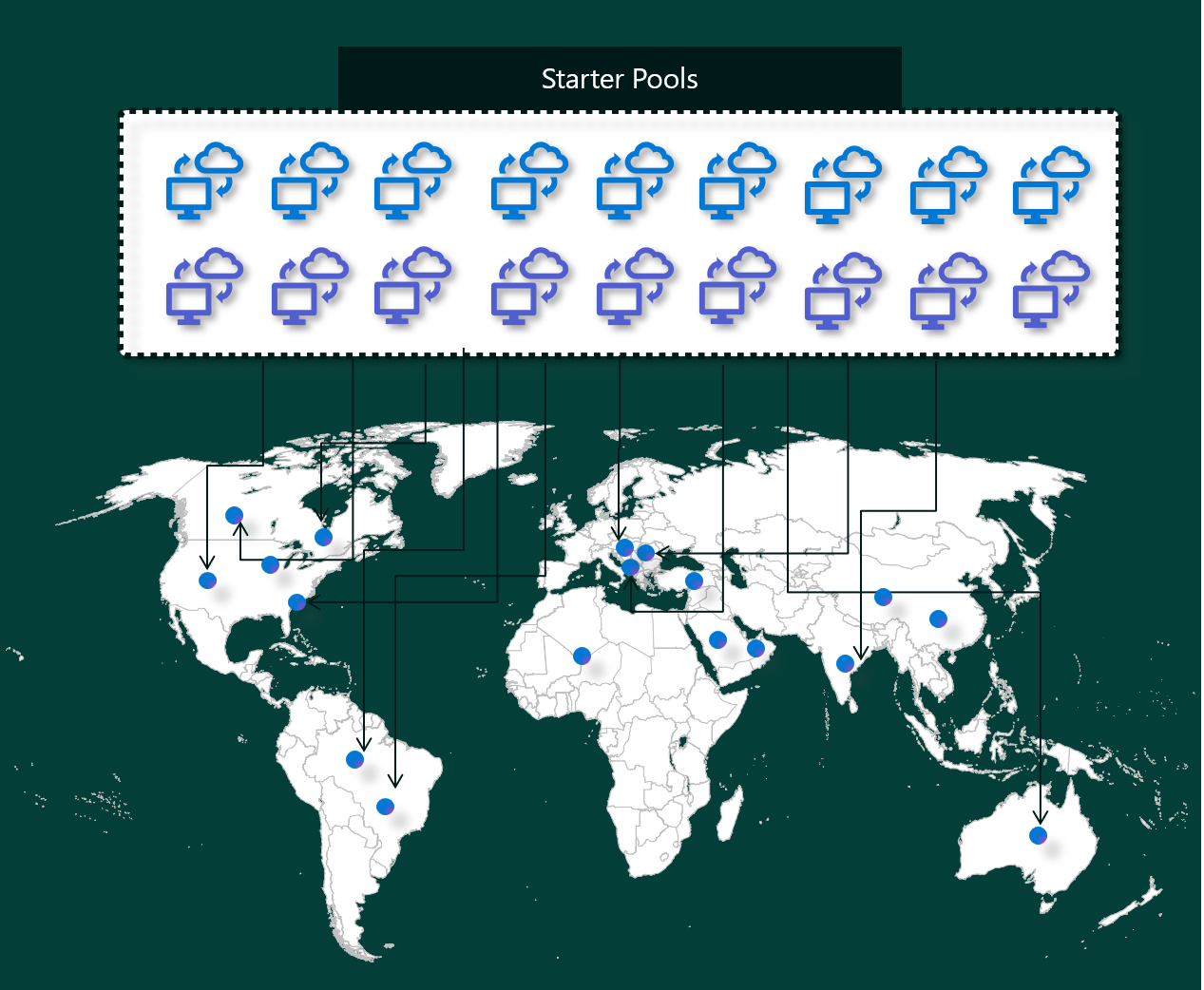

Microsoft Fabric Data Engineering- ja Data Science -kokemukset toimivat täysin hallitussa Apache Spark -käsittelyympäristössä. Tämä ympäristö on suunniteltu tarjoamaan vertaansa vailla olevaa nopeutta ja tehokkuutta. Aloituspoolien ansiosta voit odottaa nopeaa Apache Spark -istunnon alustamista yleensä 5–10 sekunnin kuluessa ilman manuaalista asennusta. Voit myös joustavasti mukauttaa Apache Spark -varannot tietotekniikka- ja tietojenkäsittelyvaatimuksiesi mukaisesti. Käyttöympäristö mahdollistaa optimoidun ja räätälöidyn analytiikkakokemuksen. Lyhyesti sanottuna aloituspooli on nopea tapa käyttää valmiiksi määritettyä Sparkiä, kun taas Spark-varannon mukauttaminen ja joustavuus ovat käytettävissä.

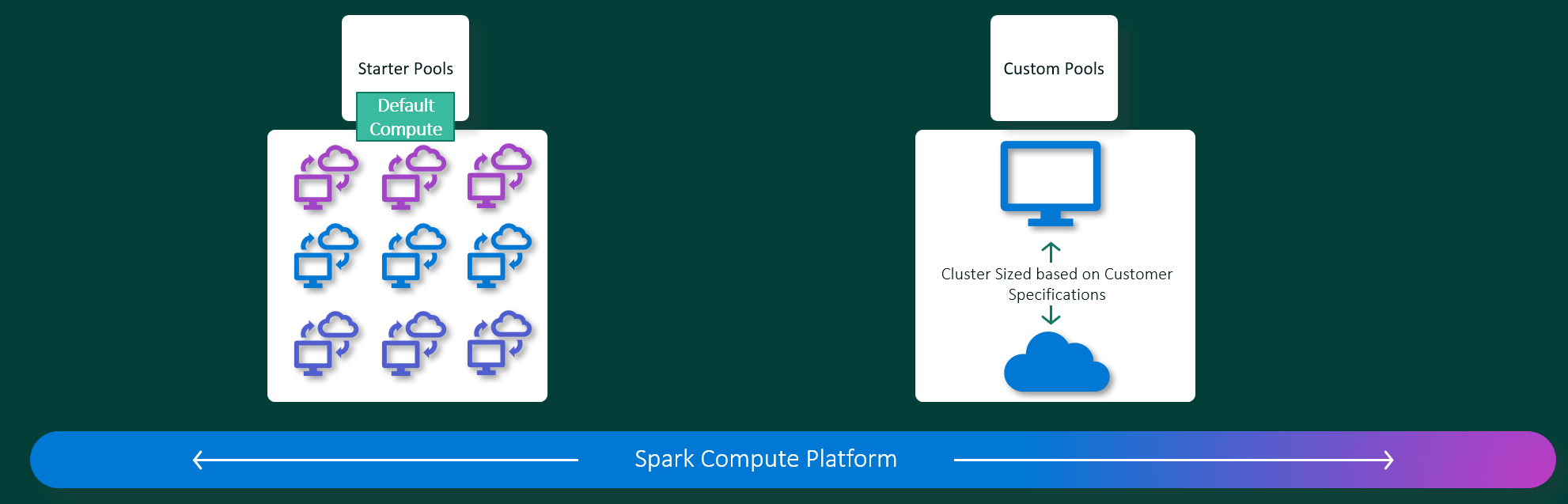

Starter-altaat

Aloitusaltaat ovat nopea ja helppo tapa käyttää Sparkiä Microsoft Fabric -ympäristössä sekunneissa. Spark-istuntoja voi käyttää heti sen sijaan, että odottaisit Sparkin määrittävän solmut puolestasi. Tämä auttaa sinua käyttämään tietoja entistä enemmän ja saamaan merkityksellisiä tietoja nopeammin.

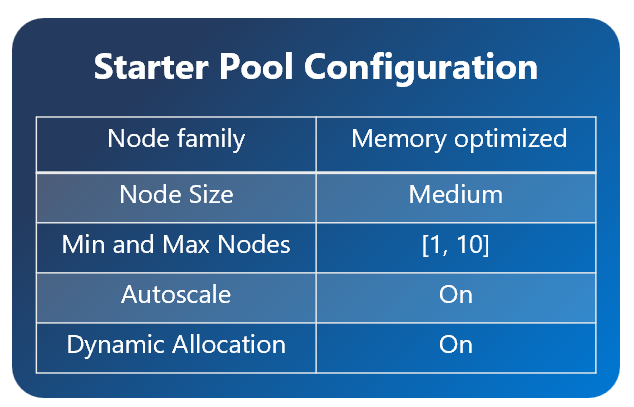

Aloitusaltaissa on Apache Spark -klustereita, jotka ovat aina käytössä ja valmiita pyyntöihisi. Ne käyttävät keskikokoisia solmuja, jotka skaalautuvat dynaamisesti ylösPäin Spark-työtarpeiden mukaan.

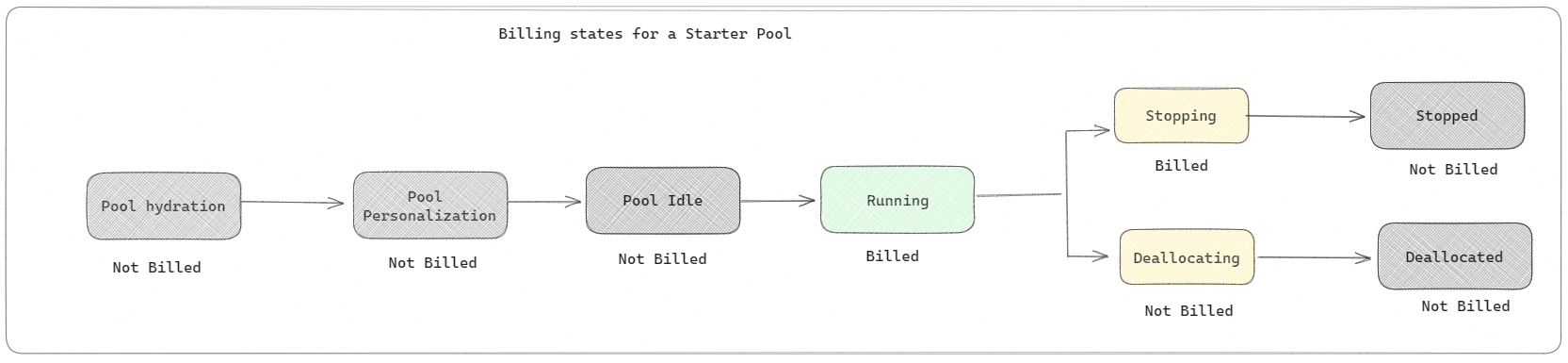

Aloituspooleissa on myös oletusasetukset, joiden avulla voit asentaa kirjastoja nopeasti hidastamatta istunnon alkamisaikaa. Jos kuitenkin haluat käyttää ylimääräisiä mukautettuja Apache Spark -ominaisuuksia tai -kirjastoja työtilastasi tai kapasiteettiasetuksistasi, Sparkillä kestää kauemmin saada solmut puolestasi. Laskutuksen ja kapasiteetin kulutuksen osalta sinua veloitetaan kapasiteetin kulutuksesta, kun aloitat muistikirjan tai Apache Spark -työmäärityksen suorittamisen. Sinulta ei veloiteta aikaa, jolloin klusterit ovat käyttämättömänä altaassa.

Jos esimerkiksi lähetät muistikirjatyön aloitussarjaan, sinua laskutetaan vain siltä ajanjaksolta, jolloin muistikirjaistunto on aktiivinen. Laskutettu aika ei sisällä käyttämättömyysaikaa tai aikaa, joka istunnon mukauttamiseen Spark-kontekstissa kuluu.

Spark-altaat

Spark-varannon avulla voit kertoa Sparkille, millaisia resursseja tarvitset tietoanalyysitehtäviin. Voit antaa Spark-varannolle nimen ja valita, montako solmua (työkoneet) ovat ja kuinka suuria solmut ovat. Voit myös määrittää Sparkille, miten voit säätää solmujen määrää sen mukaan, kuinka paljon työtä sinulla on. Spark-varannon luominen on maksutonta; Maksat vain, kun suoritat Spark-työn altaassa, ja tämän jälkeen Spark määrittää solmut puolestasi.

Jos et käytä Spark-poolia kahteen minuuttiin istunnon päättymisen jälkeen, Spark-varannon varaus poistetaan. Tämän oletusistunnon vanhentumisaika on 20 minuuttia, ja voit halutessasi muuttaa sitä. Jos olet työtilan järjestelmänvalvoja, voit myös luoda mukautettuja Spark-varantoja työtilaasi ja tehdä niistä oletusasetuksen muille käyttäjille. Näin säästät aikaa ja vältät uuden Spark-uima-altaan määrittämisen aina, kun suoritat muistikirjan tai Spark-työn. Mukautettujen Spark-varannon käynnistyminen kestää noin kolme minuuttia, koska Sparkin on haettava solmut Azuresta.

Voit myös luoda yksittäisen solmun Spark-varannot asettamalla solmujen vähimmäismäärän sellaiseksi, jolloin ohjain ja suoritettava tiedosto suoritetaan yhdessä solmussa, joka tulee palautettavan HA:n mukana ja joka soveltuu pienille kuormituksille.

Mukautetun Spark-varannon solmujen koko ja määrä määrä määräytyvät Microsoft Fabric -kapasiteetin mukaan. Kapasiteetti mittaa, kuinka paljon laskentatehoa voit käyttää Azuressa. Yksi tapa ajatella sitä on, että kaksi Apache Spark VCorea (Sparkin laskentatehoyksikkö) on yhtä kapasiteettiyksikköä.

Muistiinpano

Apache Sparkissä käyttäjät saavat kaksi Apache Spark -näennäisydintä kullekin kapasiteettiyksikölle, jonka he varaavat osana varastointiyksikköään. Yksi kapasiteettiyksikkö = Kaksi Spark-näennäisydintä So F64 => 128 Spark Vcorea ja jossa käytetään 3x Purskeen kertointa, joka antaa yhteensä 384 Spark VCorea

Esimerkiksi Fabric-kapasiteetin SKU F64 -kapasiteetilla on 64 kapasiteettiyksikköä, mikä vastaa 384 Spark VCorea (64 * 2 * 3X Purskeen kerrannaista). Näiden Spark-näennäisytimien avulla voit luoda erikokoisia solmuja mukautetulle Spark-varannolle, kunhan Spark-näennäisytimien kokonaismäärä ei ole yli 384.

Spark-altaita laskutetaan kuin aloitusaltaita; Et maksa luomistasi mukautetuista Spark-altaista, ellei sinulla ole aktiivista Spark-istuntoa, joka on luotu muistikirjan tai Spark-työmäärityksen suorittamista varten. Sinua laskutetaan vain työn suoritusajan ajalta. Sinua ei laskuteta vaiheista, kuten klusterin luonnista ja uudelleensijoittamisesta työn valmistumisen jälkeen.

Jos esimerkiksi lähetät muistikirjatyön mukautettuun Spark-varantoon, sinulta veloitetaan vain siltä ajanjaksolta, kun istunto on aktiivinen. Muistikirjaistunnon laskutus päättyy, kun Spark-istunto on loppunut tai vanhentunut. Sinulta ei veloiteta aikaa, joka kuluu klusteriesiintymien hankkimiseen pilvipalvelusta tai Spark-kontekstin alustamiseen kuluvasta ajasta.

Mahdolliset mukautetun varannon määritykset F64:lle edellisen esimerkin perusteella:

| Fabric-kapasiteetin SKU | Kapasiteetin yksiköt | Enintään Spark-näennäisytimet ja purskekerroin | Solmun koko | Solmujen enimmäismäärä |

|---|---|---|---|---|

| F64 | 64 | 384 | Pieni | 96 |

| F64 | 64 | 384 | Keskikokoinen | 48 |

| F64 | 64 | 384 | Suuri | 24 |

| F64 | 64 | 384 | X-Large | 12 |

| F64 | 64 | 384 | XX-Suuri | 6 |

Muistiinpano

Jotta voit luoda mukautettuja varantoja, tarvitset työtilan järjestelmänvalvojan oikeudet. Microsoft Fabric -kapasiteetin järjestelmänvalvojan täytyy myös myöntää käyttöoikeudet, jotta työtilan järjestelmänvalvojat voivat muuttaa mukautettujen Spark-poolien kokoa. Lisätietoja on artikkelissa Mukautettujen Spark-uima-altaan käytön aloittaminen Fabricissa

Solmut

Apache Spark -esiintymä koostuu yhdestä pääsolmusta ja työntekijäsolmuista, ja se voi käynnistää vähintään yhden solmun Spark-esiintymässä. Pääsolmu suorittaa ylimääräisiä hallintapalveluita, kuten Livy, Yarn Resource Manager, Zookeeper ja Apache Spark -ohjain. Kaikki solmut suorittavat palveluja, kuten Node Agent ja Yarn Node Manager. Kaikki työntekijäsolmut suorittavat Apache Spark Executor -palvelun.

Solmukoot

Spark-pool voidaan määrittää solmukooilla, jotka vaihtelevat pienestä käsittelysolmusta (jossa on 4 näennäisydintä ja 32 Gt muistia) kaksinkertaiseen suureen käsittelysolmuun (64 näennäisydintä ja 512 Gt muistia solmua kohden). Solmukokoja voidaan muuttaa varannon luomisen jälkeen, vaikka aktiivinen istunto olisi käynnistettävä uudelleen.

| Koko | vCore | Muisti |

|---|---|---|

| Pieni | 4 | 32 Gt |

| Keskikokoinen | 8 | 64 Gt |

| Suuri | 16 | 128 Gt |

| X-Large | 32 | 256 Gt |

| XX-Suuri | 64 | 512 Gt |

Muistiinpano

Solmukoot X-Large ja XX-Large sallitaan vain muille kuin kokeilujaksona valmistetuille Fabric-SKU:ille.

Automaattinen skaalaaminen

Apache Spark -varannon automaattinen skaalaus mahdollistaa käsittelyresurssien automaattisen skaalauksen ylös ja alas toiminnan määrän mukaan. Kun otat käyttöön automaattisen skaalauksen, voit määrittää solmujen vähimmäis- ja enimmäismäärän skaalautuviksi. Kun poistat automaattisen skaalauksen käytöstä, määritettyjen solmujen määrä pysyy kiinteänä. Voit muuttaa tätä asetusta varannon luomisen jälkeen, vaikka saatat joutua käynnistämään esiintymän uudelleen.

Muistiinpano

Oletusarvon mukaan spark.yarn.executor.decommission.enabled on true, mikä mahdollistaa alikäytettyjen solmujen automaattisen sammutuksen käsittelyn tehokkuuden optimoimiseksi. Jos suosit vähemmän aggressiivista skaalausta, tämän määrityksen arvoksi voidaan asettaa false

Dynaaminen kohdistaminen

Dynaamisen kohdistuksen avulla Apache Spark -sovellus voi pyytää lisää suoritintiedostoja, jos tehtävät ylittävät nykyisen suoritettavan tiedoston suorittamiseen kohdistuvan kuormituksen. Se julkaisee myös suoritettavat tiedostotiedostot, kun työt on suoritettu ja jos Spark-sovellus on siirtymässä käyttämättömyystilaan. Yrityskäyttäjien on usein vaikea hienosäätää suoritettavan suorituksen määrityksiä, koska ne eroavat huomattavasti Spark-työn suoritusprosessin eri vaiheista. Nämä määritykset riippuvat myös käsiteltyjen tietojen määrästä, joka muuttuu aika ajoin. Voit ottaa käyttöön tiedostotiedostojen dynaamisen kohdistuksen osana varannon määritystä, jolloin suoritettavat suoritustiedostot voidaan automaattisesti jakaa Spark-sovellukseen Spark-varannossa käytettävissä olevien solmujen perusteella.

Kun otat dynaamisen kohdistusvaihtoehdon käyttöön jokaiselle lähetetylle Spark-sovellukselle, järjestelmä varaa suoritettavat suoritustiedostot työn lähettämisvaiheen aikana minimisolmujen perusteella. Voit määrittää solmujen enimmäismäärän onnistuneiden automaattisten skaalausskenaarioiden tukemiseksi.