Escenario completo de ciencia de datos: introducción y arquitectura

Este conjunto de tutoriales muestra un escenario de un extremo a otro de ejemplo en la experiencia de ciencia de datos de Fabric. Implemente cada paso de la ingesta, limpieza y preparación de datos para entrenar modelos de aprendizaje automático y generar información y, a continuación, consumir esas conclusiones mediante herramientas de visualización como Power BI.

Si no está familiarizado con Microsoft Fabric, consulte ¿Qué es Microsoft Fabric?.

Introducción

El ciclo de vida de un proyecto de ciencia de datos suele incluir (a menudo, iterativamente) los pasos siguientes:

- Comprensión empresarial

- Adquisición de datos

- Exploración, limpieza, preparación y visualización de datos

- Entrenamiento del modelo y seguimiento de experimentos

- Puntuación de modelos y generación de información.

Los objetivos y los criterios de éxito de cada fase dependen de la colaboración, el uso compartido de datos y la documentación. La experiencia de ciencia de datos de Fabric consta de varias características integradas nativas que permiten la colaboración, la adquisición de datos, el uso compartido y el consumo sin problemas.

En estos tutoriales, se toma el rol de un científico de datos al que se le ha asignado la tarea de explorar, limpiar y transformar un conjunto de datos que contiene el estado de renovación de 10 000 clientes en un banco. A continuación, cree un modelo de aprendizaje automático para predecir qué clientes bancarios probablemente se van.

Aprenderá a realizar las actividades siguientes:

- Use los cuadernos de Fabric para escenarios de ciencia de datos.

- Ingesta de datos en un lago de datos de Fabric mediante Apache Spark.

- Carga de datos existentes desde las tablas delta del lago de datos.

- Limpie y transforme los datos mediante las herramientas basadas en Apache Spark y Python.

- Cree experimentos y ejecuciones para entrenar diferentes modelos de aprendizaje automático.

- Registre y realice un seguimiento de los modelos entrenados mediante MLflow y la interfaz de usuario de Fabric.

- Ejecución de la puntuación a gran escala y guardado de las predicciones y los resultados de inferencia en el lago de datos.

- Visualización de predicciones en Power BI mediante DirectLake.

Arquitectura

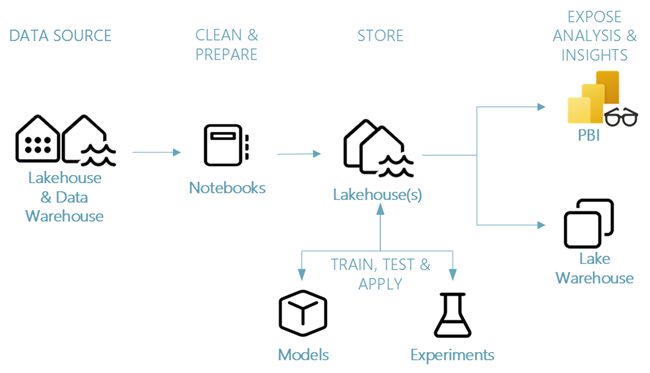

En esta serie de tutoriales, presentamos un escenario simplificado de ciencia de datos de un extremo a otro que implica:

- Ingesta de datos de un origen de datos externo.

- Exploración y limpieza de datos.

- Entrenar y registrar modelos de aprendizaje automático.

- Puntuación por lotes y guardado de predicciones.

- Visualizar los resultados de la predicción en Power BI.

Diferentes componentes del escenario de ciencia de datos

Orígenes de datos: Fabric facilita y acelera la conexión a Azure Data Services, otras plataformas en la nube y orígenes de datos locales para ingerir datos. Usando Fabric Notebooks puede ingerir datos del Lakehouse integrado, Data Warehouse, modelos semánticos, y varios orígenes de datos personalizados compatibles con Apache Spark y Python. Esta serie de tutoriales se centra en la ingesta y carga de datos desde un lago de datos.

Explorar, limpiar y preparar: la experiencia de ciencia de datos en Fabric admite la limpieza, transformación, exploración y caracterización de datos mediante experiencias integradas en Spark, así como herramientas basadas en Python, como Data Wrangler y SemPy Library. En este tutorial se mostrará la exploración de datos mediante la biblioteca de Python seaborn y la limpieza y preparación de datos mediante Apache Spark.

Modelos y experimentos: Fabric permite entrenar, evaluar y puntuar modelos de aprendizaje automático mediante el uso de elementos de modelo y experimento integrados con integración perfecta con MLflow para el seguimiento de experimentos y el registro o la implementación del modelo. Fabric también incluye funcionalidades para la predicción del modelo a escala (PREDICT) para obtener y compartir información empresarial.

Almacenamiento: Fabric usa Delta Lake como estándar, lo que significa que todos los motores de Fabric pueden interactuar con el mismo conjunto de datos almacenado en un lago de datos. Esta capa de almacenamiento permite almacenar datos estructurados y no estructurados que admiten el almacenamiento basado en archivos y el formato tabular. Se puede acceder fácilmente a los conjuntos de datos y los archivos almacenados a través de todos los elementos de experiencia de Fabric, como cuadernos y canalizaciones.

Exposición de análisis e información: Power BI, una herramienta de inteligencia empresarial líder del sector, puede consumir datos de un lago de datos, para la creación de informes y la visualización. Los datos almacenados en lakehouse también se pueden visualizar en cuadernos mediante bibliotecas de visualización nativas de Spark o Python, como matplotlib, seaborn, plotly, etc. Los datos también se pueden visualizar mediante la biblioteca SemPy que admite visualizaciones enriquecidas y específicas de tareas integradas para el modelo de datos semántico, para las dependencias y sus infracciones, y para casos de uso de clasificación y regresión.