Introducción al bloque de creación de seguridad de Azure OpenAI

En este artículo se muestra cómo crear y usar el ejemplo de bloque de creación de seguridad de Azure OpenAI. El propósito es demostrar el aprovisionamiento de cuentas de Azure OpenAI con el control de acceso basado en roles (RBAC) para la autenticación sin claves (Microsoft Entra ID) en Azure OpenAI. Este ejemplo de aplicación de chat también incluye toda la infraestructura y la configuración necesarias para aprovisionar recursos de Azure OpenAI e implementar la aplicación en Azure Container Apps mediante Azure Developer CLI.

Siguiendo las instrucciones de este artículo, podrá:

- Implemente una aplicación de chat segura de Azure Container.

- Use la identidad administrada para el acceso a Azure OpenAI.

- Chatee con un modelo de lenguaje grande (LLM) de Azure OpenAI mediante la biblioteca de OpenAI.

Una vez finalizado este artículo, puede comenzar a modificar el nuevo proyecto con sus datos y código personalizado.

Nota

En este artículo se usan una o varias plantillas de aplicaciones de IA como base para los ejemplos e instrucciones del artículo. Las plantillas de aplicaciones de IA le proporcionan implementaciones de referencia bien mantenidas y fáciles de implementar que le ayudan a garantizar un punto inicial de alta calidad para sus aplicaciones de IA.

Introducción a la arquitectura

En el siguiente diagrama se muestra una arquitectura sencilla de la aplicación de chat:

La aplicación de chat se ejecuta como una aplicación de Azure Container. La aplicación usa la identidad administrada a través de Microsoft Entra ID para autenticarse con Azure OpenAI, en lugar de una clave de API. La aplicación de chat usa Azure OpenAI para generar respuestas a los mensajes del usuario.

La arquitectura de la aplicación se basa en los siguientes servicios y componentes:

- Azure OpenAI representa el proveedor de IA al que se envían las consultas del usuario.

- Azure Container Apps es el entorno de contenedor donde se hospeda la aplicación.

- La identidad administrada nos ayuda a garantizar la seguridad de primer nivel y elimina el requisito de que, como desarrollador, deba administrar de forma segura un dato confidencial.

- Archivos de Bicep para aprovisionar recursos de Azure, incluidos Azure OpenAI, Azure Container Apps, Azure Container Registry, Azure Log Analytics y roles RBAC.

- El Protocolo de chat de Microsoft AI proporciona contratos de API estandarizados en todas las soluciones y lenguajes de IA. La aplicación de chat se ajusta al protocolo Microsoft AI Chat Protocol, que permite que la aplicación de evaluaciones se ejecute en cualquier aplicación de chat que se ajuste al protocolo.

- Un quart de Python que usa el paquete

openaipara generar respuestas a los mensajes del usuario. - Un front-end HTML/JavaScript básico que transmite respuestas desde el back-end mediante líneas JSON a través de ReadableStream.

- Una aplicación web de Blazor que usa el paquete NuGet Azure.AI.OpenAI para generar respuestas a los mensajes del usuario.

- Una aplicación web TypeScript que usa el paquete npm openai para generar respuestas a los mensajes del usuario.

Costo

Para mantener los precios lo más bajos posibles en este ejemplo, la mayoría de los recursos usan un plan de tarifa básico o de consumo. Modifique el nivel según sea necesario en función del uso previsto. Una vez que haya terminado con el artículo, puede eliminar los recursos para dejar de incurrir en cargos.

Obtenga más información sobre el coste en el repositorio de ejemplo.

Obtenga más información sobre el coste en el repositorio de ejemplo.

Obtenga más información sobre el coste en el repositorio de ejemplo.

Requisitos previos

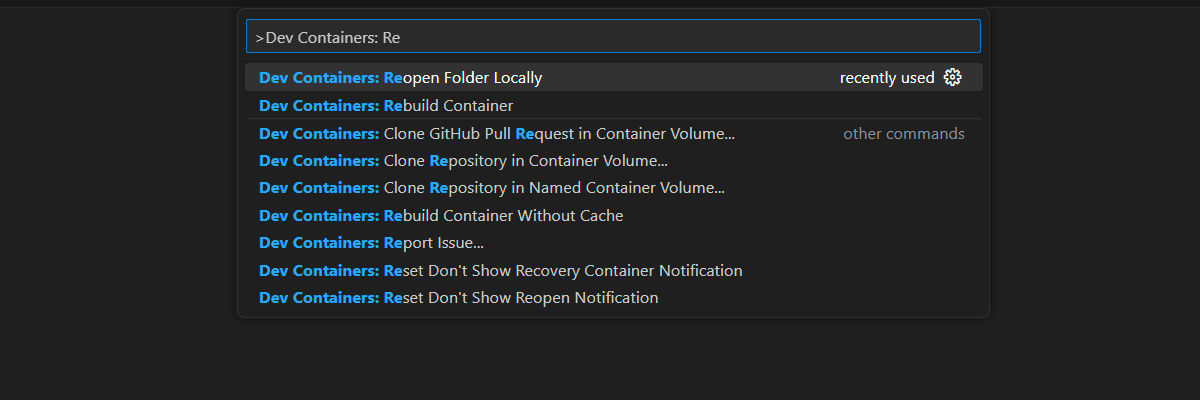

Hay disponible un entorno contenedor de desarrollo con todas las dependencias necesarias para completar este artículo. Puede ejecutar el contenedor de desarrollo en GitHub Codespaces (en un navegador) o localmente utilizando Visual Studio Code.

Para usar este artículo, necesita los siguientes requisitos previos:

Una suscripción a Azure: cree una cuenta gratuita.

Permisos de cuenta de Azure: la cuenta de Azure debe tener permisos de

Microsoft.Authorization/roleAssignments/write, como Administrador de acceso de usuario o Propietario.GitHub

Entorno de desarrollo abierto

Siga estas instrucciones para implementar un entorno de desarrollo preconfigurado que contenga todas las dependencias necesarias para completar este artículo.

GitHub Codespaces ejecuta un contenedor de desarrollo administrado por GitHub con Visual Studio Code para la web como interfaz de usuario. Para obtener el entorno de desarrollo más sencillo, utilice Codespaces de GitHub de modo que tenga las herramientas y dependencias de desarrollador correctas preinstaladas para completar este artículo.

Importante

Todas las cuentas de GitHub pueden usar Codespaces durante un máximo de 60 horas gratis cada mes con 2 instancias principales. Para obtener más información, consulte Almacenamiento y horas de núcleo incluidas mensualmente en GitHub Codespaces.

Siga estos pasos para crear un nuevo codespace de GitHub en la rama main del repositorio de GitHub Azure-Samples/openai-chat-app-quickstart.

Haga clic con el botón derecho en el botón siguiente y seleccione Abrir vínculo en la nueva ventana. Esta acción le permite tener el entorno de desarrollo y la documentación disponibles para su revisión.

En la página Crear codespace, revise la información y, después, seleccione Crear nuevo codespace.

Espere a que se inicie Codespace. Este proceso de startup puede tardar unos minutos.

En el terminal de la parte inferior de la pantalla, inicie sesión en Azure con Azure Developer CLI.

azd auth loginCopie el código del terminal y péguelo en un navegador. Siga las instrucciones para autenticarse con su cuenta Azure.

Las tareas restantes de este artículo tienen lugar en el contexto de este contenedor de desarrollo.

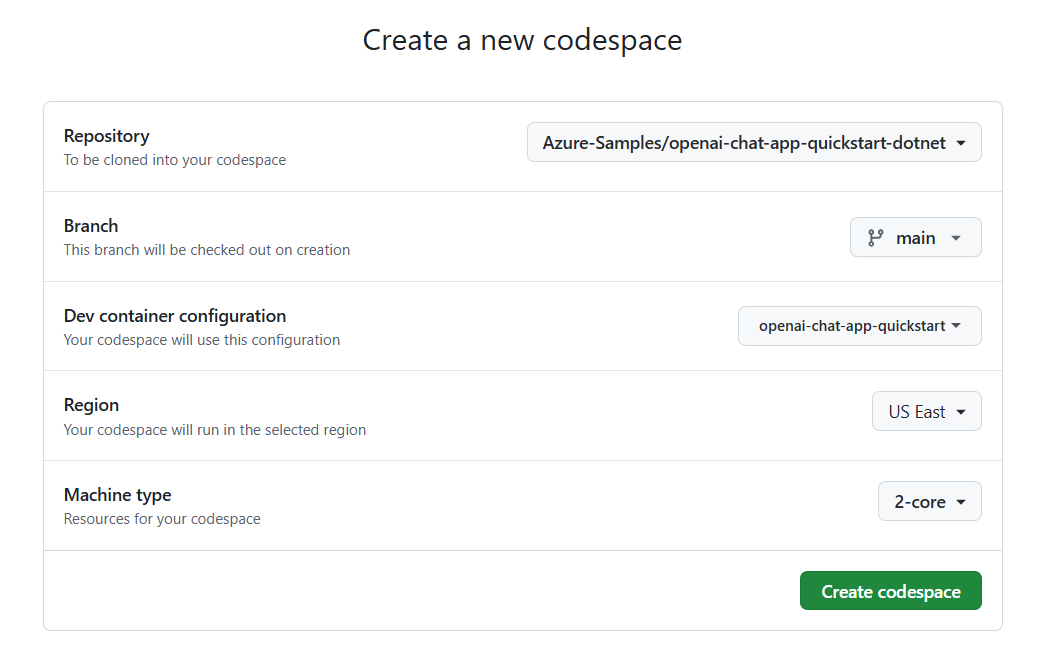

Siga estos pasos para crear un nuevo codespace de GitHub en la rama main del repositorio de GitHub Azure-Samples/openai-chat-app-quickstart-dotnet.

Haga clic con el botón derecho en el botón siguiente y seleccione Abrir vínculo en la nueva ventana. Esta acción le permite tener el entorno de desarrollo y la documentación disponibles para su revisión.

En la página Crear codespace, revise la información y, después, seleccione Crear codespace.

Espere a que se inicie Codespace. Este proceso de startup puede tardar unos minutos.

En el terminal de la parte inferior de la pantalla, inicie sesión en Azure con Azure Developer CLI.

azd auth loginCopie el código del terminal y péguelo en un navegador. Siga las instrucciones para autenticarse con su cuenta Azure.

Las tareas restantes de este artículo tienen lugar en el contexto de este contenedor de desarrollo.

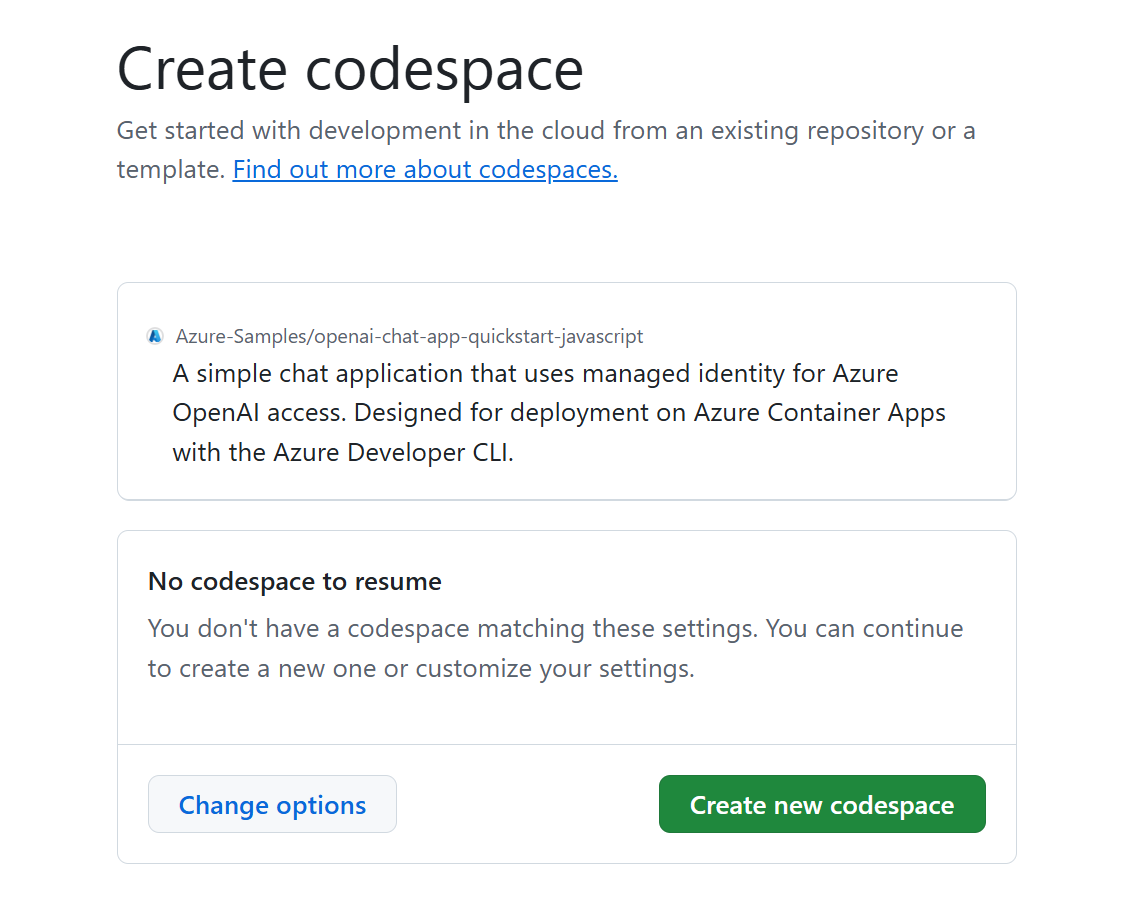

Siga estos pasos para crear un nuevo codespace de GitHub en la rama main del repositorio de GitHub Azure-Samples/openai-chat-app-quickstart-javascript.

- Haga clic con el botón derecho en el botón siguiente y seleccione Abrir vínculo en la nueva ventana. Esta acción le permite tener el entorno de desarrollo y la documentación disponibles para su revisión.

En la página Crear codespace, revise la información y, después, seleccione Crear nuevo codespace.

Espere a que se inicie Codespace. Este proceso de startup puede tardar unos minutos.

En el terminal de la parte inferior de la pantalla, inicie sesión en Azure con Azure Developer CLI.

azd auth loginCopie el código del terminal y péguelo en un navegador. Siga las instrucciones para autenticarse con su cuenta Azure.

Las tareas restantes de este artículo tienen lugar en el contexto de este contenedor de desarrollo.

Implementación y ejecución

El repositorio de ejemplo contiene todos los archivos de código y configuración para la implementación de Azure de la aplicación de chat. Los pasos siguientes le guiarán por el proceso de implementación de Azure de la aplicación de chat de ejemplo.

Implementación de la aplicación de chat en Azure

Importante

Los recursos de Azure creados en esta sección incurren en costes inmediatos. Estos recursos pueden acumular costes incluso si interrumpe el comando antes de que se ejecute por completo.

Ejecute el siguiente comando de Azure Developer CLI para el aprovisionamiento de recursos de Azure y la implementación de código fuente:

azd upUse la siguiente tabla para responder a las solicitudes:

Prompt Respuesta Nombre del entorno Hágala corta y en minúsculas. Agregue su nombre o alias. Por ejemplo, secure-chat. Se usa como parte del nombre del grupo de recursos.Suscripción Seleccione la suscripción en la que crear los recursos. Ubicación (para el hospedaje) Seleccione una ubicación cercana en la lista. Localización del modelo OpenAI Seleccione una ubicación cercana en la lista. Si está disponible la misma ubicación que la primera, selecciónela. Espere hasta que se implemente la aplicación. La implementación suele tardar entre 5 y 10 minutos en completarse.

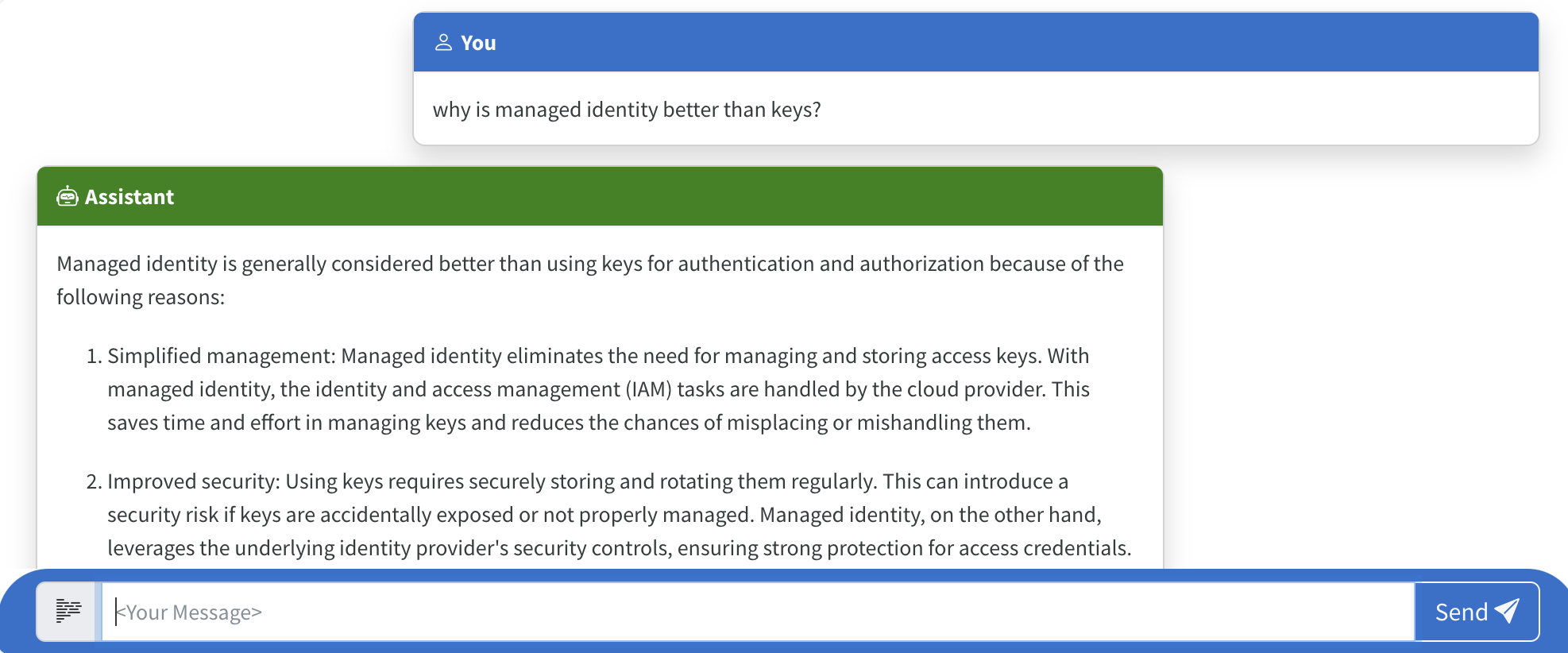

Uso de la aplicación de chat para formular preguntas al modelo de lenguaje grande

El terminal muestra una dirección URL después de una implementación correcta de la aplicación.

Seleccione esa URL etiquetada

Deploying service webpara abrir la aplicación de chat en un navegador.En el explorador, escriba una pregunta como "¿Por qué es mejor la identidad administrada que las claves?".

La respuesta procede de Azure OpenAI y se muestra el resultado.

Exploración del código de ejemplo

Aunque OpenAI y el servicio OpenAI de Azure se basan en una biblioteca cliente común de Python, se necesitan pequeños cambios de código al usar puntos de conexión de Azure OpenAI. Veamos cómo este ejemplo configura la autenticación sin claves con Microsoft Entra ID y se comunica con Azure OpenAI.

Configuración de la autenticación con la identidad administrada

En este ejemplo, el archivo src\quartapp\chat.py comienza con la configuración de la autenticación sin claves.

El fragmento de código siguiente usa el módulo azure.identity.aio para crear un flujo de autenticación asincrónico de Microsoft Entra.

El siguiente fragmento de código usa la variable de entorno AZURE_CLIENT_IDazd para crear una instancia de ManagedIdentityCredential capaz de autenticarse a través de una identidad administrada asignada por el usuario.

user_assigned_managed_identity_credential = ManagedIdentityCredential(client_id=os.getenv("AZURE_CLIENT_ID"))

Nota

Las variables de entorno del recurso azd se aprovisionan durante la implementación de la aplicación azd.

El siguiente fragmento de código usa la variable de entorno del recurso AZURE_TENANT_IDazd para crear una instancia de AzureDeveloperCliCredential capaz de autenticarse con el inquilino actual de Microsoft Entra.

azure_dev_cli_credential = AzureDeveloperCliCredential(tenant_id=os.getenv("AZURE_TENANT_ID"), process_timeout=60)

La biblioteca cliente de identidades de Azure proporciona credenciales, clases públicas que implementan el protocolo TokenCredential de la biblioteca de Azure Core. Una credencial representa un flujo de autenticación distinto para adquirir un token de acceso de Microsoft Entra ID. Estas credenciales se pueden encadenar para formar una secuencia ordenada de mecanismos de autenticación que se van a intentar.

El fragmento de código siguiente crea una ChainedTokenCredential mediante una ManagedIdentityCredential y una AzureDeveloperCliCredential:

- La

ManagedIdentityCredentialse usa para Azure Functions y Azure App Service. Se admite una identidad administrada asignada por el usuario pasando elclient_idaManagedIdentityCredential. - La

AzureDeveloperCliCredentialse usa para el desarrollo local. Se estableció anteriormente en función del inquilino de Microsoft Entra que se va a usar.

azure_credential = ChainedTokenCredential(

user_assigned_managed_identity_credential,

azure_dev_cli_credential

)

Sugerencia

El orden de las credenciales es importante, ya que se usa el primer token de acceso válido de Microsoft Entra. Para obtener más información, consulte el artículo Información general sobre ChainedTokenCredential.

El siguiente fragmento de código obtiene el proveedor de tokens de Azure OpenAI en función de la credencial de Azure seleccionada. Este valor se obtiene llamando a azure.identity.aio.get_bearer_token_provider con dos argumentos:

azure_credential: la instancia deChainedTokenCredentialcreada anteriormente para autenticar la solicitud.https://cognitiveservices.azure.com/.default: se requieren uno o varios ámbitos de token de portador. En este caso, el punto de conexión de Azure Cognitive Services.

token_provider = get_bearer_token_provider(

azure_credential, "https://cognitiveservices.azure.com/.default"

)

Las siguientes líneas comprueban las variables de entorno de recurso azd necesarias AZURE_OPENAI_ENDPOINT y AZURE_OPENAI_CHATGPT_DEPLOYMENT, que se aprovisionan durante la implementación de la aplicación azd. Si un valor no está presente, se produce un error.

if not os.getenv("AZURE_OPENAI_ENDPOINT"):

raise ValueError("AZURE_OPENAI_ENDPOINT is required for Azure OpenAI")

if not os.getenv("AZURE_OPENAI_CHATGPT_DEPLOYMENT"):

raise ValueError("AZURE_OPENAI_CHATGPT_DEPLOYMENT is required for Azure OpenAI")

Este fragmento de código inicializa el cliente de Azure OpenAI, estableciendo los parámetros api_version, azure_endpoint y azure_ad_token_provider (client_args):

bp.openai_client = AsyncAzureOpenAI(

api_version=os.getenv("AZURE_OPENAI_API_VERSION") or "2024-02-15-preview",

azure_endpoint=os.getenv("AZURE_OPENAI_ENDPOINT"),

azure_ad_token_provider=token_provider,

)

En la línea siguiente se establece el nombre de implementación del modelo de Azure OpenAI para su uso en llamadas API:

bp.openai_model = os.getenv("AZURE_OPENAI_CHATGPT_DEPLOYMENT")

Nota

OpenAI usa el argumento de palabra clave model para especificar qué modelo se va a usar. Azure OpenAI tiene el concepto de implementaciones de modelo únicas. Al usar Azure OpenAI, model debe hacer referencia al nombre de implementación subyacente elegido durante la implementación del modelo de Azure OpenAI.

Una vez completada esta función, el cliente está configurado correctamente y listo para interactuar con los servicios de Azure OpenAI.

Flujo de respuesta mediante el cliente y el modelo de OpenAI

El response_stream controla la llamada de finalización del chat en la ruta. El siguiente fragmento de código muestra cómo se usan openai_client y model.

async def response_stream():

# This sends all messages, so API request may exceed token limits

all_messages = [

{"role": "system", "content": "You are a helpful assistant."},

] + request_messages

chat_coroutine = bp.openai_client.chat.completions.create(

# Azure OpenAI takes the deployment name as the model name

model=bp.openai_model,

messages=all_messages,

stream=True,

)

Exploración del código de ejemplo

Las aplicaciones .NET dependen de la biblioteca cliente Azure.AI.OpenAI para comunicarse con los servicios de Azure OpenAI, que depende de la biblioteca de OpenAI. La aplicación de ejemplo configura la autenticación sin claves mediante Microsoft Entra ID para comunicarse con Azure OpenAI.

Configuración de la autenticación y el registro de servicios

En este ejemplo, la autenticación sin claves se configura en el archivo program.cs. El siguiente fragmento de código usa la variable de entorno AZURE_CLIENT_ID establecida por azd para crear una instancia de ManagedIdentityCredential capaz de autenticarse a través de una identidad administrada asignada por el usuario.

var userAssignedIdentityCredential =

new ManagedIdentityCredential(builder.Configuration.GetValue<string>("AZURE_CLIENT_ID"));

Nota

Las variables de entorno del recurso azd se aprovisionan durante la implementación de la aplicación azd.

El siguiente fragmento de código usa la variable de entorno AZURE_TENANT_ID establecida por azd para crear una instancia de AzureDeveloperCliCredential capaz de autenticarse localmente mediante la cuenta que inició sesión en azd.

var azureDevCliCredential = new AzureDeveloperCliCredential(

new AzureDeveloperCliCredentialOptions()

{

TenantId = builder.Configuration.GetValue<string>("AZURE_TENANT_ID")

});

La biblioteca cliente de identidades de Azure proporciona clases de credenciales que implementan el protocolo TokenCredential de la biblioteca de Azure Core. Una credencial representa un flujo de autenticación distinto para adquirir un token de acceso de Microsoft Entra ID. Estas credenciales se pueden encadenar con ChainedTokenCredential para formar una secuencia ordenada de mecanismos de autenticación que se van a intentar.

El fragmento de código siguiente registra el AzureOpenAIClient para la inyección de dependencias y crea una ChainedTokenCredential mediante una ManagedIdentityCredential y una AzureDeveloperCliCredential:

- La

ManagedIdentityCredentialse usa para Azure Functions y Azure App Service. Se admite una identidad administrada asignada por el usuario mediante elAZURE_CLIENT_IDque se proporcionó aManagedIdentityCredential. - La

AzureDeveloperCliCredentialse usa para el desarrollo local. Se estableció anteriormente en función del inquilino de Microsoft Entra que se va a usar.

builder.Services.AddAzureClients(

clientBuilder => {

clientBuilder.AddClient<AzureOpenAIClient, AzureOpenAIClientOptions>((options, _, _)

=> new AzureOpenAIClient(

new Uri(endpoint),

new ChainedTokenCredential(

userAssignedIdentityCredential, azureDevCliCredential), options));

});

Sugerencia

El orden de las credenciales es importante, ya que se usa el primer token de acceso válido de Microsoft Entra. Para obtener más información, consulte el artículo Información general sobre ChainedTokenCredential.

Obtención de finalizaciones de chat mediante el cliente de Azure OpenAI

La aplicación web de Blazor inyecta el AzureOpenAIClient registrado en la parte superior del componente Home.Razor:

@inject AzureOpenAIClient azureOpenAIClient

Cuando el usuario envía el formulario, el AzureOpenAIClient envía su solicitud al modelo de OpenAI para generar una finalización:

ChatClient chatClient = azureOpenAIClient.GetChatClient("gpt-4o-mini");

messages.Add(new UserChatMessage(model.UserMessage));

ChatCompletion completion = await chatClient.CompleteChatAsync(messages);

messages.Add(new SystemChatMessage(completion.Content[0].Text));

Exploración del código de ejemplo

Aunque OpenAI y el servicio OpenAI de Azure se basan en una openai (biblioteca cliente común de JavaScript), se necesitan pequeños cambios de código al usar puntos de conexión de Azure OpenAI. Veamos cómo este ejemplo configura la autenticación sin claves con Microsoft Entra ID y se comunica con Azure OpenAI.

Autenticación sin claves para cada entorno

La biblioteca cliente de identidades de Azure proporciona clases de credenciales que implementan el protocolo TokenCredential de la biblioteca de Azure Core. Una credencial representa un flujo de autenticación distinto para adquirir un token de acceso de Microsoft Entra ID. Estas credenciales se pueden encadenar con ChainedTokenCredential para formar una secuencia ordenada de mecanismos de autenticación que se van a intentar. Esto le permite implementar el mismo código en entornos de producción y desarrollo local.

Configuración de la autenticación con la identidad administrada

En este ejemplo, ./src/azure-authentication.ts proporciona varias funciones para proporcionar autenticación sin claves a Azure OpenAI.

La primera función, getChainedCredential(), devuelve la primera credencial de Azure válida que se encuentra en la cadena.

function getChainedCredential() {

return new ChainedTokenCredential(

new ManagedIdentityCredential(process.env.AZURE_CLIENT_ID!),

new AzureDeveloperCliCredential({

tenantId: process.env.AZURE_TENANT_ID! ? process.env.AZURE_TENANT_ID! : undefined

})

);

}

- ManagedIdentityCredential se intenta primero. Se configura con la variable de entorno AZURE_CLIENT_ID en tiempo de ejecución de producción y es capaz de autenticarse a través de la identidad administrada asignada por el usuario.

- AzureDeveloperCliCredential se intenta en segundo lugar. Se configura cuando un desarrollador inicia sesión con

az loginde la CLI de Azure.

Sugerencia

El orden de las credenciales es importante, ya que se usa el primer token de acceso válido de Microsoft Entra. Para obtener más información, consulte el artículo Información general sobre ChainedTokenCredential.

Obtención del token de portador para OpenAI

La segunda función de ./src/azure-authentication.ts es getTokenProvider(), que devuelve una devolución de llamada que proporciona un token de portador con ámbito al punto de conexión de Azure Cognitive Services.

function getTokenProvider(): () => Promise<string> {

const credential = getChainedCredential();

const scope = "https://cognitiveservices.azure.com/.default";

return getBearerTokenProvider(credential, scope);

}

El fragmento de código anterior usa getBearerTokenProvider para tomar la credencial y el ámbito y, a continuación, devuelve una devolución de llamada que proporciona un token de portador.

Creación de un cliente autenticado de Azure OpenAI

La tercera función de ./src/azure-authentication.ts es getOpenAiClient(), que devuelve el cliente de Azure OpenAI.

export function getOpenAiClient(): AzureOpenAI | undefined{

try {

if (!process.env.AZURE_OPENAI_ENDPOINT) {

throw new Error("AZURE_OPENAI_ENDPOINT is required for Azure OpenAI");

}

if (!process.env.AZURE_OPENAI_CHAT_DEPLOYMENT) {

throw new Error("AZURE_OPENAI_CHAT_DEPLOYMENT is required for Azure OpenAI");

}

const options = {

azureADTokenProvider: getTokenProvider(),

deployment: process.env.AZURE_OPENAI_CHAT_DEPLOYMENT!,

apiVersion: process.env.AZURE_OPENAI_API_VERSION! || "2024-02-15-preview",

endpoint: process.env.AZURE_OPENAI_ENDPOINT!

}

// Create the Asynchronous Azure OpenAI client

return new AzureOpenAI (options);

} catch (error) {

console.error('Error getting Azure OpenAI client: ', error);

}

}

Este código toma las opciones, incluido el token con ámbito correcto, y crea el cliente de AzureOpenAI.

Transmisión de respuesta de chat con Azure OpenAI

Use el siguiente controlador de rutas Fastify en ./src/openai-chat-api.ts para enviar un mensaje a Azure OpenAI y transmitir la respuesta.

import { FastifyReply, FastifyRequest } from 'fastify';

import { AzureOpenAI } from "openai";

import { getOpenAiClient } from './azure-authentication.js';

import { ChatCompletionChunk, ChatCompletionMessageParam } from 'openai/resources/chat/completions';

interface ChatRequestBody {

messages: ChatCompletionMessageParam [];

}

export async function chatRoute (request: FastifyRequest<{ Body: ChatRequestBody }>, reply: FastifyReply) {

const requestMessages: ChatCompletionMessageParam[] = request?.body?.messages;

const openaiClient: AzureOpenAI | undefined = getOpenAiClient();

if (!openaiClient) {

throw new Error("Azure OpenAI client is not configured");

}

const allMessages = [

{ role: "system", content: "You are a helpful assistant."},

...requestMessages

] as ChatCompletionMessageParam [];

const chatCompletionChunks = await openaiClient.chat.completions.create({

// Azure Open AI takes the deployment name as the model name

model: process.env.AZURE_OPENAI_CHAT_DEPLOYMENT_MODEL || "gpt-4o-mini",

messages: allMessages,

stream: true

})

reply.raw.setHeader('Content-Type', 'text/html; charset=utf-8');

reply.raw.setHeader('Cache-Control', 'no-cache');

reply.raw.setHeader('Connection', 'keep-alive');

reply.raw.flushHeaders();

for await (const chunk of chatCompletionChunks as AsyncIterable<ChatCompletionChunk>) {

for (const choice of chunk.choices) {

reply.raw.write(JSON.stringify(choice) + "\n")

}

}

reply.raw.end()

}

La función obtiene la conversación de chat, incluidos los mensajes anteriores, y los envía a Azure OpenAI. A medida que se devuelven los fragmentos de secuencia desde Azure OpenAI, se envían al cliente.

Otras consideraciones de seguridad

En este artículo se muestra cómo el ejemplo usa ChainedTokenCredential para autenticarse en el servicio Azure OpenAI.

El ejemplo también tiene una acción de GitHub que examina los archivos de infraestructura como código y genera un informe que contiene los problemas detectados. Para garantizar los procedimientos recomendados continuos en su propio repositorio, se recomienda que cualquier persona que cree soluciones basadas en nuestras plantillas compruebe que la configuración de análisis de secretos de GitHub esté habilitada.

Considere otras medidas de seguridad, como:

Restringir el acceso al conjunto adecuado de usuarios de aplicaciones mediante Microsoft Entra.

Proteger la instancia de Azure Container Apps con un firewall o una red virtual.

Limpieza de recursos

Limpieza de los recursos de Azure

Los recursos Azure creados en este artículo se facturan a su suscripción Azure. Si no espera necesitar estos recursos en el futuro, elimínelos para evitar incurrir en más gastos.

Para borrar los recursos de Azure y eliminar el código fuente, ejecute el siguiente comando de Azure Developer CLI:

azd down --purge

Limpiar GitHub Codespaces

La eliminación del entorno de GitHub Codespaces garantiza que pueda maximizar la cantidad de derechos de horas gratuitas por núcleo que obtiene para su cuenta.

Importante

Para obtener más información sobre los derechos de la cuenta de GitHub, consulte Almacenamiento y horas de núcleo incluidas mensualmente en GitHub Codespaces.

Inicie sesión en el panel de GitHub Codespaces.

Busque los espacios de código que se ejecutan actualmente procedentes del repositorio de GitHub

Azure-Samples/openai-chat-app-quickstart.Abra el menú contextual del codespace y, a continuación, seleccione Eliminar.

Inicie sesión en el panel de GitHub Codespaces.

Busque los espacios de código que se ejecutan actualmente procedentes del repositorio de GitHub

Azure-Samples/openai-chat-app-quickstart-dotnet.Abra el menú contextual del codespace y, a continuación, seleccione Eliminar.

Inicie sesión en el panel de GitHub Codespaces.

Busque los espacios de código que se ejecutan actualmente procedentes del repositorio de GitHub

Azure-Samples/openai-chat-app-quickstart-javascript.Abra el menú contextual del codespace y, a continuación, seleccione Eliminar.

Obtener ayuda

Si su problema no se resuelve, regístrelo en el apartado de problemas del repositorio.

Pasos siguientes

Si su problema no se resuelve, regístrelo en el apartado de problemas del repositorio.

Si su problema no se resuelve, regístrelo en el apartado de problemas del repositorio.