Ajuste preciso de modelos con Azure AI Foundry

Importante

Los elementos marcados (versión preliminar) en este artículo se encuentran actualmente en versión preliminar pública. Esta versión preliminar se ofrece sin acuerdo de nivel de servicio y no se recomienda para las cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

El ajuste preciso hace referencia a la personalización de un modelo de IA generativa previamente entrenado con entrenamiento adicional en una tarea específica o un nuevo conjunto de datos para mejorar el rendimiento, las nuevas aptitudes o la precisión. El resultado es un nuevo modelo de GenAI personalizado optimizado en función de los ejemplos proporcionados.

Considere la posibilidad de ajustar los modelos de GenAI para:

- Escalar y adaptarse a necesidades empresariales específicas

- Reducir los falsos positivos, ya que es menos probable que los modelos adaptados produzcan respuestas inexactas o irrelevantes

- Mejorar la precisión del modelo para tareas específicas del dominio

- Ahorrar tiempo y recursos con resultados más rápidos y precisos

- Obtenga resultados más pertinentes y adaptados al contexto a medida que los modelos se ajustan a casos de uso específicos

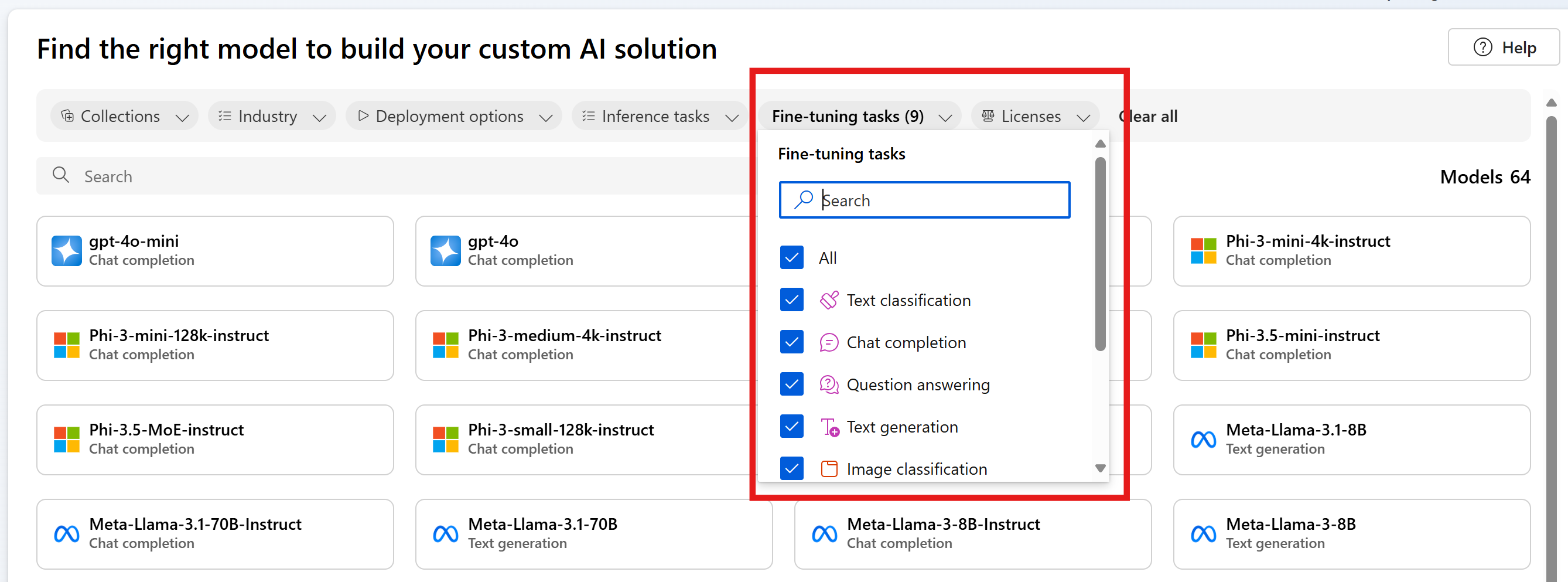

Azure AI Foundry ofrece varios modelos a través de proveedores de modelos, que le permiten acceder a lo último y lo mejor del mercado. Puede detectar modelos compatibles para ajustar a través de nuestro catálogo de modelo mediante el filtro Tareas de ajuste preciso y seleccione la tarjeta de modelo para obtener información detallada sobre cada modelo. Los modelos específicos pueden estar sujetos a restricciones regionales, vea esta lista para obtener más detalles.

Este artículo le guiará a través de casos de uso para el ajuste preciso y cómo esto puede ayudarle en su recorrido de GenAI.

Introducción a la optimización

Al comenzar en el recorrido de la IA generativa, se recomienda comenzar con la ingeniería de solicitudes y RAG para familiarizarse con los modelos base y sus funcionalidades.

- La ingeniería de solicitudes es una técnica que consiste en diseñar solicitudes mediante detalles de estilo y tono, ejemplos de respuestas y asignación de intenciones para modelos de procesamiento de lenguaje natural. Este proceso mejora la precisión y la relevancia de las respuestas para optimizar el rendimiento del modelo.

- Generación aumentada de recuperación (RAG): mejora el rendimiento del modelo de LLM mediante la recuperación de datos de orígenes externos y la incorporación de dichos datos a una solicitud. RAG puede ayudar a las empresas a desarrollar soluciones personalizadas al tiempo que mantienen la relevancia de los datos y optimizan los costos.

A medida que se vaya sintiendo cómodo y empiece a crear su solución, es importante que entienda en qué puntos se queda corta la ingeniería de solicitudes, lo que le ayudará a darse cuenta de si debe intentar un ajuste preciso.

- ¿Se produce un error del modelo base en casos limítrofes o excepciones?

- ¿El modelo básico no proporciona sistemáticamente resultados en el formato correcto?

- ¿Es difícil ajustar suficientes ejemplos en la ventana de contexto para dirigir el modelo?

- ¿Hay una latencia alta?

Algunos ejemplos de errores con el modelo base y la ingeniería de solicitudes pueden ayudarle a identificar los datos que se van a recopilar para ajustar y establecer una línea base de rendimiento con la que puede evaluar y comparar el modelo ajustado. Tener una base de referencia para el rendimiento sin ajuste preciso es esencial para saber si el ajuste preciso mejora o no el rendimiento del modelo.

Este es un ejemplo:

Un cliente quiere usar GPT-3.5 Turbo para convertir preguntas de lenguaje natural en consultas en un lenguaje de consulta específico y no estándar. El cliente proporciona instrucciones en la solicitud (“Devolver siempre GQL”) y ha usado RAG para recuperar el esquema de la base de datos. Sin embargo, la sintaxis no siempre es correcta y a menudo se producen errores en los casos perimetrales. El cliente recopila miles de ejemplos de preguntas de lenguaje natural y las consultas equivalentes para la base de datos, incluidos los casos en los que se produjo un error en el modelo antes. A continuación, el cliente usa esos datos para ajustar el modelo de manera precisa. La combinación de su nuevo modelo ajustado de forma precisa con su solicitud y recuperación diseñadas aporta la precisión de las salidas del modelo hasta estándares aceptables para su uso.

Casos de uso

Los modelos base ya están entrenados previamente en grandes cantidades de datos y la mayoría de las veces agregará instrucciones y ejemplos a la solicitud para obtener las respuestas de calidad que está buscando; este proceso se denomina "aprendizaje de pocas capturas". El ajuste preciso le permite entrenar un modelo con muchos más ejemplos que puede adaptar para satisfacer su caso de uso específico, mejorando así el aprendizaje de pocas capturas. Esto puede reducir el número de tokens en la solicitud que conduce a posibles ahorros de costes y solicitudes con una menor latencia.

Convertir el lenguaje natural en un lenguaje de consulta es solo un caso de uso en el que puede mostrar, no decir, al modelo cómo debe comportarse. Estos son algunos casos de uso adicionales:

- Mejorar el control del modelo de datos recuperados

- Dirigir el modelo para generar contenido en un estilo, tono o formato específicos

- Mejorar la precisión al buscar información

- Reducir la longitud de la solicitud

- Enseñar nuevas aptitudes (es decir, lenguaje natural al código)

Si identifica el costo como motivador principal, continúe con precaución. El ajuste preciso podría reducir los costos de determinados casos de uso al acortar las solicitudes o permitirle usar un modelo más pequeño. Pero puede haber un mayor coste inicial para el entrenamiento y tiene que pagar por hospedar su propio modelo personalizado.

Pasos para ajustar un modelo

Estos son los pasos generales para ajustar un modelo:

- En función del caso de uso, elija un modelo que admita la tarea

- Preparar y cargar los datos de entrenamiento

- (Opcional) Preparar y cargar datos de validación

- (Opcional) Configurar parámetros de la tarea

- Entrene el modelo.

- Una vez completado, revisar las métricas y evaluar el modelo. Si los resultados no cumplen el punto de referencia, vuelva al paso 2.

- Use el modelo ajustado

Es importante destacar que el ajuste preciso depende en gran medida de la calidad de los datos que puede proporcionar. Es recomendable proporcionar cientos, o incluso miles, de ejemplos de entrenamiento para llevarlos a cabo correctamente y obtener los resultados deseados.

Modelos admitidos para el ajuste preciso

Ahora que sabe cuándo usar el ajuste preciso para su caso de uso, puede ir a Azure AI Foundry para encontrar varios modelos disponibles para ajustarlos de manera precisa. Para algunos modelos del catálogo de modelo, el ajuste preciso está disponible mediante una API sin servidor o un proceso administrado (versión preliminar) o ambos.

El ajuste preciso está disponible en regiones específicas de Azure para algunos modelos que se implementan a través de API sin servidor. Para ajustar estos modelos, un usuario debe tener un centro o proyecto en la región donde el modelo está disponible para el ajuste preciso. Para obtener más información, consulte Disponibilidad de regiones para modelos en puntos de conexión de API sin servidor.

Para más información sobre el ajuste preciso mediante un proceso administrado (versión preliminar), consulte Ajuste preciso de modelos mediante un proceso administrado (versión preliminar).

Para obtener más información sobre los modelos de Azure OpenAI que están disponibles para el ajuste preciso, consulte la Documentación sobre los modelos de Azure OpenAI Service o la tabla de modelos de Azure OpenAI más adelante en esta guía.

En el caso de los modelos de Azure OpenAI Service que puede ajustar, las regiones admitidas para la optimización incluyen Centro-norte de EE. UU., Centro de Suecia, etc.

Ajuste preciso de los modelos de Azure OpenAI

Nota:

gpt-35-turbo: el ajuste preciso de este modelo se limita a un subconjunto de regiones y no está disponible en todas las regiones en las que el modelo base está disponible.

Las regiones admitidas para el ajuste fino pueden variar si usa modelos de Azure OpenAI en un proyecto de Azure AI Foundry frente a fuera de un proyecto.

| Id. de modelo | Regiones de ajuste preciso | Solicitud máxima (tokens) | Datos de entrenamiento (hasta) |

|---|---|---|---|

babbage-002 |

Centro-Norte de EE. UU Centro de Suecia Oeste de Suiza |

16 384 | Septiembre de 2021 |

davinci-002 |

Centro-Norte de EE. UU Centro de Suecia Oeste de Suiza |

16 384 | Septiembre de 2021 |

gpt-35-turbo (0613) |

Este de EE. UU. 2 Centro-Norte de EE. UU Centro de Suecia Oeste de Suiza |

4 096 | Septiembre de 2021 |

gpt-35-turbo (1106) |

Este de EE. UU. 2 Centro-Norte de EE. UU Centro de Suecia Oeste de Suiza |

Entrada: 16 385 Salida: 4096 |

Septiembre de 2021 |

gpt-35-turbo (0125) |

Este de EE. UU. 2 Centro-Norte de EE. UU Centro de Suecia Oeste de Suiza |

16 385 | Septiembre de 2021 |

gpt-4 (0613) 1 |

Centro-Norte de EE. UU Centro de Suecia |

8192 | Septiembre de 2021 |

gpt-4o-mini (18-07-2024) |

Centro-Norte de EE. UU Centro de Suecia |

Entrada: 128 000 Salida: 16 384 Longitud del contexto de ejemplo de entrenamiento: 64,536 |

Octubre de 2023 |

gpt-4o (2024-08-06) |

Este de EE. UU. 2 Centro-Norte de EE. UU Centro de Suecia |

Entrada: 128 000 Salida: 16 384 Longitud del contexto de ejemplo de entrenamiento: 64,536 |

Octubre de 2023 |

1 GPT-4 se encuentra actualmente en versión preliminar pública.

Contenido relacionado

- Optimización de modelos mediante proceso administrado (versión preliminar)

- Ajustar de manera precisa un modelo de Azure OpenAI en el portal de Azure AI Foundry

- Ajuste preciso de un modelo Llama 2 en Inteligencia artificial del portal de Azure AI Foundry

- Ajuste preciso de un modelo Phi-3 en Inteligencia artificial del portal de Azure AI Foundry

- Implementación de la familia Phi-3 de modelos de lenguaje pequeños con Azure AI Foundry