Evaluación de aplicaciones de IA generativas

Importante

Los elementos marcados (versión preliminar) en este artículo se encuentran actualmente en versión preliminar pública. Esta versión preliminar se ofrece sin acuerdo de nivel de servicio y no se recomienda para las cargas de trabajo de producción. Es posible que algunas características no sean compatibles o que tengan sus funcionalidades limitadas. Para más información, consulte Términos de uso complementarios de las Versiones Preliminares de Microsoft Azure.

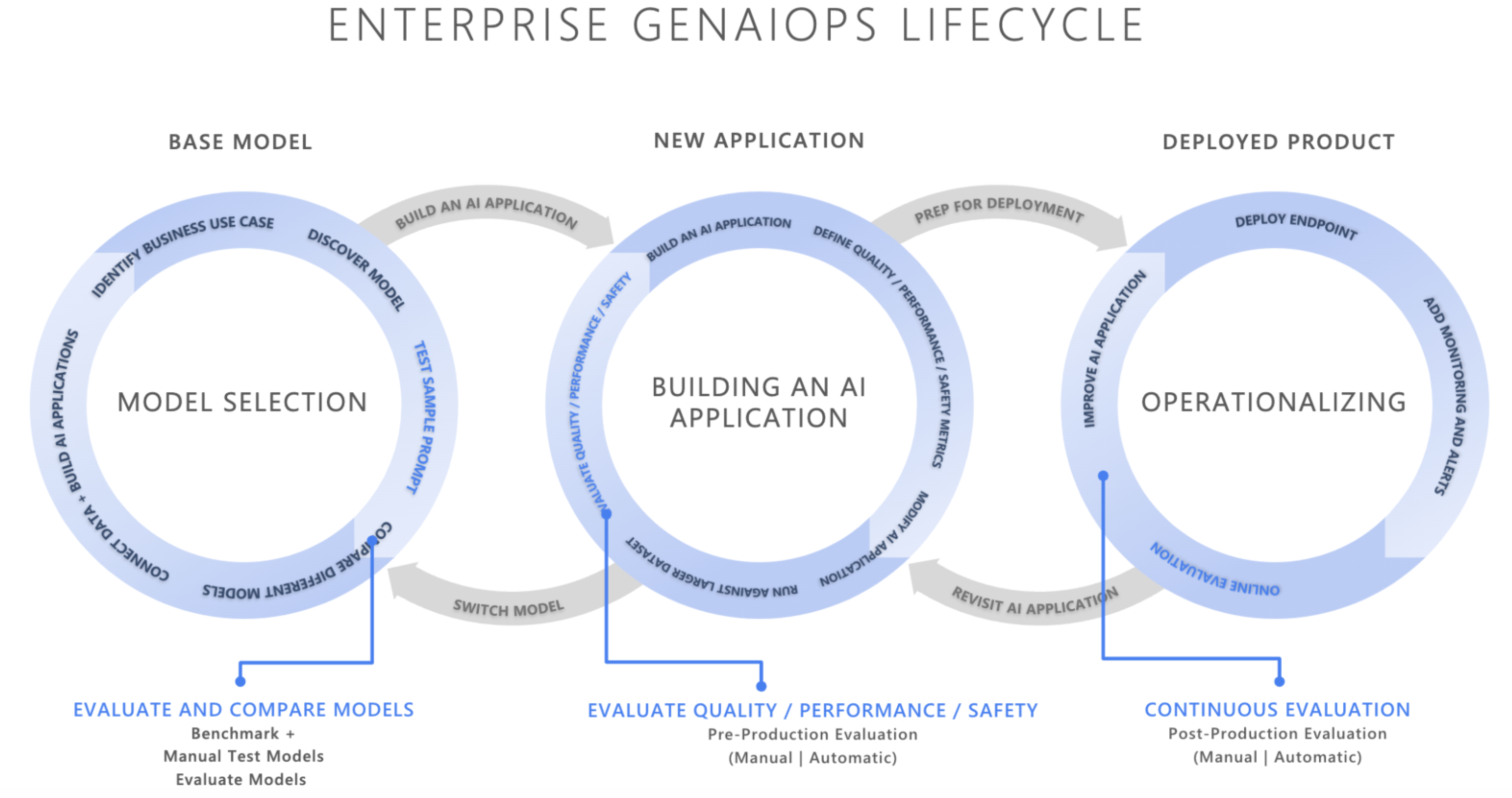

En el panorama de rápida evolución de la inteligencia artificial, la integración de operaciones de inteligencia artificial generativa (GenAIOps) está transformando cómo las organizaciones desarrollan e implementan aplicaciones de inteligencia artificial. A medida que las empresas dependen cada vez más de la inteligencia artificial para mejorar la toma de decisiones, mejorar las experiencias de los clientes e impulsar la innovación, la importancia de un marco de evaluación sólido no se puede superar. La evaluación es un componente esencial del ciclo de vida de la inteligencia artificial generativa para crear confianza y confianza en aplicaciones centradas en la inteligencia artificial. Si no se diseña cuidadosamente, estas aplicaciones pueden producir salidas que se fabrican y no están en primer plano en contexto, irrelevantes o incoherentes, lo que da lugar a experiencias deficientes de los clientes, o peor, perpetuar los estereotipos sociales, promover la información incorrecta, exponer a las organizaciones a ataques malintencionados o a una amplia gama de otros impactos negativos.

Los evaluadores son herramientas útiles para evaluar la frecuencia y la gravedad de los riesgos de contenido o el comportamiento no deseado en las respuestas de ia. La realización de evaluaciones sistemáticas iterativas con los evaluadores adecuados puede ayudar a los equipos a medir y abordar posibles problemas de calidad, seguridad o seguridad de respuesta a lo largo del ciclo de vida de desarrollo de la inteligencia artificial, desde la selección inicial del modelo a través de la supervisión posterior a la producción. Evaluación dentro de la producción del ciclo de vida de operaciones de GenAI.

Al comprender e implementar estrategias de evaluación eficaces en cada fase, las organizaciones pueden garantizar que sus soluciones de inteligencia artificial no solo cumplan las expectativas iniciales, sino que también se adapten y crezcan en entornos reales. Vamos a profundizar en cómo encaja la evaluación en las tres fases críticas del ciclo de vida de la inteligencia artificial

Selección del modelo base

La primera fase del ciclo de vida de la inteligencia artificial implica seleccionar un modelo base adecuado. Los modelos de IA generativa varían ampliamente en términos de funcionalidades, fortalezas y limitaciones, por lo que es esencial identificar qué modelo se adapta mejor a su caso de uso específico. Durante la evaluación del modelo base, se "compra" para comparar diferentes modelos probando sus salidas con un conjunto de criterios relevantes para la aplicación.

Entre las consideraciones clave de esta fase se pueden incluir las siguientes:

- Precisión y calidad: ¿Cómo genera el modelo respuestas relevantes y coherentes?

- Rendimiento en tareasespecíficas: ¿El modelo puede controlar el tipo de mensajes y el contenido necesarios para su caso de uso? ¿Cómo es su latencia y costo?

- Consideraciones éticas y de sesgo: ¿Produce el modelo resultados que podrían perpetuar o promover estereotipos dañinos?

- Riesgo y seguridad: ¿Existe algún riesgo para el modelo que genera contenido no seguro o malintencionado?

Puede explorar las pruebas comparativas de Azure AI Foundry para evaluar y comparar modelos en conjuntos de datos disponibles públicamente, al tiempo que regenera los resultados de pruebas comparativas en sus propios datos. Como alternativa, puede evaluar uno de los muchos modelos de IA generativos base mediante el SDK de evaluación de Azure AI, como se muestra, consulte Ejemplo de evaluación de puntos de conexión del modelo.

Evaluación previa a la producción

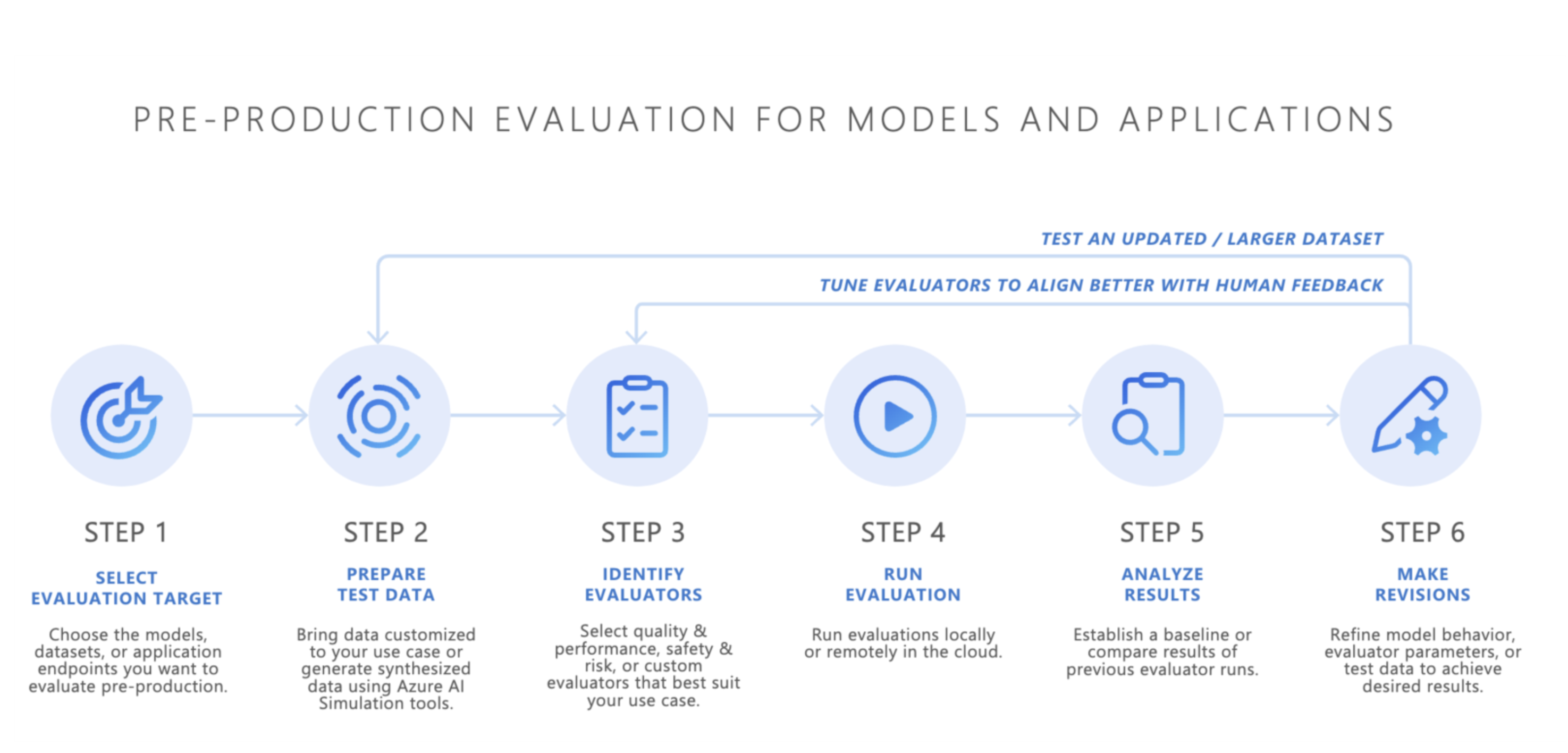

Después de seleccionar un modelo base, el siguiente paso consiste en desarrollar una aplicación de inteligencia artificial, como un bot de chat con tecnología de IA, una aplicación de generación aumentada por recuperación (RAG), una aplicación de IA agente o cualquier otra herramienta de inteligencia artificial generativa. Después del desarrollo, comienza la evaluación de preproducción. Antes de implementar la aplicación en un entorno de producción, las pruebas rigurosas son esenciales para asegurarse de que el modelo está realmente listo para su uso real.

La evaluación previa a la producción implica:

- Pruebas con conjuntos de datos de evaluación: estos conjuntos de datos simulan interacciones realistas del usuario para asegurarse de que la aplicación de inteligencia artificial funciona según lo previsto.

- Identificación de casos perimetrales: la búsqueda de escenarios en los que la calidad de respuesta de la aplicación de IA podría degradar o producir salidas no deseadas.

- Evaluación de la solidez: asegurarse de que el modelo puede controlar una variedad de variaciones de entrada sin caídas significativas de calidad o seguridad.

- Medición de métricas clave: se evalúan métricas como la base de respuesta, la relevancia y la seguridad para confirmar la preparación para producción.

La fase de preproducción actúa como una comprobación de calidad final, lo que reduce el riesgo de implementar una aplicación de inteligencia artificial que no cumpla los estándares de rendimiento o seguridad deseados.

- Traiga sus propios datos: puede evaluar las aplicaciones de inteligencia artificial en preproducción mediante sus propios datos de evaluación con los evaluadores admitidos del SDK de evaluación de Azure AI o Azure AI Evaluation, incluidos los evaluadores de calidad de generación, seguridad o personalizados ,y ver los resultados a través del portal de Azure AI Foundry.

- Simuladores: si no tiene datos de evaluación (datos de prueba), los simuladores del SDK de evaluación de Azure AI pueden ayudarle mediante la generación de consultas relacionadas con temas o adversarios. Estos simuladores prueban la respuesta del modelo a consultas de tipo ataque o adecuadas para situaciones (casos perimetrales).

- El simulador adversario inserta consultas que imitan posibles amenazas de seguridad o intentan jailbreaks, lo que ayuda a identificar limitaciones y a preparar el modelo para condiciones inesperadas.

- Los simuladores adecuados para el contexto generan conversaciones típicas y relevantes que esperaría que los usuarios prueben la calidad de las respuestas.

Como alternativa, también puede usar el widget de evaluación de Azure AI Foundry para probar las aplicaciones de IA generativas.

Una vez que se logran resultados satisfactorios, la aplicación de inteligencia artificial se puede implementar en producción.

Supervisión posterior a la producción

Después de la implementación, la aplicación de inteligencia artificial entra en la fase de evaluación posterior a la producción, también conocida como evaluación o supervisión en línea. En esta fase, el modelo se inserta dentro de un producto real y responde a consultas de usuario reales. La supervisión garantiza que el modelo siga comportándose según lo previsto y se adapte a los cambios en el comportamiento o el contenido del usuario.

- Seguimiento continuo del rendimiento: medición periódica de la respuesta de la aplicación de IA mediante métricas clave para garantizar una calidad de salida coherente.

- Respuesta a incidentes: responde rápidamente a las salidas perjudiciales, desleales o inapropiadas que pueden surgir durante el uso real.

Al supervisar continuamente el comportamiento de la aplicación de inteligencia artificial en producción, puede mantener experiencias de usuario de alta calidad y solucionar rápidamente los problemas que se produzcan.

Conclusión

GenAIOps consiste en establecer un proceso confiable y repetible para administrar aplicaciones de inteligencia artificial generativas en su ciclo de vida. La evaluación desempeña un papel fundamental en cada fase, desde la selección del modelo base, hasta las pruebas de preproducción, hasta la supervisión continua posterior a la producción. Al medir y abordar sistemáticamente los riesgos y refinar los sistemas de inteligencia artificial en todos los pasos, los equipos pueden crear soluciones de inteligencia artificial generativas que no sean solo eficaces, sino que también sean confiables y seguras para el uso real.

Hoja de referencia rápida:

| Fin | Proceso | Parámetros |

|---|---|---|

| ¿Para qué está evaluando? | Identificación o compilación de evaluadores pertinentes | - Calidad y rendimiento ( Cuaderno de ejemplo de calidad y rendimiento) - Seguridad y seguridad (cuaderno de ejemplo seguridad y seguridad) - Personalizado (bloc de notas de ejemplo personalizado) |

| ¿Qué datos debe usar? | Cargar o generar un conjunto de datos pertinente | Simulador genérico para medir la calidad y el rendimiento (cuaderno de ejemplo de simulador genérico) - Simulador adversario para medir la seguridad y la seguridad (cuaderno de ejemplo del simulador adversario) |

| ¿Qué recursos deben llevar a cabo la evaluación? | Ejecución de la evaluación | Ejecución local - Ejecución remota en la nube |

| ¿Cómo ha funcionado mi modelo o aplicación? | Analizar resultados | Ver puntuaciones de agregado, ver detalles, detalles de puntuación, comparar ejecuciones de evaluación |

| ¿Cómo puedo mejorar? | Realizar cambios en los modelos, aplicaciones o evaluadores | - Si los resultados de la evaluación no se alinean con los comentarios humanos, ajuste el evaluador. - Si los resultados de la evaluación se alinean con los comentarios humanos, pero no cumplen los umbrales de calidad y seguridad, aplique mitigaciones dirigidas. |

Contenido relacionado

- Evaluación de las aplicaciones de IA generativas a través del área de juegos

- Evaluación de las aplicaciones de IA generativas con el SDK o el portal de Azure AI Foundry

- Métricas de evaluación y supervisión para la inteligencia artificial generativa

- Nota sobre transparencia para las evaluaciones de seguridad de Azure AI Foundry