Obtenga información sobre cómo configurar filtros de contenido con Azure AI Foundry

El sistema de filtrado de contenido integrado en Azure AI Foundry se ejecuta junto con los modelos principales, incluidos los modelos de generación de imágenes DALL-E. Usa un conjunto de modelos de clasificación de varias clases para detectar cuatro categorías de contenido dañino (violencia, odio, sexo y autolesiones) en cuatro niveles de gravedad respectivamente (seguro, bajo, medio y alto). También emplea clasificadores binarios opcionales para detectar riesgo de jailbreak, texto existente y código de repositorios públicos.

La configuración de filtrado de contenido predeterminada se establece para filtrar en el umbral de gravedad media para las cuatro categorías de daños en el contenido para las solicitudes y finalizaciones. Esto significa que el contenido que se detecta en el nivel de gravedad medio o alto se filtra con los filtros de contenido, mientras que el contenido detectado en el nivel de gravedad bajo o seguro no se filtra. Obtenga más información sobre las categorías de contenido, los niveles de gravedad y el comportamiento del sistema de filtrado de contenido aquí.

La detección de riesgo de jailbreak y los modelos de código y texto protegidos son opcionales y están activados de forma predeterminada. Para los modelos de código y texto de material protegido y de jailbreak, la característica de configuración permite a todos los clientes activar y desactivar los modelos. Los modelos están activados de forma predeterminada y se pueden desactivar según su escenario. Algunos modelos deben estar en determinados escenarios para conservar la cobertura en el compromiso de derechos de autor del cliente.

Nota:

Todos los clientes tienen la capacidad de modificar los filtros de contenido y configurar los umbrales de gravedad (bajo, medio, alto). La aprobación es necesaria para desactivar los filtros de contenido parcialmente o totalmente desactivados. Los clientes administrados solo pueden solicitar el control de filtrado de contenido completo mediante este formato: Revisión de acceso limitado de Azure OpenAI: filtros de contenido modificados. En este momento, no es posible convertirse en un cliente administrado.

Los filtros de contenido se pueden configurar en el nivel de recurso. Una vez creada una nueva configuración, se puede asociar a una o varias implementaciones. Para obtener más información sobre la implementación de modelos, consulte la guía de implementación de recursos.

Requisitos previos

- Debe tener un recurso de Azure OpenAI y una implementación de modelo de lenguaje grande (LLM) para configurar filtros de contenido. Siga un inicio rápido para comenzar.

Descripción de la configuración del filtro de contenido

Azure OpenAI Service incluye la configuración de seguridad predeterminada aplicada a todos los modelos, excepto Azure OpenAI Whisper. Estas configuraciones le proporcionan una experiencia responsable de forma predeterminada, incluyendo modelos de filtrado de contenidos, listas de bloqueo, transformación de avisos, credenciales de contenido, y otros. Aquí encontrará más información.

Todos los clientes también pueden configurar filtros de contenido y crear directivas de seguridad personalizadas adaptadas a sus requisitos de casos de uso. La característica de configuración permite a los clientes ajustar la configuración, por separado para solicitudes y finalizaciones, para filtrar el contenido de cada categoría de contenido en distintos niveles de gravedad, tal y como se describe en la tabla siguiente. El contenido detectado en el nivel de gravedad "seguro" está etiquetado en anotaciones, pero no está sujeto al filtrado y no es configurable.

| Gravedad filtrada | Configurable para solicitudes | Configurable para finalizaciones | Descripciones |

|---|---|---|---|

| Bajo, medio, alto | Sí | Sí | Configuración de filtrado más estricta. El contenido detectado en niveles de gravedad bajo, medio y alto se filtra. |

| Medio y alto | Sí | Sí | El contenido detectado en el nivel de gravedad bajo no se filtra, sino que se filtra el contenido de un nivel medio y alto. |

| Alto | Sí | Sí | El contenido detectado en niveles de gravedad bajo y medio no se filtra. Solo se filtra el contenido en el nivel de gravedad alto. |

| Sin filtros | Si se aprueba1 | Si se aprueba1 | No se filtra ningún contenido, independientemente del nivel de gravedad detectado. Requiere aprobación1. |

| Solo anotar | Si se aprueba1 | Si se aprueba1 | Deshabilita la funcionalidad de filtro, por lo que el contenido no se bloqueará, pero las anotaciones se devuelven a través de la respuesta de la API. Requiere aprobación1. |

1 En el caso de los modelos de Azure OpenAI, solo los clientes aprobados para el filtrado de contenidos modificado tienen el control total de los filtros de contenido y pueden desactivarlos. Solicite filtros de contenido modificado mediante este formulario: Revisión de acceso limitado de Azure OpenAI: filtros de contenido modificados. Los clientes de Azure Government pueden solicitar filtros de contenido modificados mediante este formulario: Azure Government: Solicitud de filtrado de contenido modificado para Azure OpenAI Service.

Los filtros de contenido configurables para entradas (indicaciones) y salidas (finalizaciones) están disponibles para todos los modelos de Azure OpenAI.

Las configuraciones de filtrado de contenido se crean dentro de un recurso en el portal de Azure AI Foundry y se pueden asociar a implementaciones. Obtenga más información sobre la capacidad de configuración aquí.

Los clientes son responsables de garantizar que las aplicaciones que integran Azure OpenAI cumplan con el código de conducta.

Descripción de otros filtros

Puede configurar las siguientes categorías de filtro además de los filtros de categoría de daños predeterminados.

| Categoría de filtro | Estado | Configuración predeterminada | ¿Se aplica a la solicitud o a la finalización? | Descripción |

|---|---|---|---|---|

| Escudos de solicitudes frente a ataques directos (jailbreak) | GA | Activado | Mensaje de usuario | Filtra o anota las indicaciones del usuario que podrían presentar un riesgo de jailbreak. Para obtener más información sobre las anotaciones, visite filtrado de contenido de Azure AI Foundry. |

| Escudos de solicitudes frente a ataques indirectos | GA | Desactivado | Mensaje de usuario | Filtrado o anotación de ataques indirectos, también conocidos como ataques indirectos de solicitudes o ataques de inyección de solicitudes entre dominios, una posible vulnerabilidad en la que terceros colocan instrucciones malintencionadas dentro de documentos a los que el sistema de inteligencia artificial generativa puede acceder y procesar. Requieren: inserción de documentos y formato. |

| Material protegido: código | GA | Activado | Completion | Filtra el código protegido u obtiene la cita de ejemplo y la información de licencia en anotaciones para fragmentos de código que coinciden con cualquier fuente de código público, impulsado por GitHub Copilot. Para más información sobre el consumo de anotaciones, consulte la guía de conceptos de filtrado de contenido. |

| Material protegido: texto | GA | Activado | Completion | Identifica y bloquea el contenido de texto conocido para que no aparezca en la salida del modelo (por ejemplo, letras de canciones, recetas y contenido web seleccionado). |

| "Groundedness" | Vista previa | Desactivado | Completion | Detecta si las respuestas de texto de los modelos de lenguaje grande (LLM) se basan en los materiales de origen proporcionados por los usuarios. La ausencia de base hace referencia a aquellas instancias en las que los LLM producen información no factual o inexacta de lo que estaba presente en los materiales de origen. Requieren: inserción de documentos y formato. |

Crear un filtro de contenido en Azure AI Foundry

Para cualquier implementación de modelos en Azure AI Foundry, puede usar directamente el filtro de contenido predeterminado, pero es posible que desee tener más control. Por ejemplo, podría hacer que un filtro sea más estricto o más permisivo, o habilitar funcionalidades más avanzadas, como escudos de avisos y detección de materiales protegidos.

Sugerencia

Para obtener instrucciones sobre los filtros de contenido en el proyecto de Azure AI Foundry, puede leer más en Filtrado de contenido de Azure AI Foundry.

Siga estos pasos para crear un filtro de contenido:

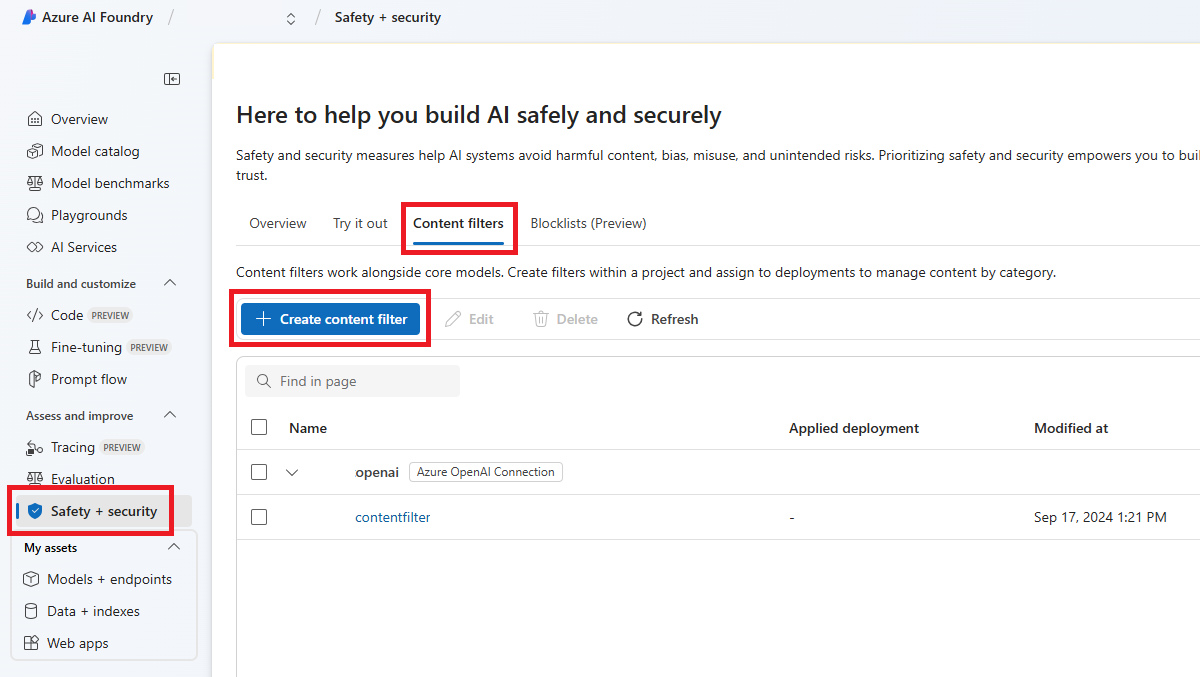

Vaya a Fundición de IA de Azure y diríjase a su proyecto. A continuación, seleccione la página Seguridad y protección en el menú izquierdo y seleccione la pestaña Filtros de contenido.

Seleccione + Crear filtro de contenido.

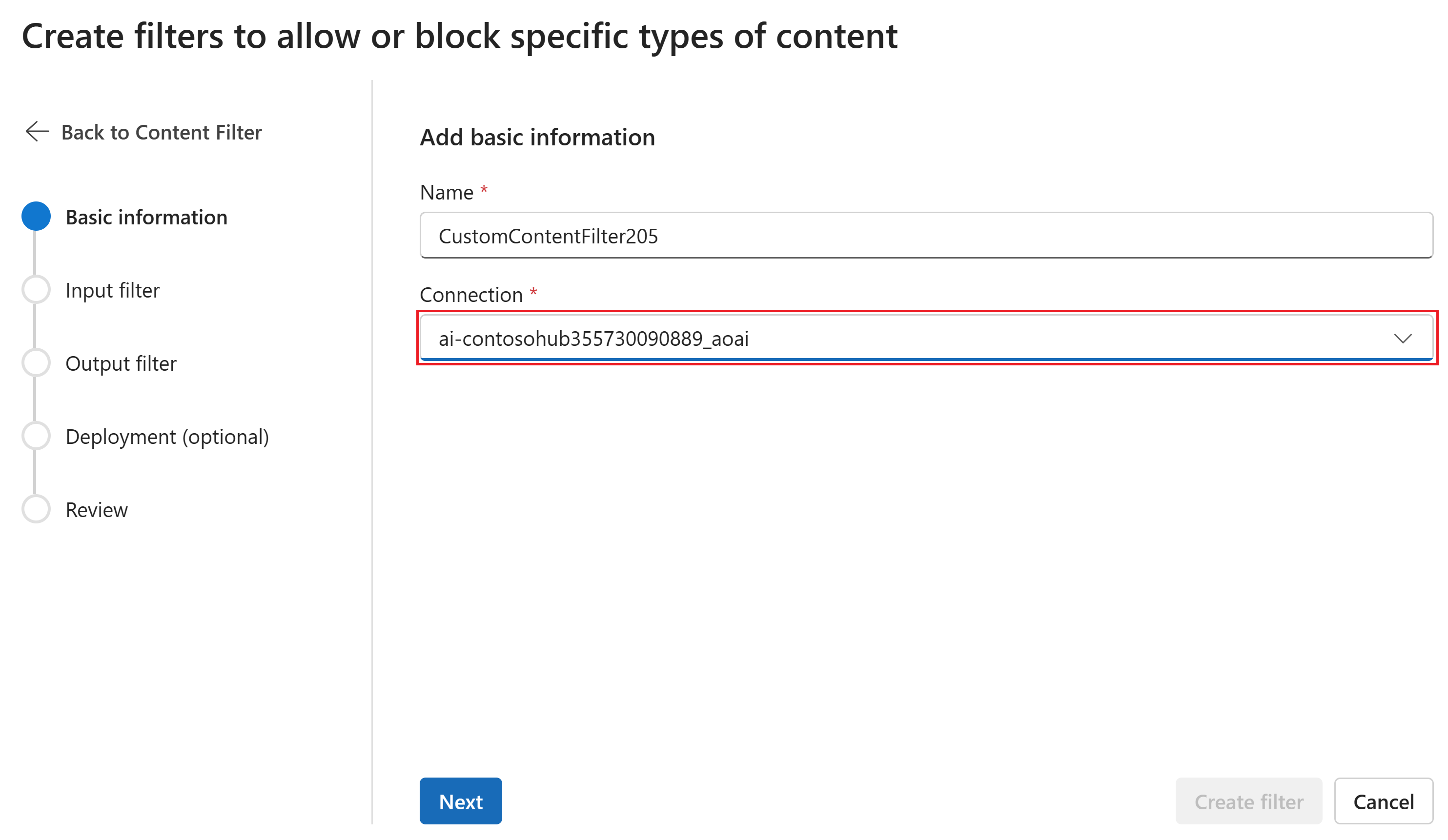

En la página Información básica, escriba un nombre para la configuración de filtrado de contenido. Seleccione una conexión para asociar con el filtro de contenido. Luego, seleccione Siguiente.

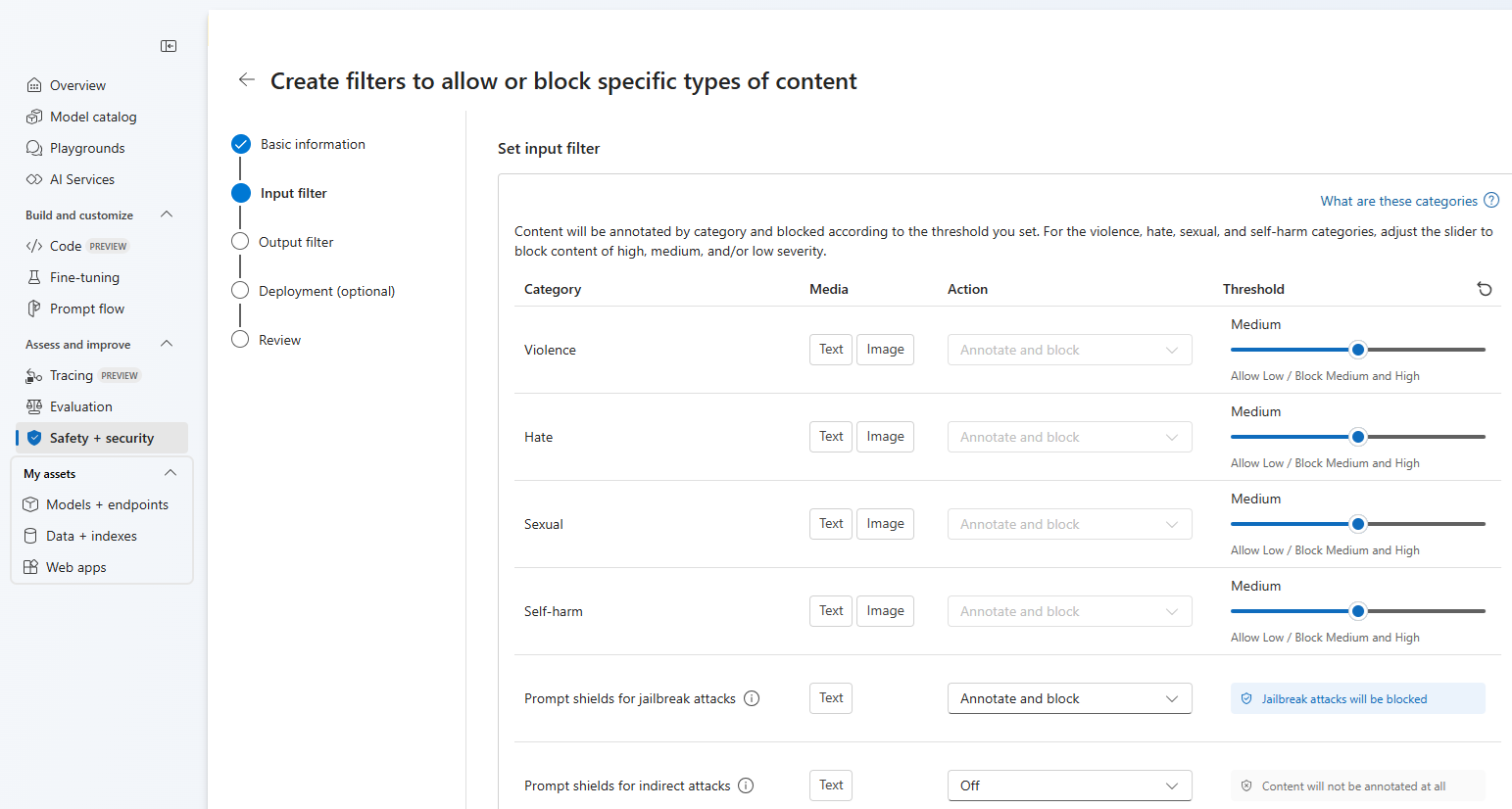

Ahora puede configurar los filtros de entrada (para solicitudes de usuario) y filtros de salida (para la finalización del modelo).

En la página Filtros de entrada, puede establecer el filtro para el mensaje de entrada. Para las cuatro primeras categorías de contenido hay tres niveles de gravedad que se pueden configurar: Bajo, medio y alto. Puede usar los controles deslizantes para establecer el umbral de gravedad si determina que la aplicación o el escenario de uso requieren un filtrado diferente al de los valores predeterminados. Algunos filtros, como Prompt Shields y la detección de materiales protegidos, permiten determinar si el modelo debe anotar o bloquear el contenido. Al seleccionar Anotar solo ejecuta el modelo correspondiente y devuelve anotaciones a través de la respuesta de la API, pero no filtrará el contenido. Además de anotar, también puede optar por bloquear el contenido.

Si el caso de uso se aprobó para los filtros de contenido modificados, recibirá control total sobre las configuraciones de filtrado de contenido y puede optar por activar el filtrado parcialmente o totalmente desactivado, o habilitar la anotación solo para las categorías de daños de contenido (violencia, odio, sexo y autolesión).

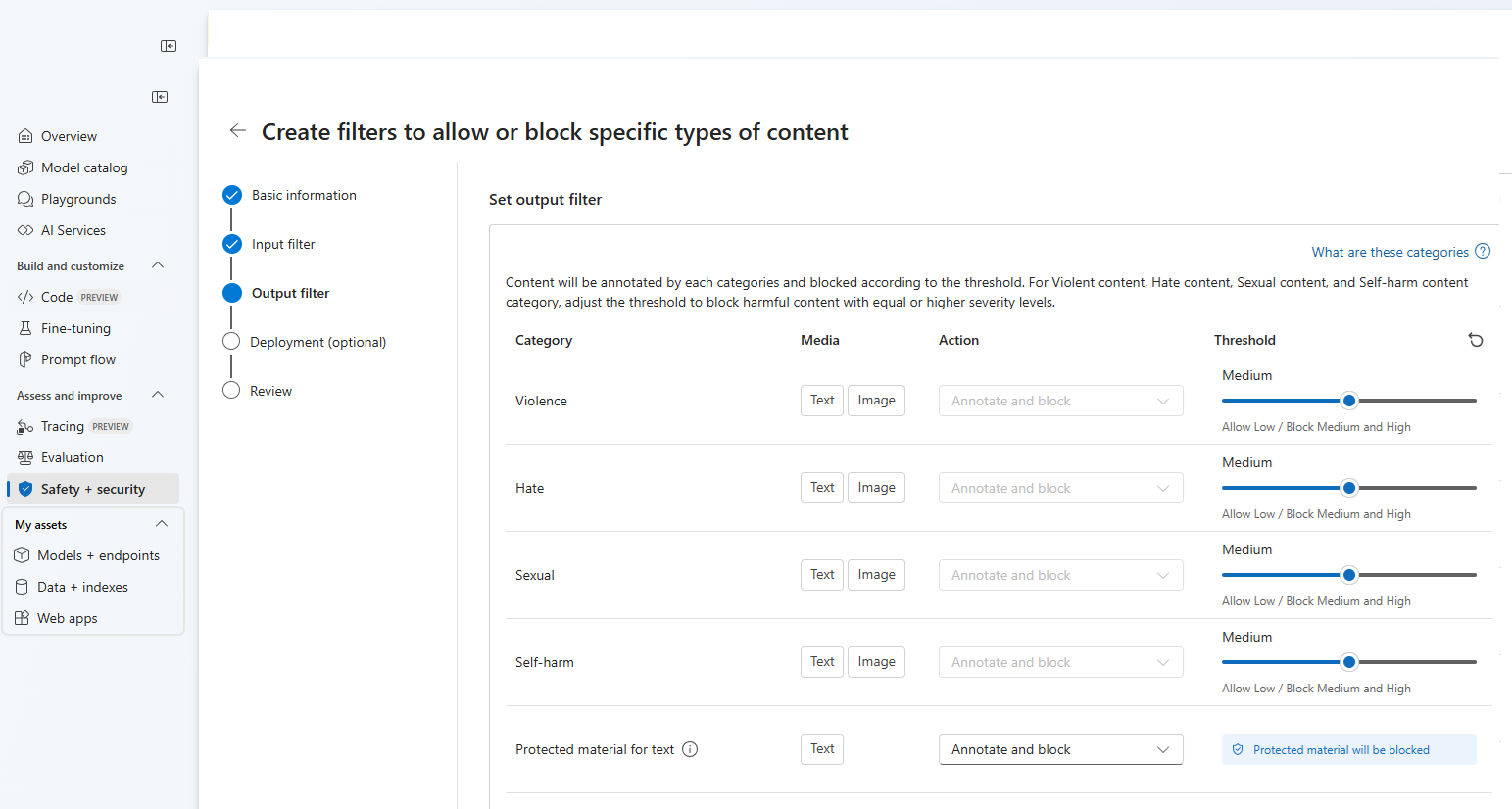

El contenido se anotará por categoría y se bloqueará según el umbral establecido. Para las categorías de violencia, odio, sexo y autolesión, ajuste el control deslizante para bloquear el contenido de gravedad alta, media o baja.

En la página Filtros de salida, puede configurar el filtro de salida, que se aplicará a todo el contenido de salida generado por el modelo. Configure los filtros individuales como antes. Esta página también proporciona la opción Modo de streaming, que permite filtrar el contenido casi en tiempo real a medida que el modelo genera, lo que reduce la latencia. Cuando haya terminado, seleccione Siguiente.

Cada categoría anotará el contenido y se bloqueará según el umbral. Para el contenido violento, el contenido de odio, el contenido sexual y la categoría de contenido de daño personal, ajuste el umbral para bloquear el contenido dañino con niveles de gravedad iguales o superiores.

Opcionalmente, en la página Implementación, puede asociar el filtro de contenido a una implementación. Si una implementación seleccionada ya tiene un filtro asociado, debe confirmar que desea reemplazarla. También puede asociar el filtro de contenido a una implementación más adelante. Seleccione Crear.

Las configuraciones de filtrado de contenido se crean en el nivel central en el Portal de la Fundición de IA de Azure. Obtenga más información sobre la capacidad de configuración en la Documentación de Azure OpenAI Service.

En la página Revisar, revise la configuración y a continuación, seleccione Crear filtro.

Usar una lista de bloqueados como filtro

Puede aplicar una lista de bloqueados como un filtro de entrada o salida, o ambos. Habilite la opción Lista de bloqueados en la página Filtro de entrada o Filtro de salida. Seleccione una o varias listas de bloqueados en la lista desplegable o use la lista de bloqueados soeces integrada. Puede combinar varias listas de bloqueados en el mismo filtro.

Aplicar un filtro de contenido

El proceso de creación de filtros le ofrece la opción de aplicar el filtro a las implementaciones que desee. También puede cambiar o quitar filtros de contenido de las implementaciones en cualquier momento.

Siga estos pasos para aplicar un filtro de contenido a una implementación:

Vaya a Fundición de IA de Azure y seleccione un proyecto.

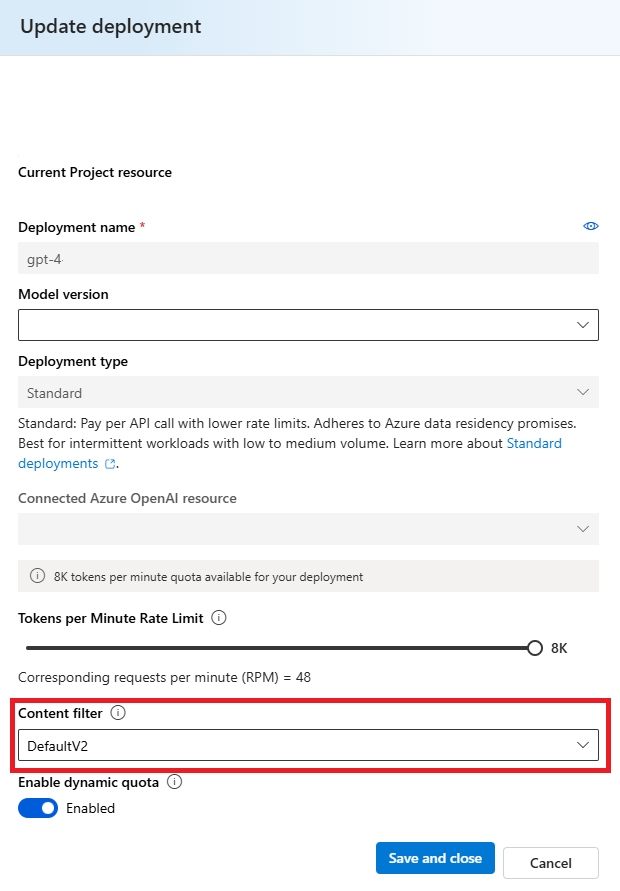

Seleccione Modelos y puntos de conexión en el panel izquierdo, elija una de las implementaciones y, a continuación, seleccione Editar.

En la ventana Actualizar implementación, seleccione el filtro de contenido que desea aplicar a la implementación. A continuación, seleccione Guardar y cerrar.

También puede editar y eliminar una configuración de filtro de contenido si es necesario. Antes de eliminar una configuración de filtrado de contenido, deberá anular la asignación y reemplazarla de cualquier implementación en la pestaña Implementaciones.

Ahora, puede ir al área de juegos para probar si el filtro de contenido funciona según lo previsto.

Comentarios de filtrado de contenido de informes

Si encuentra un problema de filtrado de contenido, seleccione el botón Filtrar comentarios situado en la parte superior del área de juegos. Esto está habilitado en la área de juegos Imágenes, Chat y Finalizaciones una vez que envíe un mensaje.

Cuando aparezca el cuadro de diálogo, seleccione el problema de filtrado de contenido adecuado. Incluya tantos detalles como sea posible en relación con el problema de filtrado de contenido, como el mensaje específico y el error de filtrado de contenido que encontró. No incluya ninguna información privada o confidencial.

Para obtener soporte técnico, envíe una incidencia de soporte técnico.

Seguimiento de los procedimientos recomendados

Se recomienda informar a las decisiones de configuración de filtrado de contenido a través de una identificación iterativa (por ejemplo, pruebas de equipo rojo, pruebas de esfuerzo y análisis) y el proceso de medición para solucionar los posibles daños que son pertinentes para un modelo, aplicación y escenario de implementación específicos. Después de implementar mitigaciones como el filtrado de contenido, repita la medición para probar la eficacia. Las recomendaciones y los procedimientos recomendados para la inteligencia artificial responsable de Azure OpenAI, que se basan en el estándar de inteligencia artificial responsable de Microsoft, se pueden encontrar en La introducción a la inteligencia artificial responsable de Azure OpenAI.

Contenido relacionado

- Obtenga más información sobre las prácticas de inteligencia artificial responsable de Azure OpenAI: Introducción a las prácticas de inteligencia artificial responsable para los modelos de Azure OpenAI.

- Obtenga más información acerca de las categorías de filtrado de contenido y niveles de gravedad con Azure AI Foundry.

- Obtenga más información sobre Read Teaming en nuestro: artículo Introducción a los modelos lingüísticos de gran tamaño (LLM).