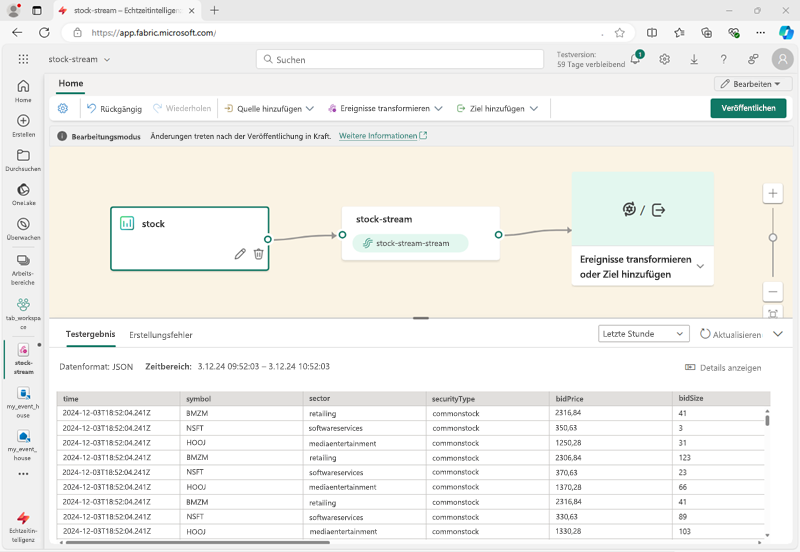

Erfassen und Transformieren von Echtzeitdaten

Eventstreams in Microsoft Fabric werden verwendet, um Echtzeitdaten aus zahlreichen Streamingdatenquellen zu erfassen, zu transformieren und zu laden. Wenn Sie einen Eventstream im System einrichten, definieren Sie ein Datenverarbeitungsmodul, das dauerhaft ausgeführt wird, um Echtzeitdaten zu erfassen und zu transformieren. Sie sagen ihr, woher sie die Daten bekommen soll, wohin sie sie senden soll und wie sie sie unterwegs ändern kann, falls nötig.

Datenquellen für Eventstreams

Eventstreams in Microsoft Fabric unterstützen zahlreiche Datenquellen, darunter:

- Externe Dienste, z. B. Azure Storage, Azure Event Hubs, Azure IoT Hubs, Apache Kafka-Hubs, CDC-Feeds (Change Data Capture) in relationalen Datenbankdiensten und andere.

- Fabric-Ereignisse, z. B. Änderungen an Elementen in einem Fabric-Arbeitsbereich, Datenänderungen in OneLake-Datenspeichern und Ereignisse im Zusammenhang mit Fabric-Aufträgen.

- Beispieldaten, darunter eine Reihe von Beispielen, die Ihnen helfen können, Echtzeitanalyseszenarien in Microsoft Fabric zu untersuchen.

Tipp

Weitere Informationen zu unterstützten Quellen finden Sie unter Unterstützte Quellen für den Fabric-Echtzeit-Hub.

Datentransformationen in Eventstreams

Sie können die Daten innerhalb des Eventstreams transformieren. Auf diese Weise können Sie sie vor dem Speichern filtern, zusammenfassen und umformen. Zu den verfügbaren Transformationen zählen:

- Filtern: Verwenden Sie die Filtertransformation, um Ereignisse basierend auf dem Wert eines Felds in der Eingabe zu filtern. Je nach Datentyp (Zahl oder Text) behält die Transformation die Werte bei, die der ausgewählten Bedingung entsprechen, z. B.

nulloderis not null. - Felder verwalten: Mithilfe dieser Transformation können Sie Felder aus einer Eingabe oder einer anderen Transformation hinzufügen, entfernen, ihren Datentyp ändern oder sie umbenennen.

- Aggregieren: Verwenden Sie die Aggregattransformation, um eine Aggregation (Summe, Minimum, Maximum oder Mittelwert) jedes Mal zu berechnen, wenn in einem bestimmten Zeitraum ein neues Ereignis auftritt. Dieser Vorgang ermöglicht auch die Umbenennung dieser berechneten Spalten sowie das Filtern oder Aufteilen der Aggregation basierend auf anderen Dimensionen in Ihren Daten. Sie können in derselben Transformation eine oder mehrere Aggregationen verwenden.

- Group by: Verwenden Sie die Transformation Group by, um Aggregationen über alle Ereignisse innerhalb eines bestimmten Zeitfensters zu berechnen. Sie können die Ansicht nach den Werten in einem oder mehreren Feldern gruppieren. Sie ähnelt der Aggregattransformation und lässt die Umbenennung der Spalten zu, bietet jedoch mehr Optionen für die Aggregation und enthält komplexere Optionen für Zeitfenster. Wie bei Aggregat können Sie pro Transformation mehrere Aggregationen hinzufügen.

- Vereinigen: Mithilfe von Vereinigungstransformationen können Sie zwei oder mehr Knoten verbinden und Ereignisse mit gemeinsamen Feldern (mit dem gleichen Namen und Datentyp) in eine Tabelle einfügen. Felder, die nicht übereinstimmen, werden verworfen und sind nicht in der Ausgabe enthalten.

- Erweitern: Verwenden Sie diese Arraytransformation, um eine neue Zeile für jeden Wert innerhalb eines Arrays zu erstellen.

- Verknüpfen: Dies ist eine Transformation zum Kombinieren von Daten aus zwei Datenströmen basierend auf einer gemeinsamen übereinstimmenden Bedingung.

Tipp

Weitere Informationen zu unterstützten Transformationen finden Sie unter Verarbeiten von Ereignisdaten mit dem Ereignisprozessor-Editor.

Datenziele in Eventstreams

Sie können die Daten aus Ihrem Datenstrom in die folgenden Ziele laden:

- Eventhouse: Mit diesem Ziel können Sie Ihre Echtzeitereignisdaten in einem Eventhouse erfassen, in dem Sie die Kusto Query Language (KQL) verwenden können, um die Daten abzufragen und zu analysieren.

- Lakehouse: Dieses Ziel bietet Ihnen die Möglichkeit, Ihre Echtzeitereignisse zu transformieren, bevor Sie sie in Ihr Lakehouse erfassen. Echtzeitereignisse werden in das Delta Lake-Format konvertiert und dann in den angegebenen Lakehouse-Tabellen gespeichert.

- Abgeleiteter Datenstrom: Ein abgeleiteter Datenstrom wird verwendet, um die Ausgabe Ihres Eventstreams an einen anderen Eventstream umzuleiten. Der abgeleitete Datenstrom stellt den transformierten Standarddatenstrom nach der Datenstromverarbeitung dar.

- Fabric-Activator: Mit diesem Ziel können Sie Ihre Echtzeitereignisdaten direkt mit einem Fabric-Activator verbinden. Dies ist ein intelligenter Agent, der Aktionen basierend auf Werten im Datenstrom automatisieren kann.

- Benutzerdefinierter Endpunkt: Mit diesem Ziel können Sie Ihre Echtzeitereignisse an einen benutzerdefinierten Endpunkt weiterleiten. Dieses Ziel ist nützlich, wenn Sie Echtzeitdaten an ein externes System oder eine benutzerdefinierte Anwendung außerhalb von Microsoft Fabric weiterleiten möchten.

Tipp

Weitere Informationen zu unterstützten Quellen finden Sie unter Hinzufügen und Verwalten eines Ziels in einem Eventstream.