Einrichten der Datenqualität für Fabric Lakehouse-Daten

Fabric OneLake ist ein einzelner, einheitlicher, logischer Data Lake für Ihre gesamte organization. Ein Data Lake verarbeitet große Datenmengen aus verschiedenen Quellen. Wie Microsoft OneDrive wird Auch OneLake automatisch mit jedem Microsoft Fabric-Mandanten bereitgestellt und ist so konzipiert, dass sie der zentrale Ort für alle Ihre Analysedaten ist. OneLake bringt Kunden:

- Ein Data Lake für die gesamte organization

- Eine Kopie der Daten für die Verwendung mit mehreren Analyse-Engines

OneLake zielt darauf ab, Ihnen den größtmöglichen Nutzen aus einer einzelnen Kopie von Daten ohne Datenverschiebung oder Duplizierung zu bieten. Sie müssen daten nicht mehr kopieren, nur um sie mit einer anderen Engine zu verwenden oder Silos aufzuschlüsseln, damit Sie die Daten mit Daten aus anderen Quellen analysieren können. Sie können Microsoft Purview verwenden, um den Fabric-Datenbestand zu katalogisieren und die Datenqualität zu messen, um Verbesserungsmaßnahmen zu steuern und zu fördern.

Sie können die Verknüpfung verwenden, um auf Daten zu verweisen, die an anderen Dateispeicherorten gespeichert sind. Diese Dateispeicherorte können sich innerhalb desselben Arbeitsbereichs oder in verschiedenen Arbeitsbereichen, in OneLake oder außerhalb von OneLake in Azure Data Lake Storage (ADLS), Amazon Web Services (AWS) S3 oder Dataverse befinden, wobei weitere Zielspeicherorte in Kürze verfügbar sind. Der Speicherort der Datenquelle spielt keine so große Rolle, OneLake-Verknüpfungen lassen Dateien und Ordner so aussehen, als hätten Sie sie lokal gespeichert. Wenn Teams unabhängig in separaten Arbeitsbereichen arbeiten, können Sie mit Verknüpfungen Daten in verschiedenen Geschäftsgruppen und Domänen in einem virtuellen Datenprodukt kombinieren, um die spezifischen Anforderungen eines Benutzers zu erfüllen.

Sie können die Spiegelung verwenden, um Daten aus verschiedenen Quellen in Fabric zusammenzuführen. Die Spiegelung in Fabric ist eine kostengünstige Lösung mit geringer Latenz, um Daten aus verschiedenen Systemen auf einer einzigen Analyseplattform zusammenzuführen. Sie können Ihren vorhandenen Datenbestand kontinuierlich direkt in OneLake von Fabric replizieren, einschließlich Daten aus Azure SQL Database, Azure Cosmos DB und Snowflake. Mit den aktuellsten Daten in einem abfragbaren Format in OneLake können Sie jetzt alle verschiedenen Dienste in Fabric verwenden. Beispiel: Ausführen von Analysen mit Spark, Ausführen von Notebooks, Datenentwicklung, Visualisieren über Power BI-Berichte und vieles mehr. Die Delta-Tabellen können dann überall in Fabric verwendet werden, sodass Benutzer ihre Journey zu Fabric beschleunigen können.

Registrieren von Fabric OneLake

Zum Konfigurieren der Data Map-Überprüfung müssen Sie zuerst die Datenquelle registrieren, die Sie überprüfen möchten. Zum Überprüfen eines Fabric-Arbeitsbereichs gibt es keine Änderungen an der vorhandenen Oberfläche, um einen Fabric-Mandanten als Datenquelle zu registrieren. Führen Sie die folgenden Schritte aus, um eine neue Datenquelle zu registrieren:

- Navigieren Sie im Microsoft Purview-Portal zu Data Map.

- Wählen Sie Registrieren aus.

- Wählen Sie unter Quellen registrieren die Option Fabric aus.

Weitere Informationen finden Sie in den Anweisungen zum Einrichten desselben Mandanten und der mandantenübergreifenden Einrichtung.

Einrichten der Data Map-Überprüfung

Zum Überprüfen von Lakehouse-Unterartikeln gibt es keine Änderungen an der vorhandenen Oberfläche in Data Map, um eine Überprüfung einzurichten. Es gibt einen weiteren Schritt, um den Scananmeldeinformationen mindestens die Rolle Mitwirkender in den Fabric-Arbeitsbereichen zu gewähren, um die Schemainformationen aus unterstützten Dateiformaten zu extrahieren.

Derzeit wird nur der Dienstprinzipal als Authentifizierungsmethode unterstützt. Die MSI-Unterstützung befindet sich noch im Backlog.

Weitere Informationen finden Sie in den Anweisungen zum Einrichten desselben Mandanten und der mandantenübergreifenden Einrichtung.

Einrichten der Verbindung für die Fabric Lakehouse-Überprüfung

Nachdem Sie Fabric Lakehouse als Quelle registriert haben, können Sie fabric aus der Liste Der registrierten Datenquellen in Data Map auswählen und Dann Neue Überprüfung auswählen. Fügen Sie eine Datenquellen-ID hinzu, und führen Sie dann die folgenden Schritte aus:

Erstellen einer Sicherheitsgruppe und eines Dienstprinzipals

Fügen Sie dieser Sicherheitsgruppe sowohl diesen Dienstprinzipal als auch die verwaltete Purview-Identität hinzu, und stellen Sie dann diese Sicherheitsgruppe bereit.

Zuordnen der Sicherheitsgruppe zum Fabric-Mandanten

- Melden Sie sich beim Fabric-Verwaltungsportal an.

- Wählen Sie die Seite Mandanteneinstellungen aus. Sie müssen ein Fabric-Admin sein, um die Seite mit den Mandanteneinstellungen anzuzeigen.

- Wählen Sie Admin API-Einstellungen > Dienstprinzipale die Verwendung schreibgeschützter Administrator-APIs erlauben aus.

- Wählen Sie Bestimmte Sicherheitsgruppen aus.

- Wählen Sie Admin API-Einstellungen > Administrator-APIs-Antworten mit detaillierten Metadaten verbessern und Antworten von Administrator-APIs mit DAX- und Mashupausdrücken > verbessern Aktivieren Sie die Umschaltfläche, damit Microsoft Purview Data Map die detaillierten Metadaten von Fabric-Datasets im Rahmen der Überprüfungen automatisch ermitteln können. Nachdem Sie die Admin API-Einstellungen auf Ihrem Fabric-Mandanten aktualisiert haben, warten Sie etwa 15 Minuten, bevor Sie eine Überprüfungs- und Testverbindung registrieren.

Stellen Sie Admin API-Einstellungen schreibgeschützte API-Berechtigung für diese Sicherheitsgruppe bereit.

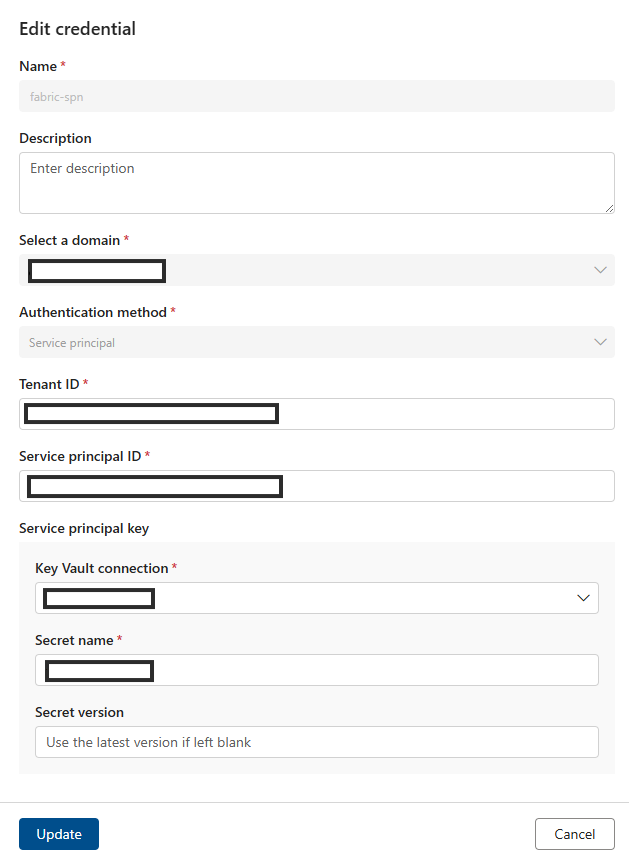

Fügen Sie den SPN zum Feld Anmeldeinformationen hinzu.

Fügen Sie den Namen der Azure-Ressource hinzu.

Fügen Sie die Mandanten-ID hinzu.

Fügen Sie die Dienstprinzipal-ID hinzu.

Fügen Sie Key Vault Verbindung hinzu.

Hinzufügen des Geheimnisnamens.

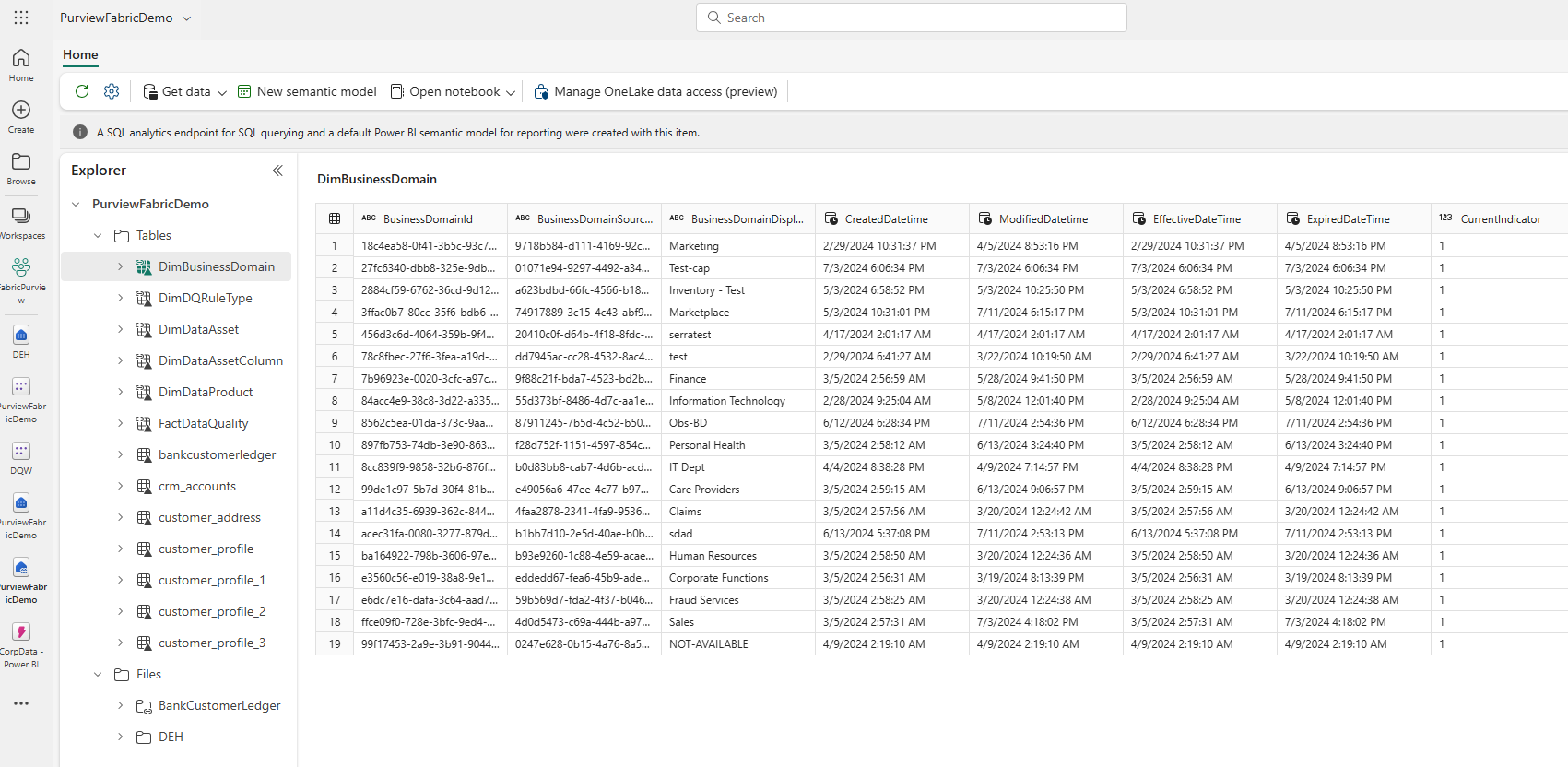

Nachdem Sie den Data Map-Scan abgeschlossen haben, suchen Sie eine Lakehouse-instance in Unified Catalog.

- Öffnen Sie im Microsoft Purview-Portal Unified Catalog.

- Wählen Sie Ermittlung und dann Datenressourcen aus.

- Wählen Sie auf der Seite Datenressourcendie Option Microsoft Fabric aus.

- Wählen Sie Fabric-Arbeitsbereiche und dann einen Arbeitsbereich aus der Liste aus.

- Suchen Sie auf der Seite des Arbeitsbereichs unter Elementname nach dem lakehouse-instance.

So durchsuchen Sie Lakehouse-Tabellen:

- Wählen Sie auf einer Arbeitsbereichsseite den Elementnamen Tabellen aus.

- Wählen Sie ein Lakehouse-Tabellenobjekt aus, das unter Elementname aufgeführt ist.

- Zeigen Sie die Detailseite des Medienobjekts an, um Metadaten wie Schema, Herkunft und Eigenschaften zu finden.

Voraussetzungen für die Fabric Lakehouse-Datenqualitätsüberprüfung

- Verknüpfung, Spiegel oder Laden Ihrer Daten in Fabric Lakehouse im Delta-Format.

Wichtig

Wenn Sie Fabric Lakehouse neue Tabellen, Dateien oder neue Daten per Spiegelung oder Verknüpfung hinzugefügt haben, müssen Sie eine Data Map-Bereichsüberprüfung ausführen, um diese neuen Datensätze zu katalogisieren, bevor Sie diese Datenressourcen einem Datenprodukt zur Bewertung der Datenqualität hinzufügen.

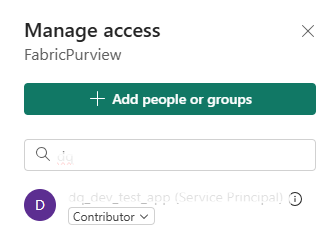

- Gewähren des Rechtes "Mitwirkender" für Ihren Arbeitsbereich für Purview MSI

- Fügen Sie die gescannte Datenressource aus Lakehouse den Datenprodukten der Governancedomäne hinzu. Suchen Sie auf der Seite eines Datenprodukts in Unified Catalog die Datenressourcen, und wählen Sie Datenassets hinzufügen aus. Datenprofilerstellung und Datenqualitätsüberprüfungen können nur für die Datenressourcen durchgeführt werden, die den Datenprodukten in der Governancedomäne zugeordnet sind.

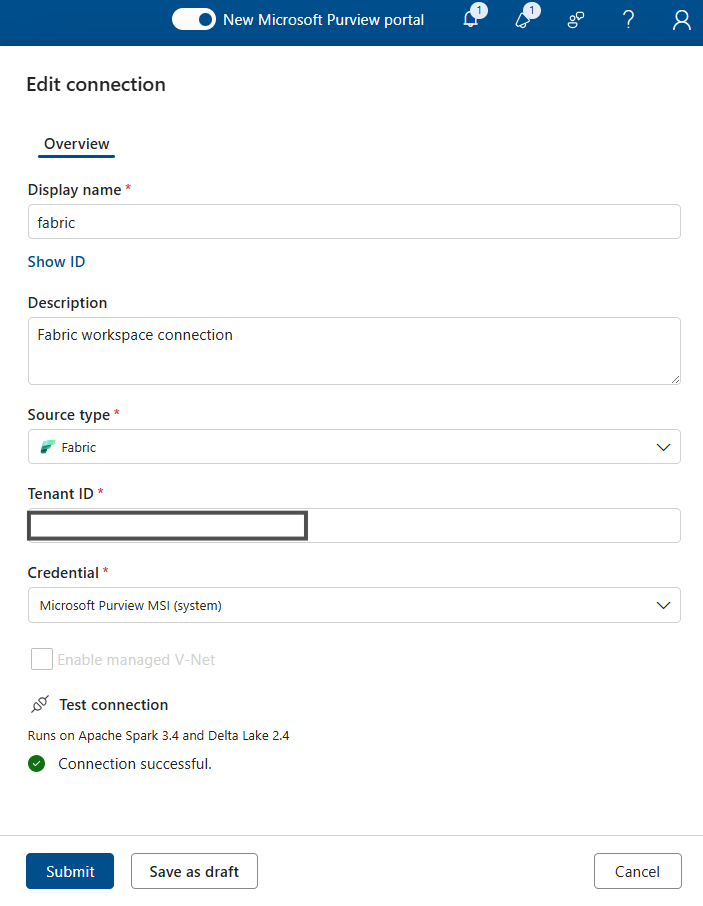

Für die Datenprofilerstellung und die Überprüfung der Datenqualität müssen Sie eine Datenquellenverbindung erstellen, da verschiedene Connectors verwendet werden, um die Datenquelle zu verbinden und Daten zu scannen, um Fakten und Dimensionen der Datenqualität zu erfassen. So richten Sie eine Verbindung ein:

Wählen Sie in Unified Catalog Die Option Integritätsverwaltung und dann Datenqualität aus.

Wählen Sie eine Governancedomäne und in der Dropdownliste Verwalten die Option Connections aus.

Wählen Sie Neu aus, um die Verbindungskonfigurationsseite zu öffnen.

Fügen Sie den Verbindungsanzeigenamen und eine Beschreibung hinzu.

Fügen Sie den Quelltyp Fabric hinzu.

Fügen Sie die Mandanten-ID hinzu.

Arbeitsbereichs-ID hinzufügen

Hinzufügen der Lakehouse-ID

Fügen SieDie Microsoft Purview-MSIfür Anmeldeinformationen - hinzu.

Testen Sie die Verbindung, um sicherzustellen, dass die konfigurierte Verbindung erfolgreich ist.

Wichtig

- Für eine Datenqualitätsüberprüfung muss Microsoft Purview MSI Mitwirkender Zugriff auf den Fabric-Arbeitsbereich haben, um einen Fabric-Arbeitsbereich zu verbinden. Um Mitwirkender Zugriff zu gewähren, öffnen Sie Ihren Fabric-Arbeitsbereich, wählen Sie drei Punkte (...) aus, wählen Sie Arbeitsbereichszugriff, dann Personen oder Gruppe hinzufügen aus, und fügen Sie dann Purview MSI als Mitwirkender hinzu.

- Fabric-Tabellen müssen im Delta- oder Iceberg-Format vorliegen.

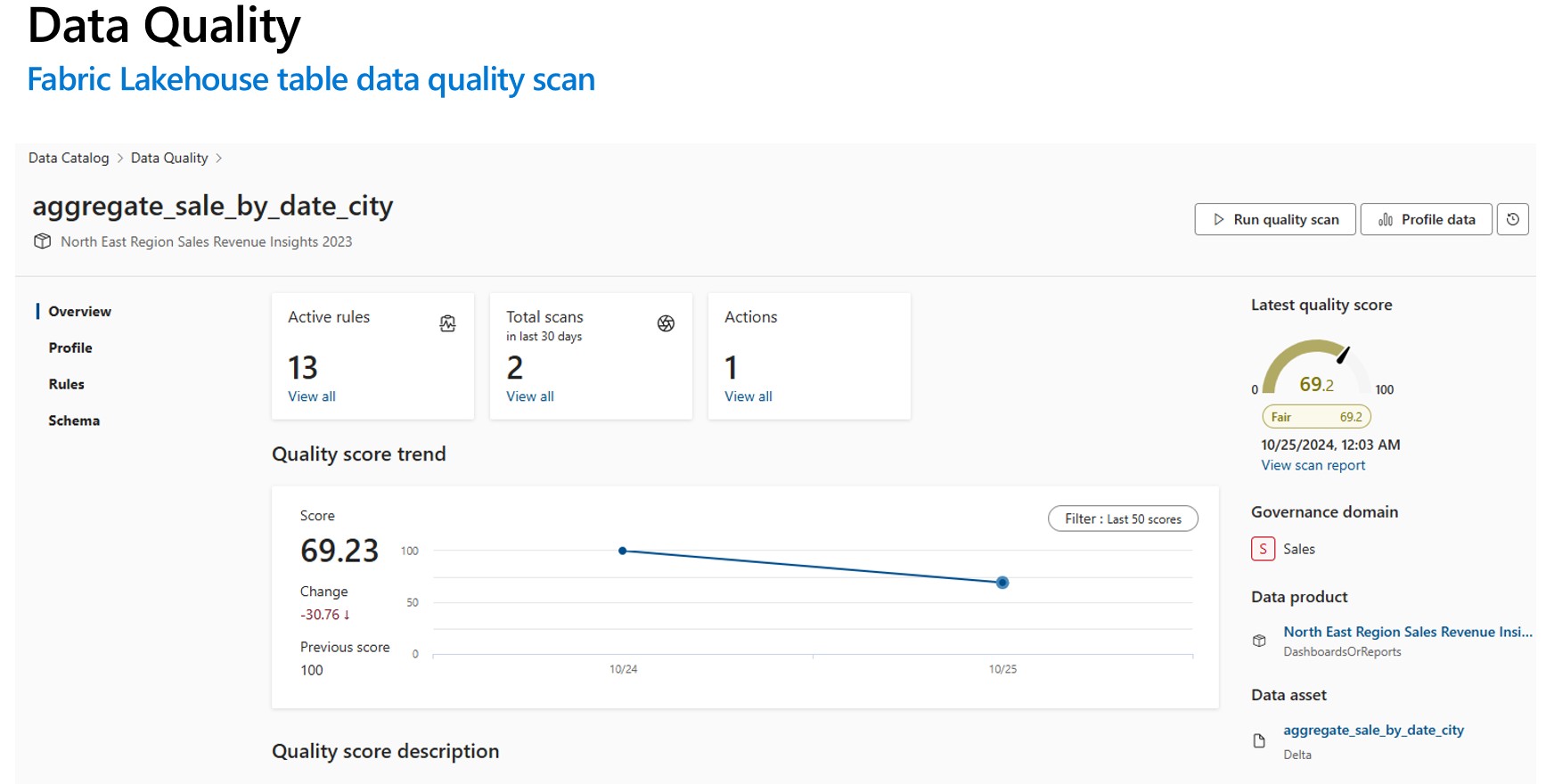

Profilerstellung und Datenqualitätsüberprüfung (DQ) für Daten in Fabric Lakehouse

Nachdem die Verbindungseinrichtung erfolgreich abgeschlossen wurde, können Sie ein Profil erstellen, Regeln erstellen und anwenden und eine Datenqualitätsüberprüfung (Data Quality, DQ) ihrer Daten in Fabric Lakehouse ausführen. Befolgen Sie die unten beschriebene Schritt-für-Schritt-Anleitung:

- Zuordnen einer Lakehouse-Tabelle zu einem Datenprodukt für Zusammenstellung, Ermittlung und Abonnement. Erfahren Sie, wie Sie Datenprodukte erstellen und verwalten.

- Profile Fabric Lakehouse-Tabelle. Erfahren Sie, wie Sie die Datenprofilerstellung für eine Datenressource konfigurieren und ausführen.

- Konfigurieren und Ausführen der Datenqualitätsüberprüfung, um die Datenqualität einer Fabric Lakehouse-Tabelle zu messen. Erfahren Sie, wie Sie eine Datenqualitätsüberprüfung konfigurieren und ausführen.

Wichtig

- Stellen Sie sicher, dass Ihre Daten im Delta- oder Iceberg-Format vorliegen.

- Stellen Sie sicher, dass die Data Map-Überprüfung erfolgreich ausgeführt wurde. Wenn dies nicht der Fall ist, führen Sie den Scan erneut aus.

Begrenzungen

Data Quality für Parquet-Dateien ist so konzipiert, dass Folgendes unterstützt wird:

- Ein Verzeichnis mit Parquet-Part-Datei. Beispiel: ./Sales/{Parquet Part Files}. Der vollqualifizierte Name muss folgen

https://(storage account).dfs.core.windows.net/(container)/path/path2/{SparkPartitions}. Stellen Sie sicher, dass keine {n}-Muster in der Verzeichnis-/Unterverzeichnisstruktur vorhanden sind. Es muss vielmehr ein direkter FQN sein, der zu {SparkPartitions} führt. - Ein Verzeichnis mit partitionierten Parquet-Dateien, partitioniert nach Spalten innerhalb des Datasets, z. B. Nach Jahr und Monat partitionierte Verkaufsdaten. Beispiel: ./Sales/{Year=2018}/{Month=Dec}/{Parquet Part Files}.

Beide wichtigen Szenarien, die ein konsistentes Parquet-Datasetschema aufweisen, werden unterstützt. Einschränkung: Es ist nicht für N beliebige Hierarchien von Verzeichnissen mit Parquet-Dateien konzipiert oder wird nicht unterstützt. Wir empfehlen dem Kunden, Daten in (1) oder (2) konstruierter Struktur darzustellen. Daher wird dem Kunden empfohlen, den unterstützten Parquet-Standard zu befolgen oder seine Daten in das ACID-kompatible Deltaformat zu migrieren.

Tipp

Für Data Map

- Stellen Sie sicher, dass der SPN über Arbeitsbereichsberechtigungen verfügt.

- Stellen Sie sicher, dass die Überprüfungsverbindung den SPN verwendet.

- Das Ausführen einer vollständigen Überprüfung wird empfohlen, wenn Sie zum ersten Mal eine Lakehouse-Überprüfung einrichten.

- Überprüfen, ob die erfassten Ressourcen aktualisiert/aktualisiert wurden

Unified Catalog

- Die DQ-Verbindung muss MSI-Anmeldeinformationen verwenden.

- Erstellen Sie idealerweise ein neues Datenprodukt zum erstmaligen Testen des DQ-Scans für Lakehouse-Daten.

- Fügen Sie die erfassten Datenressourcen hinzu, und überprüfen Sie, ob die Datenassets aktualisiert werden.

- Versuchen Sie das Ausführungsprofil. Führen Sie bei Erfolg die DQ-Regel aus. Wenn dies nicht erfolgreich ist, versuchen Sie, das Ressourcenschema zu aktualisieren (Schemaschemaverwaltungs-Importschema> ).

- Einige Benutzer mussten auch ein neues Lakehouse und Beispieldaten erstellen, um zu überprüfen, ob alles von Grund auf funktioniert. In einigen Fällen ist das Arbeiten mit Ressourcen, die zuvor in der Data Map erfasst wurden, nicht konsistent.

Ressourcen

- Konfigurieren und Ausführen der Datenprofilerstellung für Ihre Daten

- Konfigurieren und Ausführen der Datenqualitätsüberprüfung

- Häufig gestellte Fragen und Selbsthilfe

- Einrichten einer Data Quality-Verbindung

- Informationen zur Spiegelung in Fabric

- OneLake-Tastenkombinationen

- Data Quality für gespiegelte Fabric-Datenquellen

- Data Quality for OneLake– Verknüpfungen für Datenquellen