Übersicht über den Microsoft 365 Copilot Orchestrator

Microsoft 365 Copilot ist Ihr persönlicher Assistent für die Arbeit. Es hilft bei verschiedenen allgemeinen Aufgaben wie Schreiben, Zusammenfassen, Recherchieren und mehr. Copilot verfügt über unterschiedliche Fähigkeiten, die diesen verschiedenen Aufgabentypen entsprechen. Copilot kann beispielsweise Aktionselemente aus einer Besprechung zusammenfassen, Änderungen an einer Datei vorschlagen oder Ressourcen und Experten zu einem bestimmten Thema in Ihrem organization aufspüren. Jeder Skill verfügt über eigene Parameter und Ausgaben, die auf die jeweilige Aufgabe zugeschnitten sind.

Wie jeder Copilot wird Microsoft 365 Copilot zu einem bestimmten Zeitpunkt mit Daten trainiert. Um neue Informationen und Echtzeitinformationen abzurufen und zu verarbeiten, insbesondere Daten, die für Ihre organization und Workflows spezifisch sind, benötigen Agents Plug-Ins. Plug-Ins innerhalb eines Agents erweitern Microsoft 365 Copilot Fähigkeiten und Nutzen für Endbenutzer, sodass er den richtigen Skill aus seinem gesamten Repertoire auswählen kann.

Aber woher weiß Ihr Agent, welche Qualifikation er verwenden soll, wenn Sie um Hilfe bitten? Wie interpretiert sie Ihre Anforderung und stimmt sie mit dem besten verfügbaren Skill überein? Dies ist die Aufgabe des Microsoft 365 Copilot Orchestrators.

In diesem Artikel wird die Logik hinter dem Skillauswahlprozess von Copilot erläutert und wie Sie sicherstellen können, dass Copilot bei jeder Gelegenheit das richtige Plug-In von Ihrem Agent verwendet, um Ihren Benutzern zu profitieren.

Wichtig

- API-Plug-Ins werden derzeit nur als Aktionen in deklarativen Agents unterstützt. Sie sind in Microsoft 365 Copilot nicht aktiviert. Ein Beispiel zum Hinzufügen eines API-Plug-Ins zu einem deklarativen Agent finden Sie unter Hinzufügen eines Plug-Ins.

- Die Funktion ist standardmäßig in allen Microsoft 365 Copilot lizenzierten Mandanten aktiviert. Administratoren können diese Funktionalität auf Benutzer- und Gruppenbasis deaktivieren und steuern, wie einzelne Plug-Ins für die Verwendung genehmigt werden und welche Plug-Ins aktiviert sind. Weitere Informationen finden Sie unter Verwalten von Agents in integrierten Apps.

Copilot-Orchestrator

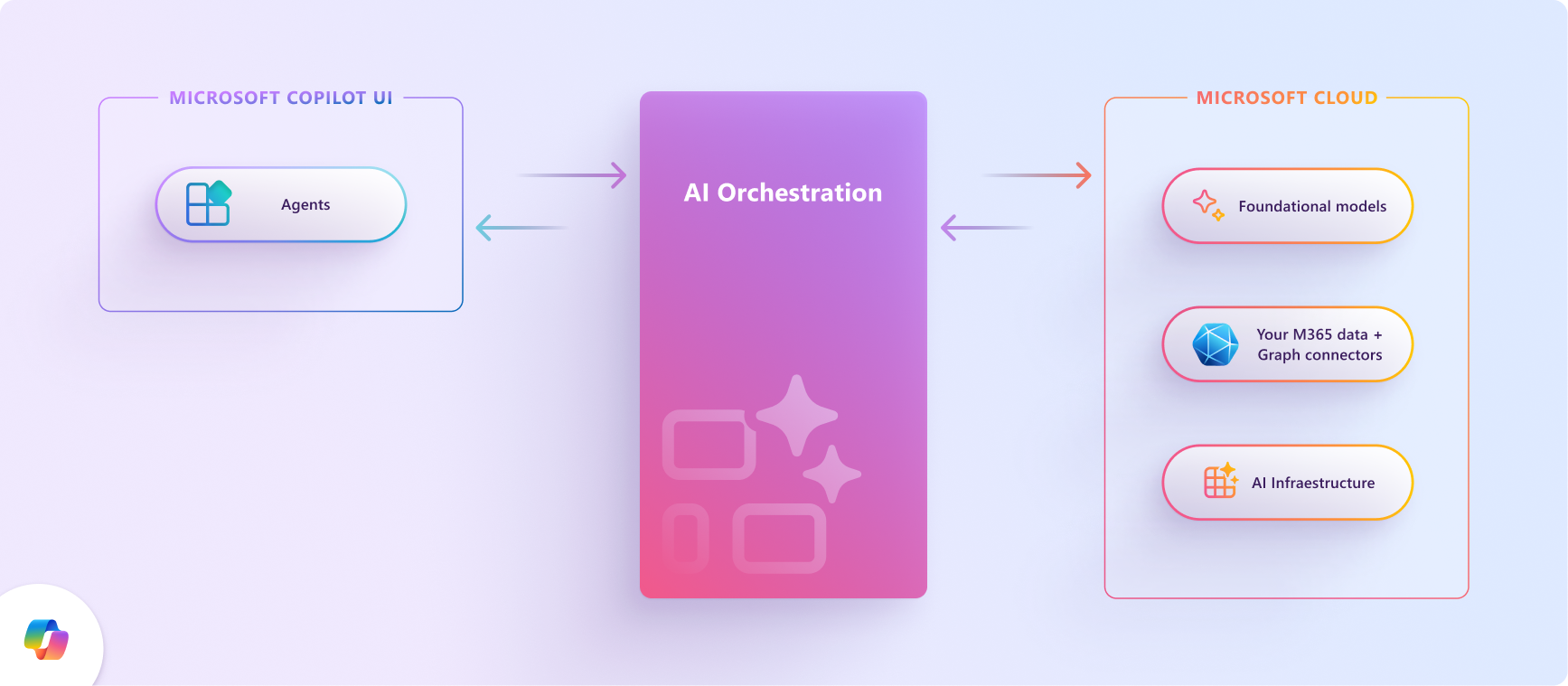

Zwischen der Eingabe in natürlicher Sprache des Benutzers und der Ausgabe von Copilot in natürlicher Sprache arbeitet der Copilot-Orchestrator im Hintergrund daran, die richtigen Skills aus den richtigen Plug-Ins für die Aufgabe des Benutzers auszuwählen und auszuführen.

Die Orchestrierungsebene stellt die Schnittstelle zwischen foundation Large Language Models (LLMs) und den vielen Möglichkeiten dar, wie Sie Copilot erweitern, anreichern und anpassen können, wie Ihre Kunden arbeiten.

Das folgende Diagramm veranschaulicht, wie der Microsoft 365 Copilot Orchestrator das richtige Plug-In mit der richtigen Qualifikation zur richtigen Zeit auswählt, auch wenn mehrere Optionen zur Auswahl stehen.

Eingabe in natürlicher Sprache: Der Benutzer sendet eine Abfrage an Ihren Agent, z. B. "Welche Tickets werden mir gerade zugewiesen?"

Vorläufige Überprüfungen: Copilot führt mehrere Überprüfungen der Abfrage durch, einschließlich verantwortungsvoller KI-Überprüfungen und Sicherheitsmaßnahmen, um sicherzustellen, dass sie keine Risiken darstellt. Wenn bei der Abfrage eine dieser Überprüfungen fehlschlägt, beendet Copilot die Interaktion.

Begründung: Der Copilot-Orchestrator formuliert einen Plan, der aus mehreren Aktionen besteht, die er ausführt, um auf die Aufforderung des Benutzers zu reagieren.

Kontext- und Toolauswahl: Der Orchestrator ruft den Konversationskontext des Benutzers aus dem Kontextspeicher ab und integriert Daten aus Microsoft Graph, um den Kontext zu verfeinern. Anschließend wird die anfängliche Abfrage basierend auf diesem aktualisierten Kontext angepasst und an das LLM (large language model) weitergeleitet, um die nächsten Schritte zu leiten.

Der LLM könnte mit dem Generieren einer Antwort fortfahren, indem er die integrierten Funktionen von Copilot verwendet, oder es kann feststellen, dass zusätzliche Daten erforderlich sind.

Wenn weitere Informationen benötigt werden, sucht der Orchestrator basierend auf den Beschreibungen der Plug-Ins und ihrer Funktionen nach den Plug-Ins (Tools) mit der richtigen Qualifikation für die Aufgabe aus den aktivierten Plug-Ins des Agents.

Funktionsabgleich und Parameterermittlung: Der Orchestrator formuliert eine neue Eingabeaufforderung, die die anfängliche Abfrage des Benutzers, den aktualisierten Kontext und die ausgewählten Plug-Ins enthält, und stellt sie dem LLM vor. Der LLM wertet die Eingabe aus und gibt das optimale Plug-In und die funktion innerhalb dieses Plug-Ins an, um die Aufgabe zu beheben. Anschließend werden dem Orchestrator die erforderlichen Funktionsdetails und Parameter bereitgestellt, die zum Sammeln der erforderlichen Informationen erforderlich sind.

Toolinitiierung: Der Orchestrator verwendet die Antwort des LLM, um eine API-Anforderung zu erstellen und die Anforderung an den Toolinitiator zu senden, der die angeforderten Informationen sicher abruft, die sich außerhalb der Copilot-Infrastruktur befinden. Er führt die Anforderung aus und sendet die Ergebnisse zur weiteren Verarbeitung zurück an den Orchestrator.

Ergebnisanalyse und Antwortformulierung: Der Orchestrator integriert die API-Antwort in den laufenden Kontext und konsultiert den LLM in einer kontinuierlichen Schlussfolgerungsschleife, bis der LLM es für angemessen hält, eine endgültige Antwort zu generieren.

Antwort: Der Orchestrator kompiliert alle Informationen, die während des Argumentationsprozesses gesammelt wurden, und übermittelt sie an den LLM, um eine endgültige Antwort zu erstellen. Nachdem sichergestellt wurde, dass die Antwort den Richtlinien für verantwortungsvolle KI entspricht, sendet sie die Antwort zurück an den Orchestrator, der sie im Kontextspeicher protokolliert und über die Copilot-Benutzeroberfläche an den Benutzer übermittelt.

Ausgabe in natürlicher Sprache: Schließlich übermittelt der Orchestrator die Antwort an den Benutzer und aktualisiert den Konversationszustand. Copilot ist bereit für die nächste Aufforderung.

Wie Copilot-Orchestrator Plug-Ins mit Benutzerabfragen abgleicht

Wenn ein Benutzer eine Abfrage an Ihren Agent sendet, durchsucht der Orchestrator den vollständigen Katalog der Fähigkeiten (Funktionen) des Agents aus installierten Plug-Ins, um bis zu fünf Skills zu identifizieren, die am besten mit der Abfrage übereinstimmen. Der Orchestrator versucht zunächst, genaue Wörter abzugleichen (lexikalische Übereinstimmung) und erweitert seinen Suchbereich nach Bedarf, um Übereinstimmungen mit beschreibenden Bedeutungen (semantische Übereinstimmung) einzuschließen. Dabei wird von bestimmten Funktionsnamen bis hin zu allgemeinen Plug-In-Beschreibungen gearbeitet, bis alle fünf Funktionskandidaten-Slots gefüllt sind. Die folgende Liste zeigt insbesondere die Hierarchie der Abgleichsmechanismen für die Funktionsauswahl des Copilot-Plug-Ins:

- Lexikalische Übereinstimmung für Funktionsname.

- Semantische Übereinstimmung für funktionsbeschreibung.

- Lexikalische Übereinstimmung mit Plug-In-Namen (fügt alle Plug-In-Funktionen zur Kandidatenliste hinzu).

- Semantische Übereinstimmung für Den Plug-In-Namen (fügt alle Plug-In-Funktionen zur Kandidatenliste hinzu).

Der Orchestrator durchläuft diese Liste, bis alle fünf Funktionskandidatenplätze gefüllt sind.

Lesen Sie Validierungsrichtlinien für Agents , um mehr über das Schreiben guter Beschreibungen zu erfahren, um sicherzustellen, dass Copilot für jede Benutzerabfrage an Ihren Agent die richtige Qualifikation auswäht.