Problembehandlung bei Datenlösungen für das Gesundheitswesen in Microsoft Fabric

Dieser Artikel informiert Sie über einige Probleme oder Fehler, die bei der Verwendung der Datenlösungen für das Gesundheitswesen in Microsoft Fabric auftreten können, und wie Sie diese beheben können. Der Artikel enthält auch einige Anleitungen zur Anwendungsüberwachung.

Wenn das Problem weiterhin besteht, nachdem Sie die Anweisungen in diesem Artikel befolgt haben, erstellen Sie ein Incident-Ticket für das Supportteam.

Bereitstellungsprobleme beheben

Manchmal können bei der Bereitstellung von Datenlösungen für das Gesundheitswesen im Fabric-Arbeitsbereich zeitweise Probleme auftreten. HIer finden Sie einige häufig beobachtete Probleme und Umgehungen zu ihrer Behebung:

Die Lösungserstellung schlägt fehl oder dauert zu lange.

Fehler: Die Erstellung der Lösung für das Gesundheitswesen dauert länger als 5 Minuten und/oder schlägt fehl.

Ursache: Dieser Fehler tritt auf, wenn es eine andere Lösung für das Gesundheitswesen mit demselben Namen gibt oder kürzlich gelöscht wurde.

Lösung: Wenn Sie kürzlich eine Lösung gelöscht haben, warten Sie 30 bis 60 Minuten, bevor Sie eine weitere Bereitstellung versuchen.

Fehler bei Funktionsbereitstellung

Fehler: Funktionen in Datenlösungen für das Gesundheitswesen können nicht bereitgestellt werden.

Lösung: Überprüfen Sie, ob die Funktion im Abschnitt Bereitgestellte Funktionen verwalten aufgeführt ist.

- Wenn die Funktion nicht in der Tabelle aufgeführt ist, versuchen Sie erneut, sie bereitzustellen. Wählen Sie zuerst die Funktionskachel und dann die Schaltfläche Im Arbeitsbereich bereitstellen aus.

- Wenn die Funktion in der Tabelle mit dem Statuswert Bereitstellung fehlgeschlagen aufgeführt ist, stellen Sie die Funktion erneut bereit. Alternativ können Sie eine neue Umgebung für Datenlösungen für das Gesundheitswesen erstellen und die Funktionalität dort erneut bereitstellen.

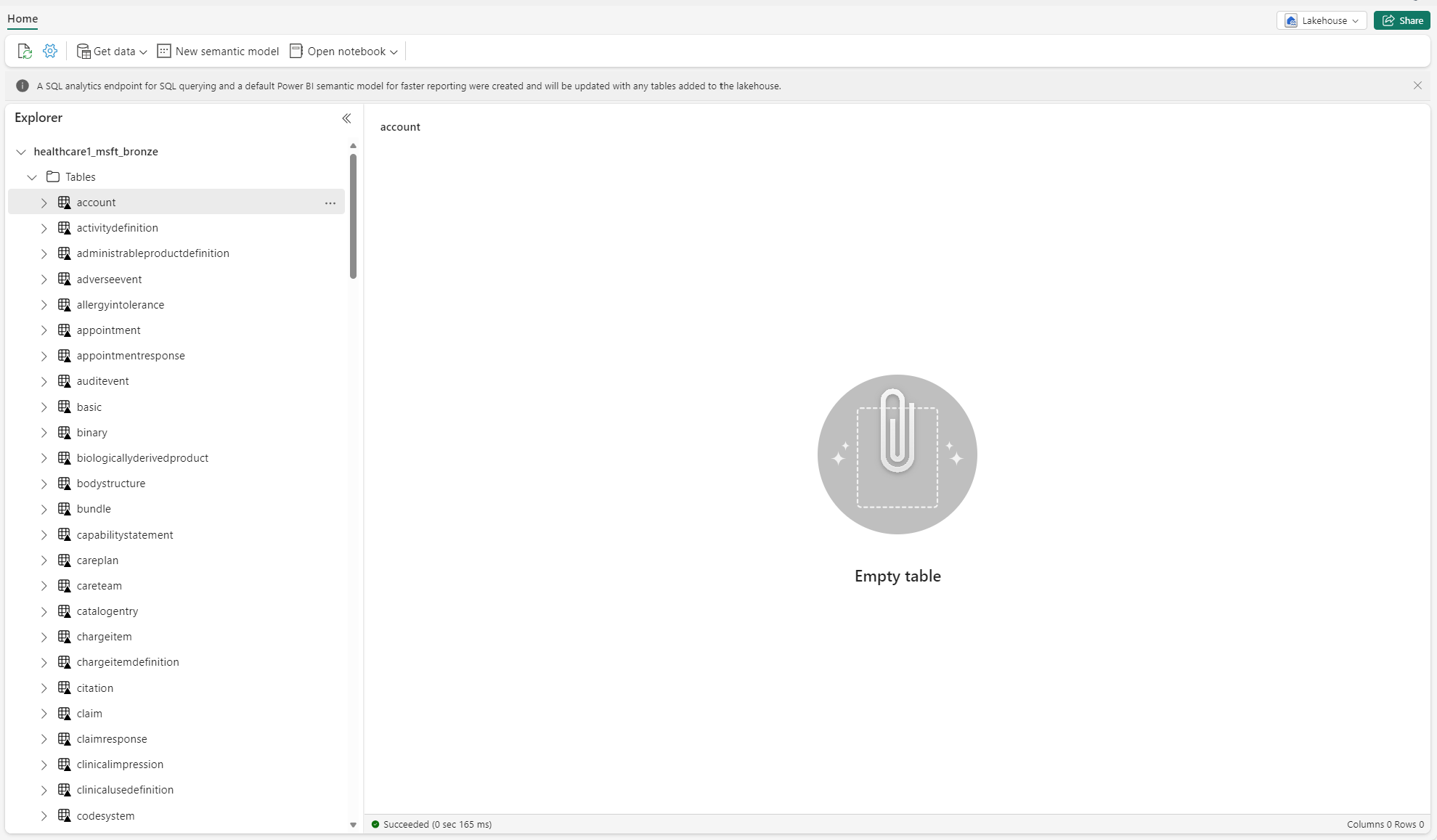

Problembehandlung bei nicht identifizierten Tabellen

Wenn Delta-Tabellen zum ersten Mal im Lakehouse erstellt werden, werden sie in der Lakehouse Explorer-Ansicht möglicherweise vorübergehend als „nicht identifiziert“ oder leer angezeigt. Sie sollten jedoch nach einigen Minuten korrekt unter dem Tabellenordner angezeigt werden.

Datenpipeline neu ausführen

Führen Sie die folgenden Schritte aus, um die Beispieldaten End-to-End auszuführen:

Führen Sie eine Spark SQL-Anweisung aus einem Notebook aus, um alle Tabellen aus einem Lakehouse zu löschen. Im Folgenden finden Sie ein Beispiel:

lakehouse_name = "<lakehouse_name>" tables = spark.sql(f"SHOW TABLES IN {lakehouse_name}") for row in tables.collect(): spark.sql(f"DROP TABLE {lakehouse_name}.{row[1]}")Verwenden Sie den dOneLake-Datei-Explorer, um in Ihrem Windows-Datei-Explorer eine Verbindung zu OneLake herzustellen.

Navigieren Sie im Windows-Datei-Explorer zu Ihrem Arbeitsbereichsordner. Löschen Sie unter

<solution_name>.HealthDataManager\DMHCheckpointalle entsprechenden Ordner in<lakehouse_id>/<table_name>. Alternativ können Sie auch Microsoft Spark Utilities (MSSparkUtils) für Fabric verwenden, um den Ordner zu löschen.Führen Sie die Datenpipelines erneut aus, beginnend mit der Aufnahme klinischer Daten im Bronze-Lakehouse.

Apache Spark-Anwendungen mit Azure Log Analytics überwachen

Die Apache Spark Anwendungsprotokolle werden an eine Azure Log Analytics-Arbeitsbereichsinstanz gesendet, die Sie abfragen können. Verwenden Sie diese Kusto-Beispielabfrage, um die Protokolle zu filtern, die für Datenlösungen für das Gesundheitswesen spezifisch sind:

AppTraces

| where Properties['LoggerName'] contains "Healthcaredatasolutions"

or Properties['LoggerName'] contains "DMF"

or Properties['LoggerName'] contains "RMT"

| limit 1000

In den Konsolenprotokollen des Notebooks wird auch RunId für jede Ausführung protokolliert. Sie können diesen Wert verwenden, um Protokolle für eine bestimmte Ausführung abzurufen, wie in der folgenden Beispielabfrage gezeigt:

AppTraces

| where Properties['RunId'] == "<RunId>"

Allgemeine Überwachungsinformationen finden Sie unter Verwenden des Fabric-Überwachungshubs.

OneLake-Datei-Explorer verwenden

Die OneLake-Datei-Explorer-Anwendung integriert OneLake nahtlos in den Windows-Datei-Explorer. Sie können den OneLake-Datei-Explorer verwenden, um jeden Ordner oder jede Datei anzuzeigen, die in Ihrem Fabric-Arbeitsbereich bereitgestellt wird. Sie können auch die Beispieldaten, OneLake-Dateien und -Ordner sowie die Prüfpunktdateien anzeigen.

Azure Storage Explorer verwenden

Sie können den Azure Storage-Explorer auch für Folgendes verwenden:

- Greifen Sie auf die OneLake-Dateien in Ihren Fabric Lakehouses zu

- Verbinden Sie sich mit Ihrem OneLake-URL-Dateipfad

Zurücksetzen der Spark-Laufzeitversion im Fabric-Arbeitsbereich

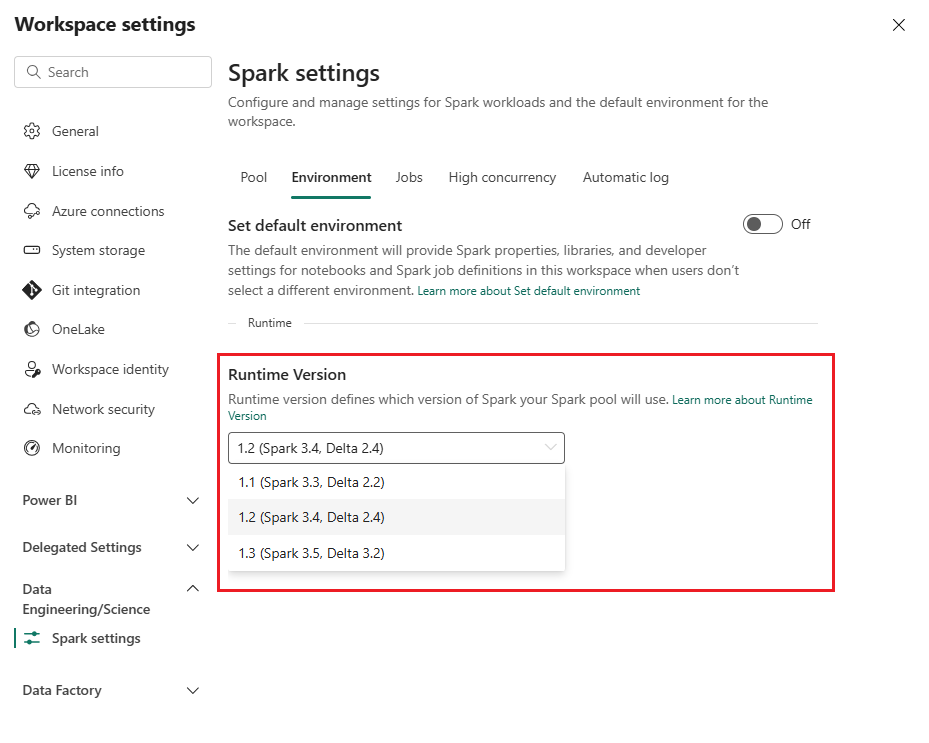

Standardmäßig verwenden alle neuen Fabric-Arbeitsbereiche die neueste Fabric-Laufzeitversion, die derzeit Runtime 1.3 ist. Datenlösungen für das Gesundheitswesen unterstützen jedoch nur Runtime 1.2.

Nachdem Sie also Datenlösungen für das Gesundheitswesen in Ihrem Arbeitsbereich bereitgestellt haben, stellen Sie sicher, dass die standardmäßige Fabric-Laufzeitversion auf Runtime 1.2 (Apache Spark 3.4 und Delta Lake 2.4) festgelegt ist. Wenn dies nicht der Fall ist, können Ihre Datenpipeline und Notebook-Ausführungen fehlschlagen. Weitere Informationen finden Sie unter Unterstützung mehrerer Laufzeiten in Fabric.

Führen Sie die folgenden Schritte aus, um die Fabric-Laufzeitversion zu überprüfen/zu aktualisieren:

Gehen Sie zu Ihrem Arbeitsbereich für Datenlösungen für das Gesundheitswesen, und wählen Sie Arbeitsbereichseinstellungen.

Erweitern Sie auf der Seite mit den Arbeitsbereichseinstellungen das Dropdownfeld Data Engineering/Science, und wählen Sie Spark-Einstellungen.

Aktualisieren Sie auf der Registerkarte Umgebung den Wert für die Laufzeitversion auf 1.2 (Spark 3.4, Delta 2.4), und speichern Sie die Änderungen.

Aktualisieren Sie die Fabric-Benutzeroberfläche und den OneLake-Datei-Explorer

Manchmal stellen Sie möglicherweise fest, dass die Fabric-Benutzeroberfläche oder der OneLake-Datei-Explorer den Inhalt nicht immer nach jeder Notebook-Ausführung aktualisiert. Wenn Sie nach dem Ausführen eines Ausführungsschritts (z. B. Erstellen eines neuen Ordners oder Lakehouse oder Erfassen neuer Daten in einer Tabelle) nicht das erwartete Ergebnis in der Benutzeroberfläche sehen, versuchen Sie, das Artefakt (Tabelle, Lakehouse, Ordner) zu aktualisieren. Durch diese Aktualisierung können häufig Unstimmigkeiten behoben werden, bevor Sie andere Optionen prüfen oder weitere Nachforschungen anstellen.