Spiegeln von Snowflake in Microsoft Fabric

Die Spiegelung in Fabric bietet eine einfache Benutzererfahrung, um komplexe ETL (Extract Transform Load) zu vermeiden und Ihre vorhandene Snowflake-Lagerdaten mit den restlichen Daten in Microsoft Fabric zu integrieren. Sie können Ihre bestehenden Snowflake-Daten kontinuierlich direkt in OneLake von Fabric replizieren. Innerhalb von Fabric können Sie leistungsstarke Business Intelligence, künstliche Intelligenz, Datentechnik, Data Science- und Datenfreigabeszenarien nutzen.

Ein Tutorial zum Konfigurieren Ihrer Snowflake-Datenbank für die Spiegelung in Fabric finden Sie im Tutorial: Konfigurieren von in Microsoft Fabric gespiegelten Datenbanken aus Azure SQL-Datenbank.

Gründe für die Verwendung von Spiegelung in Fabric.

Mit der Spiegelung in Fabric vermeiden Sie, verschiedene Dienste von mehreren Anbietern kombinieren zu müssen. Stattdessen profitieren Sie von einem hochgradig integrierten, benutzerfreundlichen End-to-End-Produkt, das Ihre Analyseanforderungen vereinfacht und auf Offenheit und Zusammenarbeit zwischen Microsoft, Snowflake und zahllosen Technologielösungen ausgelegt ist, die das Open-Source-Tabellenformat von Delta Lake lesen können.

Welche Analyseerfahrungen sind integriert?

Gespiegelte Datenbanken sind ein Element in Fabric-Datenspeicherung, die sich von Warehouse- und SQL-Analyseendpunkten unterscheiden.

Die Spiegelung erstellt drei Elemente in Ihrem Fabric-Arbeitsbereich:

- Das gespiegelte Datenbankelement. Die Spiegelung verwaltet die Replikation von Daten in OneLake und die Konvertierung in Parquet in einem analysefähigen Format. Dies ermöglicht nachgeschaltete Szenarien wie Data Engineering, Data Science und mehr.

- Ein SQL-Analyseendpunkt

- Ein Standardsemantikmodell

Jede gespiegelte Datenbank verfügt über einen automatisch generierten SQL-Analyseendpunkt, der über die Delta-Tabellen verfügt, die vom Spiegelungs-Prozess erstellt wurden. Benutzer haben Zugriff auf vertraute T-SQL-Befehle, die Datenobjekte definieren und abfragen können, aber die Daten nicht vom SQL-Analyseendpunkt bearbeiten können, da es sich um eine schreibgeschützte Kopie handelt. Sie können die folgenden Aktionen im SQL-Analyseendpunkt ausführen:

- Erkunden Sie die Tabellen, die auf Daten in Ihren Delta Lake-Tabellen aus Snowflake verweisen.

- Erstellen Sie keine Codeabfragen und -ansichten, und untersuchen Sie Daten visuell, ohne eine Codezeile zu schreiben.

- Entwicklung von Ansichten, Inline-TVFs (Tabellenwertfunktionen) und gespeicherten Prozeduren zum Kapseln Ihrer Semantik und Geschäftslogik in T-SQL.

- Verwalten von Berechtigungen für die Objekte

- Abfragen von Daten in anderen Warehouses und Lakehouses im selben Arbeitsbereich.

Zusätzlich zum SQL Query Editor gibt es ein breites Ökosystem von Tools, die den SQL-Analyseendpunkt abfragen können, einschließlich SQL Server Management Studio (SSMS), der mssql-Erweiterung mit Visual Studio Code und sogar GitHub Copilot.

Sicherheitshinweise

Um die Fabric-Spiegelung zu aktivieren, benötigen Sie Benutzerberechtigungen für Ihre Snowflake-Datenbank, die die folgenden Berechtigungen enthalten:

CREATE STREAMSELECT tableSHOW tablesDESCRIBE tables

Weitere Informationen finden Sie in der Snowflake-Dokumentation zu Zugriffssteuerungsberechtigungen für Streamingtabellen und erforderlichen Berechtigungen für Streams.

Wichtig

Detaillierte Sicherheitseinstellungen in dem Snowflake-Quelllager müssen in der gespiegelten Datenbank in Microsoft Fabric neu konfiguriert werden. Weitere Informationen finden Sie unter detaillierte SQL-Berechtigungen in Microsoft Fabric.

Kostenüberlegungen für die Snowflake-Spiegelung

Fabric berechnet keine Gebühren für eingehende Netzwerkdaten, die für die Spiegelung in OneLake anfallen. Es entstehen keine Kosten für die Spiegelung, wenn Ihre Snowflake-Daten in OneLake repliziert werden.

Es fallen Snowflake Compute- und Cloud-Abfragekosten an, wenn Daten gespiegelt werden: virtuelle Lager-Compute- und Clouddienst-Computekosten.

- Compute-Gebühren für virtuelles Snowflake-Lager:

- Compute-Gebühren fallen auf der Snowflake-Seite an, wenn es Datenänderungen gibt, die in Snowflake gelesen und in Fabric gespiegelt werden.

- Alle Metadatenabfragen, die im Hintergrund ausgeführt werden, um nach Datenänderungen zu suchen, werden nicht für Snowflake-Compute berechnet. Abfragen, die Daten produzieren, wie z.B. ein

SELECT *, die das Snowflake-Lager aufwecken, und Compute werden jedoch berechnet.

- Compute-Gebühren für Snowflake-Dienste:

- Obwohl keine Compute-Gebühren für die Aufgaben hinter den Kulissen anfallen, wie z.B. die Erstellung, Metadatenabfragen, Zugriffskontrolle, Anzeige von Datenänderungen und sogar DDL-Abfragen, fallen für diese Abfragen Cloud-Kosten an.

- Je nachdem, welche Art von Snowflake Edition Sie haben, werden Ihnen die entsprechenden Gutschriften für alle Clouddienstekosten in Rechnung gestellt.

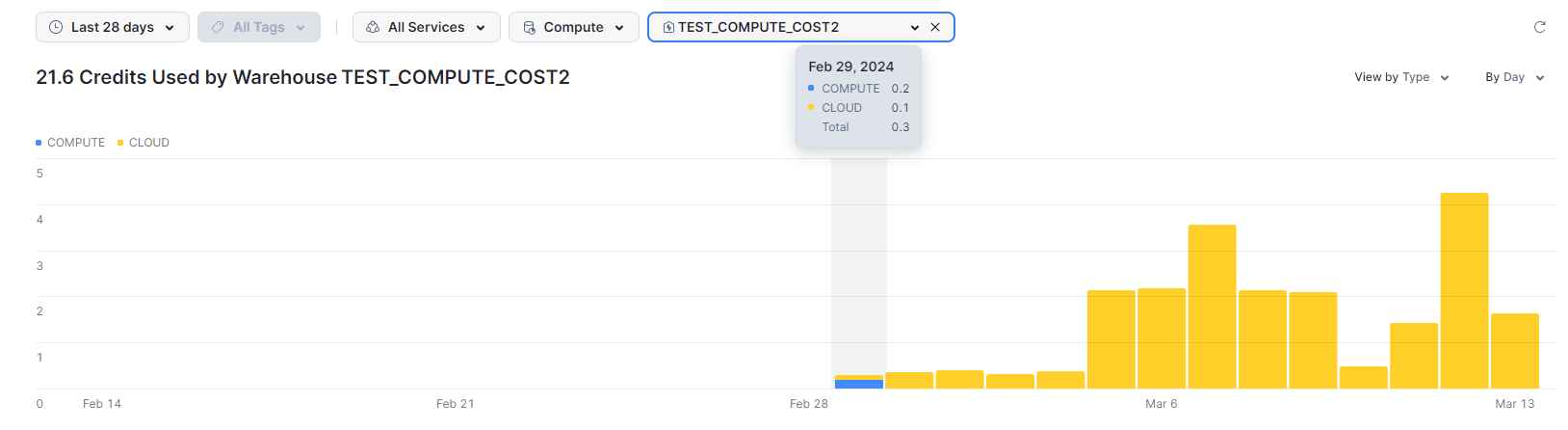

Im folgenden Screenshot sehen Sie die Compute-Kosten für das virtuelle Lager und die Cloud Services für die zugehörige Snowflake-Datenbank, die in Fabric gespiegelt wird. In diesem Szenario entfällt der Großteil der Compute-Kosten für Cloud-Dienste (in gelb) auf Datenänderungsanfragen, die auf den zuvor genannten Punkten basieren. Die Compute-Gebühren für das virtuelle Lager (in blau) stammen ausschließlich aus den Datenänderungen, die aus Snowflake gelesen und in Fabric gespiegelt werden.

Weitere Informationen zu Snowflake-spezifischen Cloud-Abfragekosten finden Sie unter Snowflake Docs: Grundlegendes zu den Gesamtkosten.