Delta Lake-Protokolle in Warehouse in Microsoft Fabric

Gilt für:✅ Warehouse in Microsoft Fabric

Warehouse in Microsoft Fabric basiert auf offenen Dateiformaten. Benutzertabellen werden im Parquet-Dateiformat gespeichert, und Delta Lake-Protokolle werden für alle Benutzertabellen veröffentlicht.

Die Delta Lake-Protokolle ermöglichen direkten Zugriff auf die Benutzertabellen des Warehouses bei jeder Engine, die Delta Lake-Tabellen lesen kann. Dieser Zugriff ist auf „schreibgeschützt“ begrenzt, um sicherzustellen, dass die Benutzerdaten die ACID-Transaktionskonformität beibehalten. Alle Einfügevorgänge, Aktualisierungen und Löschvorgänge für die Daten in den Tabellen müssen über das Warehouse durchgeführt werden. Nachdem eine Transaktion committet wurde, wird ein Systemhintergrundprozess zum Veröffentlichen des aktualisierten Delta Lake-Protokolls für die betroffenen Tabellen initiiert.

Abrufen des OneLake-Pfads

In den folgenden Schritten wird erläutert, wie Sie den OneLake-Pfad aus einer Tabelle in einem Warehouse abrufen:

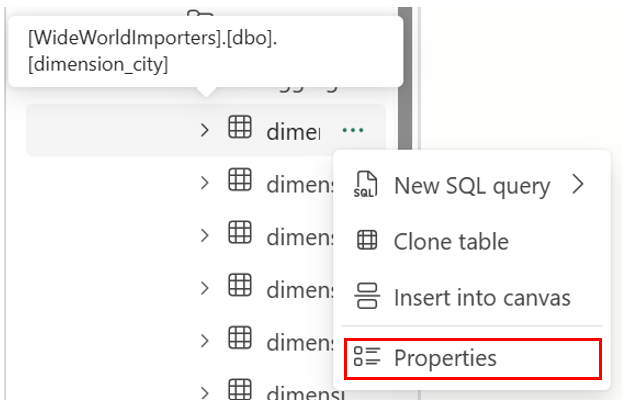

Öffnen Sie Warehouse in Ihrem Microsoft Fabric-Arbeitsbereich.

Im Objekt-Explorer finden Sie weitere Optionen (...) für eine ausgewählte Tabelle im Ordner Tabellen. Wählen Sie das Menü Eigenschaften aus.

Wenn der Bereich Eigenschaften ausgewählt wurde, zeigt er die folgenden Informationen:

- Name

- Format

- Typ

- URL

- Relativer Pfad

- ABFS-Pfad

Abrufen des Delta Lake-Protokollpfads

Sie können Delta Lake-Protokolle mit den folgenden Methoden suchen:

Delta Lake-Protokolle können über Verknüpfungen abgefragt werden, die in einem Lakehouse erstellt wurden. Sie können die Dateien im Microsoft Fabric-Portal mithilfe eines Microsoft Fabric Spark-Notebooks oder des Lakehouse-Explorers in Synapse-Datentechnik anzeigen.

Delta Lake-Protokolle können über Azure Storage-Explorer, über Spark-Verbindungen wie den Power BI-Direct Lake-Modus oder mithilfe eines beliebigen anderen Diensts gefunden werden, der Deltatabellen lesen kann.

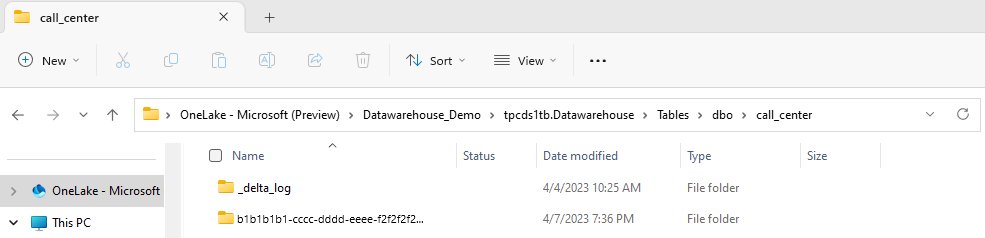

Delta Lake-Protokolle finden Sie im Ordner

_delta_logjeder Tabelle über den OneLake-Explorer in Windows, wie im folgenden Screenshot gezeigt wird.

Anhalten der Veröffentlichung von Delta Lake-Protokollen

Die Veröffentlichung von Delta Lake-Protokollen kann bei Bedarf angehalten und fortgesetzt werden. Wenn die Veröffentlichung angehalten wird, sehen Microsoft Fabric-Engines, die Tabellen außerhalb des Warehouse lesen, die Daten wie vor der Pause. Dadurch wird sichergestellt, dass Berichte stabil und konsistent bleiben, wobei Daten aus allen Tabellen wie vorhanden angezeigt werden, bevor Änderungen an den Tabellen vorgenommen wurden. Nachdem Ihre Datenaktualisierungen abgeschlossen sind, können Sie die Delta Lake Log-Veröffentlichung fortsetzen, um alle aktuellen Datenänderungen für andere Analysemodule sichtbar zu machen. Ein weiterer Anwendungsfall für das Anhalten der Delta Lake-Protokollveröffentlichung besteht darin, dass Benutzer keine Interoperabilität mit anderen Computemodulen in Microsoft Fabric benötigen, da sie die Kosten für die Berechnung sparen können.

Die Syntax zum Anhalten und Fortsetzen der Delta Lake-Protokollveröffentlichung lautet wie folgt:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED | AUTO

Beispiel: Anhalten und Fortsetzen der Delta Lake-Protokollveröffentlichung

Verwenden Sie den folgenden Codeausschnitt, um die Veröffentlichung des Delta Lake-Protokolls anzuhalten:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED

Abfragen an Warehouse-Tabellen im aktuellen Warehouse aus anderen Microsoft Fabric-Engines (z. B. Abfragen aus einem Lakehouse) zeigen nun eine Version der Daten an, wie sie vor dem Anhalten der Veröffentlichung von Delta Lake-Protokollen war. Warehouse-Abfragen zeigen weiterhin die neueste Version von Daten an.

Verwenden Sie den folgenden Codeausschnitt, um die Veröffentlichung von Delta Lake-Protokollen fortzusetzen:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = AUTO

Wenn der Zustand wieder in AUTO geändert wird, veröffentlicht die Fabric Warehouse-Engine Protokolle aller letzten Änderungen, die an Tabellen im Warehouse vorgenommen wurden, und ermöglicht es anderen Analysemodulen in Microsoft Fabric, die neueste Version von Daten zu lesen.

Überprüfen des Status der Veröffentlichung von Delta Lake-Protokollen

Verwenden Sie den folgenden Codeausschnitt, um den aktuellen Status der Veröffentlichung von Delta Lake-Protokollen in allen Warehouses für den aktuellen Arbeitsbereich zu überprüfen:

SELECT [name], [DATA_LAKE_LOG_PUBLISHING_DESC] FROM sys.databases

Begrenzungen

- Tabellennamen können von Spark und anderen Systemen nur dann verwendet werden, wenn sie ausschließlich die folgenden Zeichen enthalten: A–Z, a–z, 0–9 und Unterstriche.

- Spaltennamen, die von Spark und anderen Systemen verwendet werden, können Folgendes nicht enthalten:

- spaces

- tabs

- Wagenrückläufe

- [

- ,

- ;

- {

- }

- (

- )

- =

- ]