Kopieren aus Azure Blob Storage in Lakehouse

In diesem Tutorial erstellen Sie eine Datenpipeline, um eine CSV-Datei aus einem Eingabeordner einer Azure Blob Storage-Quelle in ein Lakehouse-Ziel zu verschieben.

Voraussetzungen

Um zu beginnen, müssen die folgenden Voraussetzungen erfüllt sein:

Stellen Sie sicher, dass Sie über einen für Project Microsoft Fabric aktivierten Arbeitsbereich verfügen: Erstellen eines Arbeitsbereichs.

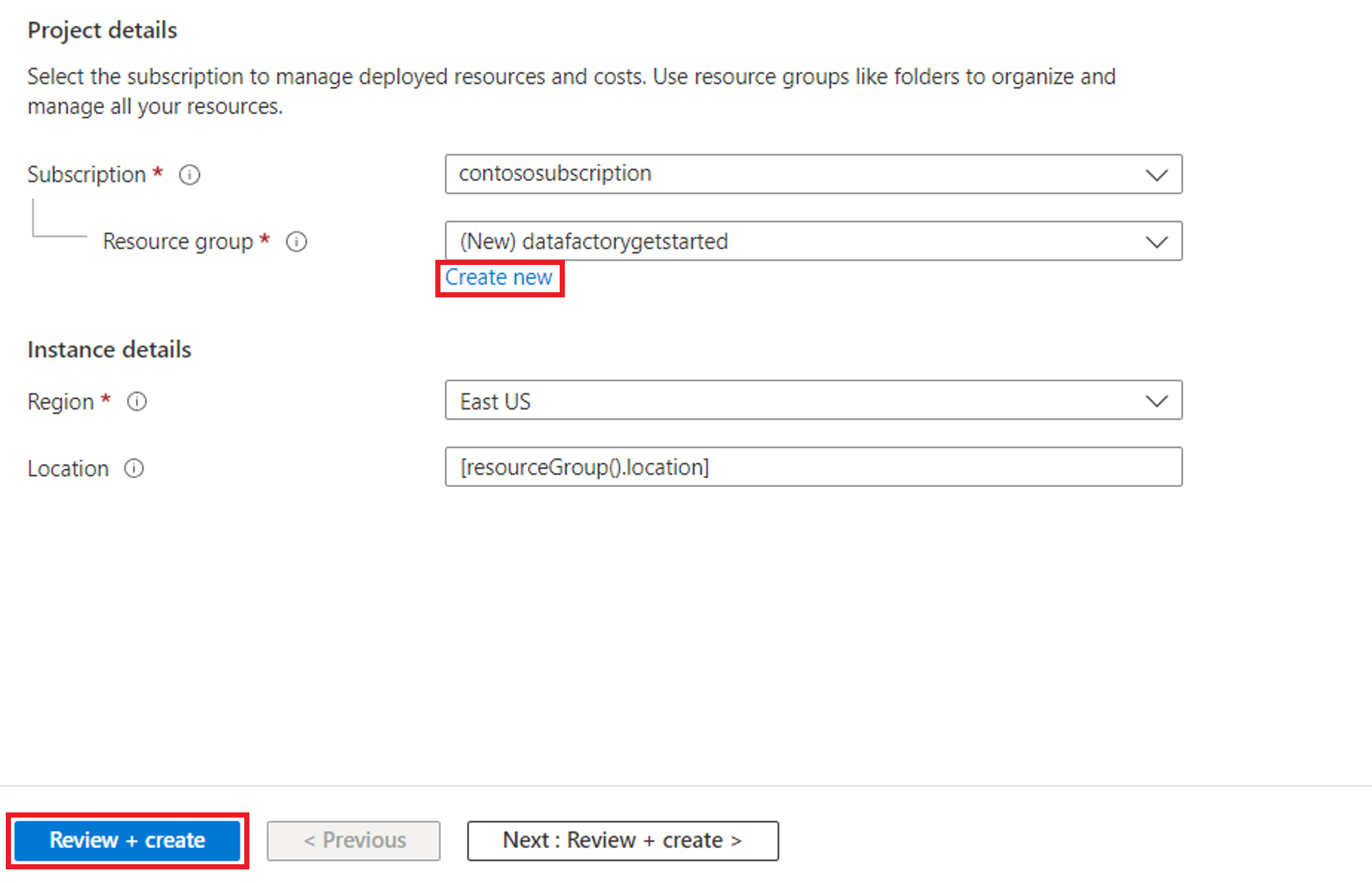

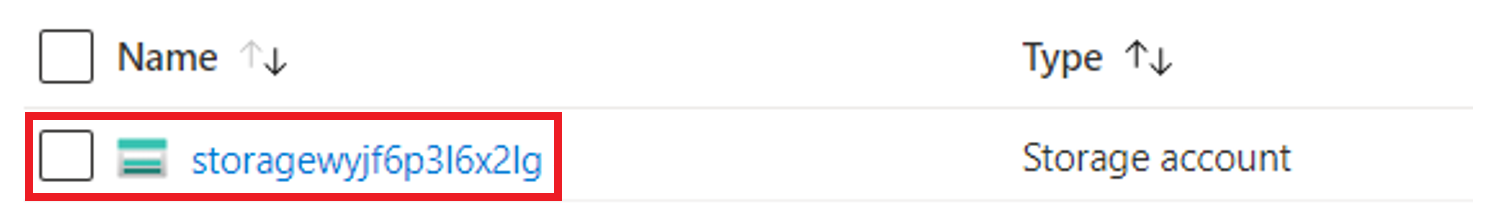

Wählen Sie die Schaltfläche Jetzt testen! aus, um die Azure Blob Storage-Datenquelle des Kopiervorgangs vorzubereiten. Erstellen Sie eine neue Ressourcengruppe für diese Azure Blob Storage-Instanz, und wählen Sie Überprüfen und Erstellen>Erstellen aus.

Anschließend wird eine Azure Blob Storage-Instanz erstellt und moviesDB2.csv in den Eingabeordner der erstellten Azure Blob Storage-Instanz hochgeladen.

Erstellen einer Datenpipeline

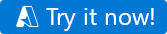

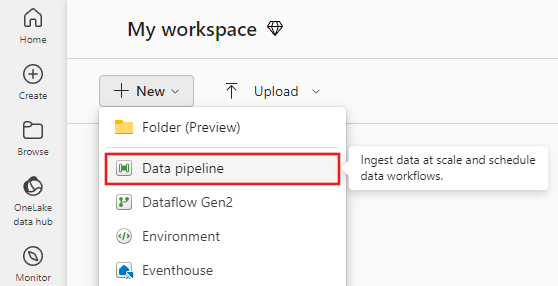

Wechseln Sie auf der Seite „app.powerbi.com“ zu Data Factory.

Erstellen Sie einen neuen Arbeitsbereich für diese Demo.

Wählen Sie Neu und dann Datenpipeline aus.

Kopieren von Daten mithilfe des Kopier-Assistenten

In dieser Sitzung beginnen Sie mit dem Erstellen einer Datenpipeline, indem Sie die folgenden Schritte ausführen. Mit diesen Schritten wird eine CSV-Datei aus einem Eingabeordner einer Azure Blob Storage-Instanz in ein Lakehouse-Ziel kopiert, indem Sie den Assistenten verwenden.

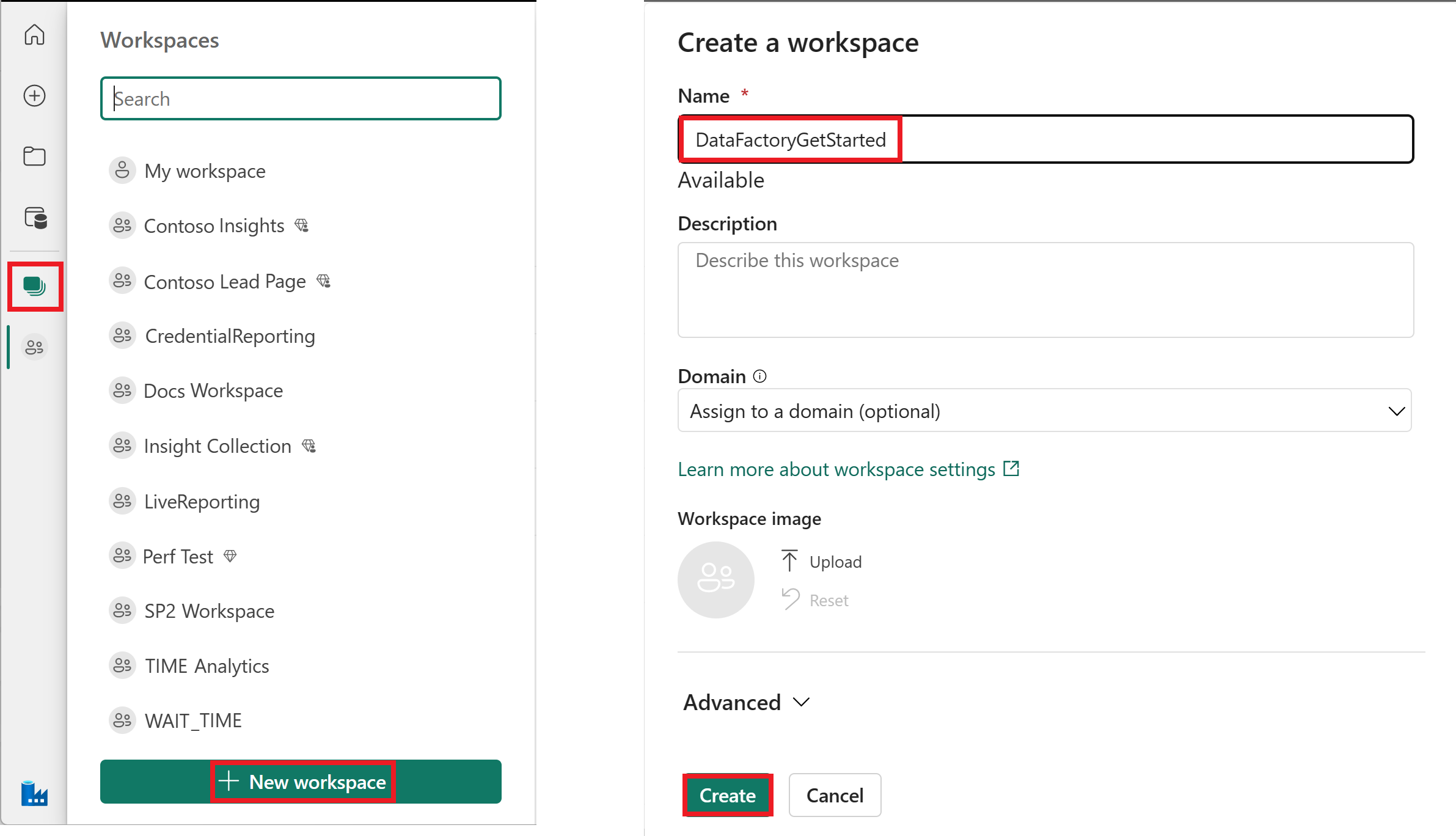

Schritt 1: Beginnen mit dem Kopier-Assistenten

Wählen Sie den Assistent Daten kopieren auf dem Canvas aus, um den Kopier-Assistenten für erste Schritte zu öffnen. Alternativ können Sie in der Dropdownliste Daten kopieren auf der Registerkarte Aktivitäten im Menüband die Option Kopier-Assistent verwenden auswählen.

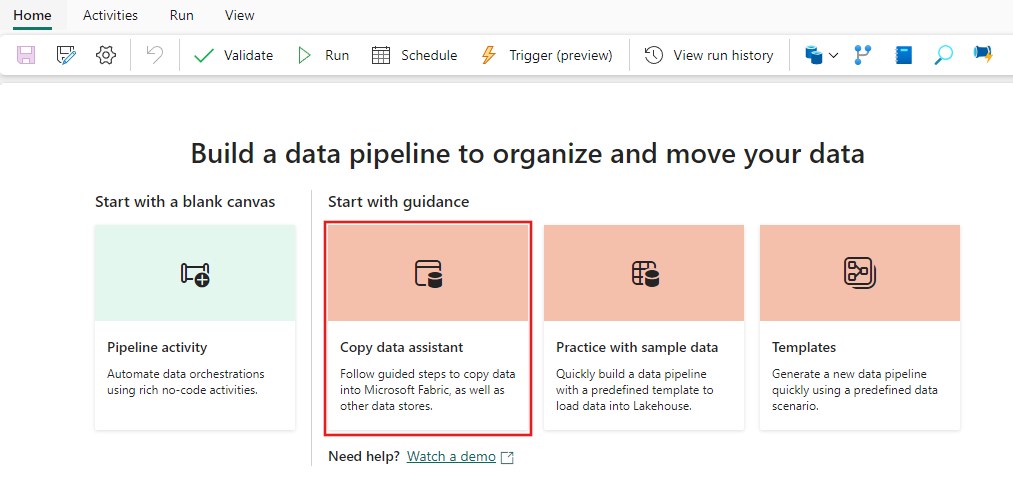

Schritt 2: Konfigurieren der Quelle

Geben Sie blob in den Auswahlfilter ein, wählen Sie dann Azure Blobs aus und wählen SieWeiter aus.

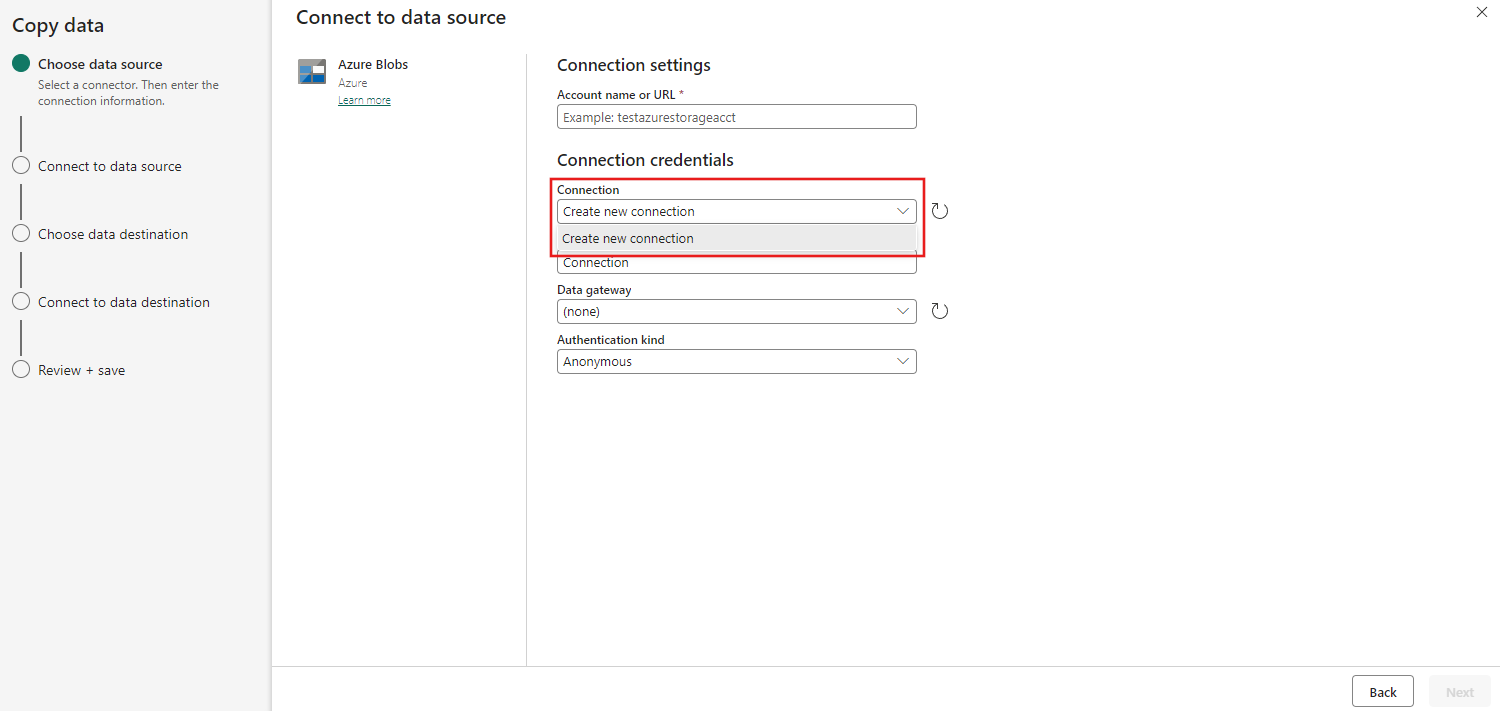

Geben Sie Ihren Kontonamen oder die URL an und erstellen Sie eine Verbindung mit Ihrer Datenquelle, indem Sie unter der Dropdownliste VerbindungNeue Verbindung erstellen auswählen.

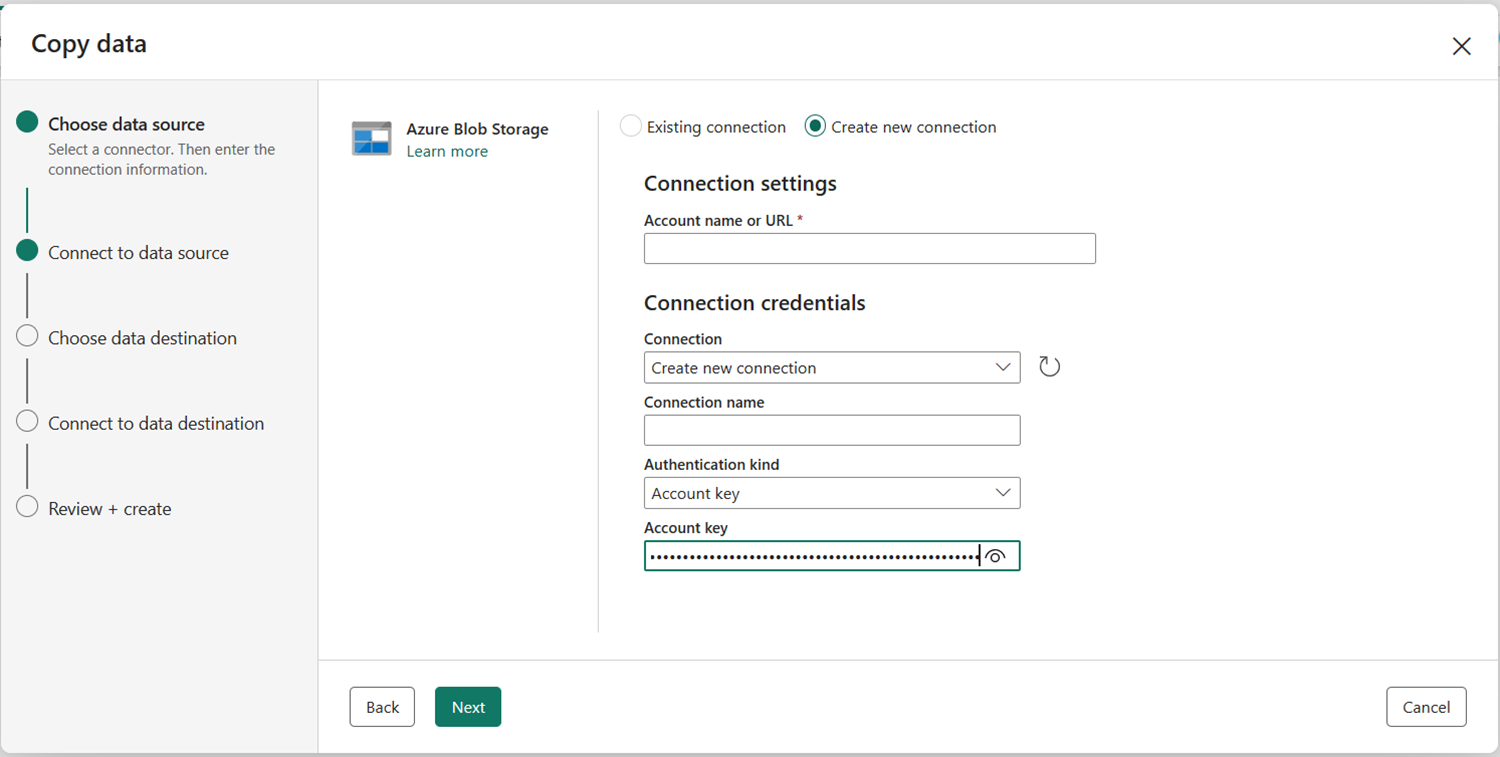

Nachdem Sie Neue Verbindung erstellen ausgewählt haben, müssen Sie nur Kontoname oder URL und die Authentifizierungsart eingeben. In dieser Demo wählen wir Kontoschlüssel aus, aber Sie können eine andere Authentifizierungsart gemäß Ihren Einstellungen auswählen.

Nachdem die Verbindung erfolgreich hergestellt wurde, müssen Sie nur „Weiter“ auswählen, um eine Verbindung mit der Datenquelle herzustellen.

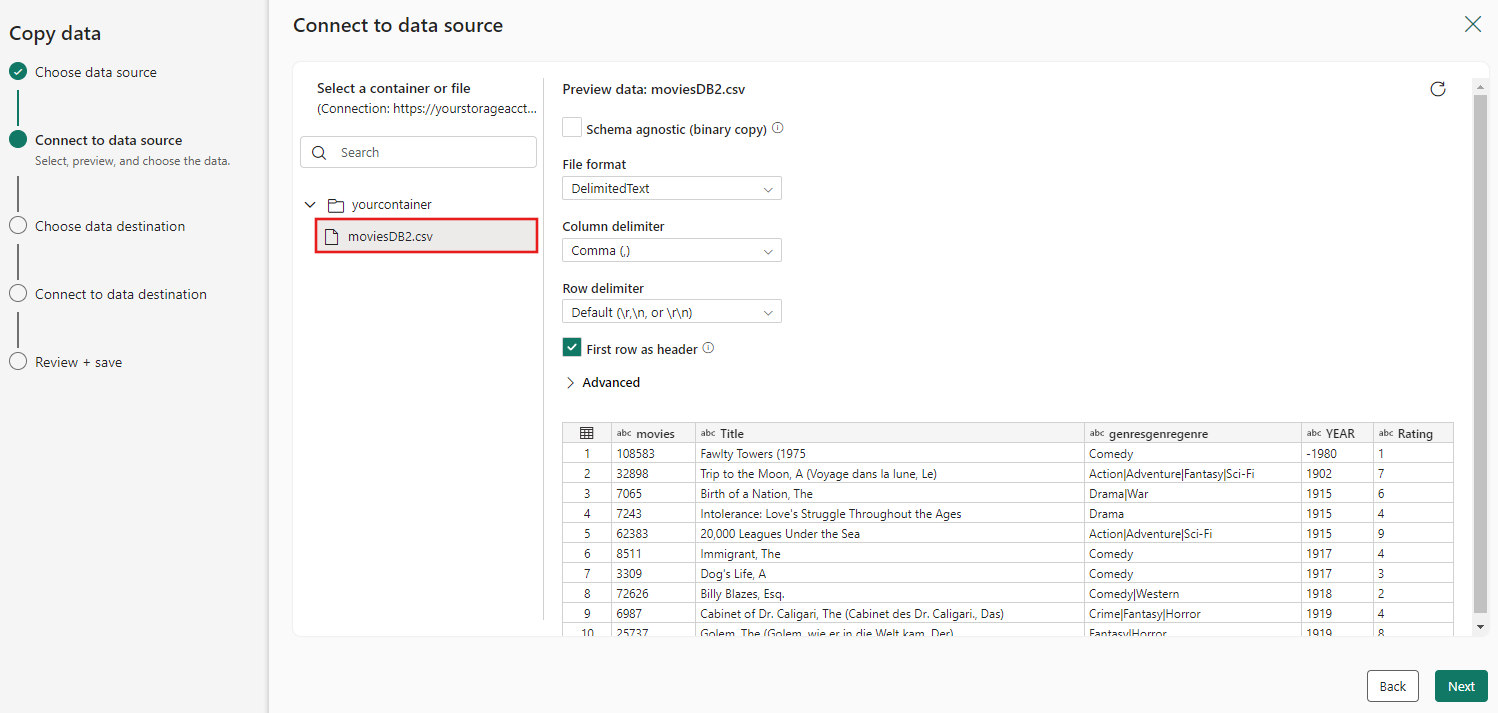

Wählen Sie die Datei moviesDB2.csv in der „Quellkonfiguration“ aus, um eine Vorschau anzuzeigen, und wählen Sie dann Weiter aus.

Schritt 3: Konfigurieren des Ziels

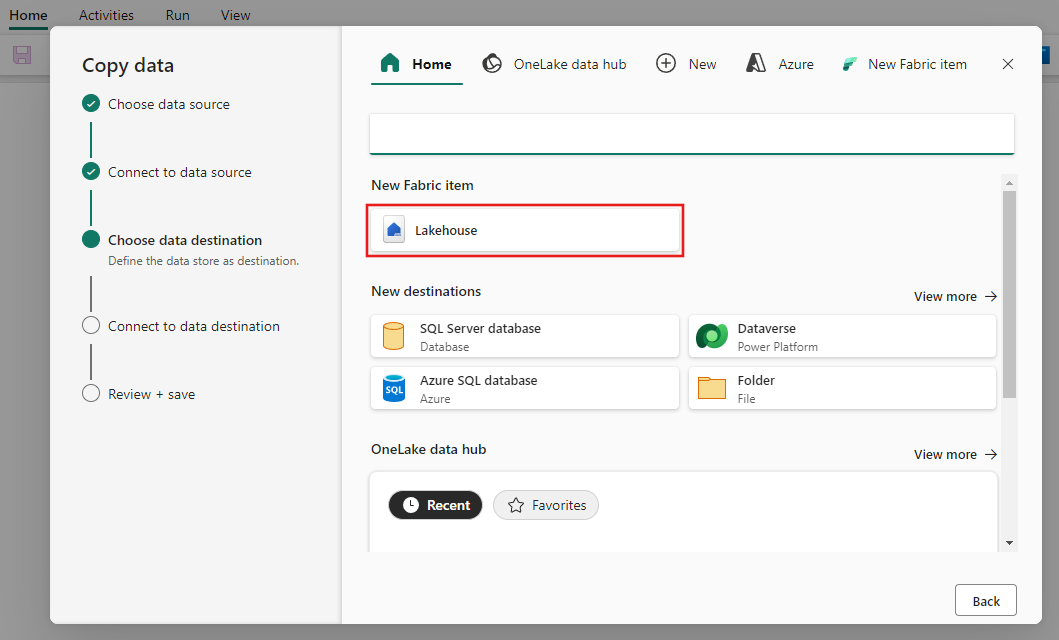

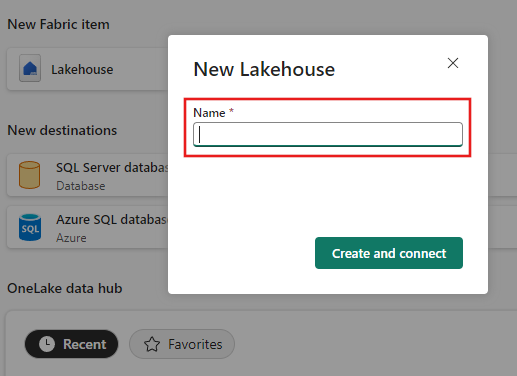

Wählen Sie Lakehouse aus.

Geben Sie einen Namen für den neuen Server an. Wählen Sie dann Erstellen und konfigurieren aus.

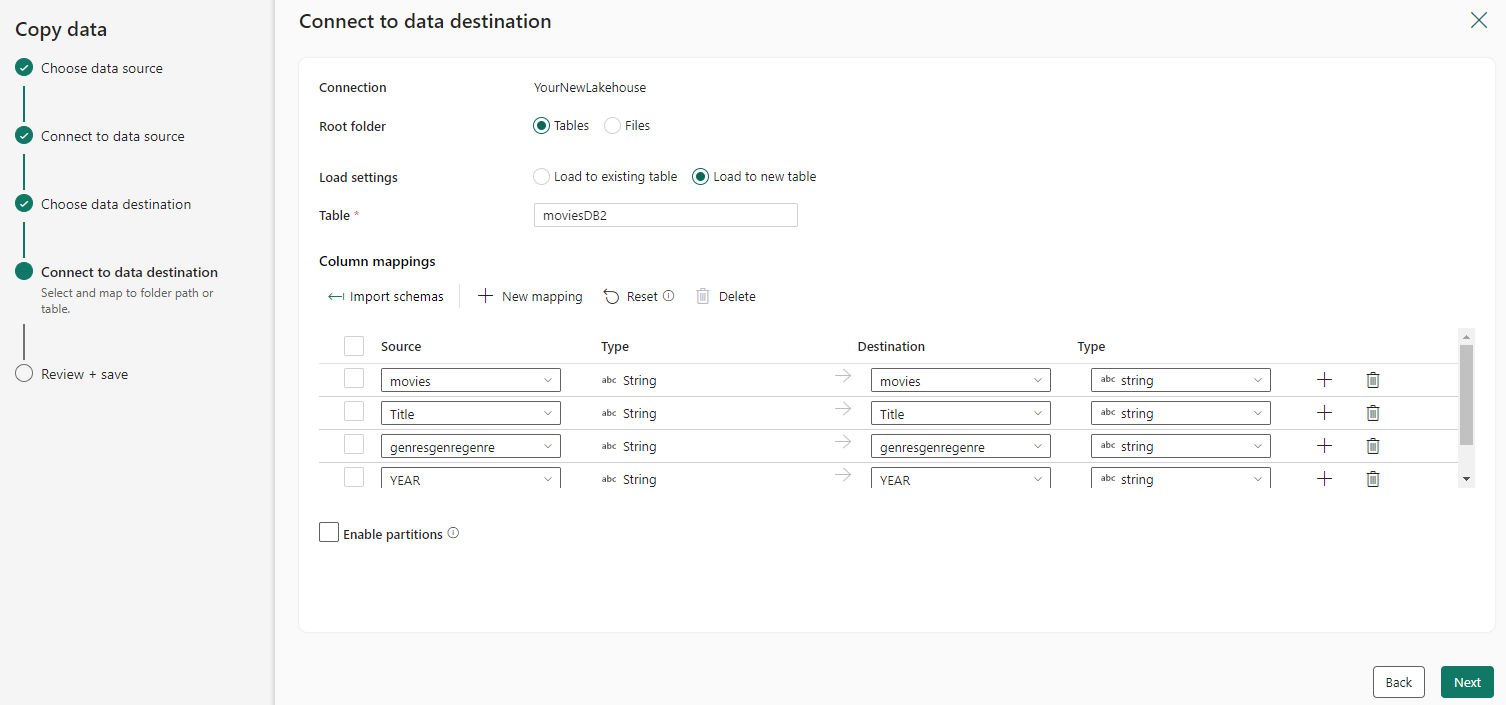

Konfigurieren Sie Ihre Quelldaten, und ordnen Sie sie Ihrem Ziel zu. Wählen Sie dann Weiter aus, um die Zielkonfigurationen abzuschließen.

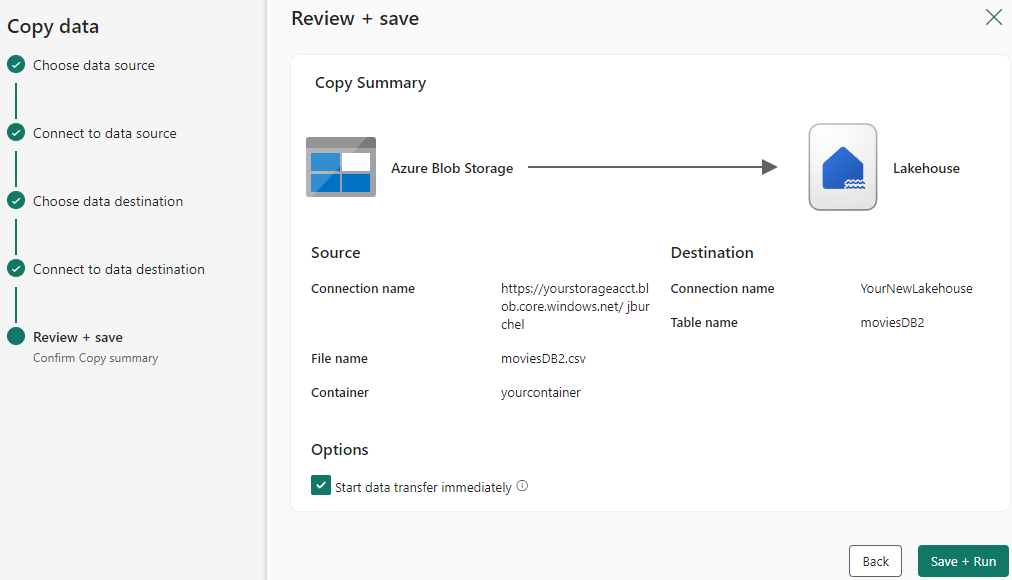

Schritt 4: Überprüfen und Erstellen der Copy-Aktivität

Überprüfen Sie die Einstellungen Ihrer Copy-Aktivität in den vorherigen Schritten, und wählen Sie OK aus, um den Vorgang abzuschließen. Sie können auch zu den vorherigen Schritten zurückkehren, um Ihre Einstellungen bei Bedarf im Tool zu bearbeiten.

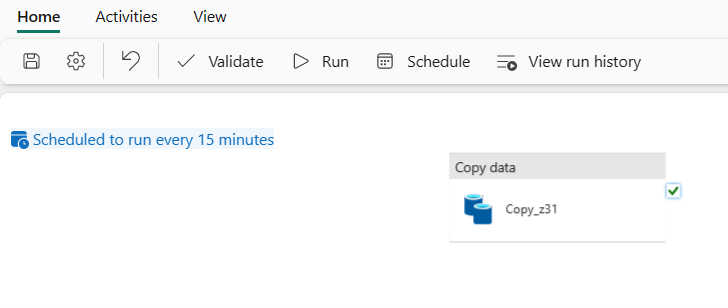

Nach Abschluss des Vorgangs wird die Kopieraktivität dem Datenpipeline-Canvas hinzugefügt und direkt ausgeführt, wenn Sie das Kontrollkästchen "Datenübertragung starten" sofort aktiviert haben.

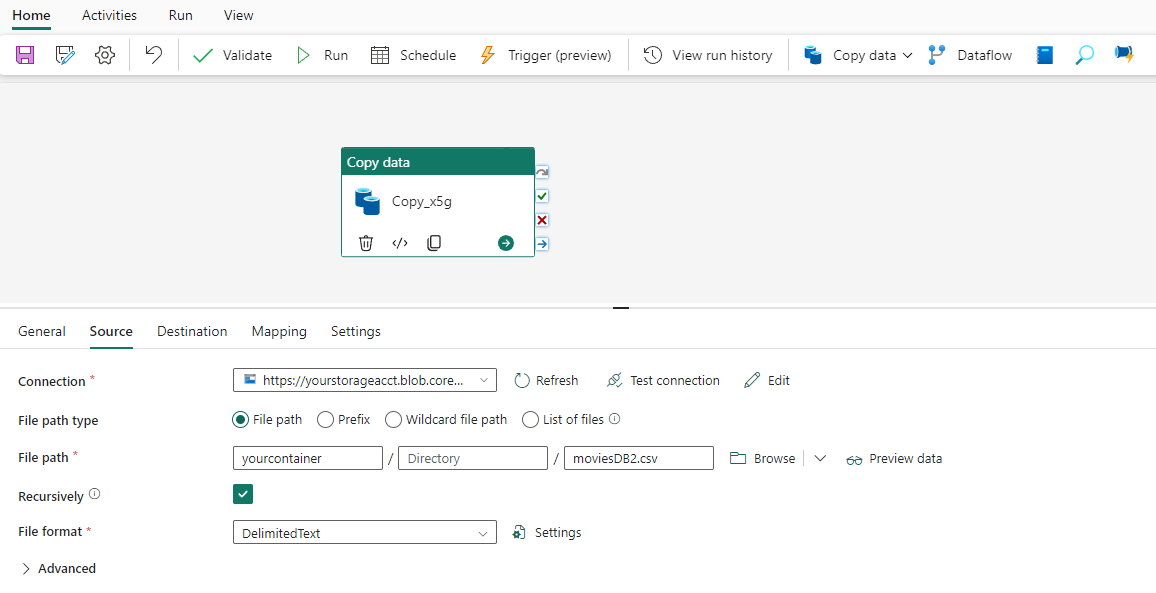

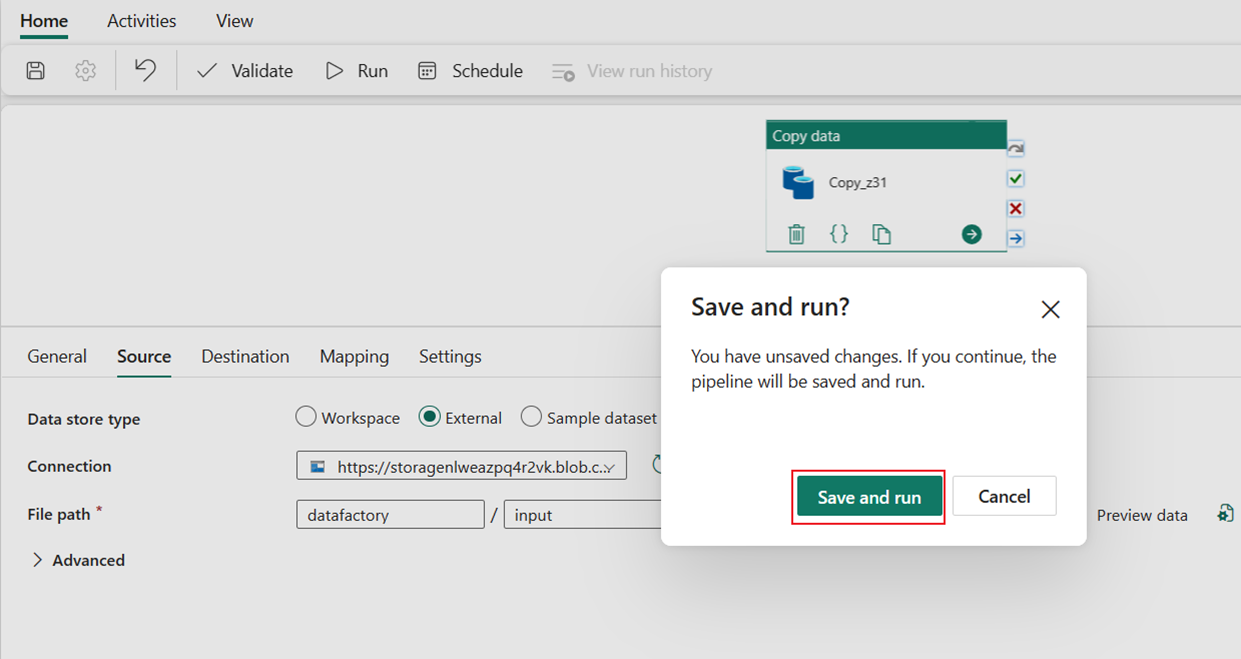

Ausführen und Planen Ihrer Datenpipeline

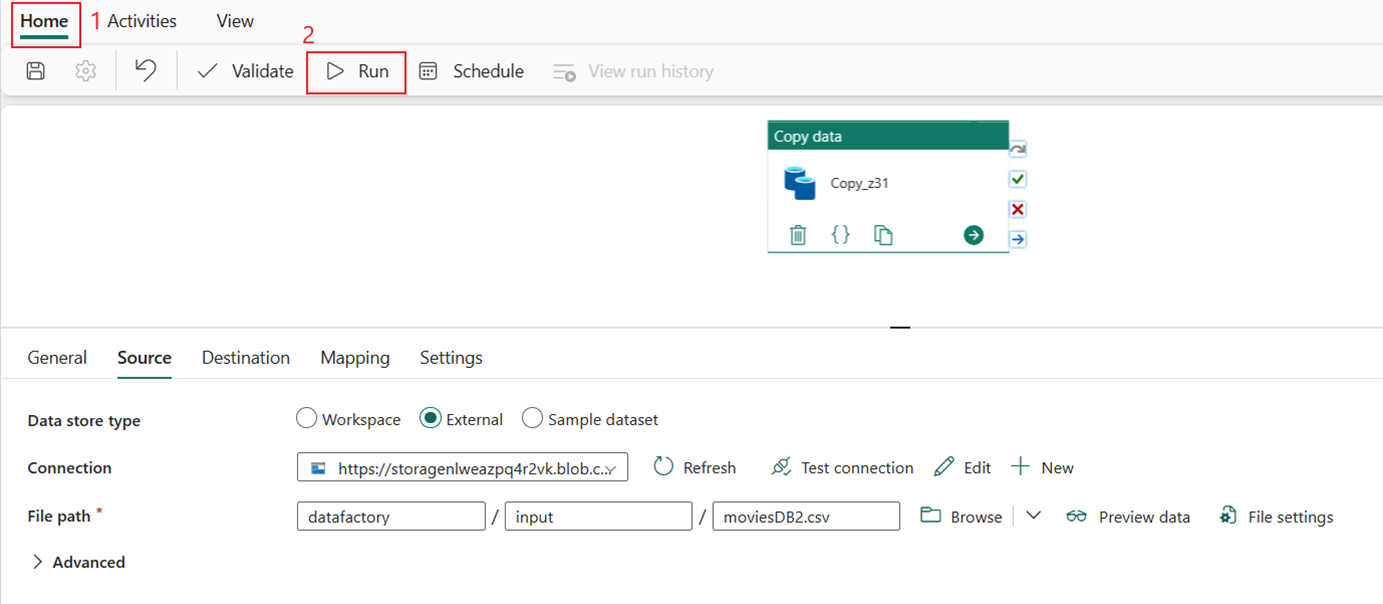

Wenn Sie das Kontrollkästchen "Datenübertragung starten" nicht sofort auf der Seite "Überprüfen+ Erstellen" verlassen haben, wechseln Sie zur Registerkarte "Start", und wählen Sie "Ausführen" aus. Wählen Sie dann Speichern und ausführen aus.

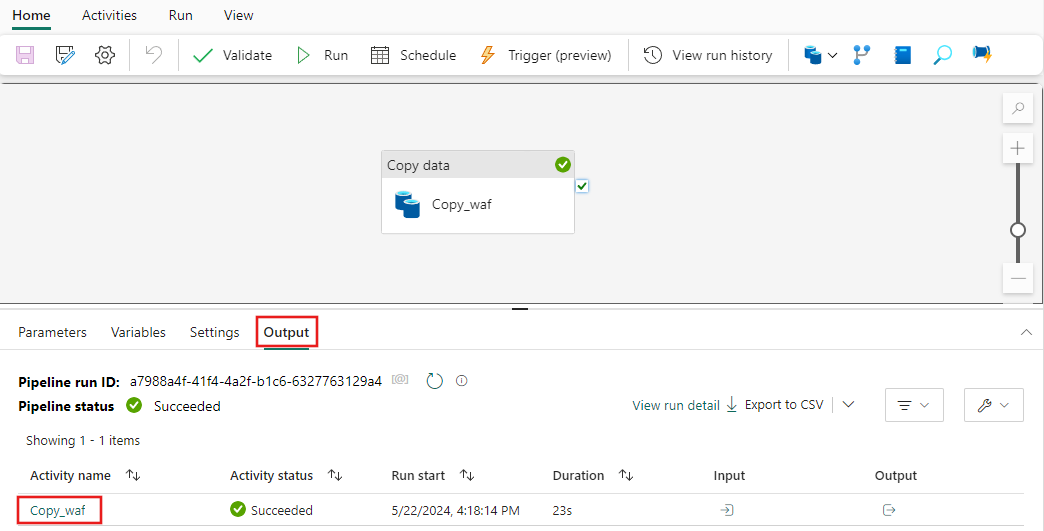

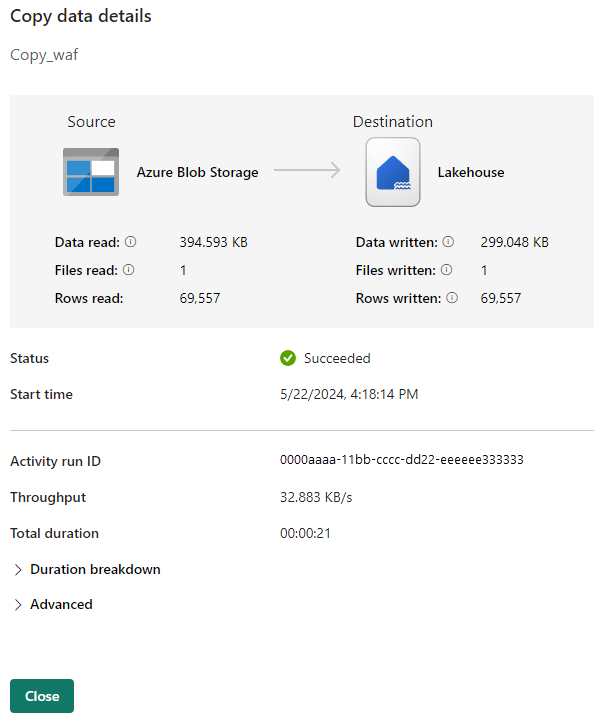

Wählen Sie auf der Registerkarte "Ausgabe" den Link mit dem Namen Ihrer Copy-Aktivität aus, um den Fortschritt zu überwachen und die Ergebnisse der Ausführung zu überprüfen.

Das Dialogfeld Datendetails kopieren zeigt die Ergebnisse der Ausführung an, einschließlich des Status, der gelesenen und geschriebenen Datenmenge, der Start- und Endzeiten und der Dauer.

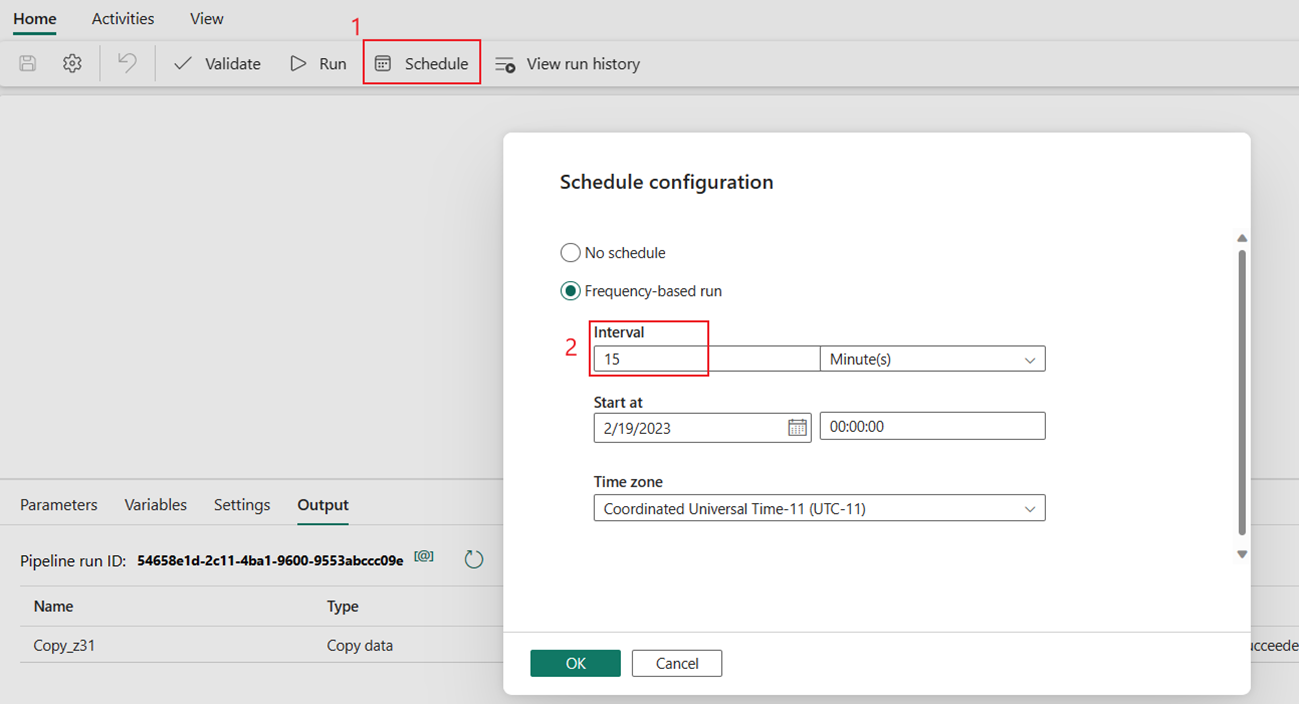

Sie können die Ausführung der Pipeline auch nach Bedarf mit einer bestimmten Häufigkeit planen. Das folgende Beispiel zeigt, wie Die Pipeline alle 15 Minuten ausgeführt wird.

Zugehöriger Inhalt

Die Pipeline in diesem Beispiel zeigt, wie Daten aus Azure Blob Storage in Lakehouse kopiert werden. Sie haben Folgendes gelernt:

- Erstellen Sie eine Datenpipeline.

- Kopieren Sie Daten mit dem Kopier-Assistenten.

- Führen Sie Ihre Datenpipeline aus, und planen Sie sie.

Erfahren Sie im nächsten Schritt mehr über die Überwachung Ihrer Pipelineausführungen.