Transformieren von Daten durch Ausführen einer SparkAuftragsdefinitionsaktivität

Mit der Spark Job Definition-Aktivität in Data Factory für Microsoft Fabric können Sie Verbindungen zu Ihren Spark Job Definitions erstellen und sie aus einer Datenpipeline ausführen.

Voraussetzungen

Um zu beginnen, müssen Sie die folgenden Voraussetzungen erfüllen:

- Ein Mandantenkonto mit einem aktiven Abonnement. Erstellen Sie ein kostenloses Konto.

- Ein Arbeitsbereich wird erstellt.

Hinzufügen einer SparkAuftragsdefinitionsaktivität zu einer Pipeline mit Benutzeroberfläche

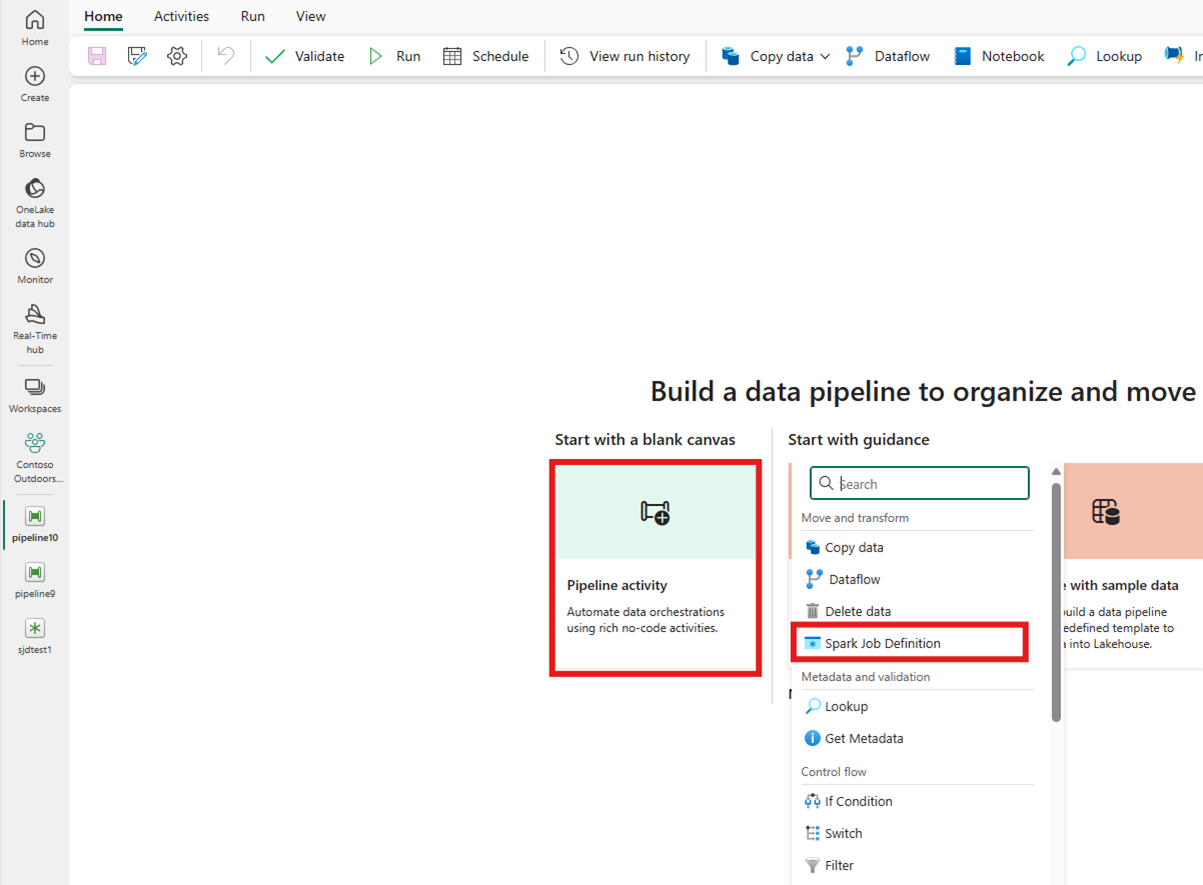

Erstellen Sie eine neue Datenpipeline in Ihrem Arbeitsbereich.

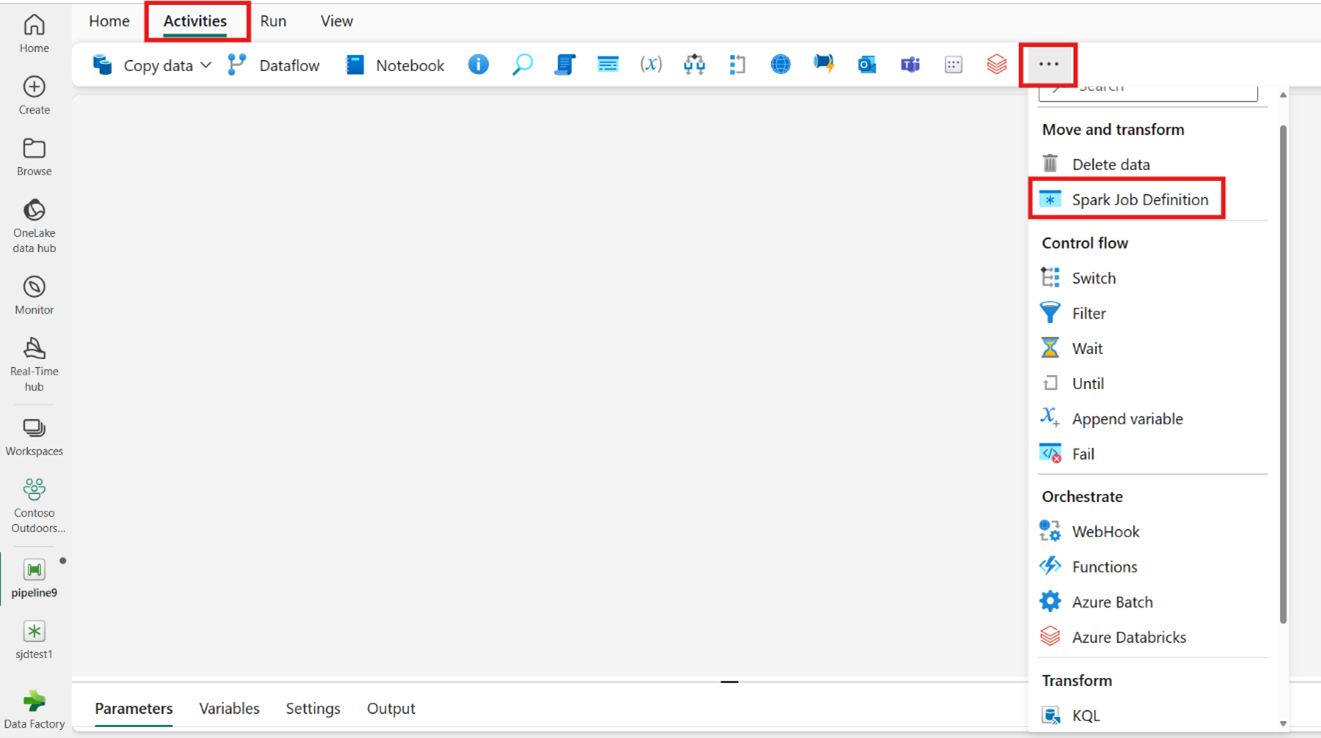

Suchen Sie auf der Startseitenkarte nach „Spark Job Definition“, und wählen Sie die Komponente aus. Alternativ können Sie die Aktivität auf der Leiste „Aktivitäten“ auswählen, um die Komponente zur Pipelinecanvas hinzuzufügen.

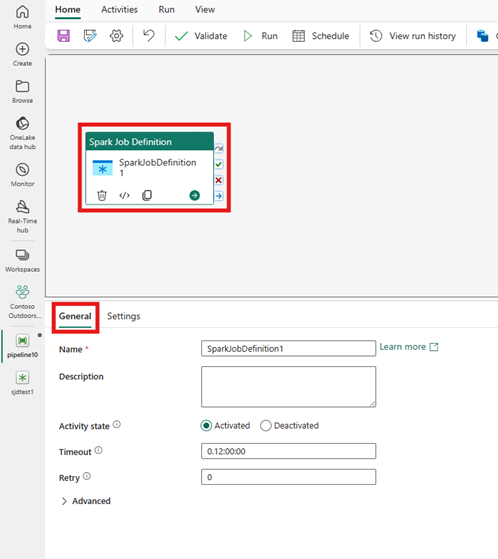

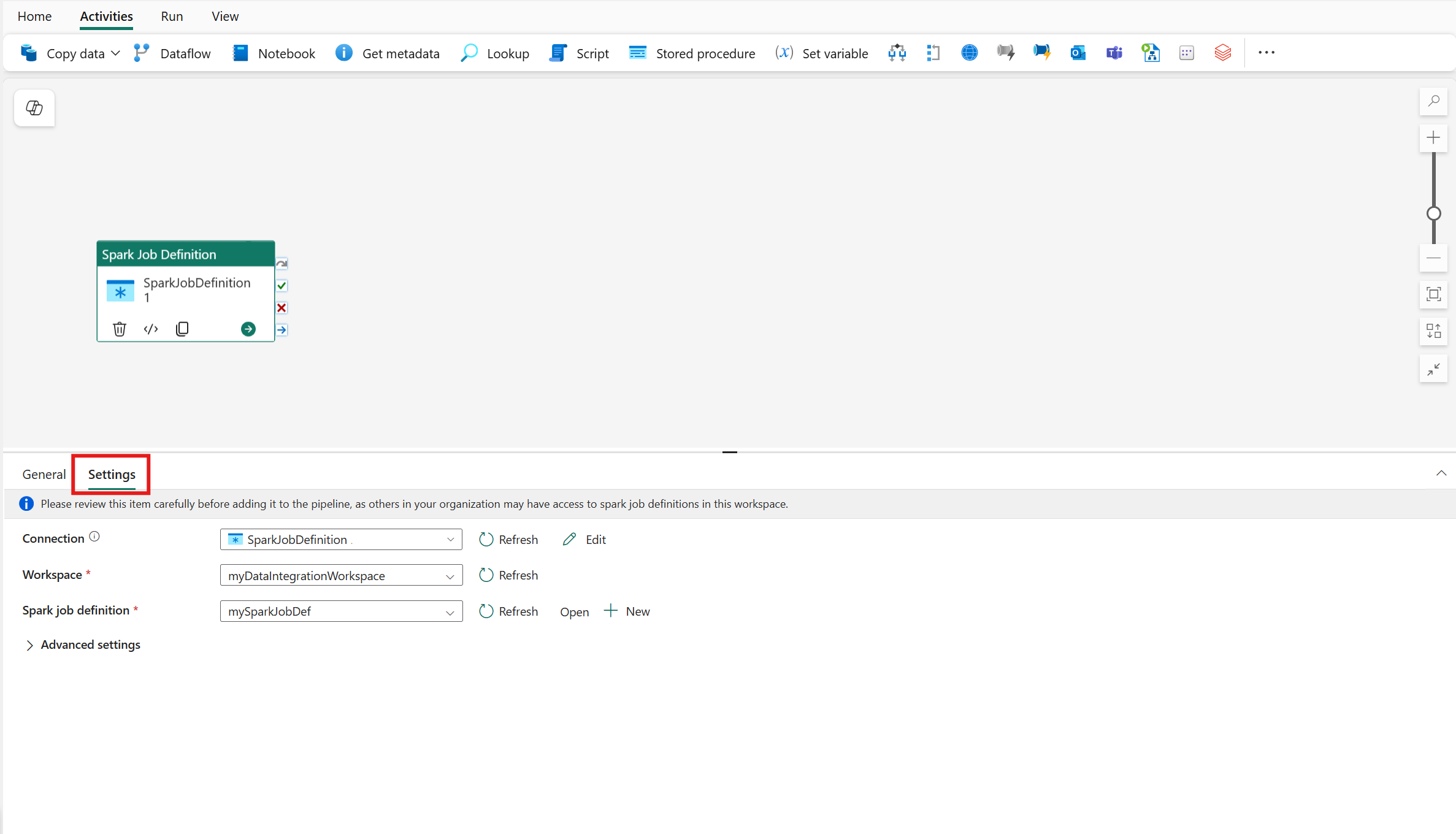

Wählen Sie die neue Spark Job Definition-Aktivität im Pipeline-Editor-Canvas aus, wenn sie noch nicht ausgewählt ist.

Beachten Sie die Anleitung zu den allgemeinen Einstellungen, um die Optionen auf der Registerkarte Allgemeine Einstellungen zu konfigurieren.

Spark Job Definition-Aktivitätseinstellungen

Wählen Sie im Bereich der Aktivitätseigenschaften die Registerkarte Einstellungen aus, und wählen Sie dann den Fabric-Arbeitsbereich aus, der die Spark-Auftragsdefinition enthält, die Sie ausführen möchten.

Bekannte Einschränkungen

Die aktuellen Einschränkungen in der Spark Job Definition-Aktivität für Fabric Data Factory sind hier aufgeführt. Dieser Abschnitt kann geändert werden.

- Das Erstellen einer neuen Spark Job Definition-Aktivität innerhalb der Aktivität wird derzeit nicht unterstützt (unter "Einstellungen")

- Die Parameterisierungsunterstützung ist nicht verfügbar.

- Obwohl wir die Überwachung der Aktivität über den Ausgabetab unterstützen, können Sie die Spark Job Definition noch nicht auf einer detaillierteren Ebene überwachen. Links zur Überwachungsseite, zum Status, zur Dauer und vorherigen Spark Job Definition-Ausführungen sind beispielsweise nicht direkt in Data Factory verfügbar. Auf der Spark Job Definition Monitoring-Seitekönnen Sie jedoch genauere Details sehen.

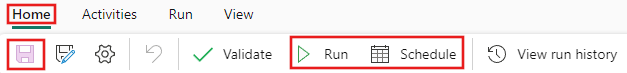

Speichern und Ausführen oder Planen der Pipeline

Nachdem Sie alle anderen aktivitäten konfiguriert haben, die für Ihre Pipeline erforderlich sind, wechseln Sie oben im Pipeline-Editor zur Registerkarte "Start", und wählen Sie die Schaltfläche "Speichern" aus, um Die Pipeline zu speichern. Wählen Sie Ausführen aus, um sie direkt auszuführen, oder Planen, um sie zu planen. Sie können den Ausführungsverlauf auch hier anzeigen oder andere Einstellungen konfigurieren.