Preisszenario mit einer Datenpipeline zum Laden von 1 TB Parquet-Daten in einer Lakehouse-Tabelle

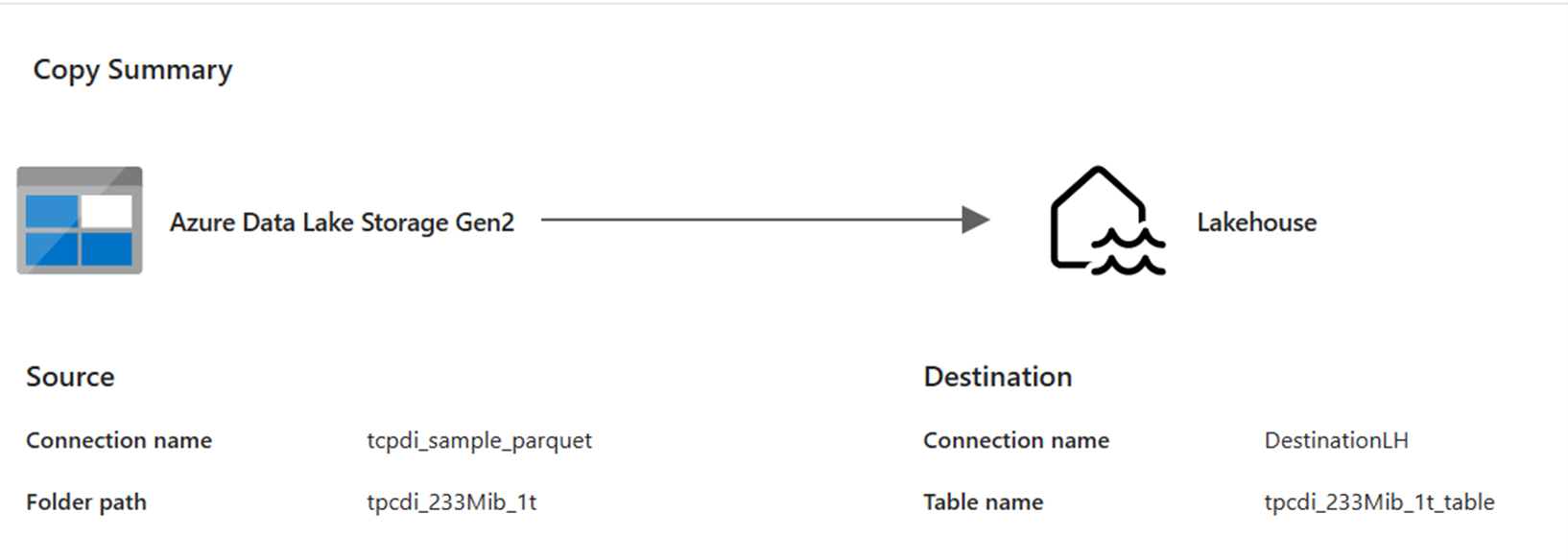

In diesem Szenario wurde eine Copy-Aktivität in einer Datenpipeline verwendet, um 1 TB Parquet-Daten zu laden, die in Azure Data Lake Storage (ADLS) Gen2 in einer Lakehouse-Tabelle in Microsoft Fabric gespeichert sind.

Die im folgenden Beispiel verwendeten Preise sind hypothetisch und stellen nicht die tatsächlichen genauen Preise dar. Diese Beispiele sollen nur zeigen, wie Sie die Kosten für Data Factory-Projekte in Microsoft Fabric schätzen, planen und verwalten können. Da die Preise für Fabric-Kapazitäten in jeder Region unterschiedlich sind, verwenden wir nutzungsbasierte Preise für eine Fabric-Kapazität in USA, Westen 2 (einer typischen Azure-Region) in Höhe von 0,18 $ pro CU und Stunde. Weitere Preisoptionen für Fabric-Kapazitäten finden Sie unter Microsoft Fabric – Preise.

Konfiguration

Um dieses Szenario zu realisieren, müssen Sie eine Pipeline mit der folgenden Konfiguration erstellen:

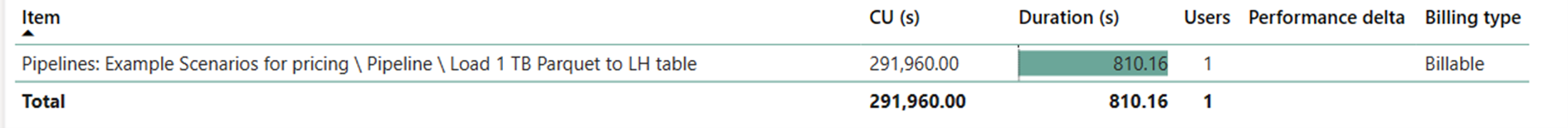

Kostenschätzung mithilfe der Fabric-Metrik-App

Der Datenverschiebungsvorgang beanspruchte 291.960 CU-Sekunden mit einer Dauer von 810,16 Sekunden (13,5 Minuten), während der Aktivitätsausführungsvorgang null war, da es keine Nicht-Copy-Aktivitäten in der Pipelineausführung gab.

Hinweis

Obwohl die tatsächliche Ausführungsdauer als Metrik gemeldet wird, ist sie für die Berechnung der effektiven CU-Stunden mit der Fabric-Metrik-App nicht relevant, da die ebenfalls gemeldete CU-Sekunden-Metrik die Dauer bereits berücksichtigt.

| Metrik | Datenverschiebungsvorgang |

|---|---|

| CU-Sekunden | 291.960 CU-Sekunden |

| Effektive CU-Stunden | (291.960) / (60*60) CU-Stunden = 81,1 CU-Stunden |

Gesamtlaufkosten bei 0,18 $/CU-Stunde = (81,1 CU-Stunden) * (0,18 $/CU-Stunde) ~= 14,60 $