So wird's ausgeführt: Aufnehmen von Daten in Fabric mithilfe der Azure Data Factory Copy-Aktivität

Der Microsoft Fabric Lakehouse-Connector in Azure Data Factory (ADF) und Azure Synapse Analytics ermöglicht sowohl Lese- als auch Schreibvorgänge in Microsoft Fabric Lakehouse (sowohl für Tabellen als auch Dateien). Dieser Connector bietet Ihnen die Möglichkeit, Ihre vorhandenen ADF- und Synapse-Pipelines und Zuordnungsdatenflüsse für die Interaktion mit Fabric Lakehouses zu verwenden. In diesem Artikel erfahren Sie, wie Sie Microsoft Fabric so konfigurieren, dass die Authentifizierung für Dienstprinzipale zulässig ist. Anschließend wird der Lakehouse Connector für das Lesen und Schreiben im Fabric Lakehouse demonstriert.

Weitere Informationen zu Microsoft Fabric Lakehouse finden Sie unter Was ist ein Seehaus?

Azure Data Factory Lakehouse Connector

Ein neuer mit Lakehouse verknüpfter Dienstconnector und zwei neue Datasets sind jetzt für Kunden verfügbar, die mit dem Lesen von und Schreiben in Microsoft Fabric Lakehouse beginnen möchten. Eine vollständige Anleitung zum Lakehouse Connector finden Sie unter Kopieren und Transformieren von Daten in Microsoft Fabric Lakehouse Files (Preview).

Authentifizierung

Verknüpfter Azure Data Factory-Dienst

Der Microsoft Fabric Lakehouse-Connector erfordert für die Authentifizierung eine Registrierung bei Dienstprinzipal (SPN)/App. Um zu beginnen, müssen Sie einen neuen SPN erstellen oder ein vorhandenes verwenden. Microsoft Fabric ermöglicht SPN-Zugriff auf bestimmte Sicherheitsgruppen oder für die gesamte Organisation. Wenn es sich bei einer bestimmten Sicherheitsgruppe um die Von Ihrer Organisation verwendete Option handelt, muss der im Lakehouse-Connector verwendete SPN zu einer Sicherheitsgruppe gehören, die der Zulassungsliste hinzugefügt wird.

Anmerkung

Power BI-API-Berechtigungen (Delegiert) sind nicht erforderlich.

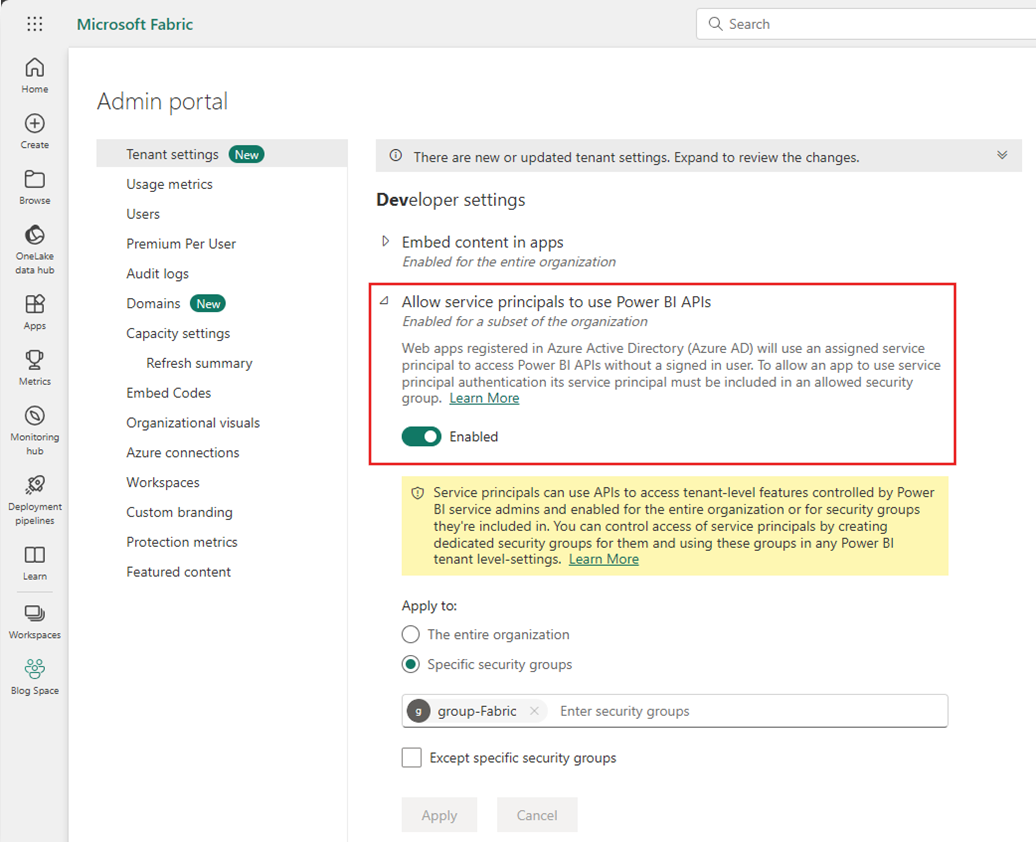

Zugriff auf Power BI-APIs

Über das Power BI-Verwaltungsportal muss der Power BI-Mandantenadministrator Dienstprinzipalen die Verwendung von Power BI-APIs gestatten aktivieren. Die Sicherheitsgruppe muss entweder in der Einstellung Dienstprinzipalen die Verwendung von Power BI-APIs gestatten angegeben werden, oder Sie aktivieren diese Einstellung für die gesamte Organisation.

Eine vollständige Anleitung finden Sie unter Einbettung von Power BI-Inhalten in eine eingebettete Analyseanwendung mit einem Dienstprinzipal und einem Anwendungsgeheimnis.

Anmerkung

Beim Zuweisen der Sicherheitsgruppe zum Arbeitsbereich kann es zu einer Verzögerung kommen, damit dem Dienstprinzipal der Zugriff auf den Arbeitsbereich aufgrund der Zwischenspeicherung von Berechtigungen in Azure gewährt wird. Wenn Sie sofortigen Zugriff benötigen, können Sie PowerShell verwenden, um eine Aktualisierung der Berechtigungen des Benutzers zu erzwingen. Öffnen Sie dazu PowerShell als Administrator, und führen Sie dann die folgenden Befehle aus:

Install-Module -Name MicrosoftPowerBIMgmt

Connect-PowerBIServiceAccount -Tenant '<TENANT ID>' -ServicePrincipal -Credential (Get-Credential)

Get-PowerBIWorkspace

Invoke-PowerBIRestMethod -URL 'https://api.powerbi.com/v1.0/myorg/RefreshUserPermissions' -Method Post -Body ''

Get-PowerBIWorkspace

Arbeitsbereichszugriff

Nach dem Hinzufügen der Sicherheitsgruppe müssen die Sicherheitsgruppe oder der Dienstprinzipal auch jedem Arbeitsbereich als Mitglied, Mitwirkender oder Administrator hinzugefügt werden. Weitere Informationen finden Sie unter Erteilen des Zugriffs auf Arbeitsbereiche für Benutzer.

Demo: Einrichten der Authentifizierung

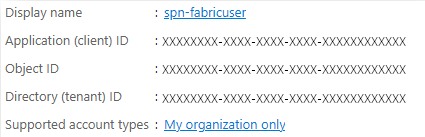

Dienstprinzipal der App-Registrierung

Erstellen oder Verwenden eines vorhandenen Dienstprinzipals der App-Registrierung (SPN). Befolgen Sie die Schritte in Registrieren einer Anwendung bei Microsoft Entra ID und Erstellen eines Dienstprinzipals.

Anmerkung

Sie müssen keinen Umleitungs-URI zuweisen.

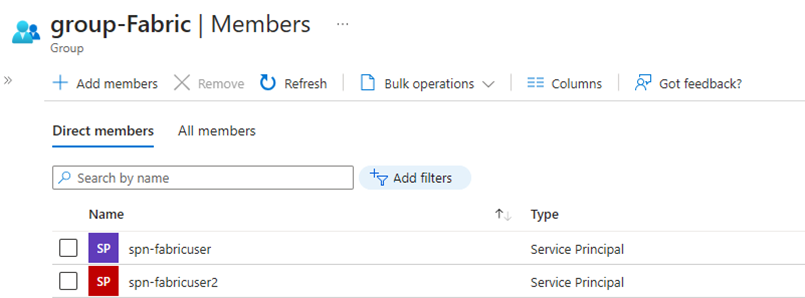

Sicherheitsgruppe

Erstellen Sie eine neue Microsoft Entra-Sicherheitsgruppe, oder verwenden Sie eine vorhandene, und fügen Sie dann den SPN hinzu. Führen Sie die Schritte in Erstellen einer einfachen Gruppe aus, und fügen Sie Mitglieder hinzu, um eine Microsoft Entra-Sicherheitsgruppe zu erstellen.

Power BI-Verwaltungsportal

Navigieren Sie im Power BI-Verwaltungsportal zu den Entwicklereinstellungen, wählen Sie Dienstprinzipalen die Verwendung von Power BI-APIs gestatten aus, und aktivieren Sie diese Option. Fügen Sie dann die Sicherheitsgruppe aus dem vorherigen Schritt hinzu. Weitere Informationen zu den Mandanteneinstellungen des Power BI-Verwaltungsportals finden Sie unter Mandanteneinstellungen.

Anmerkung

Stellen Sie sicher, dass die Einstellung aktiviert ist, wodurch Benutzer mit Apps außerhalb von Fabric auf die in OneLake gespeicherten Daten zugreifen können. Weitere Informationen finden Sie unter Zulassen, dass Apps, die außerhalb von Fabric ausgeführt werden, über OneLake auf Daten zugreifen können.

Arbeitsbereich

Fügen Sie den SPN oder die Dienstgruppe dem Arbeitsbereich mit der Zugriffsrolle Mitglied, Mitwirkender oder Administrator hinzu.

Azure Data Factory: Verknüpfter Dienst

Erstellen Sie in Azure Data Factoryeinen neuen verknüpften Dienst für Microsoft Fabric Lakehouse.

Anmerkung

Um den Arbeitsbereich und die Lakehouse-IDs zu finden, navigieren Sie zu Ihrem Fabric Lakehouse, und identifizieren Sie ihn über die URL. Beispiel: https://.../groups/<Workspace ID>>/lakehouses/<Lakehouse ID>

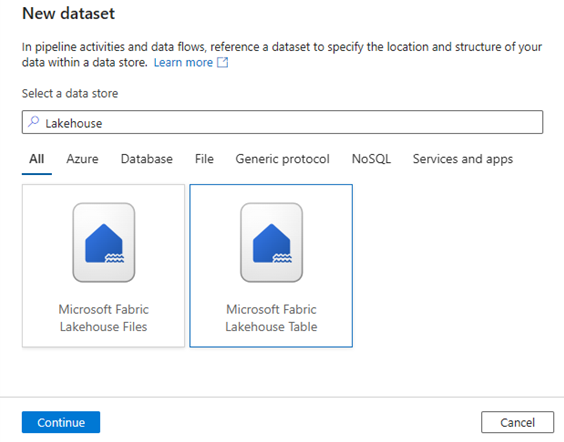

Azure Data Factory: Datensatz

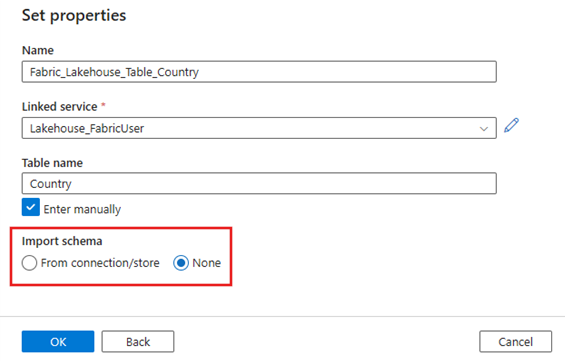

Erstellen Sie ein Dataset, das auf den verknüpften Microsoft Fabric Lakehouse-Dienst verweist.

Anmerkung

Wählen Sie Keine für die Option Schema importieren aus, wenn die Tabelle noch nicht vorhanden ist und Sie manuell einen neuen Tabellennamen angeben.

Demo: Schreiben in eine Fabric Lakehouse-Tabelle mit einer ADF-Pipeline

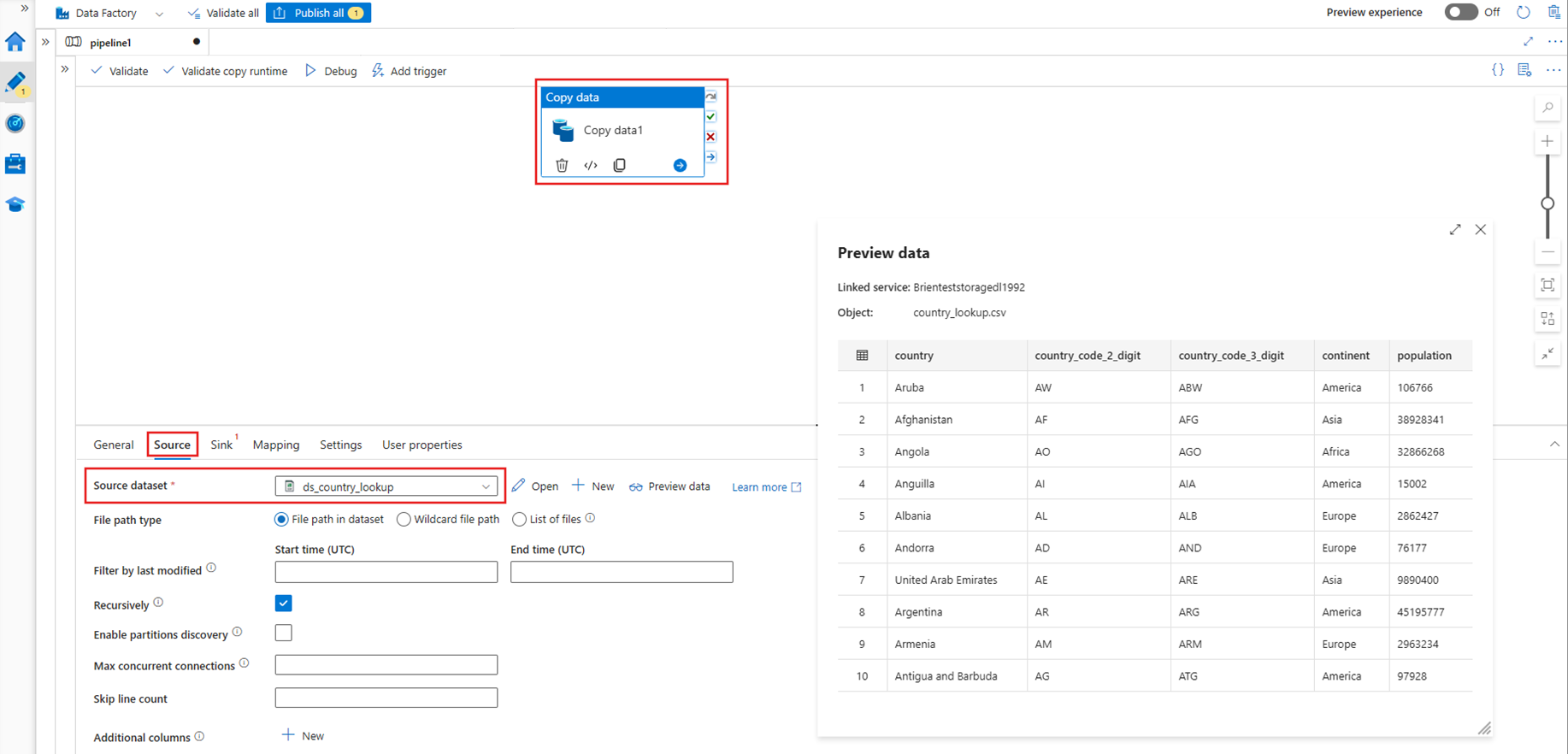

Quelle

Erstellen Sie eine neue Pipeline, und fügen Sie der Pipeline-Canvas eine Copy-Aktivität hinzu. Wählen Sie auf der Registerkarte Quelle der Aktivität "Kopieren" ein Quelldatenset aus, das Sie in eine Lakehouse-Tabelle verschieben möchten. In diesem Beispiel verweisen wir auf eine .csv-Datei aus einem Azure Data Lake Storage (ADLS)-Gen2-Konto.

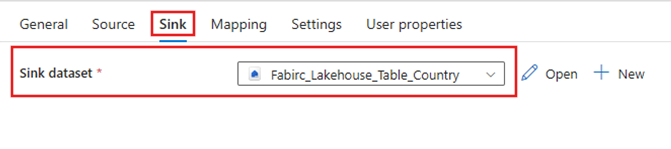

Spüle

Navigieren Sie zur Registerkarte Senke der Copy-Aktivität, und wählen Sie das zuvor erstellte Fabric Lakehouse-Dataset aus.

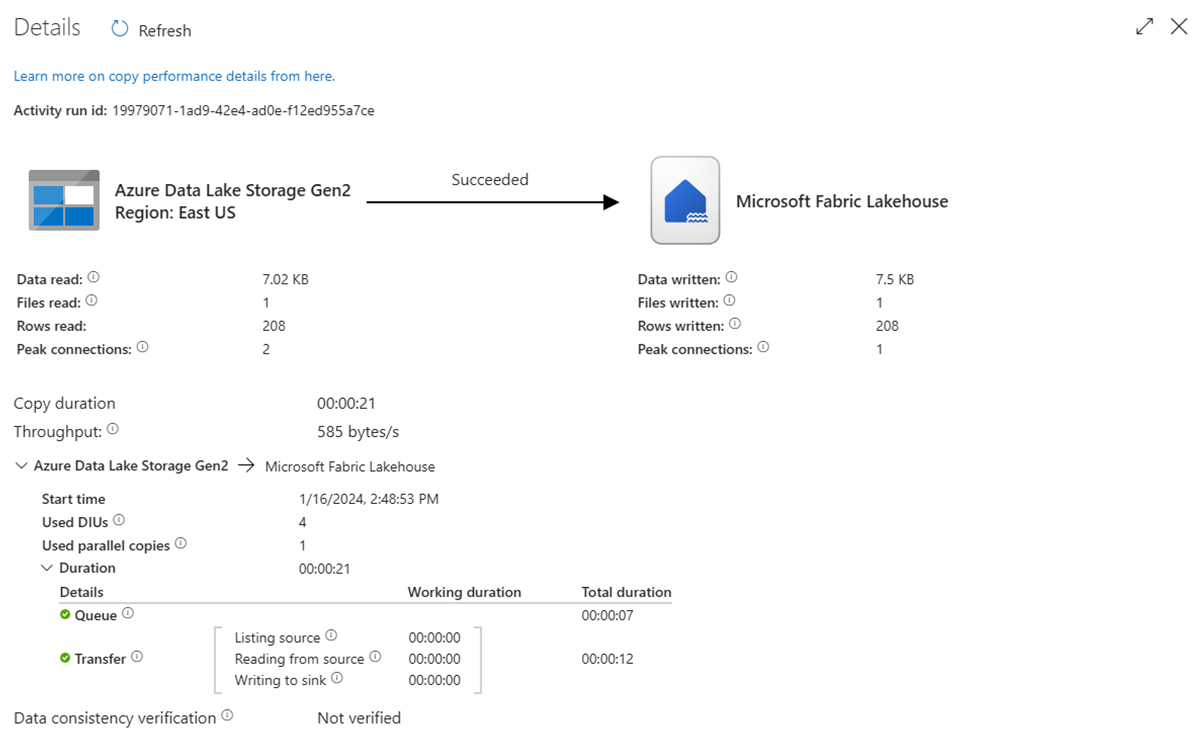

Führen Sie die Pipeline aus.

Führen Sie die Pipeline aus, um die CSV-Daten in die Fabric Lakehouse-Tabelle zu verschieben.

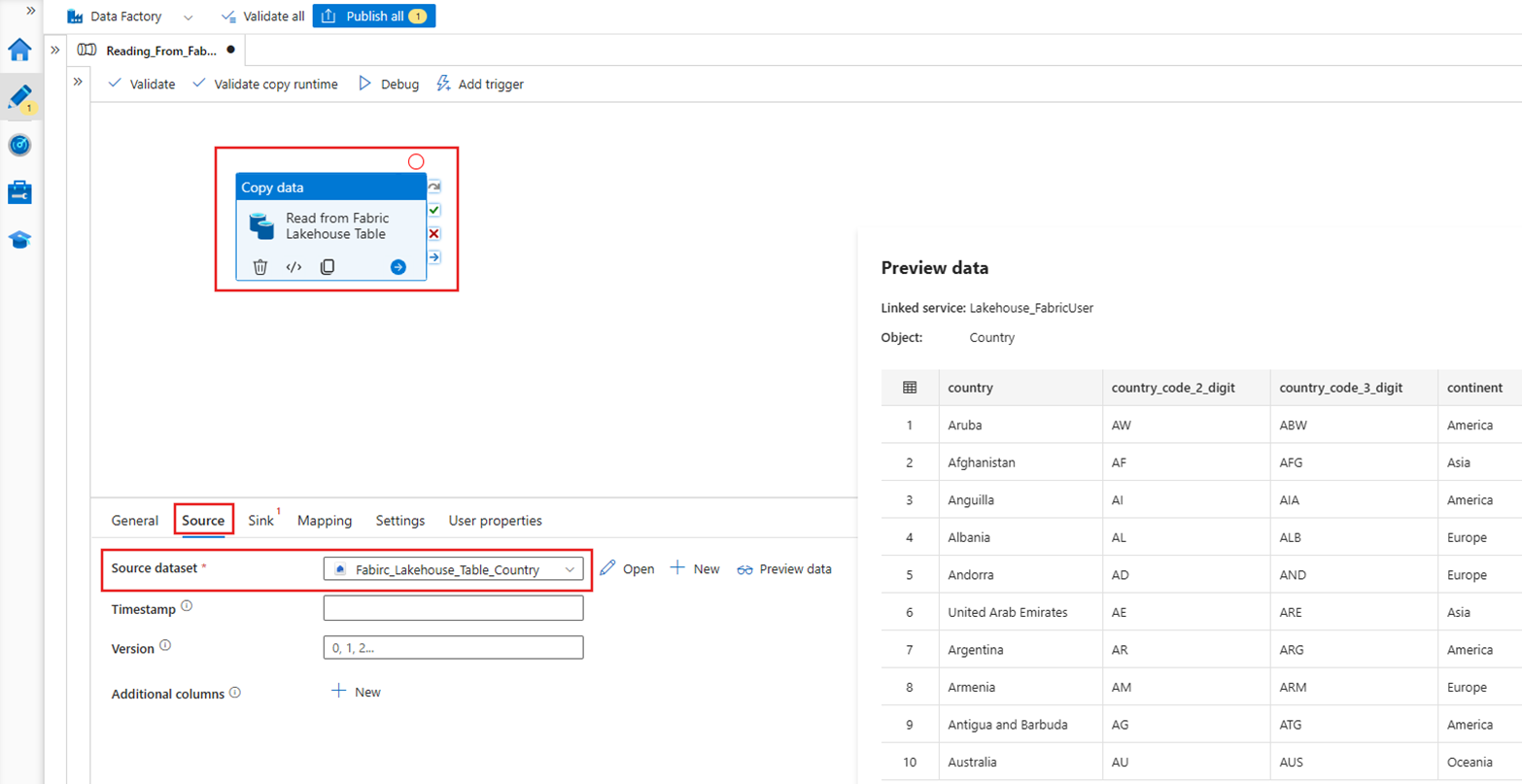

Demo: Lesen aus einer Fabric Lakehouse-Tabelle mit einer ADF-Pipeline

Im Abschnitt oben haben wir gezeigt, wie ADF zum Schreiben in eine Fabric Lakehouse-Tabelle verwendet wird. Jetzt lesen wir aus einer Fabric Lakehouse-Tabelle und schreiben in eine Parquet-Datei in Azure Data Lake Storage (ADLS) Gen2 mit einer ähnlichen Pipeline.

Quelle

Erstellen Sie eine neue Pipeline, und fügen Sie der Pipeline-Canvas eine Copy-Aktivität hinzu. Wählen Sie auf der Registerkarte Quelle der Kopieraktivität das Fabric Lakehouse-Dataset aus, das zuvor erstellt wurde.

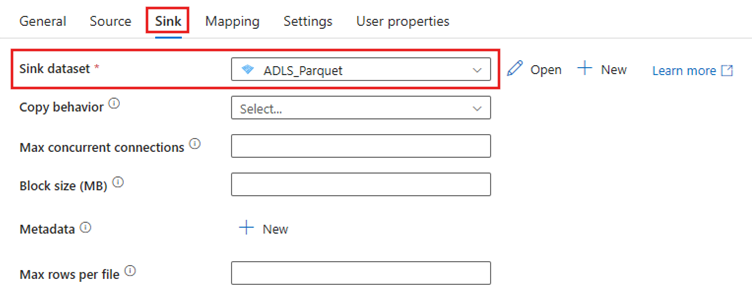

Spüle

Navigieren Sie zur Registerkarte Sink der Kopieraktivität, und wählen Sie den Zieldatensatz aus. In diesem Beispiel ist das Ziel Azure Data Lake Storage (Gen2) als Parquet-Datei.

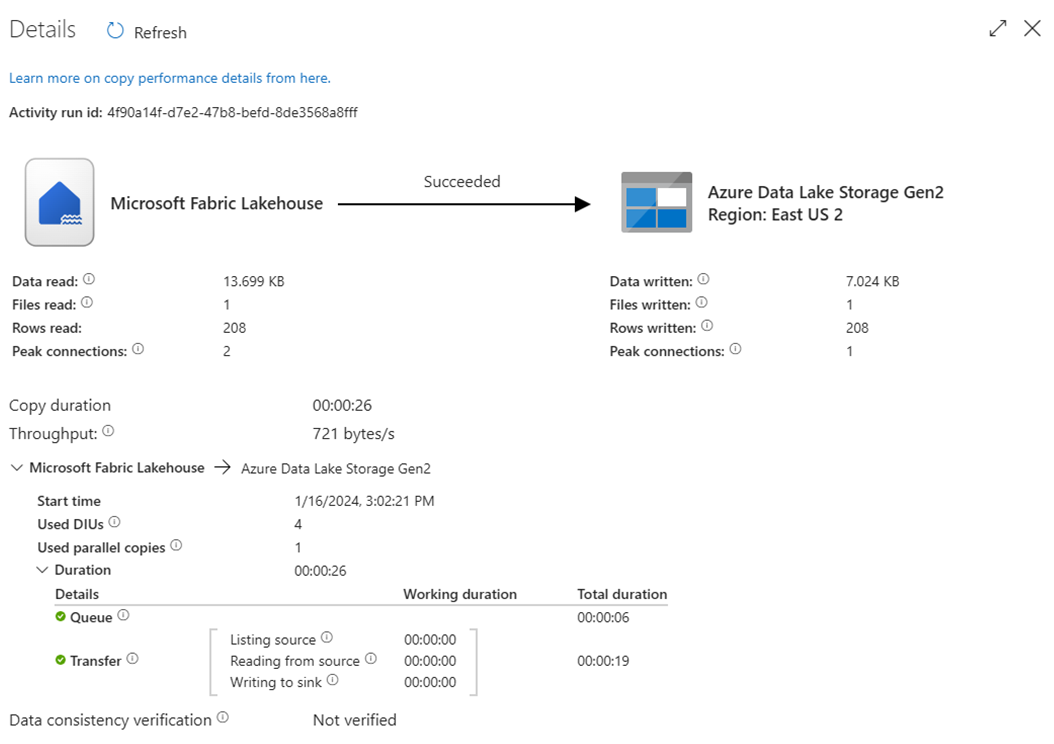

Führen Sie die Pipeline aus.

Führen Sie die Pipeline aus, um die Daten aus der Fabric Lakehouse-Tabelle in die Parquet-Datei in ADLS Gen2 zu verschieben.

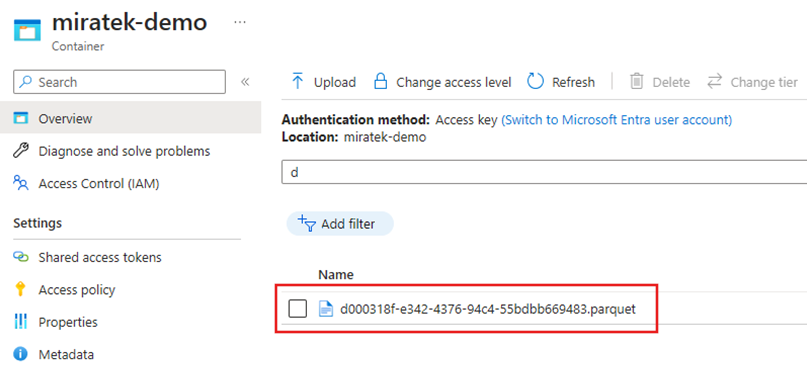

Überprüfen der Parquet-Datei in ADLS Gen2

Die Daten aus der Fabric Lakehouse-Tabelle sind jetzt in ADLS Gen2 als Parquet-Datei verfügbar.

Zusammenfassung

In diesem Abschnitt haben wir die Anforderungen für den Lakehouse-Connector mithilfe der Dienstprinzipalauthentifizierung für ein Microsoft Fabric Lakehouse untersucht und dann ein Beispiel zum Lesen und Schreiben in das Lakehouse über eine Azure Data Factory-Pipeline durchlaufen. Dieser Connector und diese Funktionen sind auch in Azure Data Factory Mapping Data Flows, Azure Synapse Analytics und Azure Synapse Analytics Mapping Data Flows verfügbar.