Zugreifen auf lokale Datenquellen in Data Factory für Microsoft Fabric

Data Factory für Microsoft Fabric ist ein leistungsstarker cloudbasierter Datenintegrationsdienst, mit dem Sie Workflows für verschiedene Datenquellen erstellen, planen und verwalten können. Für Szenarien, in denen sich Ihre Datenquellen vor Ort befinden, bietet Microsoft das lokale Datengateway, um die Lücke zwischen Ihrer lokalen Umgebung und der Cloud sicher zu schließen. Dieses Dokument führt Sie durch den Prozess des Zugriffs auf lokale Datenquellen in Data Factory für Microsoft Fabric mithilfe des lokalen Datengateways.

Erstellen eines lokalen Datengateways

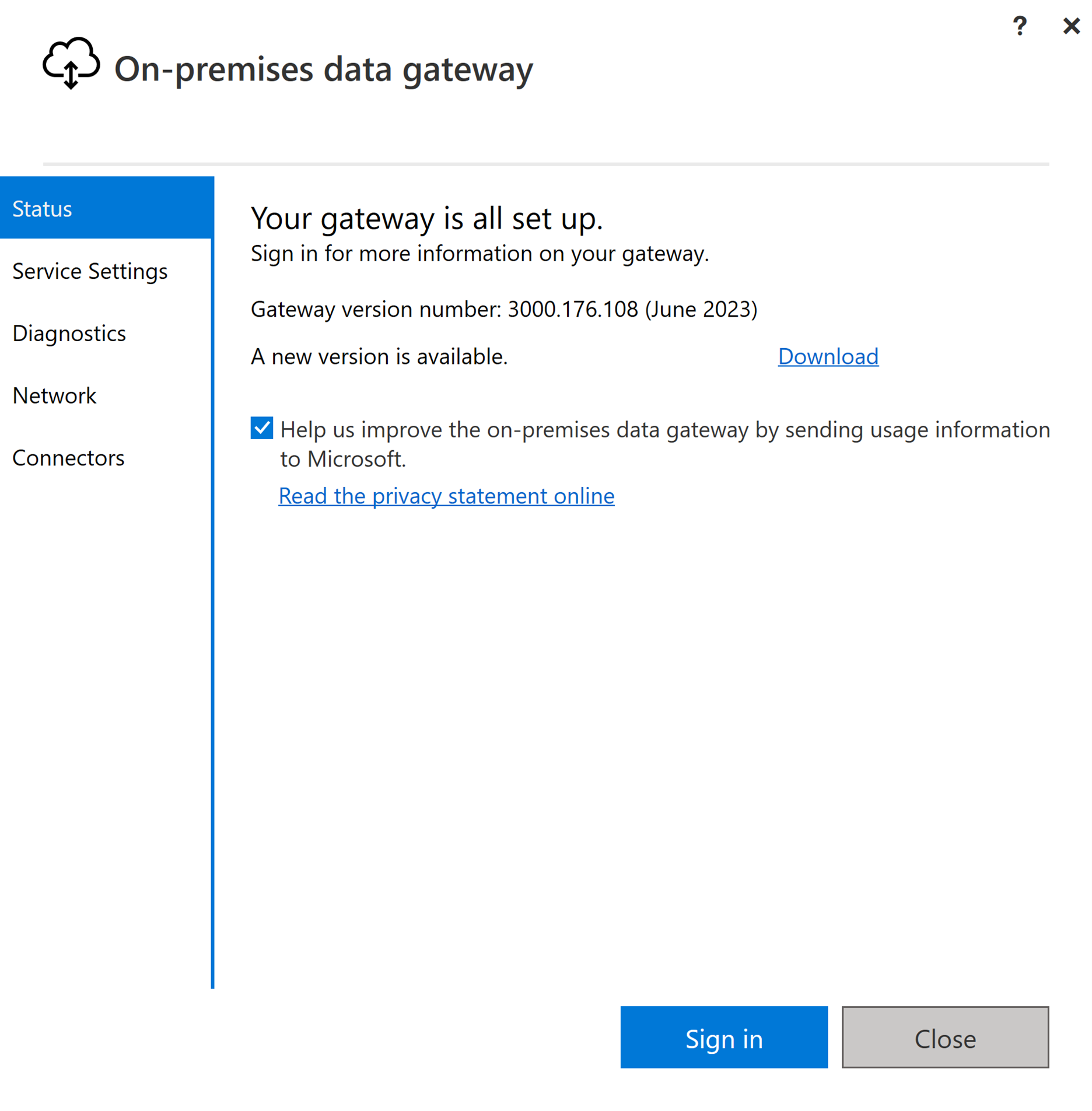

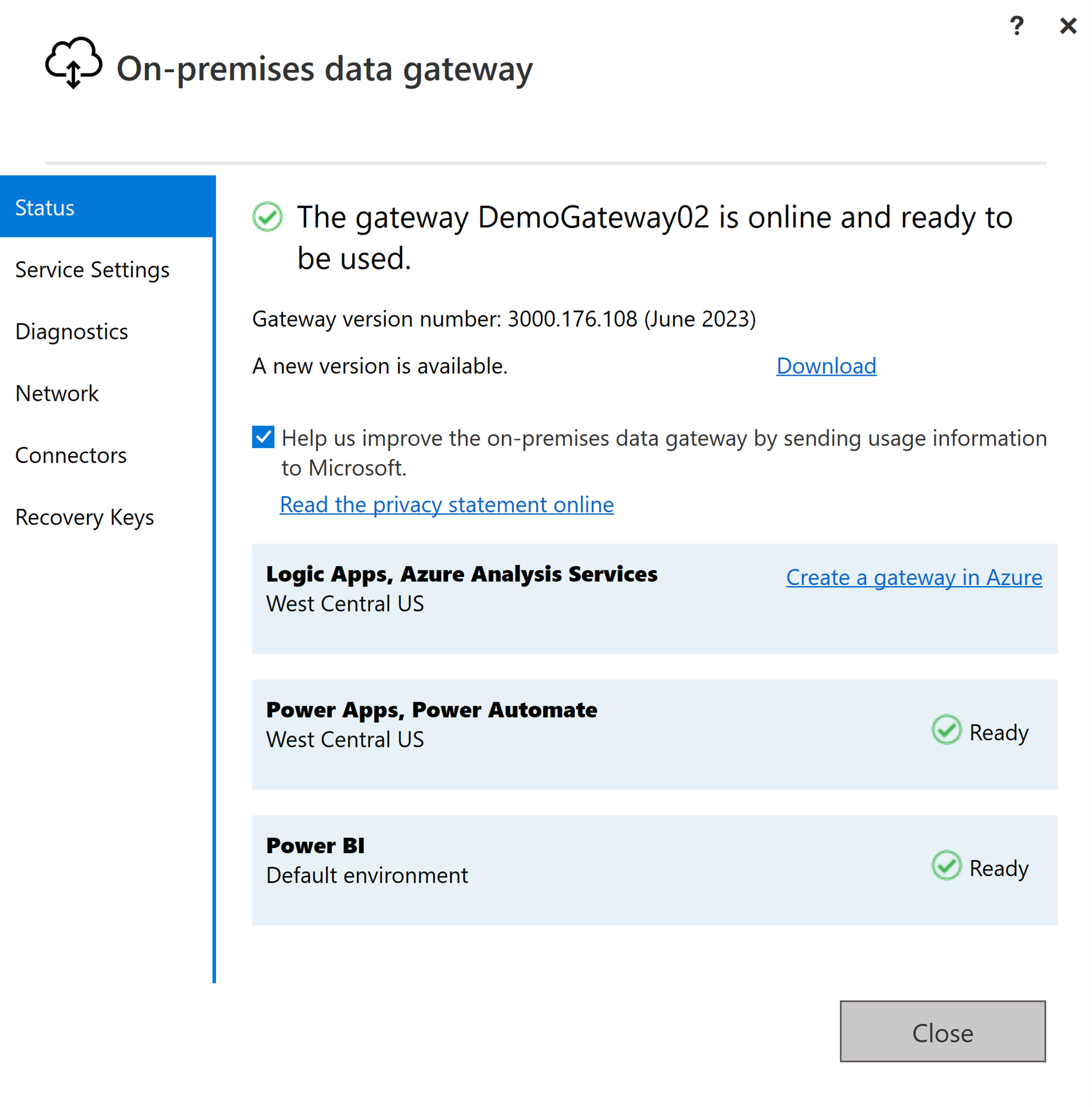

Ein lokales Datengateway ist eine Softwareanwendung, die in einer lokalen Netzwerkumgebung installiert werden soll. Es bietet eine Möglichkeit, das Gateway direkt auf Ihrem lokalen Computer zu installieren. Ausführliche Anweisungen zum Herunterladen und Installieren des lokalen Datengateways finden Sie unter Installieren eines lokalen Datengateways.

Melden Sie sich mit Ihrem Benutzerkonto an, um auf das lokale Datengateway zuzugreifen, danach wird es für die Nutzung vorbereitet.

Hinweis

Für die Unterstützung von Fabric-Pipelines ist ein lokales Datengateway der Version 3000.214.2 oder höher erforderlich.

Erstellen einer Verbindung für Ihre lokale Datenquelle

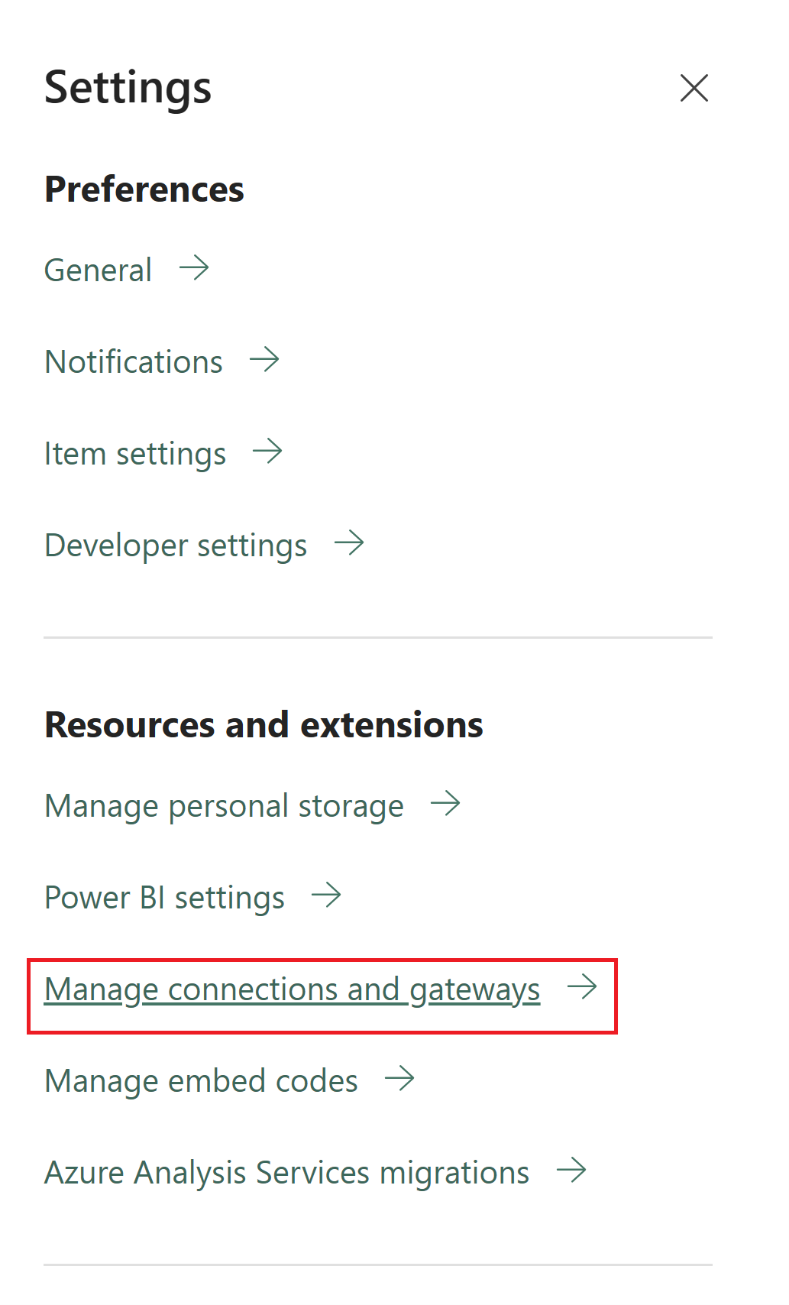

Navigieren Sie zum Admin-Portal, und wählen Sie die Schaltfläche „Einstellungen“ (ein Symbol, das wie ein Zahnrad aussieht) oben rechts auf der Seite aus. Wählen Sie dann im angezeigten Dropdownmenü Verbindungen und Gateways verwalten aus.

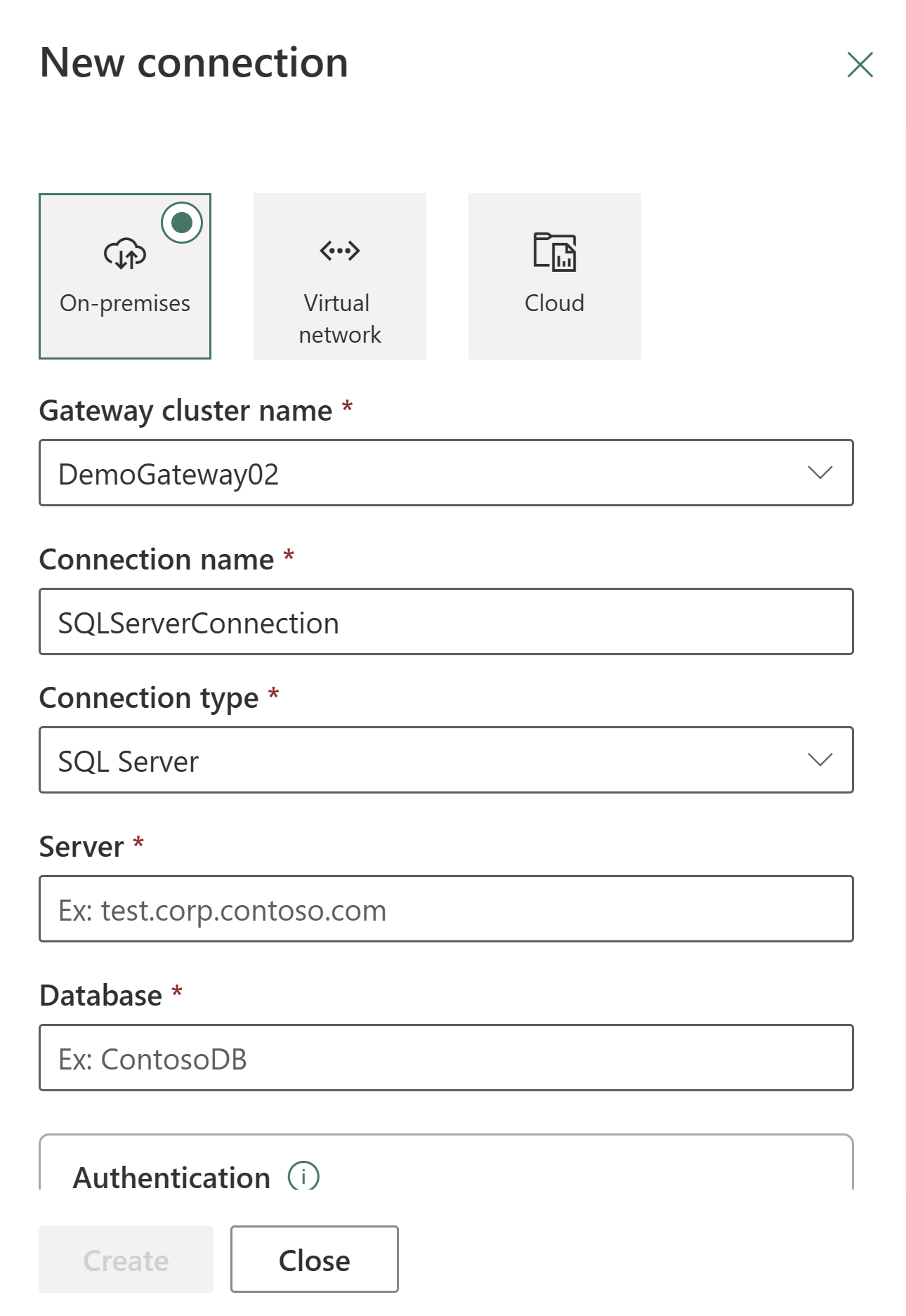

Wählen Sie im daraufhin angezeigten Dialogfeld Neue VerbindungLokal aus, und geben Sie dann Ihren Gatewaycluster zusammen mit dem zugeordneten Ressourcentyp und den relevanten Informationen an.

Zu den verfügbaren Verbindungstypen, die für Verbindungen vor Ort unterstützt werden, gehören:

- Entra-ID

- Adobe Analytics

- Analysis Services

- Azure Blob Storage

- Azure Data Lake Storage Gen2

- Azure Table Storage

- Essbase

- Datei

- Ordner

- Google Analytics

- IBM DB2

- MySQL

- OData

- ODBC

- OLE DB

- Oracle

- PostgreSQL

- Salesforce

- SAP Business Warehouse-Nachrichtenserver

- SAP Business Warehouse-Server

- SAP HANA

- SharePoint

- SQL Server

- Sybase

- Teradata

- Web

Eine umfassende Liste der Connectors, die für lokale Datentypen unterstützt werden, finden Sie unter Daten-Pipeline-Connectors in Microsoft Fabric.

Verbinden Ihrer lokalen Datenquelle mit einem Dataflow Gen2 in Data Factory für Microsoft Fabric

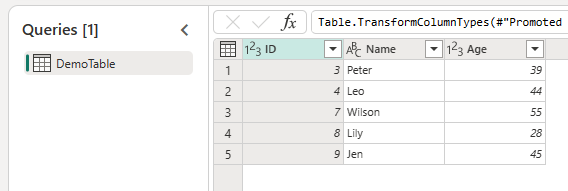

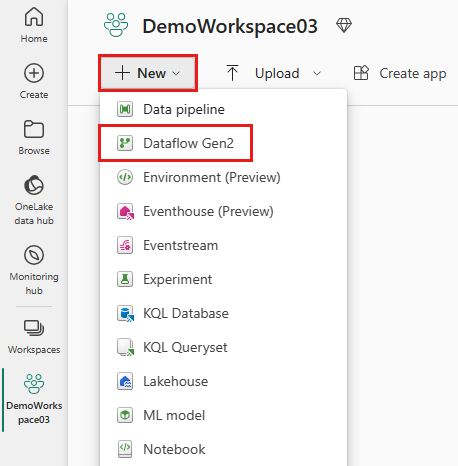

Wechseln Sie zu Ihrem Arbeitsbereich, und erstellen Sie einen Dataflow Gen2.

Fügen Sie dem Dataflow eine neue Quelle hinzu, und wählen Sie die im vorherigen Schritt erstellte Verbindung aus.

Sie können den Dataflow Gen2 verwenden, um alle erforderlichen Datentransformationen basierend auf Ihren Anforderungen durchzuführen.

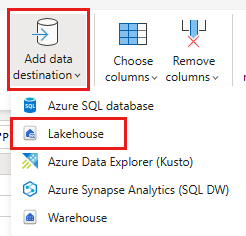

Verwenden Sie die Schaltfläche Datenziel hinzufügen auf der Registerkarte Start des Power Query-Editors, um ein Ziel für Ihre Daten aus der lokalen Quelle hinzuzufügen.

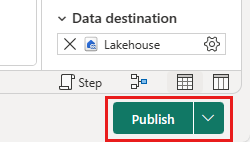

Veröffentlichen Sie den Dataflow Gen2.

Sie haben jetzt einen Dataflow Gen2 erstellt, um Daten aus einer lokalen Datenquelle in ein Cloudziel zu laden.

Verwenden lokaler Daten in einer Pipeline

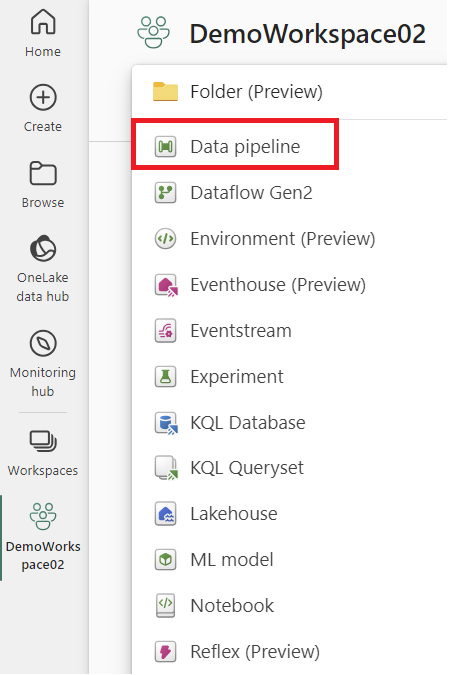

Wechseln Sie zu Ihrem Arbeitsbereich, und erstellen Sie eine Daten-Pipeline.

Hinweis

Sie müssen die Firewall so konfigurieren, dass ausgehende Verbindungen *.frontend.clouddatahub.net vom Gateway für Fabric-Pipeline-Funktionalitäten zugelassen werden.

Wählen Sie auf der Registerkarte Start des Pipeline-Editors die Option Daten kopieren und dann Kopierassistent verwenden aus. Fügen Sie der Aktivität auf der Seite Datenquelle auswählen des Assistenten eine neue Quelle hinzu und wählen Sie dann die im vorherigen Schritt erstellte Verbindung aus.

Wählen Sie ein Ziel für Ihre Daten aus der lokalen Datenquelle aus.

Ausführen der Pipeline.

Jetzt haben Sie eine Pipeline zum Laden von Daten aus einer lokalen Datenquelle in ein Cloud-Ziel erstellt und ausgeführt.

Hinweis

Lokaler Zugriff auf den Computer, auf dem das On-Premises-Datengateway installiert ist, ist in Datenpipelines nicht zulässig.