Schritt 4. Bewerten der Proof of Concept-Qualität

Den Beispielcode aus diesem Abschnitt finden Sie in diesem GitHub-Repository.

Erwartete Zeit: 5 bis 60 Minuten Die Zeit variiert je nach Anzahl der Fragen in Ihrem Auswertungssatz. Bei 100 Fragen dauert die Auswertung ca. 5 Minuten.

Übersicht und erwartetes Ergebnis

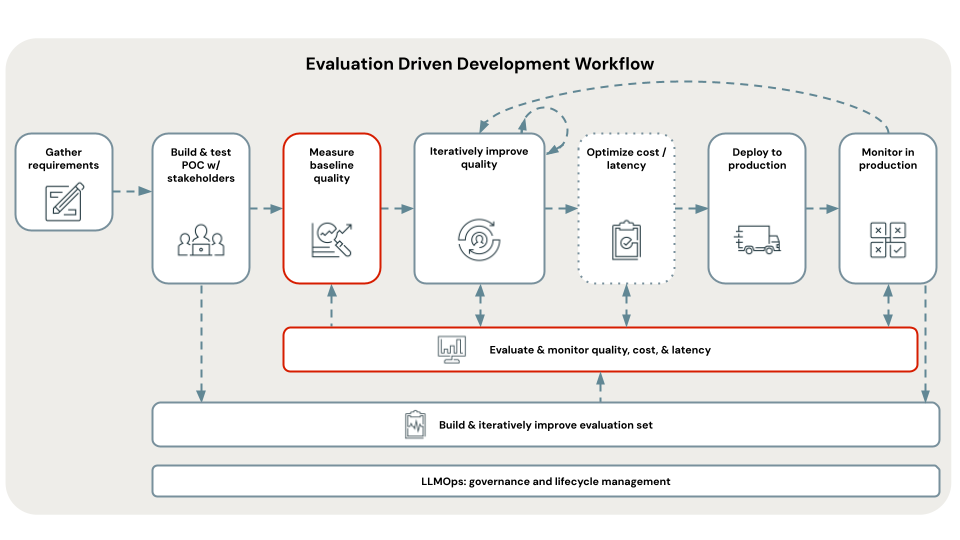

In diesem Schritt wird der soeben kuratierte Auswertungssatz verwendet, um Ihre Proof of Concept-App auszuwerten und die Baselinequalität, -kosten und -wartezeit festzulegen. Die Auswertungsergebnisse werden im nächsten Schritt verwendet, um die Grundursache von Qualitätsproblemen zu identifizieren.

Die Auswertung erfolgt mithilfe von Mosaic AI Agent Evaluation und untersucht umfassend alle Aspekte der Qualität, Kosten und Wartezeit, die im Abschnitt Metriken dieses Cookbooks beschrieben sind.

Die aggregierten Metriken und die Auswertung der einzelnen Fragen im Auswertungssatz werden in MLflow protokolliert. Ausführliche Informationen finden Sie unter Auswertungsausgaben.

Anforderungen

- Der Auswertungssatz ist verfügbar.

- Alle Anforderungen der vorherigen Schritte.

Anweisungen

- Öffnen Sie das Notebook

05_evaluate_poc_qualityin Ihrem ausgewählten Proof of Concept-Verzeichnis, und klicken Sie auf Alle ausführen. - Überprüfen Sie die Ergebnisse der Auswertung im Notebook oder mithilfe von MLflow. Wenn die Ergebnisse Ihren Qualitätsanforderungen entsprechen, können Sie direkt mit [Bereitstellen und Überwachen] fortfahren. Da die Proof of Concept-Anwendung auf Databricks basiert, kann sie in einer skalierbaren, produktionsfähigen REST-API bereitgestellt werden.

Nächster Schritt

Anhand dieser Basselinebewertung der Proof of Concept-Qualität können Sie die Grundursachen für Qualitätsprobleme identifizieren und diese Probleme iterativ beheben, um die App zu verbessern. Weitere Informationen finden Sie unter Schritt 5. Identifizieren der Grundursache von Qualitätsproblemen.