Einholen von Feedback zur Qualität einer Agentanwendung

Wichtig

Dieses Feature befindet sich in der Public Preview.

In diesem Artikel erfahren Sie, wie Sie mit der Databricks-Rezensions-App Feedback von menschlichen Prüfern zur Qualität Ihrer Agentanwendung sammeln können. Er umfasst Folgendes:

- Vorgehensweise zum Bereitstellen der Rezensions-App.

- Einsatz der App durch Prüfer zum Abgeben von Feedback zu den Antworten der Agentanwendung.

- Vorgehensweise von Experten zum Prüfen protokollierter Chats zwecks Verbesserungsvorschlägen und sonstigem Feedback über die App.

Was geschieht in einer menschlichen Auswertung?

Die Databricks-Überprüfungs-App stellt die LLM in einer Umgebung bereit, in der expertenbeteiligte Personen damit interagieren können – mit anderen Worten: Unterhaltungen führen, Fragen stellen, Feedback geben usw. Die Rezensions-App protokolliert alle Fragen, Antworten und das Feedback in einer Rückschlusstabelle, sodass Sie die Leistung des LLM weiter analysieren können. Auf diese Weise trägt die Prüf-App dazu bei, die Qualität und Sicherheit der Antworten zu gewährleisten, die Ihre Anwendung bereitstellt.

Stakeholder können mit dem Anwendungsbot chatten und Feedback zu diesen Unterhaltungen abgeben oder Feedback zu historischen Protokollen, kuratierten Ablaufverfolgungen oder Agent-Ausgaben abgeben.

Anforderungen

Rückschlusstabellen müssen auf dem Endpunkt aktiviert werden, der den Agent bedient.

Jeder menschliche Prüfer muss Zugriff auf den Arbeitsbereich der Rezensions-App haben oder mit Ihrem Databricks-Konto mit SCIM synchronisiert werden. Weitere Informationen finden Sie im nächsten Abschnitt: Einrichten von Berechtigungen für die Verwendung der Rezensions-App.

Entwickler müssen das

databricks-agents-SDK installieren, um Berechtigungen einzurichten und die Bewertungs-App zu konfigurieren.%pip install databricks-agents dbutils.library.restartPython()

Einrichten von Berechtigungen für die Verwendung der Rezensions-App

Hinweis

Menschliche Prüfer benötigen keinen Zugriff auf den Arbeitsbereich, um die Rezensions-App zu verwenden.

Sie können allen Benutzern in Ihrem Databricks-Konto Zugriff auf die Rezensions-App gewähren, auch wenn sie keinen Zugriff auf den Arbeitsbereich haben, der die Rezensions-App enthält.

- Für Benutzer, die keinen Zugriff auf den Arbeitsbereich haben, verwendet ein Kontoadministrator die SCIM-Bereitstellung auf Kontoebene, um Benutzer und Gruppen automatisch von Ihrem Identitätsanbieter mit Ihrem Azure Databricks-Konto zu synchronisieren. Sie können diese Benutzer und Gruppen auch manuell registrieren, um ihnen Zugriff zu gewähren, wenn Sie Identitäten in Databricks einrichten. Weitere Informationen finden Sie unter Synchronisieren von Benutzenden und Gruppen über Microsoft Entra ID mithilfe von SCIM.

- Für Benutzer, die bereits Zugriff auf den Arbeitsbereich haben, der die Rezensions-App enthält, ist keine zusätzliche Konfiguration erforderlich.

Das folgende Codebeispiel zeigt, wie Sie Benutzern die Berechtigung für die Überprüfungs-App für einen Agent erteilen. Der users Parameter akzeptiert eine Liste von E-Mail-Adressen.

from databricks import agents

# Note that <user_list> can specify individual users or groups.

agents.set_permissions(model_name=<model_name>, users=[<user_list>], permission_level=agents.PermissionLevel.CAN_QUERY)

Um ein Chatprotokoll zu überprüfen, muss ein Benutzer über die CAN_REVIEW Berechtigung verfügen.

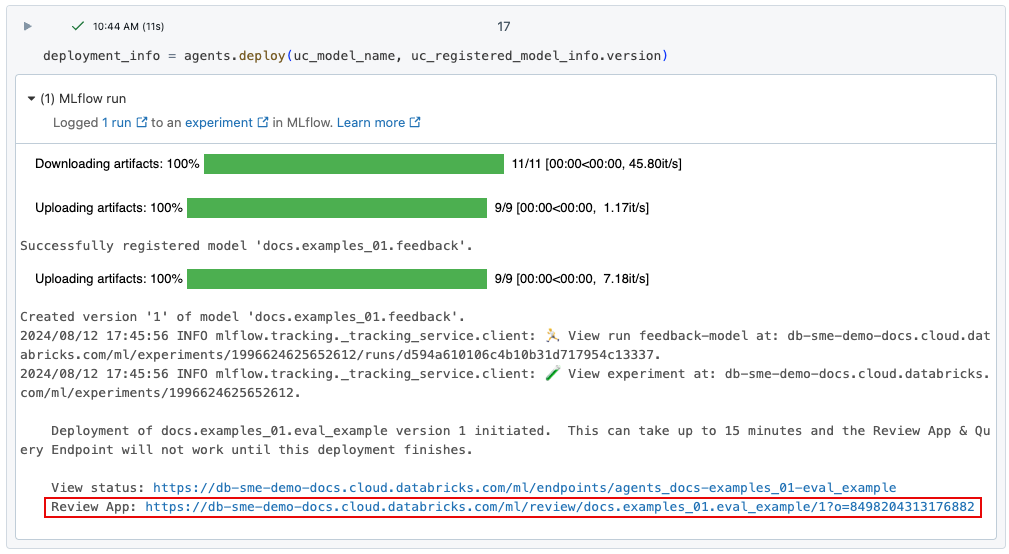

Bereitstellen der Rezensions-App

Wenn Sie einen Agent über agents.deploy() bereitstellen, wird die Rezensions-App automatisch aktiviert und bereitgestellt. Die Ausgabe des Befehls zeigt die URL für die Rezensions-App. Weitere Informationen zum Bereitstellen eines Agents finden Sie unter Bereitstellen eines Agents für generative KI-Anwendungen.

Falls der Link zur Bereitstellung verlorengehen sollte, können Sie ihn über list_deployments() finden.

from databricks import agents

deployments = agents.list_deployments()

deployments

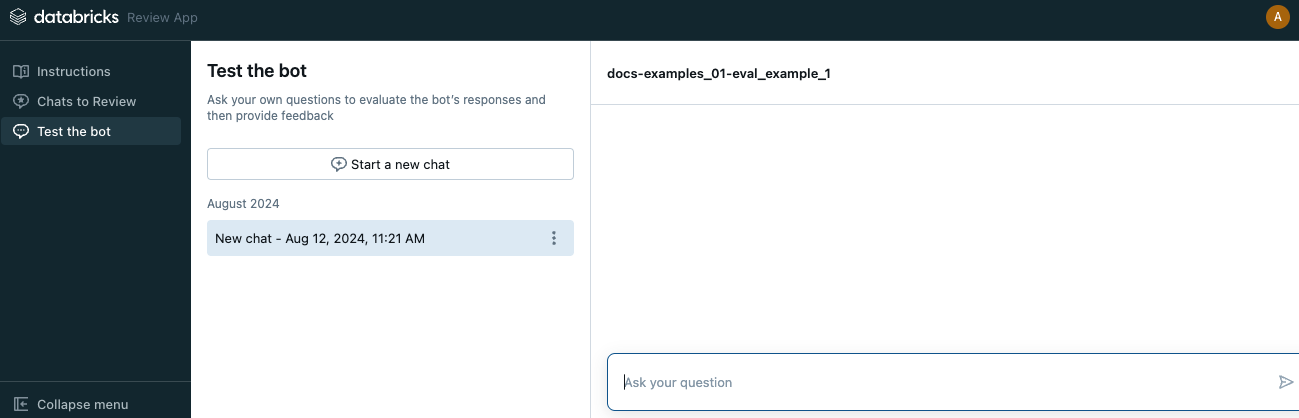

Benutzeroberfläche der Rezensions-App

Klicken Sie zum Öffnen der Rezensions-App auf die angegebene URL. Die Benutzeroberfläche der Rezensions-App verfügt über drei Registerkarten in der linken Randleiste:

- Anweisungen Zeigt Anweisungen für den Prüfer an. Siehe Bereitstellen von Anweisungen für Prüfer.

- Zu bewertende Chats Zeigt Protokolle der Interaktionen von Prüfern mit der App an, die von Experten auszuwerten sind. Siehe Bewertung von Protokollen der Interaktionen anderer Benutzer mit der App durch Experten.

- Bot testen Hier können Prüfer mit der App chatten und Bewertungen seiner Antworten abgeben. Siehe Chatten mit der App und Abgeben von Bewertungen.

Wenn Sie die Rezensions-App öffnen, wird die Seite mit den Anweisungen angezeigt.

- Klicken Sie zum Chatten mit dem Bot auf Bewertung starten oder wählen Sie in der linken Randleiste Bot testen aus. Weitere Details finden Sie unter Chatten mit der App und Abgeben von Bewertungen.

- Wählen Sie zum Bewerten von Chatprotokollen, die Ihnen zur Bewertung zur Verfügung gestellt wurden, in der Randleiste Zu bewertende Chats aus. Ausführliche Informationen finden Sie unter Bewertung von Protokollen der Interaktionen anderer Benutzer mit der App durch Experten. Informationen darüber, wie Chatprotokolle aus der Rezensions-App verfügbar gemacht werden, finden Sie unter Verfügbarmachen von Chatprotokollen zur Bewertung durch Experten.

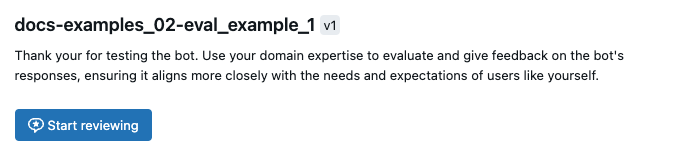

Bereitstellen von Anweisungen für Prüfer

Verwenden Sie zum Bereitstellen benutzerdefinierter Texte für die den Prüfern angezeigten Anweisungen den folgenden Code:

from databricks import agents

agents.set_review_instructions(uc_model_name, "Thank you for testing the bot. Use your domain expertise to evaluate and give feedback on the bot's responses, ensuring it aligns with the needs and expectations of users like yourself.")

agents.get_review_instructions(uc_model_name)

Chatten mit der App und Abgeben von Bewertungen

Gehen Sie zum Chatten mit der App und Abgeben von Bewertungen folgendermaßen vor:

Klicken Sie in der linken Randleiste auf Bot testen.

Geben Sie Ihre Frage in das Feld ein und drücken Sie die Returntaste oder Eingabetaste oder klicken Sie auf den Pfeil im Feld.

Die App zeigt ihre Antwort auf Ihre Frage an sowie die Quellen, anhand derer sie die Antwort gefunden hat.

Hinweis

Wenn der Agent einen Retriever verwendet, werden Datenquellen durch das

doc_uriFeld identifiziert, das vom Retriever-Schema festgelegt wurde, das während der Agenterstellung definiert wurde. Weitere Informationen finden Sie unter Festlegen des Abruferschemas.Bewerten Sie die Antwort der App und wählen Sie Ja, Nein oder Ich weiß nicht aus.

Die App fragt nach weiteren Informationen. Markieren Sie die entsprechenden Felder oder geben Sie Ihre Kommentare in das dafür vorgesehene Feld ein.

Sie können die Antwort auch direkt bearbeiten, um die Antwort zu verbessern. Klicken Sie zum Bearbeiten der Antwort auf Antwort bearbeiten, nehmen Sie ihre Änderungen im Dialog vor und klicken Sie auf Speichern, wie im folgenden Video gezeigt.

Klicken Sie auf Fertig, um Ihr Feedback zu speichern.

Stellen Sie weiter Fragen, um mehr Feedback abzugeben.

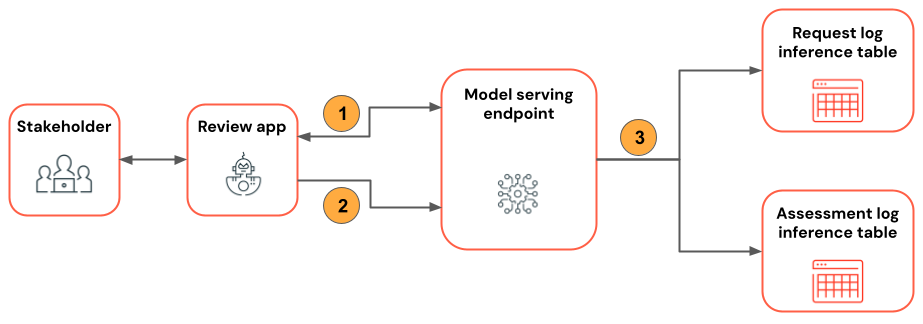

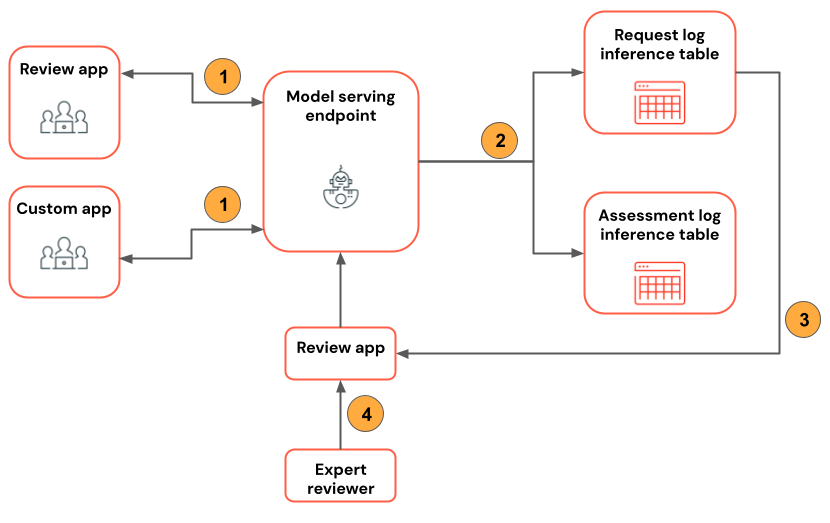

Dieser Workflow wird im folgenden Diagramm veranschaulicht.

- Über die Rezensions-App chattet der Prüfer mit der Agentanwendung.

- Über die Rezensions-App gibt der Prüfer Feedback zu den Antworten der Anwendung ab.

- Alle Anforderungen, Antworten und das Feedback werden in Rückschlusstabellen protokolliert.

Verfügbarmachen von Chatprotokollen zur Bewertung durch Experten

Wenn ein Benutzer über die REST-API oder die Rezensions-App mit einer App interagiert, werden alle Anforderungen, Antworten und zusätzliches Feedback in Rückschlusstabellen gespeichert. Die Rückschlusstabellen befinden sich im selben Unity Catalog-Katalog und -Schema, in dem das Modell registriert wurde, und haben die Namen <model_name>_payload, <model_name>_payload_assessment_logs und <model_name>_payload_request_logs. Weitere Informationen zu diesen Tabellen, einschließlich der Schemas, finden Sie unter Agent-erweiterte Rückschlusstabellen.

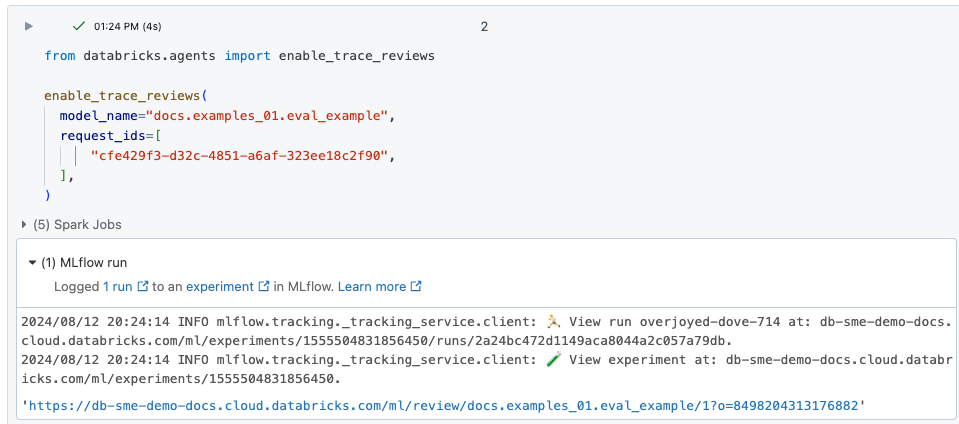

Zum Hochladen dieser Protokolle in die Rezensions-App für die Bewertung durch Experten müssen Sie zuerst die request_id finden und die Bewertung für diese request_id wie folgt aktivieren:

Suchen Sie die zu bewertenden

request_idin der Rückschlusstabelle<model_name>_payload_request_logs. Die Rückschlusstabelle befindet sich im selben Unity Catalog-Katalog und -Schema, in dem das Modell registriert wurde.Verwenden Sie Code der folgenden Art, um die zu bewertenden Protokolle in die Rezensions-App zu laden:

from databricks import agents agents.enable_trace_reviews( model_name=model_fqn, request_ids=[ "52ee973e-0689-4db1-bd05-90d60f94e79f", "1b203587-7333-4721-b0d5-bba161e4643a", "e68451f4-8e7b-4bfc-998e-4bda66992809", ], )Die Ergebniszelle enthält einen Link zur Rezensions-App mit den ausgewählten und zur Bewertung hochgeladenen Protokollen.

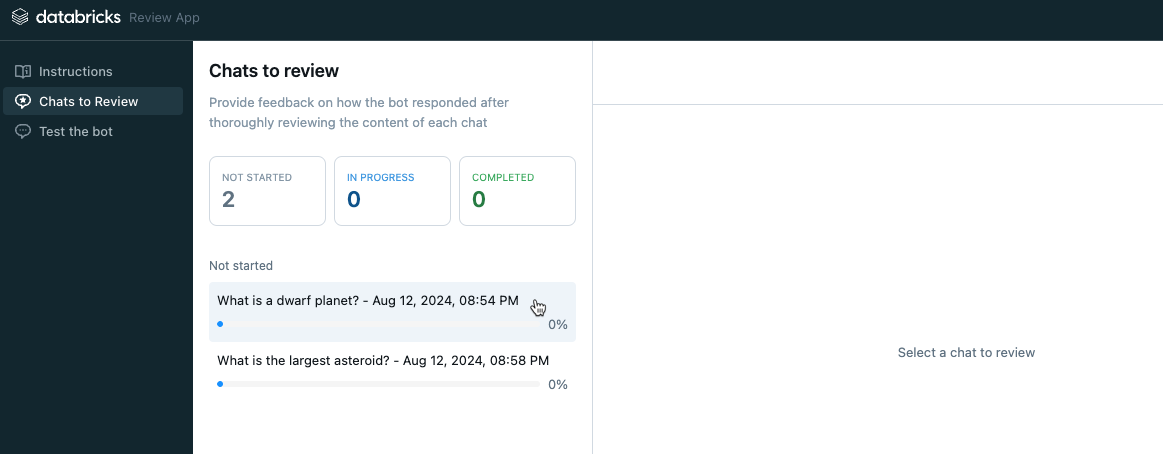

Bewertung von Protokollen der Interaktionen anderer Benutzer mit der App durch Experten

Damit Protokolle vorangehender Chats bewertet werden können, müssen die Protokolle zur Bewertung aktiviert sein. Siehe Verfügbarmachen von Chatprotokollen zur Bewertung durch Experten.

Wählen Sie in der linken Randleiste der Rezensions-App Zu bewertende Chats aus. Die aktivierten Anforderungen werden angezeigt.

Klicken Sie auf eine Anforderung, damit Sie zur Bewertung angezeigt wird.

Bewerten Sie die Anforderung und die Antwort. Die App zeigt auch die als Referenz herangezogenen Quellen an. Sie können sie anklicken, um die Referenz zu bewerten und Feedback zur Relevanz der Quelle abzugeben.

Wählen Sie zum Abgeben von Feedback zur Qualität der Antwort Ja, Nein oder ich weiß nicht aus.

Die App fragt nach weiteren Informationen. Markieren Sie die entsprechenden Felder oder geben Sie Ihre Kommentare in das dafür vorgesehene Feld ein.

Sie können die Antwort auch direkt bearbeiten, um die Antwort zu verbessern. Klicken Sie zum Bearbeiten der Antwort auf Antwort bearbeiten, nehmen Sie ihre Änderungen im Dialog vor und klicken Sie auf Speichern. Unter Chatten mit der App und Abgeben von Bewertungen finden Sie ein Video, in dem die Vorgehensweise dargestellt wird.

Klicken Sie auf Fertig, um Ihr Feedback zu speichern.

Dieser Workflow wird im folgenden Diagramm veranschaulicht.

- Über die Rezensions-App oder eine benutzerdefinierte App chatten Prüfer mit der Agentanwendung.

- Alle Anforderungen und Antworten werden in Rückschlusstabellen protokolliert.

- Anwendungsentwickler können über

enable_trace_reviews([request_id])(wobeirequest_idaus der<model_name>_payload_request_logsRückschlusstabelle stammt) Chatprotokolle zur Bewertung der App posten. - Über die Rezensions-App bewertet der Experte Protokolle und gibt Feedback ab. Das Feedback des Experten wird in Rückschlusstabellen protokolliert.

Hinweis

Wenn Sie die Azure Storage-Firewall aktiviert haben, wenden Sie sich an Ihr Azure Databricks-Kontoteam, um Rückschlusstabellen für Ihre Endpunkte zu aktivieren.

Verwenden von mlflow.evaluate() in der Anforderungsprotokolltabelle

Das folgende Notizbuch veranschaulicht die Verwendung der Protokolle aus der Rezensions-App als Eingabe für eine Auswertungsausführung mit mlflow.evaluate().