DatabricksIQ Vertrauen und Sicherheit

Databricks versteht die Bedeutung Ihrer Daten und das Vertrauen, das Sie bei der Nutzung unserer Plattform und databricksIQ-gestützten Features in uns platzieren. Databricks verpflichtet sich zu den höchsten Datenschutzstandards und hat strenge Maßnahmen implementiert, um sicherzustellen, dass Informationen, die Sie an DatabricksIQ-gestützte Features übermitteln, geschützt sind.

- Ihre Daten bleiben vertraulich.

- Databricks trainiert keine generativen Foundation-Modelle mit Daten, die Sie an diese Features übermitteln, und Databricks verwendet diese Daten nicht, um Vorschläge zu generieren, die für andere Kunden angezeigt werden.

- Unsere Modellpartner speichern Ihre über diese Features übermittelten Daten nicht, auch nicht für die Missbrauchsüberwachung. Unsere partnergestützten KI-Hilfsfunktionen verwenden null Datenaufbewahrungsendpunkte von unseren Modellpartnern.

- Schutz vor schädlichen Ausgaben. Databricks verwendet auch Azure OpenAI Inhaltsfilterung, um Benutzer*innen vor schädlichen Inhalten zu schützen. Darüber hinaus hat Databricks eine umfangreiche Auswertung mit Tausenden simulierter Benutzerinteraktionen durchgeführt, um sicherzustellen, dass die Maßnahmen zum Schutz vor schädlichen Inhalten, Jailbreaks, der Generierung unsicherer Codes und der Verwendung urheberrechtlich geschützter Inhalte von Dritten wirksam sind.

- Databricks verwendet nur die für die Bereitstellung des Dienstes erforderlichen Daten. Daten werden nur gesendet, wenn Sie mit DatabricksIQ-basierten Features interagieren. Databricks sendet Ihre Eingabeaufforderung, relevante Tabellenmetadaten und -werte, Fehler sowie Eingabecode oder Abfragen, um relevantere Ergebnisse zurückzugeben. Databricks sendet keine anderen Daten auf Zeilenebene an Modelle von Drittanbietern.

- Daten werden während der Übertragung geschützt. Der gesamte Datenverkehr zwischen Databricks und Modellpartnern wird während der Übertragung mit branchenübter TLS-Verschlüsselung verschlüsselt.

- Databricks bietet Datenresidenzsteuerelemente. DatabricksIQ-basierte Funktionen sind Designated Services und entsprechen den Datenresidenzgrenzen. Weitere Details finden Sie unter Databricks Geos: Datenresidenz und Databricks Designated Services.

Weitere Informationen zur Datenschutzerklärung und Sicherheit des Databricks-Assistenten finden Sie unter Datenschutz und Sicherheit.

Funktionen, die über die Einstellung Partnergestützte KI-Hilfsfunktionen gesteuert werden

Partnergestützte KI bezieht sich auf den Azure OpenAI-Dienst. Im Folgenden finden Sie eine Aufschlüsselung der Features, die von der Einstellung der partnergestützten KI-Hilfsfeatures gesteuert werden:

| Merkmal | Wo wird das Modell gehostet? | Wird dies über die Einstellung für Partnergestützte KI gesteuert? |

|---|---|---|

| Chat für den Databricks-Assistenten | Azure OpenAI-Dienst | Ja |

| Schnelle Problembehebung | Azure OpenAI-Dienst | Ja |

| KI-generierte UC-Kommentare | Compliancesicherheitsprofil (CSP)-Arbeitsbereiche: Azure OpenAI-Dienst | Ja, für alle CSP-Arbeitsbereiche. |

| KI-gestützte Visualisierungen und Genie-Companionbereiche auf dem AI/BI-Dashboard | Azure OpenAI-Dienst | Ja |

| Genie | Azure OpenAI-Dienst | Ja |

| Databricks-Inline-Assistent | Azure OpenAI-Dienst | Ja |

| AutoVervollständigen des Databricks-Assistenten | In Databricks gehostetes Modell | Nein |

| Intelligente Suche | Azure OpenAI-Dienst | Ja |

Verwenden eines in Databricks gehosteten Modells

Wichtig

Diese Funktion befindet sich in der Public Preview.

Erfahren Sie, wie Sie ein von Databricks gehostetes Modell verwenden, um DatabricksIQ-Features zu nutzen, die andernfalls von Azure OpenAI unterstützt werden. In diesem Abschnitt wird erläutert, wie es funktioniert.

Funktionsweise

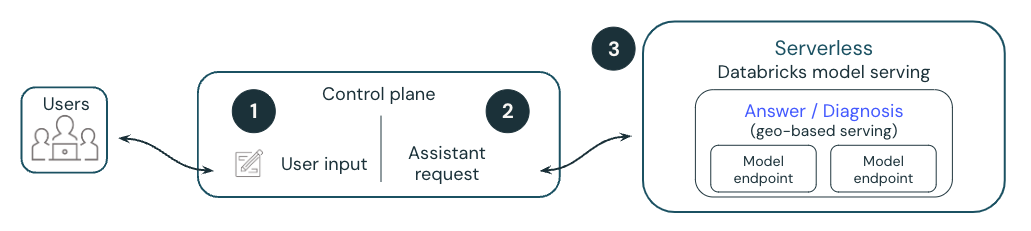

Das folgende Diagramm bietet eine Übersicht darüber, wie ein von Databricks gehostetes Modell DatabricksIQ-Features wie Quick Fix unterstützt.

- Ein Benutzer führt eine Zelle aus, die zu einem Fehler führt.

- Databricks fügt Metadaten an eine Anforderung an und sendet sie an ein vom Databricks gehostetes Large Language Model (LLM). Alle Daten werden im Ruhezustand verschlüsselt. Kunden können einen kundenseitig verwalteten Schlüssel (CMK) verwenden.

- Das vom Databricks gehostete Modell antwortet mit den vorgeschlagenen Codebearbeitungen, um den Fehler zu beheben, der dem Benutzer angezeigt wird.

Dieses Feature befindet sich in der öffentlichen Vorschau und kann geändert werden. Wenden Sie sich an Ihren Vertreter, um zu fragen, welche DatabricksIQ-Features von einem von Databricks gehosteten Modell unterstützt werden können.

Von Databricks gehostete Modelle

Wenn DatabricksIQ-Features databricks-gehostete Modelle verwenden, verwenden sie Meta Llama 3 oder andere Modelle, die auch für den kommerziellen Gebrauch verfügbar sind. Meta Llama 3 ist unter der Meta Llama 3 Community License, Copyright © Meta Platforms, Inc. lizenziert. Alle Rechte vorbehalten.

Häufig gestellte Fragen zu Databricks-gehosteten Modellen für den Assistenten

Kann ich meine eigene private Modellbereitstellungsinstanz verwenden?

Derzeit leider nicht. In dieser Vorschau werden Modellbereitstellungsendpunkte verwendet, die von Databricks verwaltet und geschützt werden. Die Modellbereitstellungsendpunkte sind statusfrei und werden durch mehrere Isolationsschichten geschützt. Sie implementieren die folgenden Sicherheitskontrollen zum Schützen Ihrer Daten:

- Jede Kundenanforderung an die Modellbereitstellung ist logisch isoliert, authentifiziert und autorisiert.

- Mosaic AI Model Serving verschlüsselt alle ruhenden Daten (AES-256) und während der Übertragung (TLS 1.2+).

Berücksichtigen die an die Modelle gesendeten Metadaten die Unity Catalog-Berechtigungen des Benutzers’?

Ja, alle an das Modell gesendeten Daten respektieren die Unity Catalog-Berechtigungen des Benutzers. Beispielsweise werden keine Metadaten in Bezug auf Tabellen, für die der Benutzer nicht über die Berechtigung zum Anzeigen verfügt, gesendet.

Wo werden die Daten gespeichert?

Der Chatverlauf des Databricks-Assistenten wird zusammen mit dem Notebook in der Datenbank der Steuerebene gespeichert. Die Datenbank für die Steuerungsebene ist AES-256-Bit verschlüsselt, und Kunden, die die Kontrolle über den Verschlüsselungsschlüssel benötigen, können unsere Funktion „Kundenseitig verwalteter Schlüssel“ nutzen.

Hinweis

- Ähnlich wie bei anderen Arbeitsbereichsobjekten ist der Aufbewahrungszeitraum für den Chatverlauf des Databricks-Assistenten an den Lebenszyklus des Objekts selbst gebunden. Wenn ein Benutzer das Notebook löscht, wird es und der zugehörige Chatverlauf nach 30 Tagen gelöscht.

- Wenn das Notebook exportiert wird, wird der Chatverlauf nicht zusammen mit dem Notebook exportiert.

- Notizbuch- und Abfragechathistorien stehen anderen Benutzern oder Administratoren nicht zur Verfügung, auch wenn die Abfrage oder das Notizbuch freigegeben ist.

Kann ich meinen eigenen API-Schlüssel für mein Modell mitbringen oder eigene Modelle hosten?

Derzeit leider nicht. Der Databricks-Assistent wird vollständig von Databricks verwaltet und gehostet. Die Funktionalität des Assistenten ist stark von Modellbereitstellungsmerkmalen (z. B. Funktionsaufrufen), Leistung und Qualität abhängig. Databricks wertet kontinuierlich neue Modelle für die beste Leistung aus und kann das Modell in zukünftigen Versionen dieser Funktion aktualisieren.

Wer besitzt die Ausgabedaten? Wenn der Assistent Code generiert, wer besitzt diese IP?

Der Kunde verfügt über seine eigene Ausgabe.

Kiene von Databricks gehosteten Modelle verwenden

So deaktivieren Sie die Verwendung von von Databricks gehosteten Modellen:

- Wählen Sie in der oberen Leiste des Databricks-Arbeitsbereichs Ihren Benutzernamen aus.

- Wählen Sie im Menü die Option Previews aus.

- Deaktivieren Sie die Option Assistent mit von Databricks gehosteten Modellen verwenden.

Weitere Informationen zum Verwalten von Previews finden Sie unter Verwalten von Azure Databricks Previews.