Konfigurieren einer Verbindung für die Verwendung der Azure KI-Modellinferenz in Ihrem KI-Projekt

Wichtig

Die in diesem Artikel markierten Elemente (Vorschau) sind aktuell als öffentliche Vorschau verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel bereitgestellt und sollte nicht für Produktionsworkloads verwendet werden. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

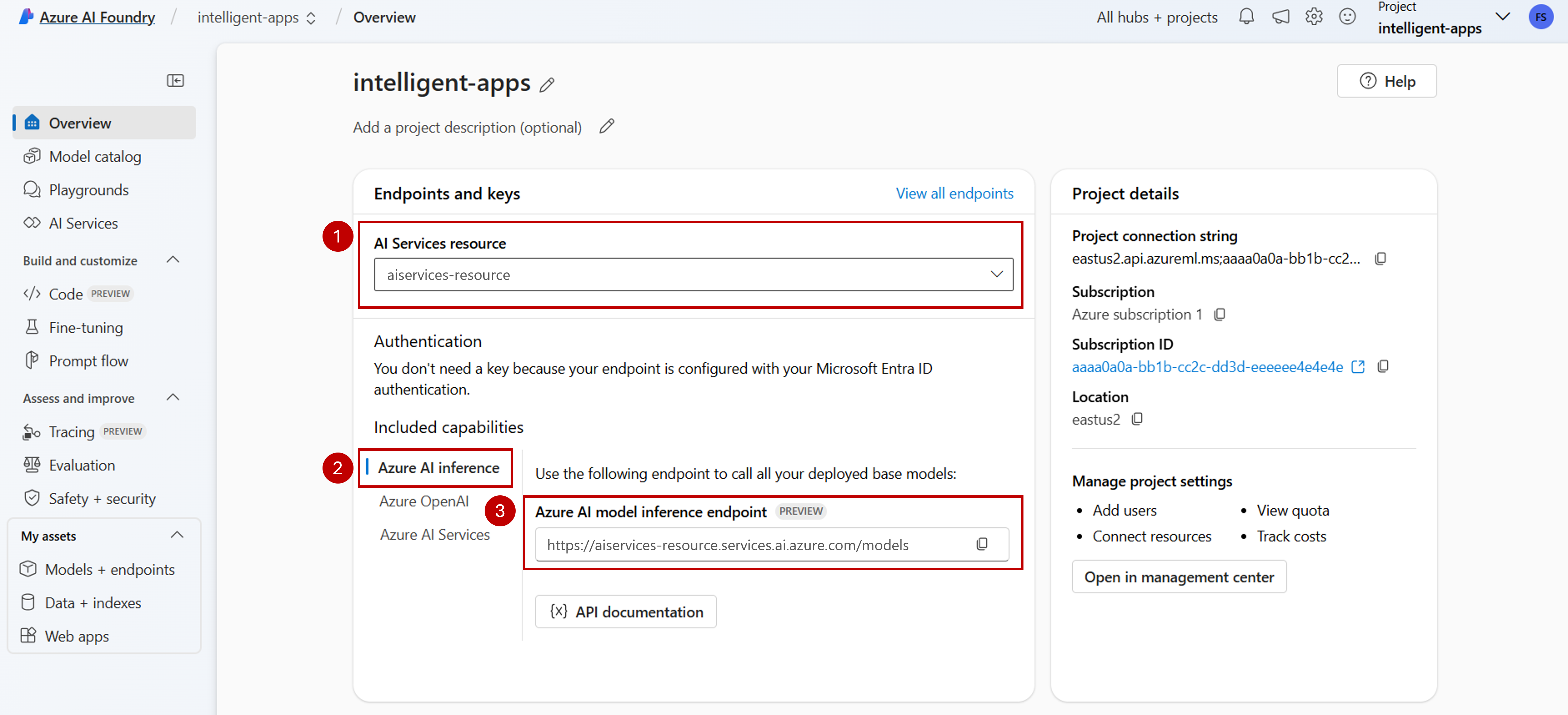

Sie können die Azure KI-Modellinferenz in Ihren Projekten in Azure AI Foundry zum Erstellen/Erreichen von Anwendungen sowie zur Interaktion mit den verfügbaren Modellen bzw. deren Verwaltung verwenden. Um den Azure KI-Modellinferenzdienst in Ihrem Projekt zu verwenden, müssen Sie eine Verbindung zur Azure KI Services-Ressource erstellen.

In diesem Artikel wird erläutert, wie Sie eine Verbindung zur Azure KI Services-Ressource erstellen, um den Inferenzendpunkt zu verwenden.

Voraussetzungen

Damit Sie die Anweisungen in diesem Artikel ausführen können, benötigen Sie Folgendes:

Ein Azure-Abonnement. Wenn Sie GitHub-Modelle verwenden, können Sie Ihre Erfahrung upgraden und während dem Prozess ein Azure-Abonnement erstellen. Lesen Sie in diesem Fall Upgrade von GitHub-Modellen auf die Azure KI-Modellinferenz.

Eine Azure KI Services-Ressource. Weitere Informationen finden Sie unter Erstellen einer Azure KI Services-Ressource.

- Ein KI-Projekt, das mit Ihrer Azure KI Services-Ressource verbunden ist. Sie können die unter Konfigurieren des Azure KI-Modellinferenzdiensts in meinem Projekt in Azure AI Foundry beschriebenen Schritte ausführen.

Verbindung hinzufügen

Sie können eine Verbindung zu einer Azure KI Services-Ressource erstellen, indem Sie die folgenden Schritte ausführen:

Besuchen Sie das Azure AI Foundry-Portal.

Wählen Sie unten links auf dem Bildschirm Verwaltungszentrum aus.

Wählen Sie im Abschnitt Verbindungen die Option Neue Verbindung aus.

Wählen Sie dann Azure KI Services aus.

Suchen Sie im Browser nach einer vorhandenen Azure KI Services-Ressource in Ihrem Abonnement.

Wählen Sie Verbindung hinzufügen aus.

Die neue Verbindung wird Ihrem Hub hinzugefügt.

Kehren Sie zur Landing Page des Projekts zurück, um fortzufahren, und wählen Sie nun die neu erstellte Verbindung aus. Aktualisieren Sie die Seite, wenn sie nicht sofort angezeigt wird.

Anzeigen von Modellbereitstellungen in der verbundenen Ressource

Sie können die Modellbereitstellungen in der verbundenen Ressource anzeigen, indem Sie die folgenden Schritte ausführen:

Besuchen Sie das Azure AI Foundry-Portal.

Klicken Sie auf der linken Navigationsleiste auf Modelle und Endpunkte.

Auf der Seite werden die für Sie verfügbaren Modellbereitstellungen gruppiert nach Verbindungsname angezeigt. Suchen Sie die soeben erstellte Verbindung, die vom Typ Azure KI Services sein sollte.

Wählen Sie eine beliebige Modellbereitstellung aus, die Sie überprüfen möchten.

Auf der Detailseite werden Informationen zu der jeweiligen Bereitstellung angezeigt. Wenn Sie das Modell testen möchten, können Sie die Option In Playground öffnen verwenden.

Der Azure AI Foundry-Playground wird angezeigt, in dem Sie mit dem angegebenen Modell interagieren können.

Wichtig

Die in diesem Artikel markierten Elemente (Vorschau) sind aktuell als öffentliche Vorschau verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel bereitgestellt und sollte nicht für Produktionsworkloads verwendet werden. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Sie können die Azure KI-Modellinferenz in Ihren Projekten in Azure AI Foundry zum Erstellen/Erreichen von Anwendungen sowie zur Interaktion mit den verfügbaren Modellen bzw. deren Verwaltung verwenden. Um den Azure KI-Modellinferenzdienst in Ihrem Projekt zu verwenden, müssen Sie eine Verbindung zur Azure KI Services-Ressource erstellen.

In diesem Artikel wird erläutert, wie Sie eine Verbindung zur Azure KI Services-Ressource erstellen, um den Inferenzendpunkt zu verwenden.

Voraussetzungen

Damit Sie die Anweisungen in diesem Artikel ausführen können, benötigen Sie Folgendes:

Ein Azure-Abonnement. Wenn Sie GitHub-Modelle verwenden, können Sie Ihre Erfahrung upgraden und während dem Prozess ein Azure-Abonnement erstellen. Lesen Sie in diesem Fall Upgrade von GitHub-Modellen auf die Azure KI-Modellinferenz.

Eine Azure KI Services-Ressource. Weitere Informationen finden Sie unter Erstellen einer Azure KI Services-Ressource.

Installieren Sie die Azure CLI und die

ml-Erweiterung für Azure AI Foundry:az extension add -n mlErmitteln Sie die folgenden Informationen:

die Azure-Abonnement-ID

Name Ihrer Azure KI Services-Ressource

Ressourcengruppe, in der die Azure KI Services-Ressource bereitgestellt wurde

Verbindung hinzufügen

Um ein Modell hinzuzufügen, müssen Sie zuerst das Modell ermitteln, das Sie bereitstellen möchten. Sie können die verfügbaren Modelle wie folgt abfragen:

Melden Sie sich bei Ihrem Azure-Abonnement an:

az loginKonfigurieren Sie die CLI so, dass sie auf das Projekt verweist:

az account set --subscription <subscription> az configure --defaults workspace=<project-name> group=<resource-group> location=<location>Erstellen Sie eine Verbindungsdefinition:

connection.yml

name: <connection-name> type: aiservices endpoint: https://<ai-services-resourcename>.services.ai.azure.com api_key: <resource-api-key>Erstellen Sie die Verbindung:

az ml connection create -f connection.ymlZu diesem Zeitpunkt steht die Verbindung für die Nutzung zur Verfügung.

Wichtig

Die in diesem Artikel markierten Elemente (Vorschau) sind aktuell als öffentliche Vorschau verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel bereitgestellt und sollte nicht für Produktionsworkloads verwendet werden. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar. Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Sie können die Azure KI-Modellinferenz in Ihren Projekten in Azure AI Foundry zum Erstellen/Erreichen von Anwendungen sowie zur Interaktion mit den verfügbaren Modellen bzw. deren Verwaltung verwenden. Um den Azure KI-Modellinferenzdienst in Ihrem Projekt zu verwenden, müssen Sie eine Verbindung zur Azure KI Services-Ressource erstellen.

In diesem Artikel wird erläutert, wie Sie eine Verbindung zur Azure KI Services-Ressource erstellen, um den Inferenzendpunkt zu verwenden.

Voraussetzungen

Damit Sie die Anweisungen in diesem Artikel ausführen können, benötigen Sie Folgendes:

Ein Azure-Abonnement. Wenn Sie GitHub-Modelle verwenden, können Sie Ihre Erfahrung upgraden und während dem Prozess ein Azure-Abonnement erstellen. Lesen Sie in diesem Fall Upgrade von GitHub-Modellen auf die Azure KI-Modellinferenz.

Eine Azure KI Services-Ressource. Weitere Informationen finden Sie unter Erstellen einer Azure KI Services-Ressource.

Ein Azure KI-Projekt mit einem KI-Hub.

Installieren Sie die Azure CLI.

Ermitteln Sie die folgenden Informationen:

die Azure-Abonnement-ID

Name Ihrer Azure KI Services-Ressource

ID Ihrer Azure KI Services-Ressource

Name des Azure KI-Hubs, in dem das Projekt bereitgestellt wird

Ressourcengruppe, in der die Azure KI Services-Ressource bereitgestellt wurde

Verbindung hinzufügen

Verwenden Sie die Vorlage

ai-services-connection-template.bicep, um die Verbindung zu beschreiben:ai-services-connection-template.bicep

@description('Name of the hub where the connection will be created') param hubName string @description('Name of the connection') param name string @description('Category of the connection') param category string = 'AIServices' @allowed(['AAD', 'ApiKey', 'ManagedIdentity', 'None']) param authType string = 'AAD' @description('The endpoint URI of the connected service') param endpointUri string @description('The resource ID of the connected service') param resourceId string = '' @secure() param key string = '' resource connection 'Microsoft.MachineLearningServices/workspaces/connections@2024-04-01-preview' = { name: '${hubName}/${name}' properties: { category: category target: endpointUri authType: authType isSharedToAll: true credentials: authType == 'ApiKey' ? { key: key } : null metadata: { ApiType: 'Azure' ResourceId: resourceId } } }Führen Sie die Bereitstellung aus:

RESOURCE_GROUP="<resource-group-name>" ACCOUNT_NAME="<azure-ai-model-inference-name>" ENDPOINT_URI="https://<azure-ai-model-inference-name>.services.ai.azure.com" RESOURCE_ID="<resource-id>" HUB_NAME="<hub-name>" az deployment group create \ --resource-group $RESOURCE_GROUP \ --template-file ai-services-connection-template.bicep \ --parameters accountName=$ACCOUNT_NAME hubName=$HUB_NAME endpointUri=$ENDPOINT_URI resourceId=$RESOURCE_ID