Delta Lake logfører i Warehouse i Microsoft Fabric

Gælder for:✅ Warehouse i Microsoft Fabric

Warehouse i Microsoft Fabric er opbygget åbne filformater. Brugertabeller gemmes i parquetfilformat, og Delta Lake-logfiler publiceres for alle brugertabeller.

Delta Lake-logfilerne åbner direkte adgang til lagerets brugertabeller for alle motorer, der kan læse Delta Lake-tabeller. Denne adgang er begrænset til skrivebeskyttet for at sikre, at brugerdataene bevarer ACID-transaktionens overholdelse. Alle indsættelser, opdateringer og sletninger i dataene i tabellerne skal udføres via Lageret. Når en transaktion er bekræftet, startes en systembaggrundsproces for at publicere den opdaterede Delta Lake-log for de berørte tabeller.

Sådan får du OneLake-sti

I følgende trin beskrives det, hvordan du henter OneLake-stien fra en tabel på et lager:

Open Warehouse i dit Microsoft Fabric-arbejdsområde.

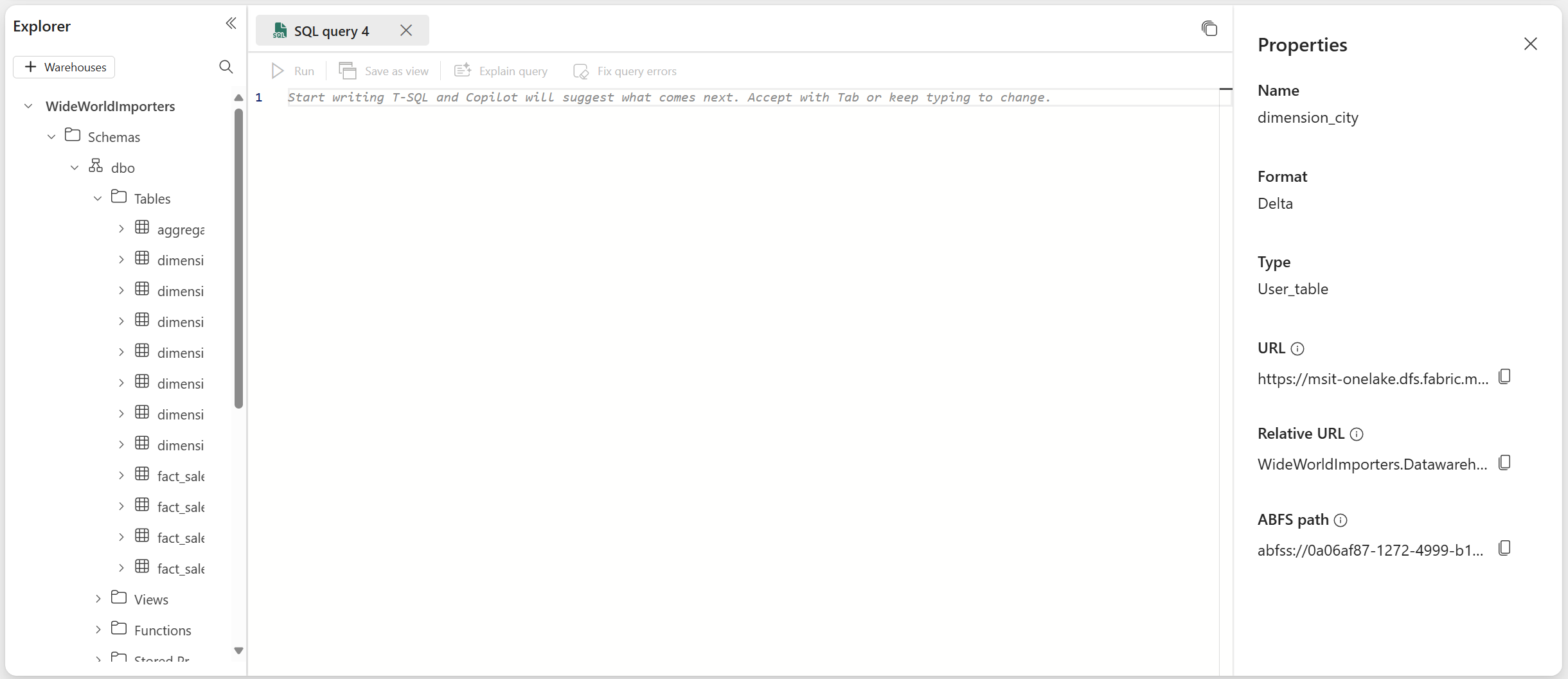

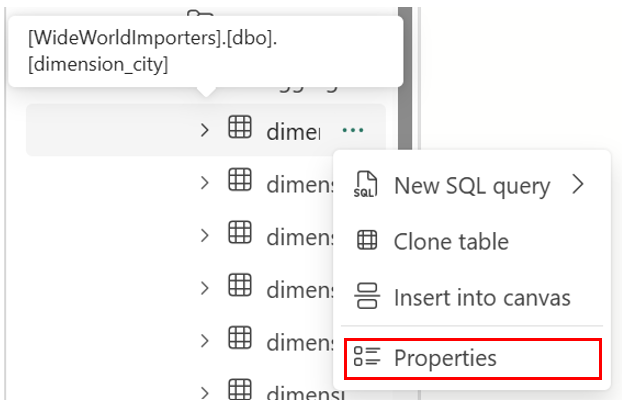

I Objektstifinder finder du flere indstillinger (...) i en valgt tabel i mappen Tabeller. Vælg menuen Egenskaber.

Ved markering vises følgende oplysninger i ruden Egenskaber :

- Navn

- Format

- Skriv

- URL-adresse

- Relativ sti

- ABFS-sti

Sådan henter du stien til Delta Lake-logfiler

Du kan finde Delta Lake-logfiler ved hjælp af følgende metoder:

Delta Lake-logfiler kan forespørges via genveje, der er oprettet i et lakehouse. Du kan få vist filerne ved hjælp af en Microsoft Fabric Spark-notesbog eller Lakehouse-stifinderen i Fabric Dataudvikler ing på Microsoft Fabric-portalen.

Delta Lake-logfiler kan findes via Azure Storage Explorer, via Spark-forbindelser, f.eks. Power BI Direct Lake-tilstand, eller ved hjælp af en hvilken som helst anden tjeneste, der kan læse deltatabeller.

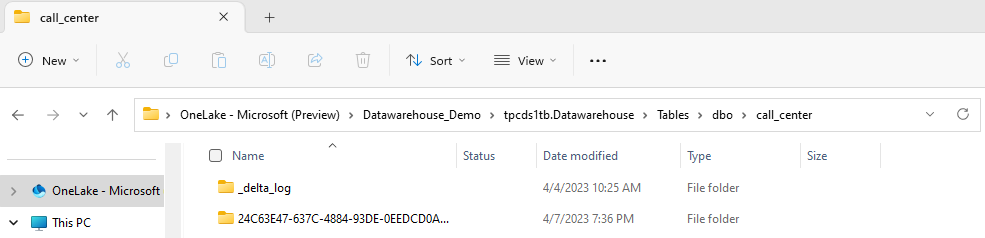

Delta Lake-logfiler kan findes i mappen for

_delta_loghver tabel via OneLake Explorer i Windows, som vist på følgende skærmbillede.

Afbryder publicering af Delta Lake-log midlertidigt

Publicering af Delta Lake-logfiler kan afbrydes midlertidigt og genoptages, hvis det er nødvendigt. Når publiceringen afbrydes midlertidigt, kan Microsoft Fabric-motorer, der læser tabeller uden for lageret, se dataene, som de var før pausen. Det sikrer, at rapporter forbliver stabile og konsistente, hvilket afspejler data fra alle tabeller, som de fandtes, før der blev foretaget ændringer i tabellerne. Når dine dataopdateringer er fuldført, kan du genoptage Delta Lake Log-publicering for at gøre alle de seneste dataændringer synlige for andre analyseprogrammer. En anden brugssag til at afbryde Delta Lake-logpublicering midlertidigt er, når brugerne ikke har brug for interoperabilitet med andre beregningsprogrammer i Microsoft Fabric, da det kan hjælpe med at spare på beregningsomkostningerne.

Syntaksen til at afbryde delta Lake-logpubliceringen midlertidigt og genoptage den er som følger:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED | AUTO

Eksempel: Sæt delta Lake-logpublicering på pause og fortsæt

Hvis du vil afbryde delta Lake-logpublicering midlertidigt, skal du bruge følgende kodestykke:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = PAUSED

Forespørgsler til lagertabeller på det aktuelle lager fra andre Microsoft Fabric-motorer (f.eks. forespørgsler fra en Lakehouse) viser nu en version af dataene, som de var, før delta Lake-logpublicering blev afbrudt midlertidigt. Lagerforespørgsler viser stadig den nyeste version af data.

Hvis du vil fortsætte delta Lake-logpublicering, skal du bruge følgende kodestykke:

ALTER DATABASE CURRENT SET DATA_LAKE_LOG_PUBLISHING = AUTO

Når tilstanden ændres tilbage til AUTO, udgiver Fabric Warehouse-programmet logge over alle de seneste ændringer af tabeller på lageret, så andre analyseprogrammer i Microsoft Fabric kan læse den nyeste version af data.

Kontrollerer status for Delta Lake-logpublicering

Hvis du vil kontrollere den aktuelle tilstand for Delta Lake-logpublicering på alle lagre for det aktuelle arbejdsområde, skal du bruge følgende kodestykke:

SELECT [name], [DATA_LAKE_LOG_PUBLISHING_DESC] FROM sys.databases

Begrænsninger

- Tabelnavne kan kun bruges af Spark og andre systemer, hvis de kun indeholder disse tegn: A-Z a-z 0-9 og understregningstegn.

- Kolonnenavne, der skal bruges af Spark og andre systemer, må ikke indeholde:

- Rum

- faner

- vognretur

- [

- ,

- ;

- {

- }

- (

- )

- =

- ]