Prisfastsættelsesscenarie ved hjælp af en datapipeline til indlæsning af 1 TB parquetdata i et data warehouse

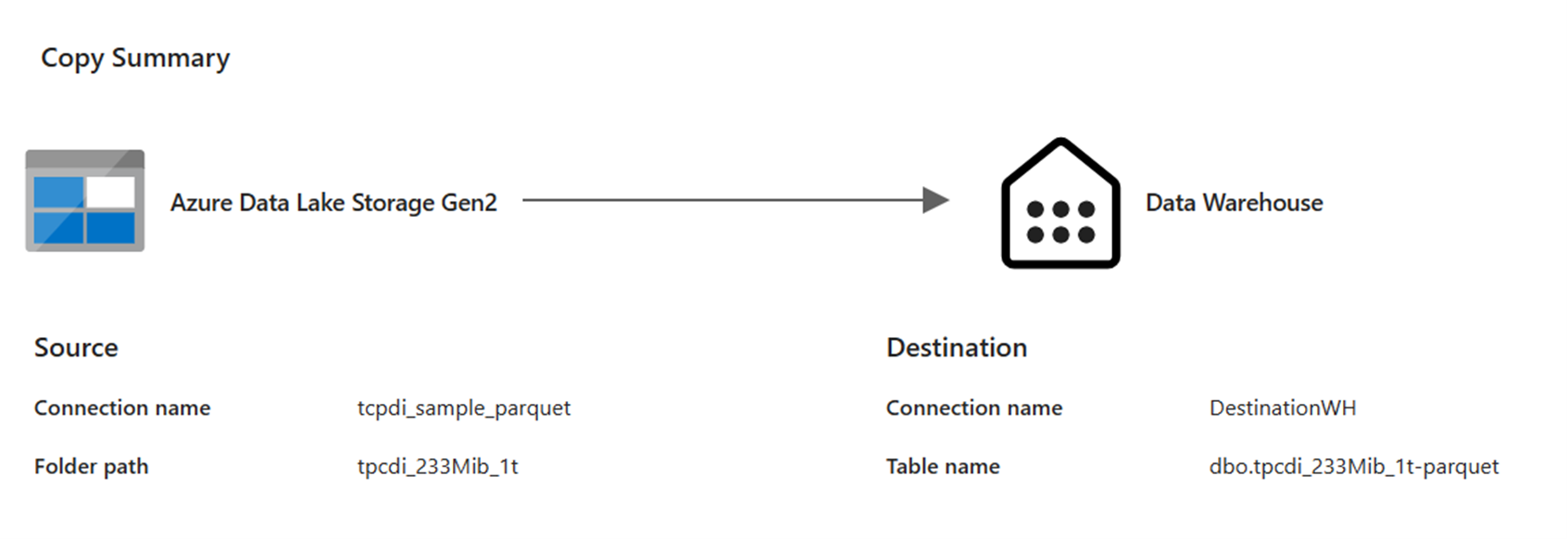

I dette scenarie blev en kopiaktivitet brugt i en datapipeline til at indlæse 1 TB parquet-tabeldata, der er gemt i Azure Data Lake Storage (ADLS) Gen2, til et data warehouse i Microsoft Fabric.

De priser, der bruges i følgende eksempel, er hypotetiske og har ikke til hensigt at indebære nøjagtige faktiske priser. Disse er blot for at vise, hvordan du kan estimere, planlægge og administrere omkostninger for Data Factory-projekter i Microsoft Fabric. Da Fabric-kapaciteter prissættes entydigt på tværs af områder, bruger vi også prissætningen efter forbrug for en Fabric-kapacitet i det vestlige USA 2 (et typisk Azure-område) til 0,18 USD pr. CU pr. time. Se Microsoft Fabric – Priser for at udforske andre muligheder for prisfastsættelse for Fabric-kapacitet her.

Konfiguration

Hvis du vil opnå dette scenarie, skal du oprette en pipeline med følgende konfiguration:

Estimering af omkostninger ved hjælp af Appen Fabric Metrics

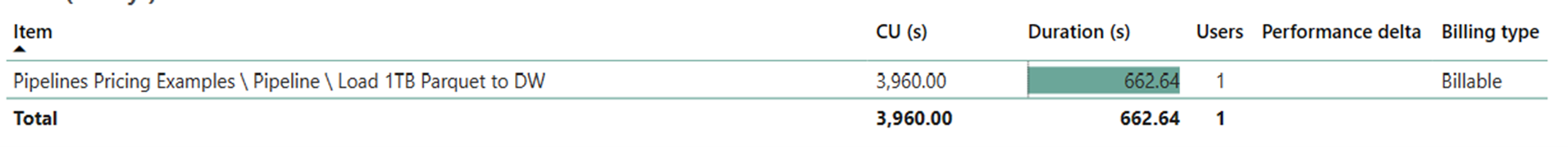

Dataflytningshandlingen brugte 3.960 CU sekunder med en varighed på 662,64 sekunder, mens aktivitetskørselshandlingen var null, da der ikke var nogen ikke-kopiaktiviteter i pipelinekørslen.

Bemærk

Selvom den er rapporteret som en metrikværdi, er den faktiske varighed af kørslen ikke relevant ved beregning af de effektive CU-timer med Fabric Metrics-appen, da den metrikværdi for CU-sekunder, den også rapporterer, allerede tegner sig for dens varighed.

| Metric | Dataflytningshandling |

|---|---|

| CU-sekunder | 3.960 CU sekunder |

| Effektive CU-timer | (3.960) / (60*60) CU-timer = 1,1 CU-timer |

Samlede kørselsomkostninger ved $0.18/CU time = (1,1 CU-time) * ($0,18/CU time) ~= $0,20