Prisfastsættelsesscenarie ved hjælp af Dataflow Gen2 til at indlæse 2 GB parquetdata i en Lakehouse-tabel

I dette scenarie blev Dataflow Gen2 brugt til at indlæse 2 GB parquetdata, der er gemt i Azure Data Lake Storage (ADLS) Gen2, i en Lakehouse-tabel i Microsoft Fabric. Vi brugte NYC Taxi-green-eksempeldataene til parquetdataene.

De priser, der bruges i følgende eksempel, er hypotetiske og har ikke til hensigt at indebære nøjagtige faktiske priser. Disse er blot for at vise, hvordan du kan estimere, planlægge og administrere omkostninger for Data Factory-projekter i Microsoft Fabric. Da Fabric-kapaciteter prissættes entydigt på tværs af områder, bruger vi også prissætningen efter forbrug for en Fabric-kapacitet i det vestlige USA 2 (et typisk Azure-område) til 0,18 USD pr. CU pr. time. Se Microsoft Fabric – Priser for at udforske andre muligheder for prisfastsættelse for Fabric-kapacitet her.

Konfiguration

Hvis du vil opnå dette scenarie, skal du oprette et dataflow ved hjælp af følgende trin:

- Initialiser dataflow: Hent data om parquetfiler på 2 GB fra ADLS Gen2-lagerkontoen.

- Konfigurer Power-forespørgsel:

- Gå til Power Query.

- Sørg for, at indstillingen for midlertidig lagring af forespørgslen er aktiveret.

- Fortsæt med at kombinere Parquet-filerne.

- Datatransformation:

- Hæv overskrifter for at skabe klarhed.

- Fjern unødvendige kolonner.

- Juster kolonnedatatyper efter behov.

- Definer destination for outputdata:

- Konfigurer Lakehouse som destination for dataoutput.

- I dette eksempel blev der oprettet og brugt et Lakehouse i Fabric.

Estimering af omkostninger ved hjælp af Appen Fabric Metrics

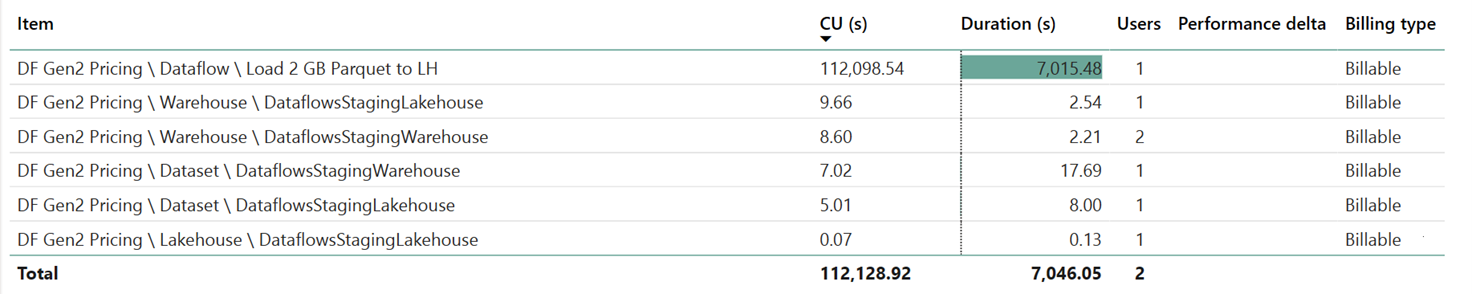

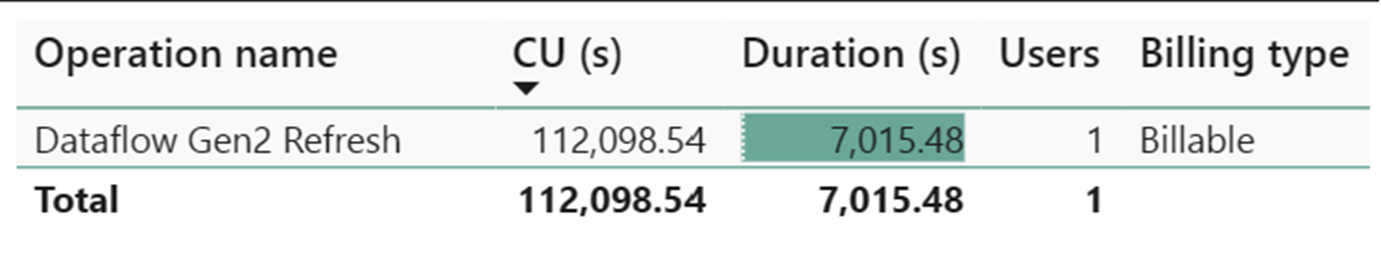

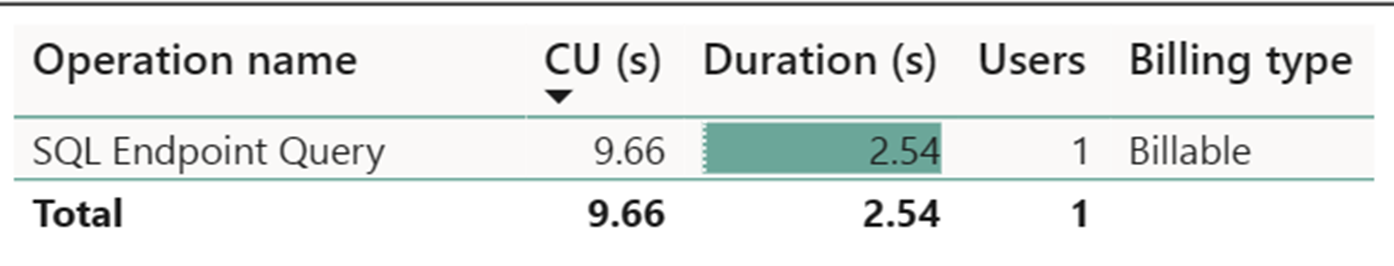

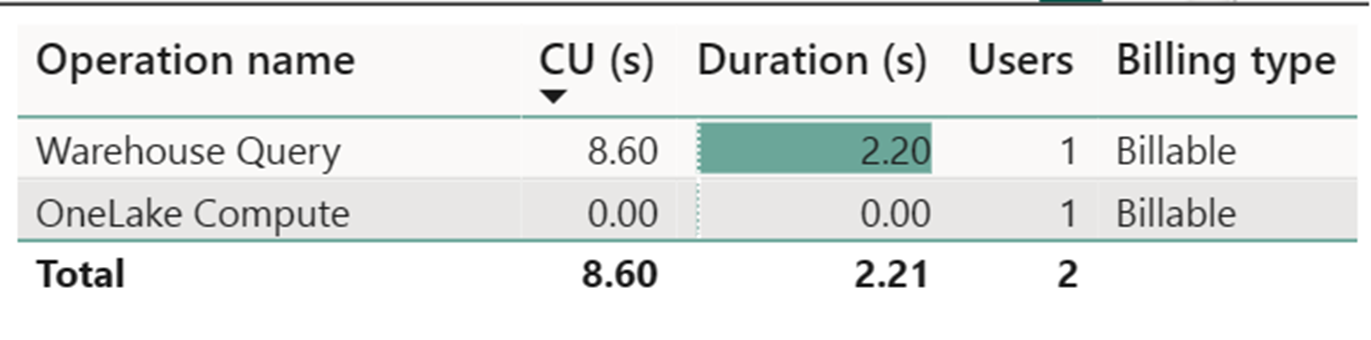

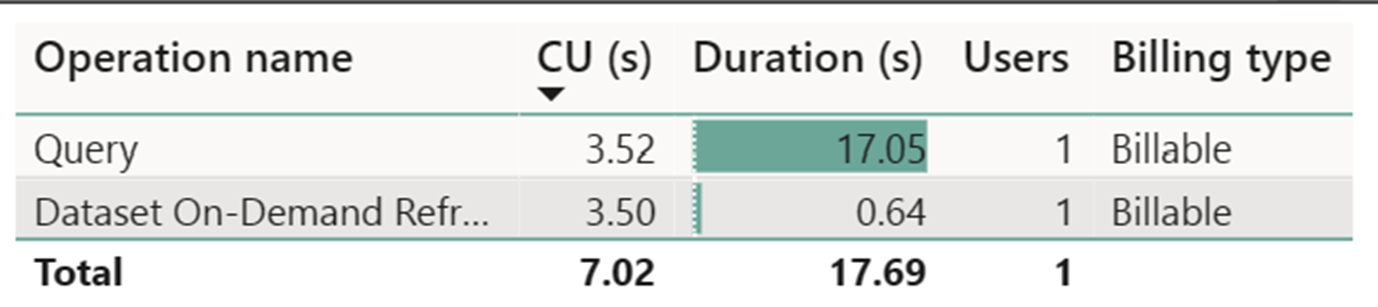

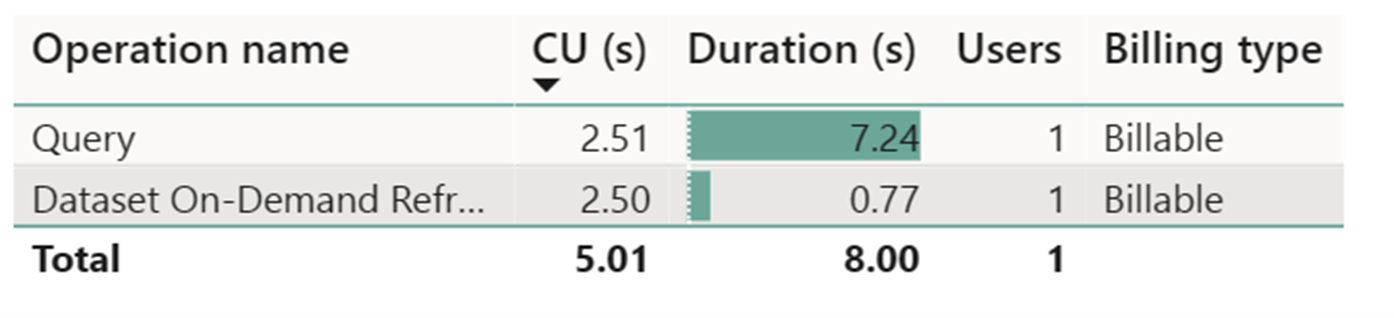

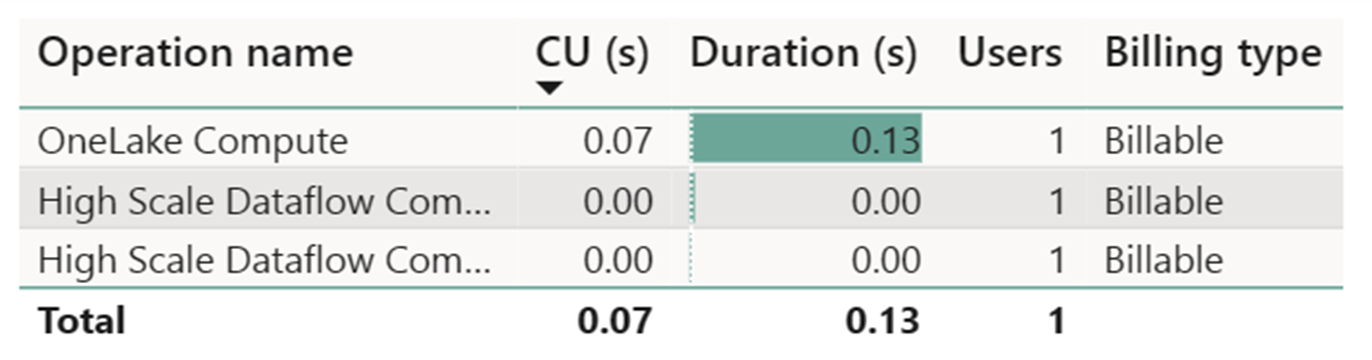

Beregningsmåleren for dataflow i høj skala registrerede ubetydelig aktivitet. Standardberegningsmåleren for opdateringshandlinger for Dataflow Gen2 bruger 112.098.540 beregningsenheder (CU'er). Det er vigtigt at overveje, at andre handlinger, herunder Warehouse Query, SQL Endpoint Query og Dataset On-Demand Refresh, udgør detaljerede aspekter af implementeringen af Dataflow Gen2, der i øjeblikket er gennemsigtige og nødvendige for deres respektive handlinger. Disse handlinger skjules dog i fremtidige opdateringer og bør ignoreres ved vurdering af omkostningerne for Dataflow Gen2.

Bemærk

Selvom den er rapporteret som en metrikværdi, er den faktiske varighed af kørslen ikke relevant ved beregning af de effektive CU-timer med Fabric Metrics-appen, da den metrikværdi for CU-sekunder, den også rapporterer, allerede tegner sig for dens varighed.

| Metric | Standard-niveauet for Compute | Beregning i høj skala |

|---|---|---|

| Samlet antal CU-sekunder | 112.098,54 CU sekunder | 0 CU sekunder |

| Faktureret for effektive CU-timer | 112.098.54 / (60*60) = 31,14 CU timer | 0/ (60*60) = 0 CU timer |

Samlede kørselsomkostninger ved $0.18/CU time = (31,14 CU-timer) * ($0,18/CU time) ~= $5,60