Jobindlæggelse i Apache Spark til Microsoft Fabric

Gælder for:✅ Dataudvikler ing og datavidenskab i Microsoft Fabric

Apache Spark for Fabric bruger den optimistiske jobindlæggelsesteknik til at bestemme minimumkravet til Spark-job. Denne proces gælder for interaktive job eller batchjob fra notesbøger, lakehouses eller Spark-jobdefinitioner. Den er afhængig af den minimale nodeindstilling for den valgte Spark-gruppe i indstillingerne for arbejdsområdet eller det tilknyttede miljø. Hvis der findes tilgængelige kerner i Den Fabric-kapacitet, der er knyttet til arbejdsområdet, accepteres jobbet og påbegynder udførelsen. Job starter med deres minimumnodeindstilling og kan skaleres op inden for deres maksimale nodegrænser i henhold til jobfaser. Hvis det samlede antal kerner, der bruges til at køre job ved hjælp af Fabric-kapaciteten, er under det maksimale antal tildelte burst-kerner, tillader jobindtagelses- og begrænsningslag på Fabric Spark jobbet at skalere op.

Du kan få flere oplysninger under Samtidighedsgrænser og -kø i Microsoft Fabric Spark.

Hvordan fungerer optimistisk jobindlæggelse?

I Fabric leveres startpuljer med et standardminimum på én node, mens brugerdefinerede puljer giver dig mulighed for at angive minimumnoder baseret på arbejdsbelastningsbehov. Automatisk skalering justerer beregningskravene for Spark-job under udførelsesfaser inden for de konfigurerede minimum- og maksimumnoder. Optimistisk jobindtagelse evaluerer jobindsendelser baseret på tilgængelige kerner og udfører dem med minimumkerner. Job forsøger at vokse baseret på maksimalt allokerede noder under udførelse. Opskaleringsanmodninger godkendes, hvis det samlede antal spark-kerner, der bruges, er inden for tildelte kapacitetsgrænser.

Bemærk

Hvis forbruget når den maksimale grænse, og alle kerner i den samlede kapacitet for Fabric er i brug, afvises alle scale-up-anmodninger. Aktive job skal enten afsluttes eller annulleres for at frigøre kerner.

Hvordan påvirker dette samtidighed i jobbet?

Det mindste kernekrav for hvert job bestemmer, om jobbet kan accepteres. Hvis kapaciteten er fuldt udnyttet og ikke har nogen kerner tilbage til at opfylde et jobs minimumkernebehov, afvises jobbet. Interaktive notesbogjob eller Lakehouse-handlinger blokeres med en fejlmeddelelse, der ikke kan sende denne anmodning, fordi al tilgængelig kapacitet bruges i øjeblikket. Annuller et job, der kører i øjeblikket, forøg den tilgængelige kapacitet, eller prøv igen senere. Batchjob sættes i kø og udføres, når kerner bliver tilgængelige.

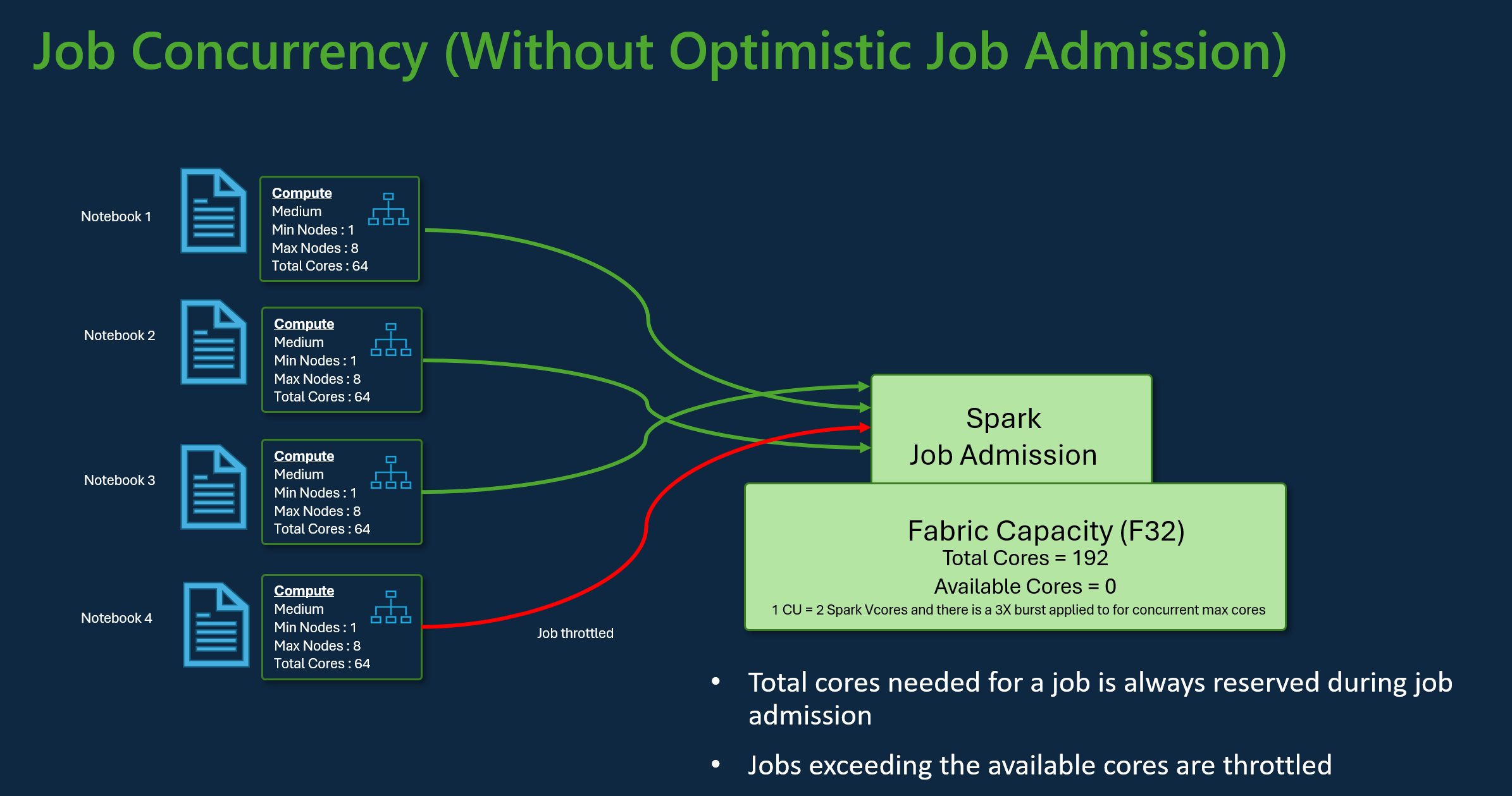

Overvej f.eks. et scenarie med en bruger, der bruger Fabric F32-kapacitets-SKU'en. Hvis det antages, at alle job bruger standardkonfigurationen for startpuljen uden optimistisk jobindtagelse, vil kapaciteten understøtte en maksimal samtidighed på tre job. Det maksimale antal kerner pr. job allokeres i henhold til konfigurationen af maks. noder.

Med optimistisk jobindtagelse med samme kapacitet som ovenfor kan 24 job optages og udføres ved hjælp af deres minimumnodekonfiguration under det maksimale samtidighedsscenarie. Da hvert job kræver 8 Spark VCores, hvor én minimumnodekonfiguration er af mellemstørrelse.

Skaler job med Automatisk skalering af Spark

Når du aktiverer automatisk skalering for Spark-puljer, udføres job med deres mindste nodekonfiguration. Under kørsel kan der forekomme skalering. Disse anmodninger gennemgår jobadgangskontrollen. Godkendte anmodninger skalerer op til de maksimale grænser baseret på det samlede antal tilgængelige kerner. Afviste anmodninger påvirker ikke aktive job. de fortsætter med at køre med deres aktuelle konfiguration, indtil kerner bliver tilgængelige.

Bemærk

Hvis du vil sikre maksimal kerneallokering for et job i henhold til konfigurationen af maks. noder, skal du deaktivere automatisk skalering og angive de maksimale noder i Fabric-kapacitets-SKU'en. I dette tilfælde, da jobbet ikke har noget minimumkrav til kerner, begynder det at køre, når der er gratis kerner tilgængelige, og skalerer op til den konfigurerede total. Hvis kapaciteten er fuldt brugt, kan interaktive job i notesbogen blive langsommere eller sat i kø. Job i kø bliver automatisk forsøgt igen, efterhånden som kerner bliver tilgængelige.

Relateret indhold

- Kom i gang med indstillingerne for administration af Spark-arbejdsområder i Microsoft Fabric.

- Få mere at vide om Spark Compute til Fabric-datakonstruktion og datavidenskab.

- Få mere at vide om samtidigheds- og køgrænser for Fabric Spark.