Hvad er datakonstruktion i Microsoft Fabric?

Datakonstruktion i Microsoft Fabric gør det muligt for brugerne at designe, bygge og vedligeholde infrastrukturer og systemer, der gør det muligt for deres organisationer at indsamle, gemme, behandle og analysere store datamængder.

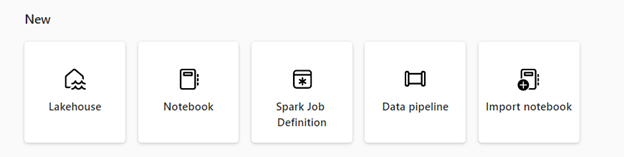

Microsoft Fabric indeholder forskellige datatekniske funktioner, der sikrer, at dine data er lettilgængelige, velorganiserede og af høj kvalitet. Fra startsiden for datakonstruktion kan du:

Opret og administrer dine data ved hjælp af et lakehouse

Design pipelines til kopiering af data til dit lakehouse

Brug Spark-jobdefinitioner til at sende batch-/streamingjob til Spark-klyngen

Brug notesbøger til at skrive kode til dataindtagelse, forberedelse og transformation

Lakehouse

Lakehouses er dataarkitekturer, der gør det muligt for organisationer at gemme og administrere strukturerede og ustrukturerede data på en enkelt placering ved hjælp af forskellige værktøjer og strukturer til at behandle og analysere disse data. Disse værktøjer og strukturer kan omfatte SQL-baserede forespørgsler og analyser samt maskinel indlæring og andre avancerede analyseteknikker.

Definition af Apache Spark-job

Spark-jobdefinitioner er et sæt instruktioner, der definerer, hvordan du udfører et job på en Spark-klynge. Den indeholder oplysninger som f.eks. input- og outputdatakilder, transformationerne og konfigurationsindstillingerne for Spark-programmet. Definitionen af Spark-job giver dig mulighed for at sende batch-/streamingjob til Spark-klyngen, anvende forskellige transformationslogik på de data, der hostes på dit lakehouse, sammen med mange andre ting.

Notesbog

Notesbøger er et interaktivt databehandlingsmiljø, der giver brugerne mulighed for at oprette og dele dokumenter, der indeholder livekode, ligninger, visualiseringer og fortælletekst. De giver brugerne mulighed for at skrive og udføre kode på forskellige programmeringssprog, herunder Python, R og Scala. Du kan bruge notesbøger til dataindtagelse, forberedelse, analyse og andre datarelaterede opgaver.

Datapipeline

Datapipelines er en række trin, der kan indsamle, behandle og transformere data fra den rå form til et format, som du kan bruge til analyse og beslutningstagning. De er en vigtig komponent i datakonstruktion, da de gør det muligt at flytte data fra kilden til destinationen på en pålidelig, skalerbar og effektiv måde.

Du kan bruge Data Engineering i Microsoft Fabric gratis, når du tilmelder dig prøveversionen af Fabric. Du kan også købe en Microsoft Fabric-kapacitet eller en Fabric-reserveret kapacitet

Relateret indhold

Kom i gang med Data Engineering:

- Hvis du vil vide mere om lakehouses, skal du se Hvad er et lakehouse i Microsoft Fabric?

- Hvis du vil i gang med et lakehouse, skal du se Opret et lakehouse i Microsoft Fabric.

- Hvis du vil vide mere om Definitioner af Apache Spark-job, skal du se Hvad er en Apache Spark-jobdefinition?

- Hvis du vil i gang med definitionen af et Apache Spark-job, skal du se Sådan opretter du en Apache Spark-jobdefinition i Fabric.

- Hvis du vil vide mere om notesbøger, skal du se Forfatter og udfør notesbogen.

- Hvis du vil i gang med kopiering af pipelineaktivitet, skal du se Sådan kopieres data ved hjælp af kopieringsaktivitet.