Ingestování dat do OneLake a analýza pomocí Azure Databricks

V této příručce:

Vytvořte kanál v pracovním prostoru a ingestujte data do OneLake ve formátu Delta.

Čtení a úprava tabulky Delta v OneLake pomocí Azure Databricks

Požadavky

Než začnete, musíte mít:

Pracovní prostor s položkou Lakehouse

Pracovní prostor Azure Databricks úrovně Premium. Pouze pracovní prostory Azure Databricks úrovně Premium podporují předávání přihlašovacích údajů Microsoft Entra. Při vytváření clusteru povolte předávání přihlašovacích údajů služby Azure Data Lake Storage v rozšířených možnostech.

Ukázková datová sada

Ingestování dat a úprava tabulky Delta

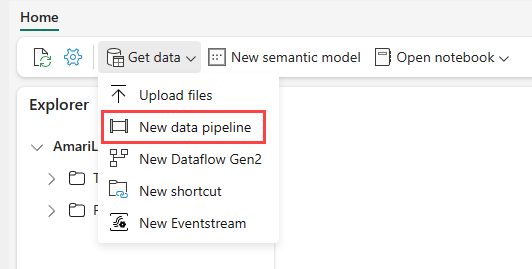

Přejděte do svého jezera v služba Power BI a vyberte Získat data a pak vyberte Nový datový kanál.

Na příkazovém řádku Nový kanál zadejte název nového kanálu a pak vyberte Vytvořit.

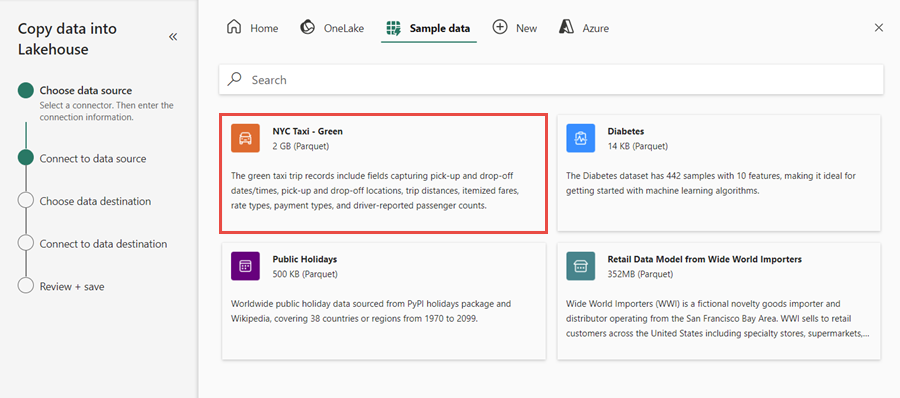

V tomto cvičení vyberte jako zdroj dat ukázková data NYC Taxi – Zelená a pak vyberte Další.

Na obrazovce náhledu vyberte Další.

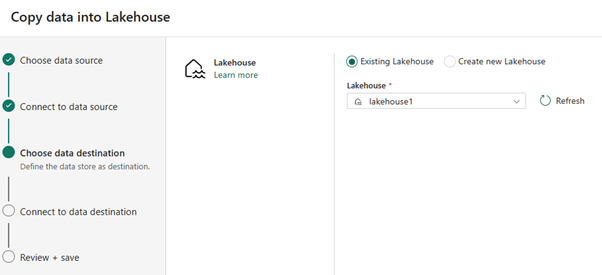

V případě cíle dat vyberte název jezera, který chcete použít k uložení dat tabulky OneLake Delta. Můžete zvolit existující jezerní dům nebo vytvořit nový.

Vyberte, kam chcete výstup uložit. Jako kořenovou složku zvolte Tabulky a jako název tabulky zadejte "nycsample".

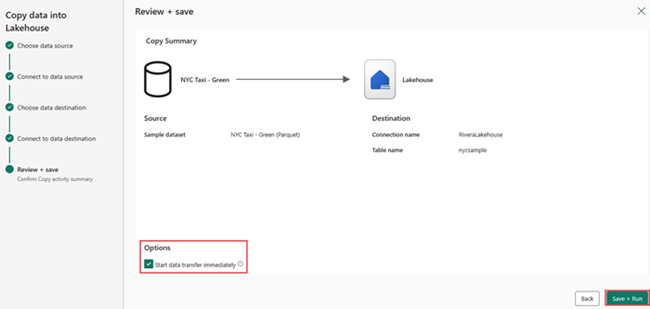

Na obrazovce Zkontrolovat a uložit vyberte Spustit přenos dat okamžitě a pak vyberte Uložit a spustit.

Po dokončení úlohy přejděte do jezera a zobrazte tabulku delta uvedenou ve složce /Tables.

Klikněte pravým tlačítkem na název vytvořené tabulky, vyberte Vlastnosti a zkopírujte cestu k systému souborů Azure Blob (ABFS).

Otevřete poznámkový blok Azure Databricks. Přečtěte si tabulku Delta na OneLake.

olsPath = "abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample" df=spark.read.format('delta').option("inferSchema","true").load(olsPath) df.show(5)Aktualizujte data tabulky Delta změnou hodnoty pole.

%sql update delta.`abfss://<replace with workspace name>@onelake.dfs.fabric.microsoft.com/<replace with item name>.Lakehouse/Tables/nycsample` set vendorID = 99999 where vendorID = 1;