Jak vytvořit vlastní fondy Sparku v Microsoft Fabric

V tomto dokumentu vysvětlujeme, jak vytvořit vlastní fondy Apache Sparku v Microsoft Fabric pro analytické úlohy. Fondy Apache Spark umožňují uživatelům vytvářet přizpůsobená výpočetní prostředí na základě jejich specifických požadavků a zajistit optimální výkon a využití prostředků.

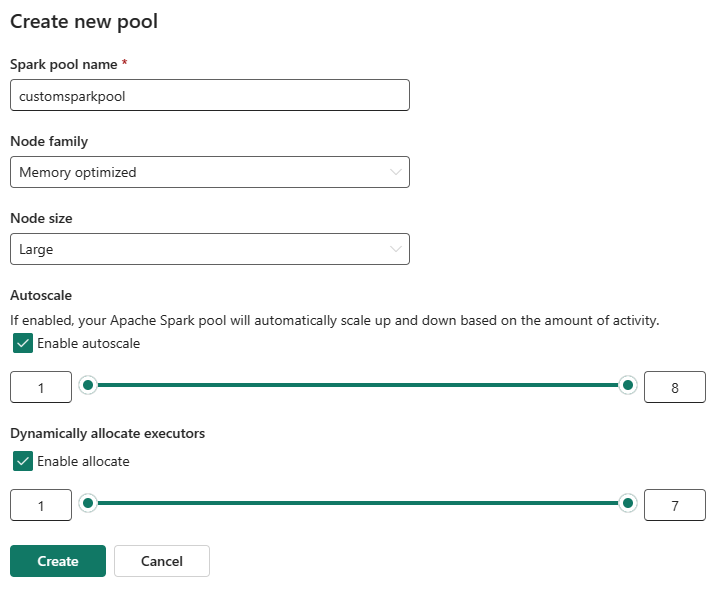

Zadáte minimální a maximální počet uzlů pro automatické škálování. Na základě těchto hodnot systém dynamicky získává a vyřadí uzly, protože se mění požadavky na výpočetní prostředky úlohy, což vede k efektivnímu škálování a lepšímu výkonu. Dynamické přidělování exekutorů ve fondech Sparku také snižuje potřebu ruční konfigurace exekutoru. Místo toho systém upraví počet exekutorů v závislosti na potřebách výpočetních prostředků na úrovni dat a úloh. Tento proces vám umožní soustředit se na úlohy, aniž byste se museli starat o optimalizaci výkonu a správu prostředků.

Poznámka:

Pokud chcete vytvořit vlastní fond Sparku, potřebujete přístup správce k pracovnímu prostoru. Správce kapacity musí povolit možnost Vlastní fondy pracovních prostorů v části Výpočty Sparku v nastavení Správa kapacity. Další informace najdete v tématu Výpočetní Nastavení Sparku pro kapacity prostředků infrastruktury.

Vytvoření vlastních fondů Sparku

Vytvoření nebo správa fondu Sparku přidruženého k vašemu pracovnímu prostoru:

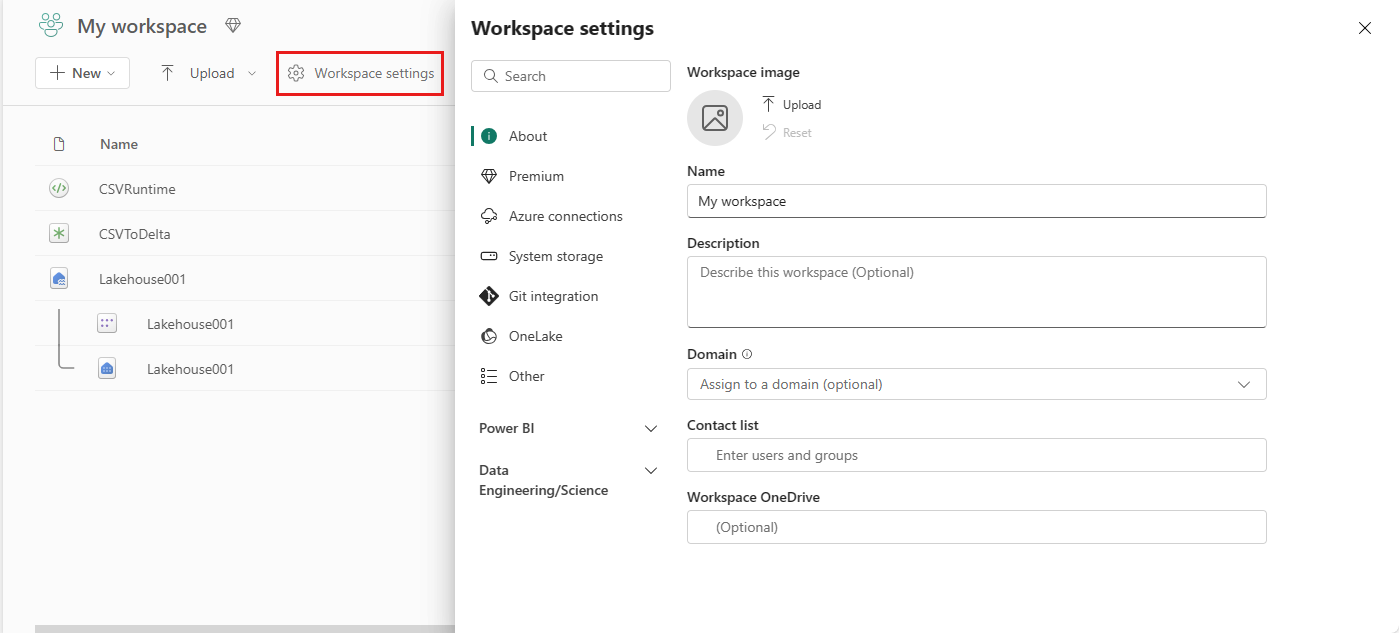

Přejděte do svého pracovního prostoru a vyberte Nastavení pracovního prostoru.

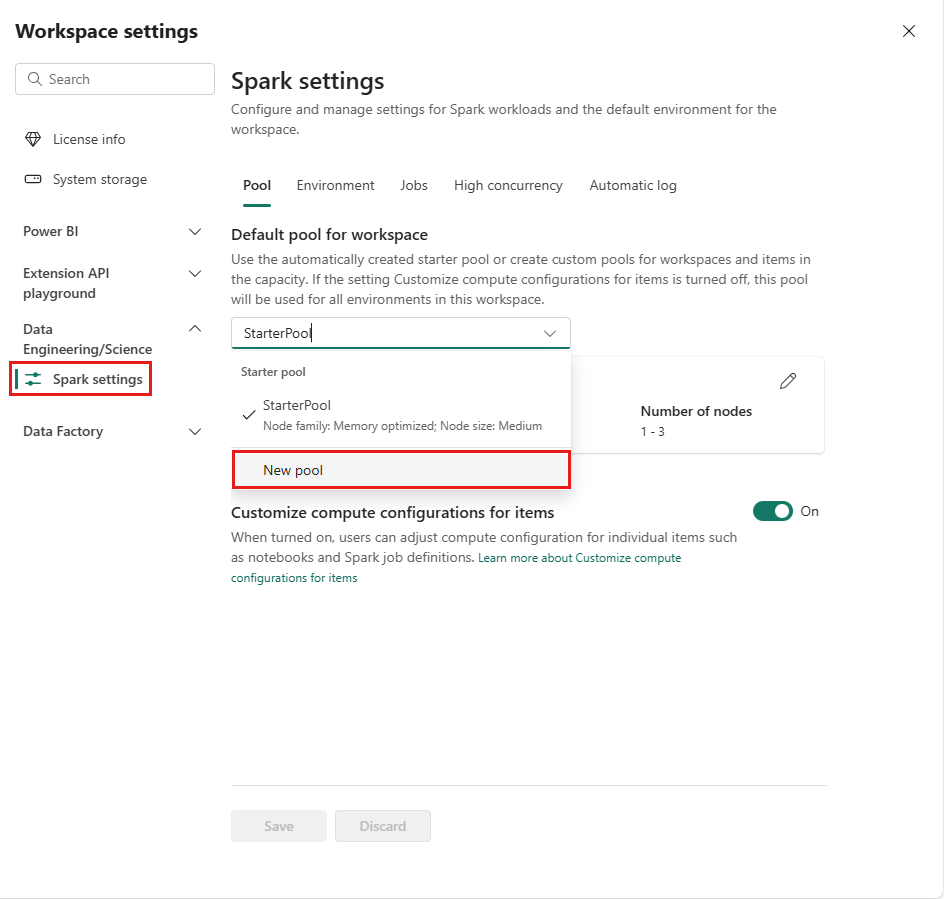

Výběrem možnosti Datoví technici/Věda rozbalte nabídku a pak vyberte Spark Compute.

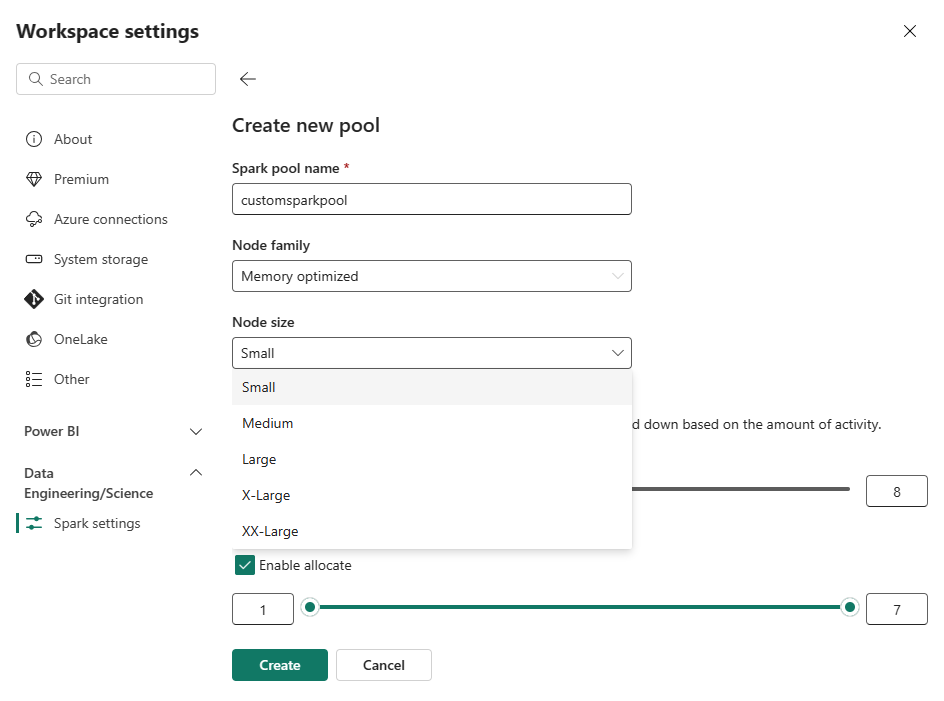

Vyberte možnost Nový fond. Na obrazovce Vytvořit fond pojmenujte fond Sparku. Zvolte také řadu uzlů a v závislosti na požadavcích na výpočetní prostředky pro vaše úlohy vyberte velikost uzlu z dostupných velikostí (Small, Medium, Large, X-Large a XX-Large).

Minimální konfiguraci uzlu pro vlastní fondy můžete nastavit na 1. Vzhledem k tomu, že Fabric Spark poskytuje obnovitelnou dostupnost pro clustery s jedním uzlem, nemusíte se starat o selhání úloh, ztrátu relace během selhání nebo platbu výpočetních prostředků za menší úlohy Sparku.

Automatické škálování pro vlastní fondy Sparku můžete povolit nebo zakázat. Pokud je povolené automatické škálování, fond dynamicky získá nové uzly až do maximálního limitu uzlu určeného uživatelem a potom je po provedení úlohy vyřadí. Tato funkce zajišťuje lepší výkon úpravou prostředků na základě požadavků úlohy. Uzly, které se vejdou do jednotek kapacity zakoupené jako součást skladové položky kapacity Fabric, můžete změnit jejich velikost.

Můžete také povolit přidělení dynamického exekutoru pro váš fond Spark, což automaticky určuje optimální počet exekutorů v rámci maximální hranice zadané uživatelem. Tato funkce upravuje počet exekutorů na základě objemu dat, což vede ke zlepšení výkonu a využití prostředků.

Tyto vlastní fondy mají výchozí dobu automatického pozastavení 2 minuty. Po dosažení doby trvání automatického pozastavení relace vyprší platnost a clustery se nepřidělí. Účtují se vám poplatky na základě počtu uzlů a doby trvání, po kterou se používají vlastní fondy Sparku.

Související obsah

- Další informace najdete ve veřejné dokumentaci k Apache Sparku.

- Začínáme s nastavením správy pracovního prostoru Sparku v Microsoft Fabric