Zodpovědná AI v úlohách Azure

Cílem zodpovědné umělé inteligence v návrhu úloh je zajistit, aby používání algoritmů umělé inteligence bylo spravedlivé, transparentnía inkluzivní. Principy zabezpečení rámce Microsoft Azure Well-Architected jsou vzájemně propojené a zaměřují se na důvěrnost a integritu. Bezpečnostní opatření musí být zavedena, aby se zachovala ochrana osobních údajů uživatelů, ochrana dat a ochrana integrity návrhu. Návrh by neměl být zneužitý pro nezamýšlené účely.

V úlohách AI modely často používají neprůspatnou logiku k rozhodování. Uživatelé by měli důvěřovat funkcím systému a mít jistotu, že modely dělají tato rozhodnutí zodpovědně. Je třeba zabránit nepřijatelnému chování, jako je manipulace, toxicita obsahu, porušování práv duševního vlastnictví a vytvářené reakce.

Zvažte případ použití, ve kterém chce společnost pro zábavu médií poskytovat doporučení pomocí modelů AI. Pokud společnost neimplementuje zodpovědnou AI a správné protokoly zabezpečení, může špatný aktér převzít kontrolu nad modely. Model může doporučit obsah, který způsobí poškození. V organizaci může toto chování vést k poškození značky, nebezpečným prostředím a právním problémům. Udržování vhodné bdělosti v průběhu životního cyklu systému je proto nezbytné a nezapomenutelné.

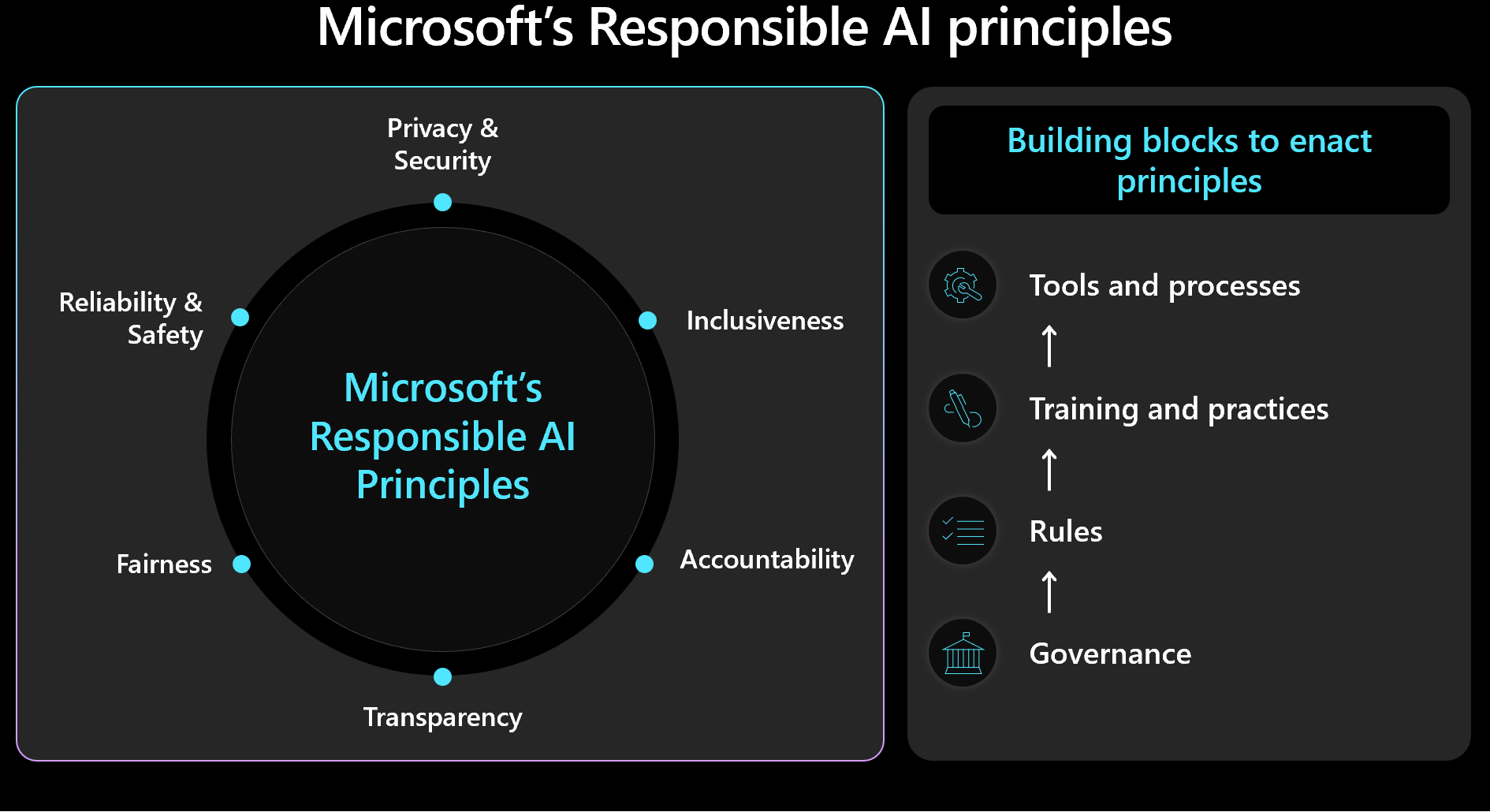

Při rozhodování o návrhu byste měli určit prioritu správy zabezpečení a úloh a mít na paměti lidské výsledky. Seznamte se s architekturou Microsoftu pro zodpovědné AI a ujistěte se, že v návrhu měříte a implementujete principy architektury. Následující obrázek znázorňuje základní koncepty architektury.

Důležité

Přesnost předpovědí a metrik pro zodpovědnou AI jsou obvykle vzájemně propojená. Zlepšením přesnosti modelu můžete zlepšit jeho nestrannost a sladění s realitou. Zodpovědná AI často odpovídá přesnosti, ale samotná přesnost nezahrnuje všechny bezpečnostní aspekty. Je důležité tyto zásady ověřit zodpovědně.

Tento článek obsahuje doporučení týkající se zodpovědného rozhodování, ověřování vstupu uživatele a pomoc při zajištění bezpečného uživatelského prostředí. Poskytuje také pokyny týkající se zabezpečení dat, které pomáhají chránit uživatelská data.

Doporučení

Následující tabulka shrnuje doporučení v tomto článku.

| Doporučení | Popis |

|---|---|

| Rozvíjet zásady, které vynucují morální praktiky v každé fázi životního cyklu. | Zahrnout položky kontrolního seznamu, které explicitně splňují požadavky na zabezpečení stavu a jsou přizpůsobené kontextu úloh. Mezi příklady patří transparentnost uživatelských dat, konfigurace souhlasu a postupy pro zpracování práva na zapomenutí (RTBF). ▪ Vyvíjejte zásady pro zodpovědnou umělou inteligenci ▪ Vynucování zásad správy politik pro zodpovědnou umělou inteligenci |

| Chránit uživatelská data s cílem maximalizovat ochranu osobních údajů. | Shromážděte pouze to, co je nezbytné a se správným souhlasem uživatele. Pomocí technických ovládacích prvků můžete chránit profily uživatelů, jejich dat a přístup k nim. ▪ zpracování uživatelských dat odpovídajícím způsobem ▪ Kontrola příchozích a odchozích dat |

| Uchovávejte rozhodnutí umělé inteligence jasná a srozumitelná. | Jasně vysvětlete, jak fungují algoritmy doporučení. Poskytněte uživatelům přehled o využití dat a algoritmickém rozhodování, které jim pomůže pochopit a důvěřovat procesu. ▪ Zajištění bezpečnosti uživatelského prostředí |

Vývoj zásad pro zodpovědnou AI

Zdokumentujte svůj přístup k zodpovědnému využití AI. Explicitně uveďte zásady, které použijete v každé fázi životního cyklu, aby tým rozuměl svým zodpovědnostem. Standardy Microsoftu pro zodpovědnou AI poskytují pokyny, ale musíte definovat, co tyto pokyny znamenají speciálně pro váš kontext.

Zásady by například měly obsahovat položky kontrolního seznamu pro mechanismy, které podporují transparentnost uživatelských dat a konfiguraci souhlasu. V ideálním případě by tyto mechanismy měly uživatelům umožnit vyjádřit výslovný nesouhlas s zahrnutím dat. Datové kanály, analýzy, trénování modelů a další fáze musí respektovat danou volbu. Dalším příkladem jsou postupy pro nakládání s RTBF. Pokud chcete učinit informovaná rozhodnutí, obraťte se na etickou oddělení vaší organizace a právní tým.

Vytvořte transparentní zásady pro použití dat a algoritmické rozhodování, které uživatelům pomůžou pochopit a důvěřovat procesu. Zdokumentovat tato rozhodnutí, aby se zachovala jasná historie potenciálních budoucích sporů.

Zodpovědná implementace umělé inteligence zahrnuje tři klíčové role: výzkumný tým, tým zásad a technický tým. Spolupráce mezi těmito týmy by měla být zprovozněna. Pokud má vaše organizace existující tým, použijte jejich práci. Jinak si tyto postupy nastavte sami.

Každý tým by měl mít své vlastní povinnosti. Například:

Výzkumný tým provádí zjišťování rizik konzultací organizačních pokynů, oborových standardů, zákonů, předpisů a známých taktik červeného týmu.

Tým zásad vyvíjí zásady specifické pro danou úlohu. Zahrnují pokyny z nadřazené organizace a nařízení státní správy.

technický tým implementuje zásady do svých procesů a dodávek. Tým ověřuje a testuje dodržování předpisů.

Každý tým formalizuje své pokyny, ale tým úloh musí být zodpovědný za vlastní zdokumentované postupy. Tým by měl jasně zdokumentovat všechny nadbytečné kroky nebo záměrné odchylky, aby se zajistilo, že neexistuje nejednoznačnost ohledně toho, co je povoleno. Tým by měl být také transparentní ohledně potenciálních nedostatků nebo neočekávaných výsledků řešení.

Vynucování zásad správného řízení pro zodpovědné AI

Navrhněte svou úlohu tak, aby vyhovovala organizačním a regulačním zásadám správného řízení. Pokud je například transparentnost požadavkem organizace, určete, jak se vztahuje na vaši úlohu. Identifikujte oblasti návrhu, životního cyklu, kódu nebo jiných součástí, ve kterých byste měli zavést funkce transparentnosti, které splňují tento standard.

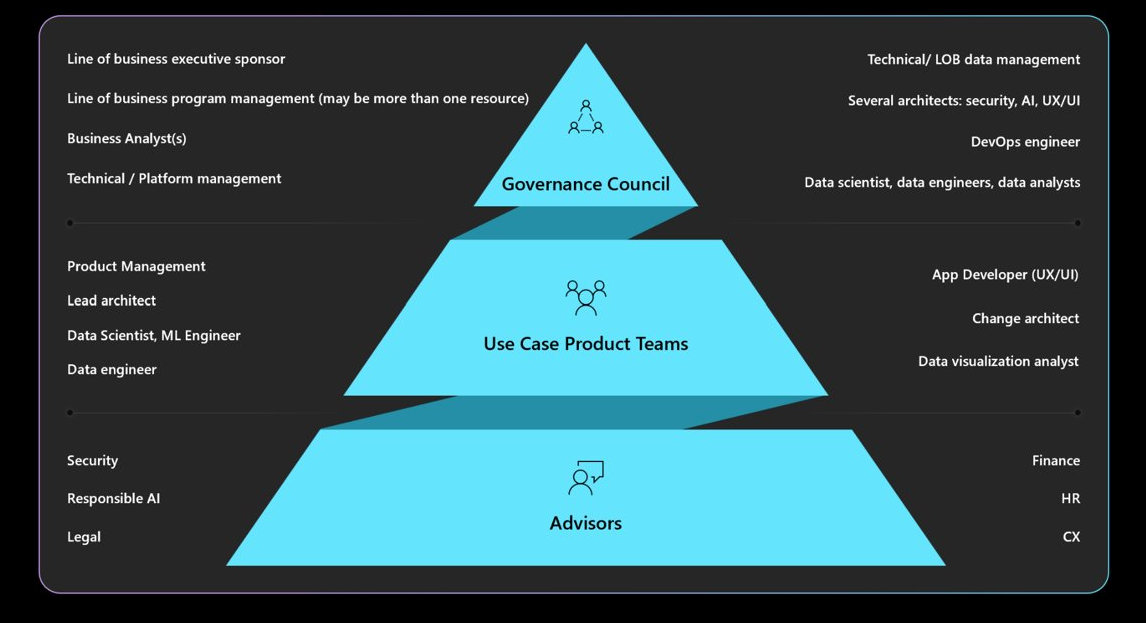

Seznamte se s požadovanými mandáty k zásadám správného řízení, zodpovědností, kontrolou a vytvářením sestav. Zajistěte, aby rada správního řízení schválila a podepsala návrhy zátěže, aby se zabránilo přepracování návrhu a zmírnily se obavy o bezpečnost nebo ochranu soukromí. Možná budete muset projít několika vrstvami schválení. Následující diagram popisuje typickou strukturu zásad správného řízení v organizaci.

Další informace o zásadách organizace a schvalovatelů najdete v tématu Definování zodpovědné strategie AI.

Zajištění bezpečnosti uživatelského prostředí

Uživatelská prostředí by měla vycházet z oborových pokynů. Použijte knihovnu Microsoft Human-AI Experiences Design Library, která obsahuje principy a poskytuje implementační pokyny. Poskytuje také příklady z produktů Microsoftu a dalších oborových zdrojů.

Během životního cyklu interakce s uživateli existují pracovní povinnosti. Začínají záměrem uživatele používat systém a pokračují v celé relaci i během jakýchkoli přerušení způsobených systémovými chybami. Zvažte následující postupy:

Vytvářejte transparentnost. Uvědomte si, jak systém generuje odpovědi na svůj dotaz.

Zahrnout odkazy na zdroje dat, které model používá pro předpovědi. Tento postup zvyšuje důvěru uživatelů tím, že jim ukáže původ informací. Návrh dat by měl obsahovat tyto zdroje v metadatech. Když například orchestrátor v aplikaci rozšířeném načítání provede vyhledávání, načte 20 bloků dokumentů a odešle prvních 10 bloků dat do modelu jako kontext. Prvních 10 bloků dat patří do tří různých dokumentů. Uživatelské rozhraní pak může odkazovat na tyto tři zdrojové dokumenty, když zobrazí odpověď modelu. Tato transparentnost zvyšuje důvěru uživatelů.

Transparentnost se stává důležitější, když používáte agenty, které fungují jako zprostředkovatelé mezi front-endovými rozhraními a back-endovými systémy. Například v systému lístků kód orchestrace interpretuje záměr uživatele a volá rozhraní API (Application Programming Interface) agentům za účelem načtení potřebných informací. Zveřejnění těchto interakcí pomáhá uživateli uvědomit si akce systému.

Pro automatizované pracovní postupy, které obsahují více agentů, vytvořte soubory protokolu, které zaznamenávají jednotlivé kroky. Soubory protokolu vám můžou pomoct identifikovat a opravit chyby. Poskytují také uživatelům vysvětlení rozhodnutí, která zprovozní transparentnost.

Upozornění

Při implementaci doporučení transparentnosti se vyhněte zahlcení uživatele příliš velkými informacemi. Přistupte postupně pomocí minimálně rušivých metod uživatelského rozhraní.

Například můžete zobrazit nástrojovou lištu, která uvádí skóre spolehlivosti z modelu. Můžete začlenit odkazy, jako jsou odkazy na zdrojové dokumenty, které uživatelé můžou vybrat pro další podrobnosti. Tato metoda iniciovaná uživatelem udržuje uživatelské rozhraní nedisruptivní a umožňuje uživatelům hledat další informace pouze v případě, že se rozhodnou.

Shromážděte zpětnou vazbu. Implementujte mechanismy zpětné vazby.

Vyhněte se zahlcení uživatelů rozsáhlými dotazníky po každé odpovědi. Místo toho používejte rychlé a jednoduché mechanismy zpětné vazby, jako jsou palce nahoru nebo palce dolů, nebo systém hodnocení pro konkrétní aspekty odpovědi ve stupni 1 až 5. Tyto metody pomáhají v průběhu času zlepšit systém a umožňují podrobnou zpětnou vazbu, aniž by byly rušivé. Mějte na paměti potenciální problémy s nestranností ve zpětné vazbě, protože můžou existovat sekundární důvody pro odpovědi uživatelů.

Implementace mechanismu zpětné vazby ovlivňuje architekturu kvůli potřebě úložiště dat. Zacházejte s názory jako s uživatelskými daty a podle potřeby použijte úrovně ochrany osobních údajů.

Kromě zpětné vazby na odpovědi shromážděte zpětnou vazbu o účinnosti uživatelského prostředí. Shromážděte metriky zapojení prostřednictvím monitorovacího stacku systému.

Zprovoznění bezpečnostních opatření pro obsah

Integrujte bezpečnost obsahu do každé fáze životního cyklu umělé inteligence pomocí vlastního kódu řešení, vhodných nástrojů a efektivních postupů zabezpečení. Zvažte následující strategie:

Anonymizovat data. Při přesunu dat od příjmu dat do trénování nebo vyhodnocení implementujte kontroly tak, aby se minimalizovalo riziko úniku osobních informací a zabránilo nezpracovaným uživatelským údajům.

Moderování obsahu Použijte rozhraní API pro zabezpečení obsahu, které vyhodnocuje požadavky a odpovědi v reálném čase. Ujistěte se, že tato rozhraní API jsou dostupná.

Identifikace a zmírnění hrozeb Použití dobře známých postupů zabezpečení ve scénářích AI Proveďte například modelování hrozeb a zdokumentujte hrozby a způsob jejich zmírnění. Typické postupy zabezpečení, jako jsou červená týmová cvičení, platí pro úlohy AI. Červené týmy můžou testovat, jestli mohou být modely manipulovány a generovat škodlivý obsah. Tyto aktivity by měly být integrované do operací umělé inteligence.

Informace najdete v tématu Plánování červeného seskupování pro velké jazykové modely a jejich aplikace.

Použijte správné metriky. Používejte metriky, které efektivně měří chování modelu. Metriky se liší v závislosti na typu modelu AI. V některých případech se měření generativních modelů nemusí vztahovat na regresní modely. Model například předpovídá očekávanou délku života a výsledky ovlivňují pojistné sazby. Problémy s nestranností v tomto modelu můžou vést k poškození souvisejícím se nestranností. Tento problém vychází z odchylek v základním testování metrik, protože metriky nestrannosti a přesnosti jsou obvykle vzájemně propojené. Zlepšení přesnosti, aby se snížily škody související se spravedlností.

Přidejte odpovídající instrumentaci. Výsledky modelu AI musí být vysvětlené. Je nutné odůvodnit a sledovat, jak se provádí odvozování, včetně trénovacích dat, počítaných funkcí a podkladových dat. V nerozlišující umělé inteligenci můžete rozhodnutí ospravedlnit krok za krokem. U generativních modelů ale může být vysvětlení výsledků složité. Zdokumentujte rozhodovací proces pro řešení potenciálních právních dopadů a zajištění transparentnosti.

Tento aspekt vysvětlitelnosti byste měli implementovat v celém životním cyklu umělé inteligence. Čištění dat, rodokmen, kritéria výběru a zpracování jsou kritické fáze, kdy by se měla sledovat rozhodnutí.

Nástroje

Integrujte nástroje pro bezpečnost obsahu a sledovatelnost dat, jako je Microsoft Purview. Rozhraní API pro zabezpečení obsahu Azure AI je možné volat z testování, aby se usnadnilo testování bezpečnosti obsahu.

Azure AI Foundry poskytuje metriky, které vyhodnocují chování modelu. Další informace najdete v tématu Vyhodnocení a monitorování metrik pro generování umělé inteligence.

Pro trénink modelů se podívejte na metriky , které poskytuje Azure Machine Learning.

Kontrola příchozích a odchozích dat

Útoky prostřednictvím injektáže výzvy, jako je například jailbreak, jsou běžným problémem pro úlohy umělé inteligence. V takovém případě se někteří uživatelé můžou pokusit model zneužít k nezamýšleným účelům. Abychom zajistili bezpečnost, inspektujeme data, abychom zabránili útokům a vyfiltrovali nevhodný obsah. Tuto analýzu použijte na vstup uživatele i odpovědi systému, které pomáhají zajistit důkladnou moderování obsahu v příchozích tocích a odchozích tocích.

V některých případech je potřeba provést několik volání modelu, například prostřednictvím služby Azure OpenAI, a obsluhovat tak jeden požadavek klienta. V těchto scénářích může být použití kontrol bezpečnosti obsahu na každé vyvolání nákladné a zbytečné. Zvažte centralizaci, která funguje v architektuře a současně zachovává zabezpečení jako odpovědnost na straně serveru. Předpokládejme, že architektura má před koncovým bodem inferencí modelu bránu, aby odlehčila specifické schopnosti back-endu. Tuto bránu můžete navrhnout tak, aby zpracovávala bezpečnostní kontroly obsahu pro požadavky a odpovědi, které back-end nemusí nativně podporovat. I když je brána běžným řešením, vrstva orchestrace dokáže tyto úlohy efektivně zvládnout v jednodušších architekturách. V obou případech můžete tyto kontroly selektivně aplikovat podle potřeby, což optimalizuje výkon a náklady.

Kontroly by měly být multimodální a měly by zahrnovat různé formáty. Pokud používáte multimodální vstupy, například obrázky, je důležité je analyzovat skryté zprávy, které můžou být škodlivé nebo násilné. Tyto zprávy nemusí být okamžitě viditelné, takže vyžadují pečlivou kontrolu. K tomuto účelu používejte nástroje, jako jsou rozhraní API pro bezpečnost obsahu.

Pokud chcete vynutit zásady ochrany osobních údajů a zabezpečení dat, zkontrolujte uživatelská data a základní data, aby byla v souladu s předpisy o ochraně osobních údajů. Ujistěte se, že jsou data sanitizovaná nebo filtrovaná při procházení systémem. Například data z předchozích konverzací zákaznické podpory můžou sloužit jako podkladová data. Tato data by měla být před opětovným použitím sanitována.

Zpracování uživatelských dat odpovídajícím způsobem

Zodpovědné postupy zahrnují pečlivé zpracování správy uživatelských dat. Tato správa zahrnuje znalost, kdy používat data a kdy se vyhnout spoléhat na uživatelská data.

Procvičte si odvozování bez sdílení uživatelských dat. Pokud chcete bezpečně sdílet uživatelská data s jinými organizacemi pro přehledy, použijte model clearinghouse. V tomto scénáři organizace poskytují data důvěryhodnému partnerovi, který model trénuje pomocí agregovaných dat. Všechny instituce pak můžou tento model používat a sdílet přehledy bez zveřejnění jednotlivých datových sad. Cílem je použít možnosti odvozování modelu bez sdílení podrobných trénovacích dat.

Propagujte rozmanitost a inkluzi. Pokud jsou potřebná uživatelská data, použijte k zmírnění škod souvisejících se nestranností různorodou řadu dat, včetně nedostatečně zastoupených žánrů a tvůrců. Implementujte funkce, které uživatelům povzbuzovat, aby prozkoumali nový a pestrý obsah. Průběžně monitorujte využití a upravte doporučení, abyste se vyhnuli překryvným typům obsahu.

Respektujte RTBF. Pokud je to možné, vyhněte se používání uživatelských dat. Pomozte zajistit soulad s RTBF tím, že máte potřebná opatření k zajištění toho, aby se uživatelská data odstranila pečlivě.

Aby bylo možné zajistit dodržování předpisů, můžou existovat žádosti o odebrání uživatelských dat ze systému. U menších modelů můžete uživatelská data odebrat opětovným trénováním modelu pomocí dat, která vylučují osobní údaje. U větších modelů, které se můžou skládat z několika menších, nezávisle natrénovaných modelů, je proces složitější a náklady a úsilí je významné. Vyhledejte právní a etické pokyny k řešení těchto situací a nezapomeňte do svých zásad zahrnout příslušnéumělé inteligence .

Zodpovědné uchovávání dat. Pokud odstranění dat není možné, získejte explicitní souhlas uživatele pro shromažďování dat a poskytněte jasné zásady ochrany osobních údajů. Shromažďování a uchovávání dat pouze v případě, že je to nezbytně nutné. Mějte připravené operace, abyste data efektivně odstranili, když už je nepotřebujete. Například vymažte historii chatu hned, jak je to praktické, a před uchováváním anonymizujte citlivá data. Pro data v klidovém stavu použijte pokročilé metody šifrování.

Podporujte vysvětlitelnost Sledujte rozhodnutí v systému, která podporují požadavky na vysvětlitelnost. Vyvinout jasné vysvětlení, jak fungují algoritmy doporučení. Poskytněte uživatelům přehled o tom, proč se jim doporučuje konkrétní obsah. Cílem je zajistit, aby úlohy AI a jejich výsledky byly transparentní a ospravedlitelné tím, že podrobně popisuje, jak se rozhodují, jaká data používají a jak byly modely natrénovány.

Šifrování uživatelských dat Vstupní data musí být zašifrována v každé fázi kanálu zpracování dat od okamžiku, kdy uživatel zadává data. Mezi tyto fáze patří data, která se přesunou z jednoho bodu do druhého, uložená data a data, která jsou v případě potřeby odvozená. Vyvážení zabezpečení a funkčnosti a cílem zachování soukromí dat v průběhu životního cyklu.

Poskytuje robustní řízení přístupu. Několik typů identit může potenciálně přistupovat k uživatelským datům. Implementujte řízení přístupu na základě role pro řídicí rovinu i rovinu dat tak, aby zahrnovalo komunikaci mezi uživateli a systémem.

Udržujte správnou segmentaci uživatelů pro ochranu osobních údajů. Microsoft 365 Copilot může například vyhledávat a poskytovat odpovědi na základě konkrétních dokumentů a e-mailů uživatele a zároveň zajistit přístup jenom k obsahu relevantnímu pro daného uživatele.

Zmenšete plochu povrchu. Základní strategií pilíře zabezpečení architektury Well-Architected je minimalizace prostoru pro útoky a posílení prostředků. Tuto strategii byste měli použít na standardní postupy zabezpečení koncových bodů tím, že úzce řídíte koncové body rozhraní API, vystavujete pouze důležitá data a v odpovědích se vyhnete nadbytečným informacím. Vyvážení výběru návrhu mezi flexibilitou a kontrolou

Ujistěte se, že neexistují žádné anonymní koncové body. Obecně platí, že uživatelům nebudete dávat větší kontrolu, než je potřeba. Ve většině scénářů nemusí uživatelé upravovat hyperparametry s výjimkou experimentálních prostředí. U typických případů použití, jako je například interakce s virtuálním agentem, by uživatelé měli řídit pouze základní aspekty, které pomáhají zajistit zabezpečení omezením zbytečné kontroly.

Další informace najdete v tématu Návrh aplikace pro úlohy AI v Azure.