MLOps a GenAIOps pro úlohy AI v Azure

Operace úloh AI jsou zaměřeny na curation of data and consumption of that data. Provoz zajišťuje efektivitu při dosahování a udržování kvality, spolehlivosti, zabezpečení, etiky a dalších standardů, které u úlohy upřednostňujete.

Úlohy úloh je možné zařadit do tří hlavních oblastí: vývoj aplikací, zpracování dat a správa modelů AI. Každá kategorie by měla využívat osvědčené provozní metodologie, jako jsou DevOps, DataOps, MLOps a GenAIOps.

Aktivity DevOps pokrývají celou správu životního cyklu vývoje aplikací prostřednictvím automatizovaných kanálů kontinuální integrace a průběžného nasazování (CI/CD) a monitorování. U úloh umělé inteligence je ale datový kanál jednou ze základních komponent. DataOps, specializace DevOps, se zaměřuje na správu životního cyklu dat zefektivňováním procesů, jako je extrakce, transformace a načítání (ETL/ELT). Odborníci na dataOps obvykle měří výkon toku dat a účinnost čištění dat a monitorují kanál pro anomálie.

Úlohy AI jsou ze své podstaty nedeterministické. Řada modelů AI je náchylná k vytváření různých odpovědí na stejný dotaz během odvozování. Tyto úlohy potřebují procesy, které můžou spravovat a přizpůsobovat se neprediktovatelnosti výstupů umělé inteligence. DataOps se rozšiřuje na MLOps, což zprovozňuje pracovní postupy strojového učení pro trénování a testování modelů. GenAIOps, specializovaná podmnožina MLOps, cílí na generování řešení umělé inteligence. Zahrnuje úlohy, jako je zjišťování modelů a upřesnění předem natrénovaných modelů s obohacenými daty.

Provozní činnosti se často překrývají a různé metodologie se vztahují na různé stupně. Například u nerozlišující umělé inteligence hraje DataOps významnou roli, zatímco aktivity DevOps jsou méně významné. Naopak v generativní umělé inteligenci spoléhá efektivita provozu na DevOps mnohem silněji než Na DataOps.

Bez ohledu na to, že celkový cíl je doručování schopností s efektivními operacemi v průběhu životního cyklu vývoje. Očekávané výsledky jsou:

- Opakovatelné procesy s konzistentními výsledky

- Trvalou přesnost modelů v průběhu času.

- Efektivní zásady správného řízení, které minimalizuje rizika.

- Procesy správy změn pro přizpůsobení se posunu modelu

Automatizace a monitorování jsou vaše klíčové provozní strategie pro dosažení těchto cílů.

Potřebujete také vytvořit standardizované procesy pro komponenty AI, pro rutinní, neplánované a nouzové operace a mít správné mechanismy sledování. Beztěchtoch

- Opakované chyby a nerereproduibility při zpracování dat, hostování modelů, řízení uzemnění dat a další úlohy.

- Nízká kvalita nebo zastaralá data používaná pro trénování a upřesnění modelu.

- Dopad na důvěru koncových uživatelů v systému v nejhorším případě vede k právním problémům, dodržování předpisů nebo zabezpečení.

Musíte implementovat zavedené procesy se správnou sadou nástrojů. Specializované nástroje jsou k dispozici pro správu pracovních postupů umělé inteligence a strojového učení v různých prostředích.

Tento článek se zaměřuje na strategii návrhu operací a poskytuje doporučení k nástrojům.

Doporučení

Tady je souhrn doporučení uvedených v tomto článku.

| Doporučení | Popis |

|---|---|

| Návrh efektivního životního cyklu provozu úloh | Na základě komponent vaší úlohy AI se různé provozní fáze použijí na jeho životní cyklus. Je důležité, abyste porozuměli osvědčeným postupům, které jsou pro váš scénář relevantní, a nástrojům, které máte k dispozici k jejich implementaci. Chvíli se seznamte s klíčovými doporučeními pro všechny komponenty vaší úlohy a implementujte je. ▪ DataOps ▪ MLOps ▪ GenaiOps ▪ Monitorování |

| Automatizujte všechno. | Automatizace zajišťuje opakovatelnost a efektivitu životního cyklu úlohy. I když jsou procesy DevOps klíčovým přispěvatelem, je potřeba provést další kroky k efektivnímu sestavování, testování, ověřování a nasazování modelů. ▪ Automatizace |

| Pokud je to možné, využijte kanály nasazení. | Kanály nasazení vám můžou pomoct dodávat opakovatelná nasazení infrastruktury nebo průběžně integrovat kód. Jsou také skvělým nástrojem pro vytváření a ověřování modelů před jejich povýšením do produkčního prostředí. Implementace kanálů nasazení vám pomůže zlepšit spolehlivost a také celkové uživatelské prostředí vaší úlohy. ▪ Kanály nasazení |

| Zabraňte posunu a rozkladu ve vašich modelech. | Musíte se chránit před rozpadem a posunem modelu a zároveň mít strukturovaný proces, který vám pomůže přijmout změny nového modelu řízeným způsobem. Když budete dodržovat doporučení týkající se údržby modelů, budete se muset vyhnout neočekávaným uživatelským zkušenostem a poskytovat aktuální službu. ▪ Údržba modelu |

Životní cyklus provozu úloh

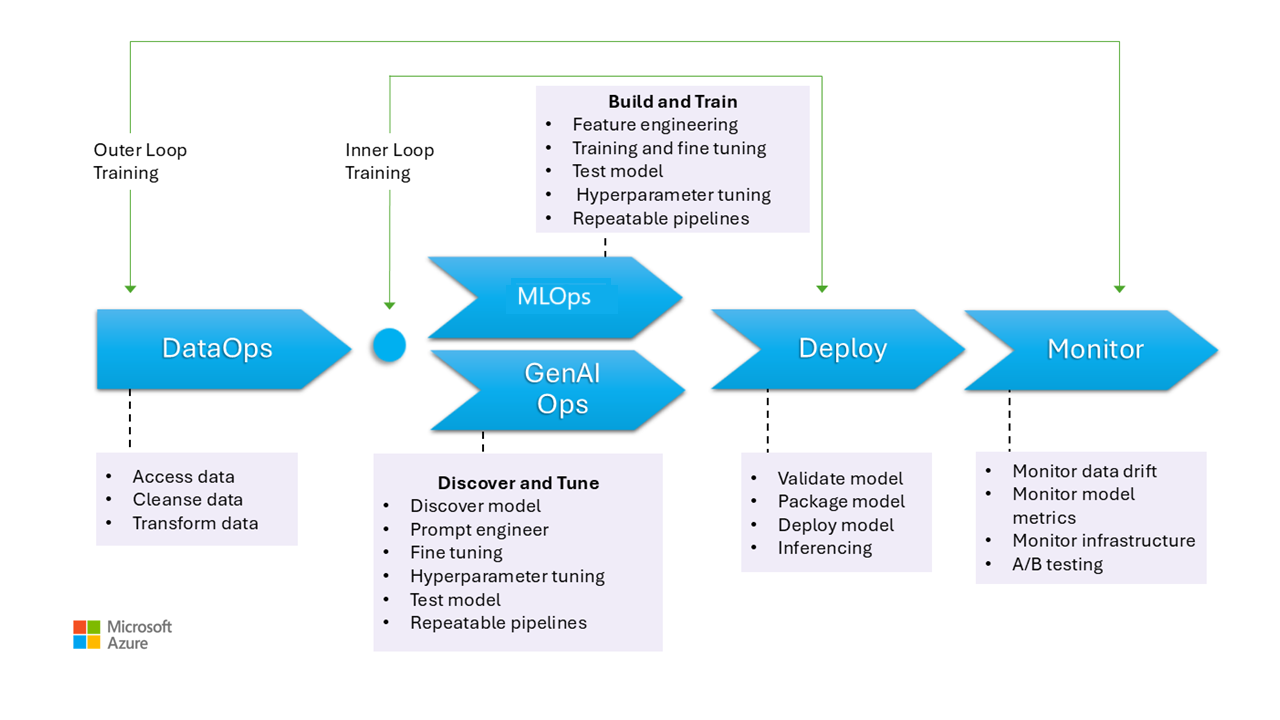

Tento obrázek znázorňuje provozní fáze modelů AI, včetně shromažďování dat, čištění dat za účelem odstranění nekonzistence nebo chyb a transformace dat do analyzovatelného formátu. Tyto fáze jsou relevantní pro trénování diskriminativních modelů i podkladových dat v generačních modelech. Konkrétní případ použití generovacích modelů trénování se ale na tomto obrázku nezobrazuje. Tento případ použití spadá mimo rozsah tohoto článku.

Fáze MLOps a GenAIOps jsou podobné. Hlavní rozdíl spočívá v tom, že v případě GenAIOps se zaměření přesune z trénování na výběr správného modelu, rychlého inženýrství a začlenění znalostí specifických pro doménu prostřednictvím jemného ladění nebo implementace načítání rozšířené generace (RAG).

I fáze nasazení a monitorování jsou poměrně podobné.

Následující části popisují běžné provozní postupy. Pokrývají všechny fáze životního cyklu, od předprodukce až po produkční prostředí.

DataOps

Data se agregují z různých produkčních zdrojů dat a pak se předzpracují, aby se odstranily chyby a nekonzistence a zpracovávaly chybějící hodnoty. Nakonec se transformuje a normalizuje do vhodného formátu pro trénování nebo rozšiřování. Aspekty návrhu jsou popsány v článcích o trénovacích datech a uzemnění dat .

Procesy operací s daty v této fázi by měly být efektivní, protože zpracování velkých objemů dat z více zdrojů a složitých datových kanálů může být náročné. Přístupy, které potřebujete k zajištění toho, aby tato fáze vytvářela vysoce kvalitní data. Monitorujte tuto fázi a sledujte pokrok směrem k přijatelnému panelu kvality.

Musíte také zajistit, aby byla data zabezpečená, protože data pocházejí z produkčního prostředí. Ujistěte se, že nižší prostředí, jako je vývoj/testování, jsou stejně zabezpečená jako produkční prostředí, aby se zabránilo jakýmkoli problémům se zabezpečením.

Poznámka:

Řešení nízkých kvalitních dat investicemi do rozsáhlého čištění dat během počátečních fází. Využijte dobře známé analytické vzory, jako jsou medailión, datové sítě a úložiště funkcí, k provádění upstreamových úloh zpracování. Pokud jsou nadřazené fáze neefektivní, musíte zlepšit kvalitu během podřízených fází, což vede ke zvýšení nákladů na úlohy, protože během každé fáze probíhá příprava dat.

Informace o úlohách zpracování dat najdete v těchto článcích:

Nástroje

Doporučujeme standardizovat nástroje orchestrace dat vaší úlohy. Nástroje by měly být schopné poskytnout datový kanál, který může seskupit aktivity a který má integrovanou automatizaci.

Kanál služby Azure Data Factory může být počáteční volbou. Dokáže efektivně připojit a zpracovávat mnoho zdrojů dat. Můžete také zvážit Službu Azure Synapse Analytics, která kombinuje velké objemy dat a datové sklady a podporuje datová jezera, Apache Spark a Azure Synapse SQL. Integruje se také se službou Data Factory pro ETL.

Kanály Azure Machine Learning pro přípravu trénovacích dat poskytují specializované funkce, které můžou automatizovat úlohy, jako je shromažďování a zpracování dat.

Oblíbené volby jsou opensourcové technologie, jako je Pandas (pro přípravu dat) a Scrapy.

MLOps

Trénování modelu je proces výběru vhodných algoritmů a poskytnutí předem zpracovaných historických dat a pozorování, které modelu umožní naučit se vzory a vytvářet předpovědi.

Trénování modelu (přípravy funkcí) a ladění hyperparametrů jsou iterativní procesy a jsou nákladné. Během každé iterace sledují datoví vědci výsledky pomocí kombinací dat, kódu a parametrů. Pomocí opakovatelných kanálů můžete sledovat experimenty s minimálním ručním úsilím, dokud nedosáhnete správné úrovně přesnosti.

Dalším provozním problémem je zřizování a škálování specializovaných výpočetních prostředků , ve kterých se provádějí experimenty. Měli byste také efektivně zabalovat a publikovat modely .

Týmy můžou začít s vývojem založeným na uživatelském rozhraní, aby snížily výzvy a s větší jistotou přešly na přístup založený na kódu.

Nástroje

Doporučujeme používat nástroje, které můžou sledovat experimenty strojového učení zachytáváním podrobností, jako jsou verze kódu, prostředí, parametry, spuštění a výsledky. MLflow je jednou z těchto opensourcových architektur. Zvažte použití pracovních prostorů Azure Machine Learning, které jsou kompatibilní s MLflow a poskytují zjednodušený pracovní postup, který datovým vědcům umožňuje spravovat produktivitu a reprodukovatelnost ve svých projektech. Pokud chcete spravovat vývoj kódu pomocí sledování správy zdrojového kódu, integrujte kanál strojového učení se správou zdrojového kódu, jako je GitHub, nebo použijte sdílené složky.

Hostování výpočetních prostředků může také ovlivnit váš výběr orchestrátoru pracovního postupu. Pokud je vaše aplikace hostovaná ve službě Azure Kubernetes Service (AKS), zvažte použití kubeflow.

Pokud uvažujete o službě Azure Machine Learning, doporučujeme začít s perspektivou architektury Azure Well-Architected Framework ve službě Machine Learning , abyste pochopili, jak vám může produkt pomoct s ohledem na kvalitu dobře navrženou architekturu.

Součástí výhod tohoto procesu je optimalizace osobního času. Datoví vědci obvykle potřebují konkrétní nástroje a sady SDK k efektivnímu provádění průzkumných analýz dat (EDA) a experimentování ze svých pracovních stanic. Vyhodnoťte, jestli jsou předem připravené možnosti ve službě Azure Machine Learning vhodné. Pokud ne, uložte konfiguraci pracovní stanice nebo udržujte schválené image virtuálních počítačů pro tuto práci. Jedním z příkladů image, kterou můžete použít jako výchozí bod, je Datová Věda virtuální počítač (DSVM).

V některých případech může být používání virtuálních počítačů zakázáno zásadami. Hledejte alternativy, jako je přidání Microsoft Dev Boxu a Azure Virtual Desktopu. Můžete také zvážit použití Dockeru k bootstrap počítačům, které obsahují předem připravené image.

Vzhledem k tomu, že tato fáze zraje a potřebujete rozšířené experimenty, přejděte do spravovaných výpočetních instancí a upřednostněte možnosti integrované jako součást pracovního postupu. Vyhodnoťte, jestli můžete výpočetní instance služby Azure Machine Learning použít k trénování a odvozování pro účely vývoje a testování. Výpočetní clustery můžou zpracovávat velké datové sady a složité modely.

Azure Machine Learning poskytuje řešení založená na kódu prostřednictvím sady SDK i možností s nízkými kódy, jako je automatizované strojové učení a vizuální návrhář. Sada Python SDK nabízí různé způsoby trénování modelů, z nichž každá má různé funkce. Machine Learning také podporuje pokročilé technologie optimalizace a distribuovaného computingu, jako je ORTModule, DeepSpeed a LoRA onNX Runtime Training, aby se urychlil proces trénování.

GenaiOps

Klíčové aktivity v této fázi začínají zjišťováním a vyhodnocováním existujících modelů , aby bylo možné určit, který je předem natrénovaný pro konkrétní případ použití. Jedná se o iterativní proces. Jakmile najdete vhodný model, může být přínosem zpřesnění pro uzemnění specifické pro doménu, což zahrnuje také iterativní kroky a vyžaduje určitou úroveň orchestrace.

Integrace a nasazování modelů vyžaduje specializované nástroje a postupy, které překračují tradiční funkce MLOps, včetně orchestrace modelů, vektorových indexů, výzev a bloků kódu.

Nástroje

Pokud chcete řešit úlohy zjišťování, využijte katalogy modelů, které zahrnují modely od různých poskytovatelů. Katalog modelů na portálu Azure AI Foundry umožňuje efektivně vyhodnotit z kurátorovaných kolekcí a efektivně nasazovat modely.

Tok výzvy služby Azure Machine Learning vám může pomoct s vývojem kódu orchestrace, povolením vytváření prototypů, experimentováním, iterací a výzvou k výpočtu. Tyto toky je možné nasadit do spravovaných koncových bodů služby Azure Machine Learning. Vyhodnoťte, jestli můžete toky spouštět a nasazovat pomocí stávající technologie kanálu CI/CD.

Nasazení

Během této fáze se model nasadí na platformu pro hostování a odvozování nebo na obsluhu vrstvy úloh AI. Rozhraní API je potřeba zabalit jako škálovatelný kontejner. Platforma kontejneru může být spravovaná výpočetní nebo vlastní hostitelská platforma. Provozní postupy by měly zajistit bezpečné nasazení a povolit vrácení zpět.

Začněte s platformou jako službou (PaaS) a bezserverovými řešeními, jako je Azure OpenAI Service, která zjednodušují přechod a správu. Zvažte použití bezserverového rozhraní API služby Azure Machine Learning pro agregaci přístupu ke koncovým bodům. Spravované výpočetní clustery jsou realizovatelnou možností pro pokročilé potřeby. Samoobslužné hostování v AKS je další možností. Ujistěte se, že máte správnou velikost výpočetních prostředků a udržujete správnou izolaci od jiných úloh. Můžete také zvážit možnosti, jako je úplné hostování modelu jako infrastruktura jako služba (IaaS). IaaS poskytuje flexibilitu, ale může přidávat provozní zátěž. Tyto možnosti jsou popsány v aplikační platformě.

Tato fáze představuje poslední šanci zachytit problémy před přesunem modelu do produkčního prostředí. Testovací procesy by měly zahrnovat ověřovací kroky, aby se zajistilo, že je model nakonfigurovaný tak, aby poskytoval předpovědi podle očekávání.

Model byste měli integrovat do stávajícího produkčního prostředí pomocí progresivních procesů expozice a použití souběžných nasazení. Kanárový model představuje běžný způsob, jak zavést nové modely. S touto metodou se uživatelská základna zvyšuje postupně. Modré-zelené nasazení je další metoda.

Nástroje

K nasazení modelů pro odvozování můžete použít kanály Azure Machine Learning nebo Azure Pipelines . Machine Learning poskytuje několik funkcí pro zjednodušené operace, včetně zřizování uzlů, aktualizací operačního systému, automatického škálování, monitorování a izolovaných virtuálních sítí.

Machine Learning také podporuje modré zelené nasazení, které umožňuje jednomu koncovému bodu obsahovat více nasazení.

Pokud používáte jiné hostitelské platformy, jako je Azure Container Apps nebo Aplikace Azure Service, zodpovídáte za operace, včetně zřizování a škálování. V těchto případech používejte kanály Azure DevOps, Kanály GitHubu nebo volbu technologie CI/CD.

Sledování

Monitorování je klíčovou strategií a používá se ve všech fázích. Jedná se o průběžný proces a slouží jako vstup do bran kvality, které zajišťují důkladné testování úloh umělé inteligence, aby se zachovala konzistence a spolehlivost v průběhu životního cyklu vývoje. Modely musí být monitorovány z hlediska provozních i datových věd.

Důrazně doporučujeme, abyste měli proces monitorování vnitřní smyčky DataOps, který měří blízkost panelu kvality přijetí a kontroluje anomálie.

U předem natrénovaných modelů je také důležité monitorovat posun a výkon dat s primárním zaměřením na levnost. Vyhodnoťte vstupy (výzvy) a výstupy (dokončení), abyste měli jistotu, že jsou relevantní a přesné. Kromě toho mějte na paměti bezpečnostní rizika, jako jsou pokusy o manipulaci s chováním modelu prostřednictvím škodlivých výzev. Ujistěte se, že existuje důkladná konfekce režim stanu, která kontroluje data v obou směrech a filtruje nevhodný obsah. Tyto aspekty jsou popsány v oblasti návrhu ResponsibleAI.

Po nasazení jsou operace monitorování nezbytné k řešení problémů, jako je rozpad modelu. Modely se můžou stát zastaralými kvůli změnám dat nebo externím změnám, které můžou způsobit, že model vytvoří irelevantní výsledky. Jako proaktivní opatření používejte automatizované procesy pro průběžné monitorování a vyhodnocujte a znovu natrénujte, abyste zachovali přesnost a relevanci. Kromě toho potřebujete monitorovat metriky infrastruktury a úloh stejně jako u jiných úloh, abyste zajistili optimální výkon a spolehlivost. Další informace naleznete v tématu Testování pro rozklad modelu.

Nástroje

Investujte do nástrojů, které usnadňují shromažďování metrik z koncových bodů odvozování, jako je kolektor dat Azure Machine Learning.

Potřebujete také pozorovatelnost výkonu modelu, posunu dat a bezpečnosti a kvality pro generování umělé inteligence.

Další informace naleznete v těchto článcích:

Automation

Úlohy AI jsou složité, protože celkový životní cyklus zahrnuje mnoho rolí, častých změn a vzájemně propojených kroků. Ruční procesy můžou být náchylné k chybám a nekonzistencem. Automatizace při hostování modelů zpracování dat pomáhá zajistit opakovatelnost a efektivitu. Automatizace není vždy povinná, ale představuje efektivní způsob správy těchto složitostí. Tady je několik případů použití, kdy automatizace může zmírnit rizika:

Na rozdíl od tradičního nasazení kódu vyžadují nedeterministické modely a řešení v AI nebo strojovém učení iterativní experimentování a trénování. Když více týmů spolupracuje, automatizace jako způsob, jak vynucovat standardizované procesy, může pomoci udržovat konzistenci, reprodukovatelnost a efektivní spolupráci mezi datovými vědci, inženýry a provozními týmy.

Životní cyklus modelu zahrnuje dva hlavní typy trénování:

Online trénování zahrnuje do modelu často, někdy denně poslední data, aby se zajistilo, že rozhodnutí jsou založená na nejnovějších informacích. Toto trénování je integrováno do úlohy, aby se model průběžně aktualizoval jako součást běžného procesu.

Offline trénování trénuje model méně často, což umožňuje delší mezeru mezi aktualizacemi. Proces trénování je oddělený od hlavní úlohy a provádí se asynchronně. Jakmile je nový model připravený, je pak integrovaný do systému.

Spolehlivost může být ohrožena v případě, že aktualizace nejsou časté. Pokud se aktualizace zmešká, je možné ji odložit bez velkých problémů. Tento koncept platí také pro zemnění dat. Pokud například používáte RAG, musíte se rozhodnout, jestli potřebujete použít nedávná data nebo jestli jsou trochu starší data dostatečná. Oba scénáře zahrnují vyvážení potřeby aktuálních informací s praktičností četnosti aktualizací. Online školení byste měli provádět prostřednictvím automatizace kvůli frekvenci a požadované spolehlivosti. V případě offline trénování je potřeba kvůli požadované frekvenci ospravedlnit automatizaci provedením analýzy nákladů a přínosů. Kromě toho můžete provádět offline trénování pomocí levnějších prostředků, jako je offline hardware.

Tradiční procesy DevOps jsou obvykle ovlivněny strukturálními změnami. V AI a strojovém učení se ale modely trénují na produkčních datech. Rozklad modelu představuje významné riziko a může vést ke snížení výkonu v průběhu času, pokud není monitorován. K zajištění účinnosti modelu se vyžaduje automatizované shromažďování a analýza metrik výkonu, výstrah a přetrénování modelů. Automatizaci můžete využít způsobem, který vám pomůže rozpoznat změny v závislostech dat a modelů a získat tak jasný přehled o aktuálním stavu v libovolném okamžiku.

Modely je možné vytrénovat dvěma odlišnými přístupy.

- Modely se trénují ve vývojovém prostředí s úplnými produkčními daty a pouze artefakt se propaguje prostřednictvím prostředí. Tento přístup může snížit výpočetní náklady, ale vyžaduje přísnější zabezpečení pro zpracování produkčních dat v nižších prostředích a nemusí být možné ve všech organizacích.

- Model se vytrénuje v každém prostředí. Zvýšení úrovně kódu může pomoct se stabilitou, protože trénovací kód se kontroluje a testuje v nižších prostředích, ale zvyšuje náklady na výpočetní prostředky.

Oba přístupy mají své výhody a nevýhody. Volba správného přístupu závisí na prioritách vaší organizace a postupech životního cyklu vývoje softwaru (SDLC) vaší organizace. Bez ohledu na metodu jsou nezbytné důkladné testování a vyhodnocení modelu před produkčním nasazením.

Kód automatizace by měl zahrnovat rodokmen dat, který podporuje auditovatelnost tím, že poskytuje jasný záznam fází zpracování dat. Tento záznam vám pomůže se správou očekávání a umožňuje předvést, jak se rozhodnutí udělala, abyste mohli řešit jakékoli obavy ohledně výsledků.

Kanály nasazení

V úlohách umělé inteligence a strojového učení zahrnuje vývoj modelů vytváření, ověřování a propagaci modelů na platformách hostování modelů. Je důležité mít kanály nasazení, které zjednodušují složité pracovní postupy související se zpracováním dat, inženýrstvím funkcí, trénováním modelu nebo rozšířením a nasazením do produkčního prostředí. Vzhledem k ne deterministické povaze AI, díky čemuž jsou procesy neprůžné, musíte začlenit kvalitativní testy do kanálů verzí a systémů monitorování.

I když mlOps a GenAIOps můžou vyžadovat odlišné aktivity umělé inteligence a základní technologie, základní koncepty zůstanou podobné těm, které jsou v DevOps. Doporučujeme použít osvědčené postupy ze stávajících procesů DevOps. Integrujte aktivity umělé inteligence do stávajících kanálů vaší úlohy.

Úlohy AI obvykle zahrnují tradiční nasazení kódu. Nasazení modelu můžete zpracovávat společně s kódem nebo samostatně ve vlastním životním cyklu. Dřívější přístup je vhodnější. Připravte se na zabalení modelů a koncových bodů odvozování s nasazením úloh, aby se operace umělé inteligence primárně zaměřovaly na přípravu dat, trénování/vyladění, správu podkladů a monitorování dat.

Přehodnotit, jak lze následující prostředky přizpůsobit tak, aby pokrývaly celý životní cyklus MLOps a GenAIOps od předprodukčního do produkčního prostředí:

- Nástroje infrastruktury jako kódu (IaC)

- Kanály CI/CD

- Zásobník pozorovatelnosti pro sledování a identifikaci problémů

Nástroje

Můžete rozšířit pracovní postupy Azure Pipelines a GitHub Actions, které se běžně používají pro CI/CD, na modely strojového učení. Pomáhají nasadit infrastrukturu strojového učení, vlastní komponenty úloh, kód orchestrace a modely. Kombinování kanálů Azure Machine Learning s kanály Azure DevOps nebo GitHubu Další informace najdete v tématu Použití služby Azure Pipelines se službou Azure Machine Learning.

Na výběr správné kombinace nástrojů ovlivňují dva hlavní faktory: případ použití a možnosti. Kanály Azure Machine Learning jsou například skvělé pro orchestraci, kterou provádějí datoví vědci. Obsahuje bohatou sadu funkcí, která podporuje opakované použití, ukládání do mezipaměti a další. Informace o možnostech nástrojů najdete v tématu Kterou technologii kanálu Azure mám použít?.

Údržba modelu

Prostředí AI/ML je konkurenceschopné s průběžnými inovacemi. Nové modely se objevují často, zjistí se nové případy použití a zpřístupní se nové zdroje dat. Výsledkem je, že rozpad modelu je běžnou výzvou.

Pokud chcete zabránit snížení výkonu nebo posunu modelu v průběhu času, musíte implementovat automatizované procesy pro průběžné monitorování, hodnocení a opětovné trénování. Příklad:

Udržujte katalog modelů. Automatizujte proces zjišťování nových modelů a aktualizaci katalogu.

Přizpůsobte se novým případům použití. Při přidání nových případů použití do požadavků na úlohy předvídejte dotazy a odpovídajícím způsobem upravte logiku zpracování dat.

Začleňte nové zdroje dat. Pokud můžou nové zdroje dat potenciálně zvýšit prediktivní výkon nebo význam modelu, aktualizujte kanál příjmu dat tak, aby se připojil k těmto zdrojům a načítal z nich data.

Vyhodnoťte dodržování právních požadavků. Když se přizpůsobíte novým možnostem, zajistěte, aby změny zůstaly platné v rámci omezení standardů dodržování předpisů organizace nebo externích předpisů.

Implementujte formální proces pro sledování průběžného zlepšování a začleníte sebelepšovací proces jako dílčí proces v rámci daného cyklu.

Průběžný vývoj

Pravidelně kontrolujte a vylepšujte provoz a podněcujte inovace.

Model vyspělosti MLOps postupuje od ručních procesů po úplnou automatizaci. Začněte ručními sestaveními a monitorováním a začleňte automatizované sestavení aplikací, trénovací prostředí a nasazení ve fázích, které jsou odůvodněné komplexními metrikami. Další informace naleznete v tématu MLOps maturity model.

Úrovně vyspělosti GenAIOps se přesouvají ze základních modelů na strukturované nasazení postupně pomocí technik automatizované optimalizace. Další informace najdete v tématu Přechod na úroveň vyspělosti GenAIOps.