Jak funguje Správce orchestrace pracovních postupů Azure?

PLATÍ PRO:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Vyzkoušejte si službu Data Factory v Microsoft Fabric, řešení pro analýzy typu all-in-one pro podniky. Microsoft Fabric zahrnuje všechno od přesunu dat až po datové vědy, analýzy v reálném čase, business intelligence a vytváření sestav. Přečtěte si, jak začít používat novou zkušební verzi zdarma.

Poznámka:

Správce orchestrace pracovních postupů využívá Apache Airflow.

Poznámka:

Správce orchestrace pracovních postupů pro Azure Data Factory spoléhá na opensourcovou aplikaci Apache Airflow. Dokumentaci a další kurzy pro Airflow najdete na stránkách dokumentace nebo komunity Apache Airflow.

Správce orchestrace pracovních postupů ve službě Azure Data Factory používá ke spouštění pracovních postupů orchestrace řízené Acyklické grafy (DAG) založené na Pythonu. Pokud chcete tuto funkci použít, musíte poskytnout své dagy a moduly plug-in ve službě Azure Blob Storage nebo prostřednictvím úložiště GitHub. Uživatelské rozhraní Airflow můžete spustit z ADF pomocí rozhraní příkazového řádku (CLI) nebo sady SDK (Software Development Kit) pro správu daG.

Vytvoření prostředí Správce orchestrace pracovního postupu

Přečtěte si: Vytvoření prostředí Správce orchestrace pracovního postupu

Import dagů

Správce orchestrace pracovních postupů poskytuje dvě různé metody načítání DAG ze zdrojových souborů Pythonu do prostředí Airflow. Tyto metody jsou:

Povolit Synchronizaci Gitu: Tato služba umožňuje synchronizovat úložiště GitHub se Správcem orchestrace pracovního postupu a umožňuje importovat dagy přímo z úložiště GitHub. Přečtěte si: Synchronizace úložiště GitHubu ve Správci orchestrace pracovního postupu

Azure Blob Storage: Skupiny dagů, moduly plug-in atd. můžete nahrát do určené složky v rámci účtu úložiště objektů blob, který je propojený se službou Azure Data Factory. Potom naimportujete cestu k souboru složky ve Správci orchestrace pracovního postupu. Projděte si: Import dagů pomocí služby Azure Blob Storage

Odebrání DAG z prostředí Airflow

Viz: Odstranění dagů ve Správci orchestrace pracovního postupu

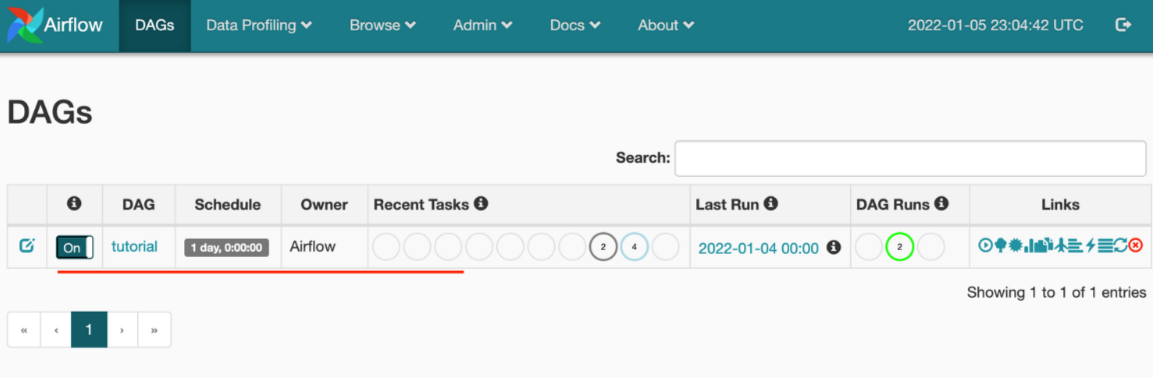

Monitorování spuštění DAG

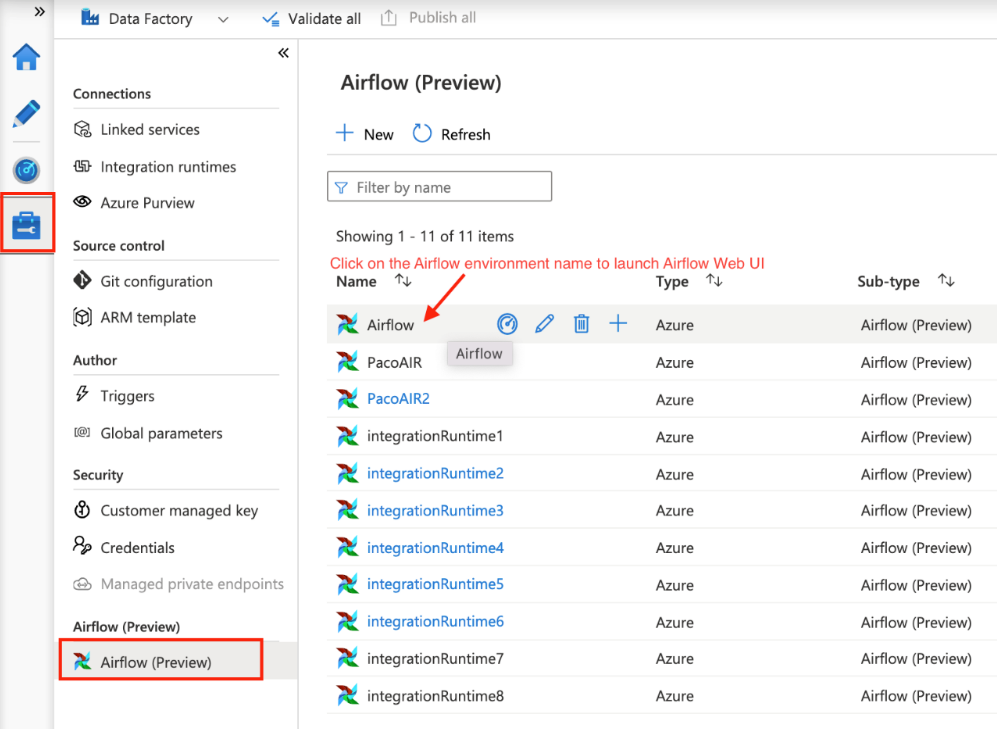

Pokud chcete monitorovat dagy Airflow, přihlaste se k uživatelskému rozhraní Airflow pomocí dříve vytvořeného uživatelského jména a hesla.

Vyberte vytvořené prostředí Airflow.

Přihlaste se pomocí uživatelského jména a hesla zadaného při vytváření prostředí Airflow Integration Runtime. (Uživatelské jméno nebo heslo můžete resetovat úpravou prostředí Airflow Integration Runtime v případě potřeby)

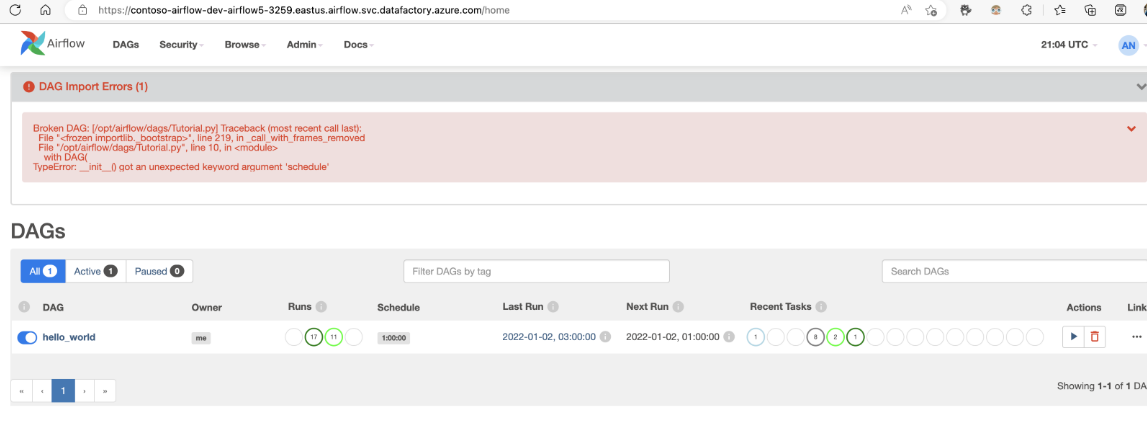

Řešení potíží s importem DAG

Problém: Zmírnění rizik importu DAG trvá více než 5 minut: Zmenšete velikost importovaných dag pomocí jednoho importu. Jedním ze způsobů, jak toho dosáhnout, je vytvoření více složek DAG s menšími skupinami DAG napříč několika kontejnery.

Problém: Importované DAG se nezobrazují, když se přihlásíte do uživatelského rozhraní Airflow. Zmírnění rizik: Přihlaste se do uživatelského rozhraní Airflow a zkontrolujte, jestli nedošlo k nějakým chybám analýzy DAG. K tomu může dojít v případě, že soubory DAG obsahují nekompatibilní kód. Přes uživatelské rozhraní Airflow najdete přesná čísla řádků a soubory, u kterých dochází k problému.