Kopírování dat ze Sparku pomocí Azure Data Factory nebo Synapse Analytics

PLATÍ PRO:  Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Tip

Vyzkoušejte si službu Data Factory v Microsoft Fabric, řešení pro analýzy typu all-in-one pro podniky. Microsoft Fabric zahrnuje všechno od přesunu dat až po datové vědy, analýzy v reálném čase, business intelligence a vytváření sestav. Přečtěte si, jak začít používat novou zkušební verzi zdarma.

Tento článek popisuje, jak pomocí aktivity kopírování v kanálu Azure Data Factory nebo Synapse Analytics kopírovat data ze Sparku. Vychází z článku s přehledem aktivity kopírování, který představuje obecný přehled aktivity kopírování.

Podporované funkce

Tento konektor Sparku je podporovaný pro následující funkce:

| Podporované funkce | IR |

|---|---|

| aktivita Copy (zdroj/-) | (1) (2) |

| Aktivita Lookup | (1) (2) |

(1) Prostředí Azure Integration Runtime (2) Místní prostředí Integration Runtime

Seznam úložišť dat podporovaných jako zdroje nebo jímky aktivitou kopírování najdete v tabulce Podporované úložiště dat.

Služba poskytuje integrovaný ovladač, který umožňuje připojení, takže pomocí tohoto konektoru nemusíte ručně instalovat žádný ovladač.

Požadavky

Pokud se vaše úložiště dat nachází uvnitř místní sítě, virtuální sítě Azure nebo amazonového privátního cloudu, musíte nakonfigurovat místní prostředí Integration Runtime pro připojení k němu.

Pokud je vaše úložiště dat spravovanou cloudovou datovou službou, můžete použít Azure Integration Runtime. Pokud je přístup omezený na IP adresy schválené v pravidlech brány firewall, můžete do seznamu povolených přidat IP adresy prostředí Azure Integration Runtime.

K přístupu k místní síti bez nutnosti instalace a konfigurace místního prostředí Integration Runtime můžete také použít funkci Runtime integrace spravované virtuální sítě ve službě Azure Data Factory.

Další informace o mechanismech zabezpečení sítě a možnostech podporovaných službou Data Factory najdete v tématu Strategie přístupu k datům.

Začínáme

K provedení aktivita Copy s kanálem můžete použít jeden z následujících nástrojů nebo sad SDK:

- Nástroj pro kopírování dat

- Azure Portal

- Sada .NET SDK

- Sada Python SDK

- Azure PowerShell

- Rozhraní REST API

- Šablona Azure Resource Manageru

Vytvoření propojené služby pro Spark pomocí uživatelského rozhraní

Pomocí následujícího postupu vytvořte propojenou službu se Sparkem v uživatelském rozhraní webu Azure Portal.

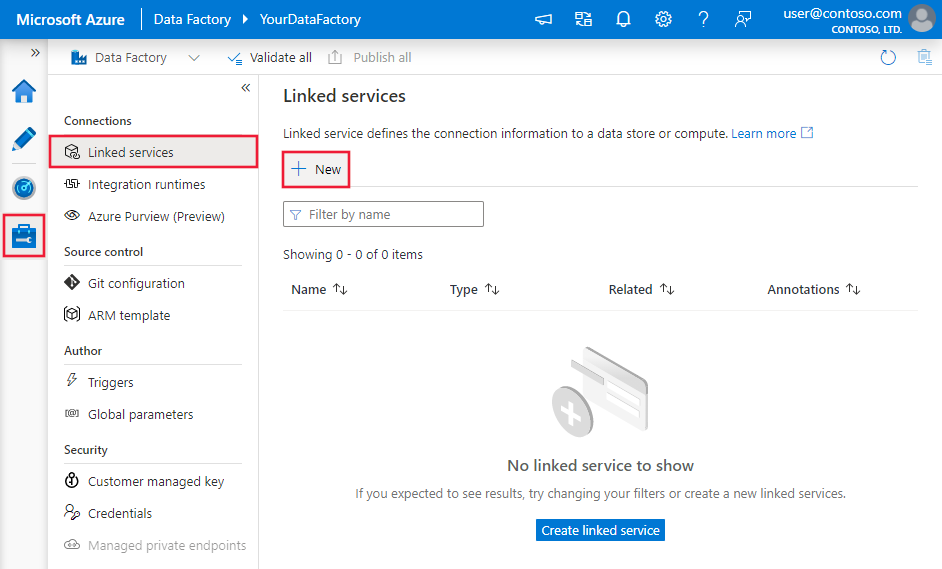

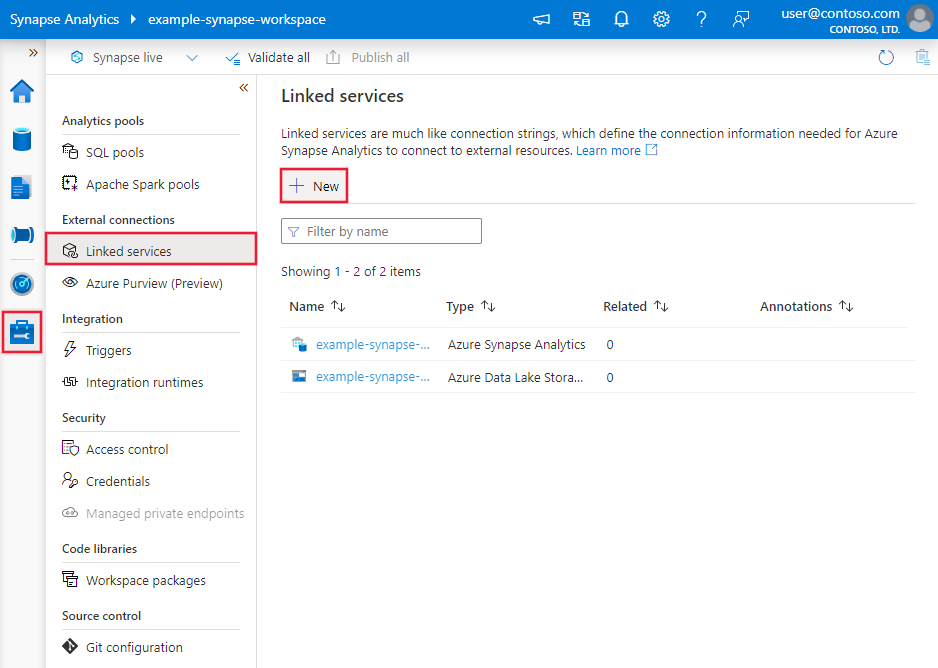

Přejděte na kartu Správa v pracovním prostoru Azure Data Factory nebo Synapse a vyberte Propojené služby a pak klikněte na Nový:

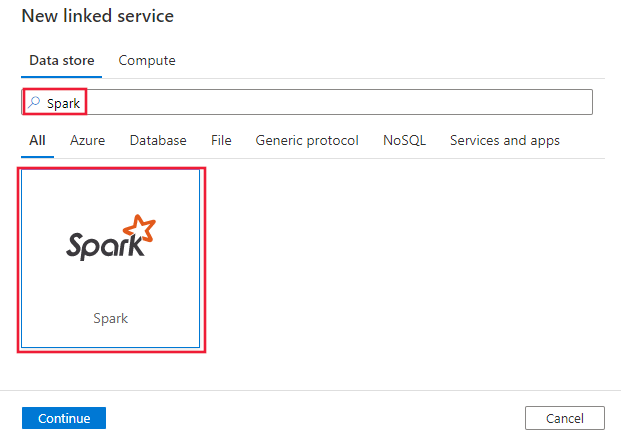

Vyhledejte Spark a vyberte konektor Sparku.

Nakonfigurujte podrobnosti o službě, otestujte připojení a vytvořte novou propojenou službu.

Podrobnosti konfigurace konektoru

Následující části obsahují podrobnosti o vlastnostech, které slouží k definování entit služby Data Factory specifických pro konektor Spark.

Vlastnosti propojené služby

Pro propojenou službu Sparku jsou podporovány následující vlastnosti:

| Vlastnost | Popis | Povinní účastníci |

|---|---|---|

| type | Vlastnost typu musí být nastavená na: Spark | Ano |

| host | IP adresa nebo název hostitele serveru Spark | Ano |

| port | Port TCP, který server Spark používá k naslouchání klientským připojením. Pokud se připojíte ke službě Azure HDInsights, zadejte port 443. | Ano |

| serverType | Typ serveru Spark. Povolené hodnoty jsou: SharkServer, SharkServer2, SparkThriftServer |

No |

| thriftTransportProtocol | Přenosový protokol, který se má použít ve vrstvě Thrift. Povolené hodnoty jsou: Binary, SASL, HTTP |

No |

| authenticationType | Metoda ověřování používaná pro přístup k serveru Spark. Povolené hodnoty jsou: Anonymní, Uživatelské jméno, UsernameAndPassword, WindowsAzureHDInsightService |

Ano |

| username | Uživatelské jméno, které používáte pro přístup k Spark Serveru. | No |

| Heslo | Heslo odpovídající uživateli. Označte toto pole jako securestring, abyste ho mohli bezpečně uložit, nebo odkazovat na tajný klíč uložený ve službě Azure Key Vault. | No |

| httpPath | Částečná adresa URL odpovídající serveru Spark. | No |

| enableSsl | Určuje, jestli jsou připojení k serveru šifrovaná pomocí protokolu TLS. Výchozí hodnota je false. | No |

| trustedCertPath | Úplná cesta k souboru .pem obsahujícího důvěryhodné certifikáty certifikační autority pro ověření serveru při připojování přes protokol TLS. Tuto vlastnost lze nastavit pouze při použití protokolu TLS v místním prostředí IR. Výchozí hodnota je soubor cacerts.pem nainstalovaný s prostředím IR. | No |

| useSystemTrustStore | Určuje, jestli se má použít certifikát certifikační autority z úložiště důvěryhodnosti systému nebo ze zadaného souboru PEM. Výchozí hodnota je false. | No |

| allowHostNameCNMismatch | Určuje, jestli se má při připojování přes protokol TLS vyžadovat název certifikátu TLS/SSL vystavený certifikační autoritou, který odpovídá názvu hostitele serveru. Výchozí hodnota je false. | No |

| allowSelfSignedServerCert | Určuje, jestli chcete povolit certifikáty podepsané svým držitelem ze serveru. Výchozí hodnota je false. | No |

| connectVia | Prostředí Integration Runtime , které se má použít pro připojení k úložišti dat. Další informace najdete v části Požadavky . Pokud není zadaný, použije výchozí prostředí Azure Integration Runtime. | No |

Příklad:

{

"name": "SparkLinkedService",

"properties": {

"type": "Spark",

"typeProperties": {

"host" : "<cluster>.azurehdinsight.net",

"port" : "<port>",

"authenticationType" : "WindowsAzureHDInsightService",

"username" : "<username>",

"password": {

"type": "SecureString",

"value": "<password>"

}

}

}

}

Vlastnosti datové sady

Úplný seznam oddílů a vlastností dostupných pro definování datových sad najdete v článku o datových sadách . Tato část obsahuje seznam vlastností podporovaných datovou sadou Spark.

Pokud chcete kopírovat data ze Sparku, nastavte vlastnost typu datové sady na SparkObject. Podporují se následující vlastnosti:

| Vlastnost | Popis | Povinní účastníci |

|---|---|---|

| type | Vlastnost typu datové sady musí být nastavená na: SparkObject. | Ano |

| schema | Název schématu | Ne (pokud je zadán dotaz ve zdroji aktivity) |

| table | Název tabulky. | Ne (pokud je zadán dotaz ve zdroji aktivity) |

| tableName | Název tabulky se schématem Tato vlastnost je podporována pro zpětnou kompatibilitu. Používejte schema a table pro nové úlohy. |

Ne (pokud je zadán dotaz ve zdroji aktivity) |

Příklad

{

"name": "SparkDataset",

"properties": {

"type": "SparkObject",

"typeProperties": {},

"schema": [],

"linkedServiceName": {

"referenceName": "<Spark linked service name>",

"type": "LinkedServiceReference"

}

}

}

Vlastnosti aktivity kopírování

Úplný seznam oddílů a vlastností dostupných pro definování aktivit najdete v článku Pipelines . Tato část obsahuje seznam vlastností podporovaných zdrojem Sparku.

Spark jako zdroj

Pokud chcete kopírovat data ze Sparku, nastavte typ zdroje v aktivitě kopírování na SparkSource. Ve zdrojové části aktivity kopírování jsou podporovány následující vlastnosti:

| Vlastnost | Popis | Povinní účastníci |

|---|---|---|

| type | Vlastnost typu zdroje aktivity kopírování musí být nastavena na: SparkSource. | Ano |

| query | Ke čtení dat použijte vlastní dotaz SQL. Například: "SELECT * FROM MyTable". |

Ne (pokud je v datové sadě zadán název tabulky) |

Příklad:

"activities":[

{

"name": "CopyFromSpark",

"type": "Copy",

"inputs": [

{

"referenceName": "<Spark input dataset name>",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "<output dataset name>",

"type": "DatasetReference"

}

],

"typeProperties": {

"source": {

"type": "SparkSource",

"query": "SELECT * FROM MyTable"

},

"sink": {

"type": "<sink type>"

}

}

}

]

Vlastnosti aktivity vyhledávání

Podrobnosti o vlastnostech najdete v aktivitě Vyhledávání.

Související obsah

Seznam úložišť dat podporovaných jako zdroje a jímky aktivitou kopírování najdete v podporovaných úložištích dat.