在 Azure Synapse Analytics 中使用 Spark

您可以在 Spark 上執行許多不同類型的應用程式,包括 Python 或 Scala 指令碼中的程式碼、編譯為 JAVA 封存 (JAR) 的 JAVA 程式碼,以及其他程式碼。 Spark 通常用於兩種工作負載:

- 批次或串流處理作業以內嵌、清除和轉換資料 - 通常是在自動化管線中執行。

- 互動式分析工作階段,以探索、分析資料,以及將其視覺化。

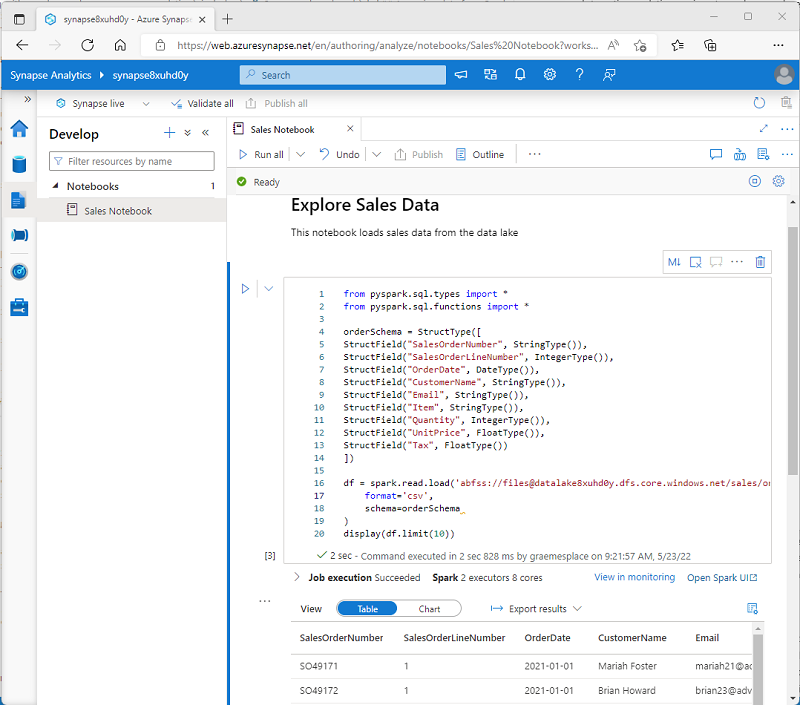

在筆記本中執行 Spark 程式碼

Azure Synapse Studio 中包含使用 Spark 的整合式筆記本介面。 筆記本提供直覺的方式,可將程式碼與 Markdown 附註結合,通常供資料科學家和資料分析師使用。 Azure Synapse Studio 整合式筆記本體驗的外觀與風格,和熱門的開放原始碼筆記本平台 Jupyter 筆記本相似。

注意

雖然通常以互動方式使用,但筆記本可以包含在自動化管線中,並以自動指令碼的形式執行。

筆記本包含一或多個「儲存格」,每個儲存格都包含程式碼或 Markdown。 筆記本中的程式碼儲存格有一些功能可協助您提高生產力,包括:

- 語法醒目提示和錯誤支援。

- 自動完成程式碼。

- 互動式資料視覺效果。

- 匯出結果的能力。

提示

若要深入了解如何使用 Azure Synapse Analytics 中的筆記本,請參閱 Azure Synapse Analytics 文件中 在 Azure Synapse Analytics 中建立、開發和維護 Synapse 筆記本 (部分機器翻譯) 一文。

從 Synapse Spark 集區存取資料

您可以在 Azure Synapse Analytics 中使用 Spark 來處理各種來源的資料,包括:

- 以 Azure Synapse Analytics 工作區的主要儲存體帳戶為基礎的資料湖。

- 以在工作區中定義為「連結服務」的儲存體為基礎的資料湖。

- 工作區中的專用或無伺服器 SQL 集區。

- Azure SQL 或 SQL Server 資料庫 (使用適用於 SQL Server 的 Spark 連接器)

- 定義為「連結服務」的 Azure Cosmos DB 分析資料庫,並使用「適用於 Cosmos DB 的 Azure Synapse Link」進行設定。

- 在工作區中定義為「連結服務」的 Azure 資料總管 Kusto 資料庫。

- 在工作區中定義為「連結服務」的外部 Hive 中繼存放區。

Spark 最常見的用法之一是處理資料湖中的資料,您可以在其中讀取和寫入多個常用格式的檔案,包括分隔文字、Parquet、Avro 和其他格式。