手動評估模型的效能

在開發自訂副手的早期階段,您想要快速實驗並反覆運算。 若要輕鬆地評估您選取的語言模型和應用程式是否使用提示流程建立且符合您的需求,您可以在 Azure AI Foundry 入口網站中手動評估模型和流程。

即使您的模型和應用程式已在生產環境中,手動評估也是評估效能的重要部分。 由於手動評估是由人們完成,它們可以提供自動化計量可能遺漏的深入解析。

讓我們探索如何在 Azure AI Foundry 入口網站中手動評估所選的模型和應用程式。

準備您的測試提示

若要開始手動評估程序,請務必準備一組不同的測試提示,以反映您的應用程式預期要處理的查詢和工作範圍。 這些提示應該涵蓋各種案例,包括常見的使用者問題、邊緣案例和潛在的失敗點。 如此一來,您就可以全面評估應用程式的效能,並找出改進的領域。

在聊天遊樂場中測試選取的模型

開發聊天應用程式時,您會使用語言模型來產生回應。 您可以藉由開發封裝聊天應用程式邏輯的提示流程來建立聊天應用程式,其可以使用多種語言模型來最終產生使用者問題的回應。

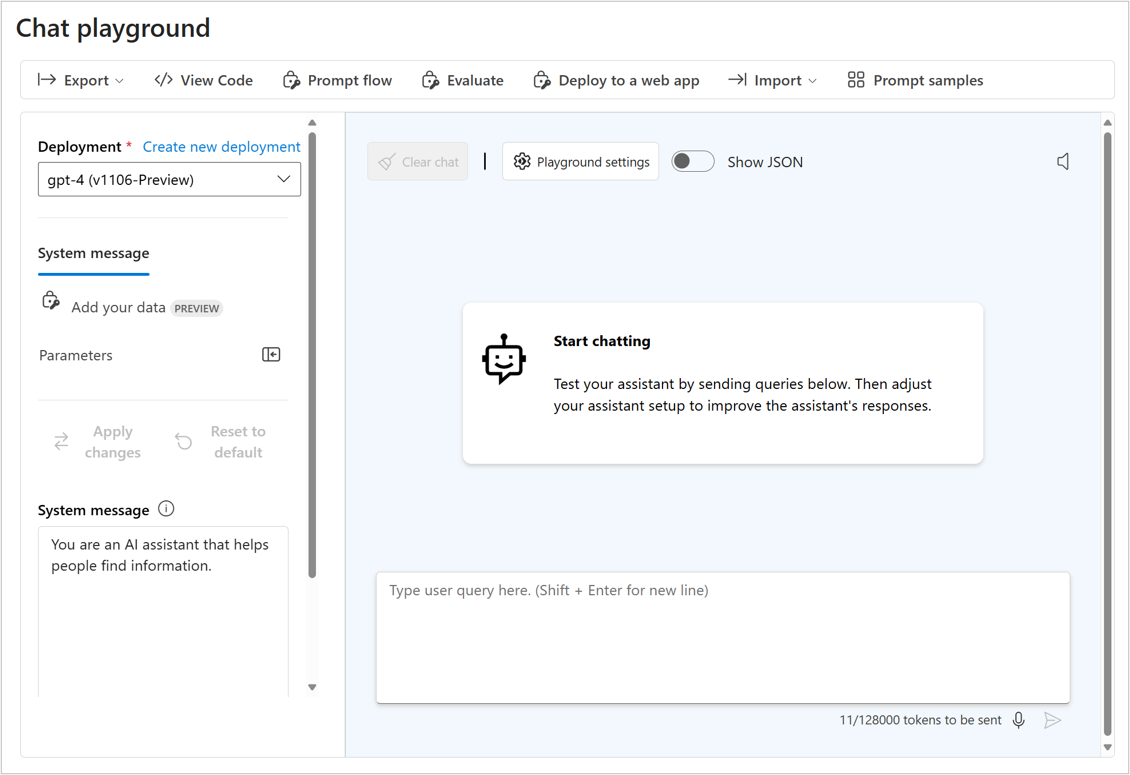

在測試您應用程式的回應之前,您可以測試選取的語言模型的回應,以驗證個別模型可如預期般運作。 您可以在聊天遊樂場中與其互動,以測試您在 Azure AI Foundry 入口網站中部署的模型。

聊天遊樂場非常適合早期開發。 您可以輸入提示,查看模型的回應方式,以及調整提示或系統訊息以進行改進。 套用變更之後,您可以再次測試提示,以評估模型的效能是否確實改善。

使用手動評估來評估多個提示

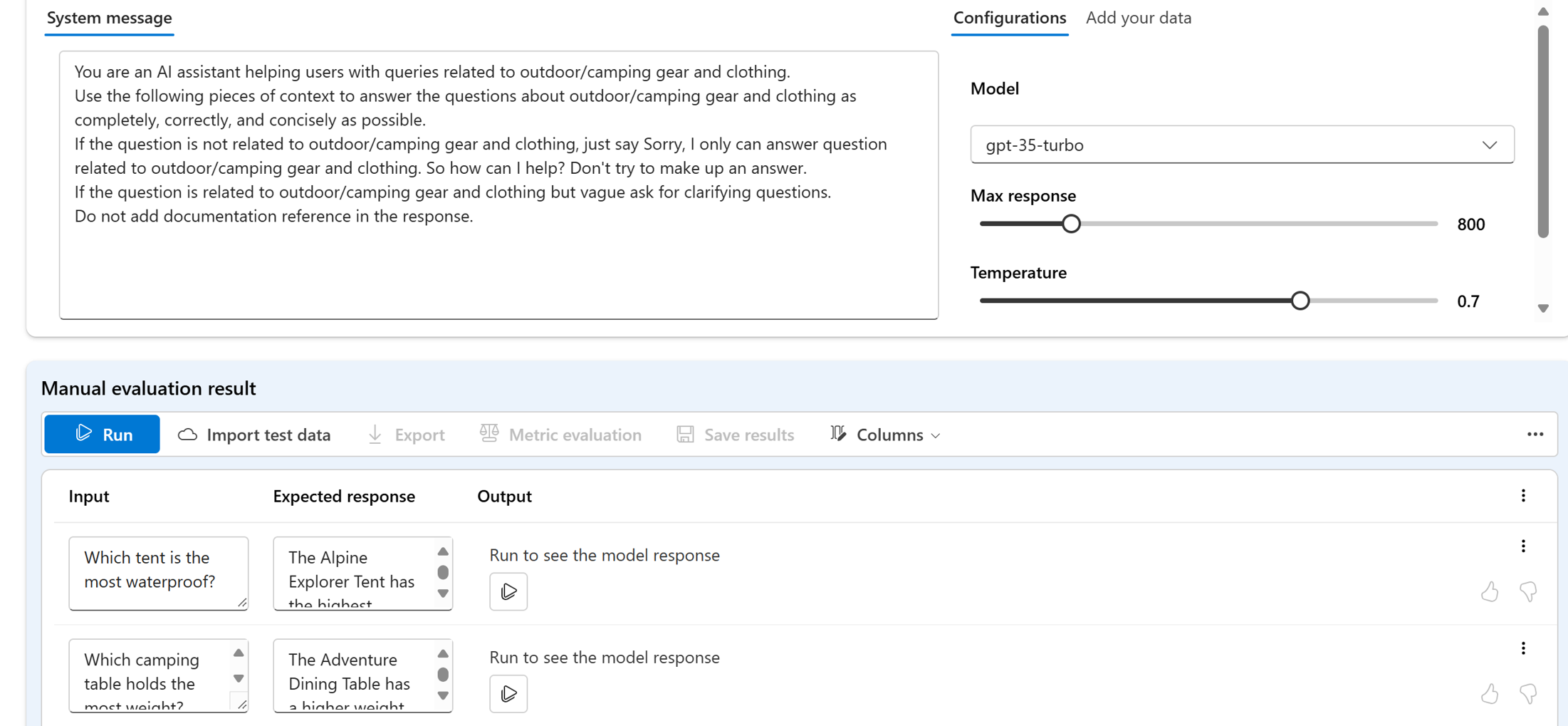

聊天遊樂場是開始使用的簡單方式。 當您想要更快速地手動評估多個提示時,您可以使用手動評估功能。 此功能可讓您上傳具有多個問題的資料集,並選擇性地新增預期的回應,以評估模型在較大的測試資料集上的效能。

您可以使用按讚或按遜的功能來為模型的回應評分。 根據整體評分,您可以藉由變更輸入提示、系統訊息、模型或模型的參數,來嘗試改善模型。

使用手動評估時,您可以更快速地根據不同的測試資料集評估模型的效能,並根據測試結果來改善模型。

手動評估個別模型之後,您可以使用提示流程將模型整合到聊天應用程式中。 您也可以手動或自動評估您使用提示流程建立的任何流程。 接下來,讓我們探索流程的評估。