Spark 作業定義 Git 整合

本文說明 Microsoft Fabric 中 Spark 作業定義 (SJD) 的 Git 整合運作方式。 瞭解如何設定存放庫連線、透過原始檔控制管理 Spark 作業定義變更,以及跨各種工作區進行部署。

在 Azure DevOps 中啟用 Spark 作業定義的 Git 整合可讓您透過完整的 Git 歷程記錄來追蹤變更。 如果選取 PySpark 或 SparkR,則會在認可中包含主要定義檔案和參考檔案。 也會追蹤這些檔案中原始碼的變更。

重要

這項功能處於預覽狀態。

設定連線

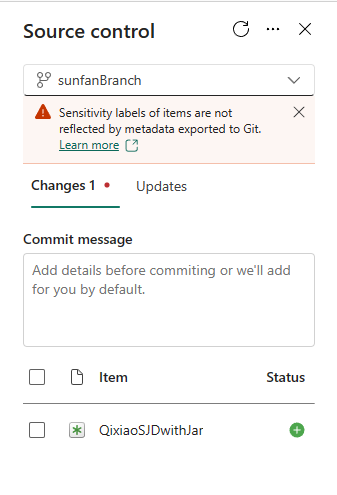

從工作區設定中,您可以輕鬆地設定存放庫的連線,以認可和同步變更。 若要設定連線,請參閱 開始使用 Git 整合 一文。 連線之後,您的項目,例如 Spark 作業定義,將會顯示在原始檔 控制面板中。

將 Spark 作業定義認可至 Git 存放庫之後,作業定義資料夾結構會出現在存放庫中。

Git 中的 Spark 作業定義表示法

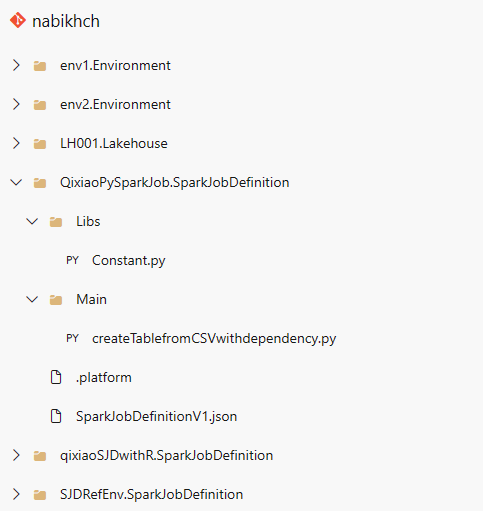

下圖是存放庫中每個 Spark 作業定義項目的檔案結構範例:

當您將Spark作業定義項目認可至存放庫時,會為每個項目建立一個 git 資料夾,並根據此架構命名: <項目名稱> + “SparkJobDefinition”。 請勿重新命名資料夾,因為它用來追蹤工作區中的項目。 例如,如果項目名稱為 「sjd1」 ,git 資料夾名稱會是 「sjd1SparkJobDefinition」。

git 資料夾內有兩個子資料夾。 它們是主要和參考。 主資料夾包含主要定義檔,而參考資料夾則包含參考檔案。

除了主要和參考檔案之外,還有一個 SparkJobDefinitionV1.json 檔案。 它會保存 Spark 作業定義項目的中繼資料,因此請勿修改它。 .platform 檔案包含與 Git 設定>相關的平台資訊,也不應該修改。

注意

- 如果您選擇 Java 或 Scala 作為語言,當上傳為.jar檔案時,將不會認可主要和參考檔案。

- 附加的環境會在從存放庫同步至 Fabric 工作區之後,保存在 Spark 作業定義中。 目前不支援跨工作區參考環境。 您必須手動附加至新的環境,或使用工作區預設設定來執行作業定義。

- 從存放庫同步處理至 Fabric 工作區時,Spark 作業定義會保留預設的 Lakehouse 標識符。 如果您認可具有預設 Lakehouse 的筆記本,則必須手動參考新建立的 Lakehouse 項目。 如需詳細資訊,請參閱 Lakehouse Git 整合。