適用於 Microsoft Fabric 的 Apache Spark 作業許可

適用於:✅Microsoft Fabric 中的 資料工程師 和 資料科學

Apache Spark for Fabric 利用開放式作業許可技術來判斷 Spark 作業的最低核心需求。 此程式適用於筆記本、Lakehouse 或 Spark 作業定義的互動式或批次作業。 它依賴工作區設定或連結環境中所選 Spark 集區的最低節點設定。 如果在連結至工作區的 Fabric 容量中找到可用的核心,則會接受作業並開始執行。 作業會以其最小節點設定起始,而且可以在每個作業階段的最大節點限制內相應增加。 如果使用 Fabric 容量執行作業所使用的核心總數低於指派的最大高載核心,Fabric Spark 上的作業許可和節流層可讓作業相應增加。

如需詳細資訊,請參閱 Microsoft Fabric Spark 中的並行限制和佇列。

開放式工作錄取如何工作?

在 Fabric 中,入門集區隨附預設至少一個節點,而自定義集區可讓您根據工作負載需求設定最小節點。 自動調整會在設定的最小和最大節點內,在運行階段調整 Spark 作業的計算需求。 開放式作業錄取會根據可用的核心評估作業提交,並以最低核心執行。 作業會嘗試根據執行期間所配置節點上限來成長。 如果所使用的Spark核心總數在已配置的容量限制內,就會核准相應增加要求。

注意

如果使用量達到上限,且網狀架構總容量內的所有核心正在使用中,則會拒絕任何相應增加要求。 作用中作業必須完成或取消,才能釋放核心。

這如何影響作業並行?

每個作業的最低核心需求會決定是否可以接受作業。 如果容量已充分利用,且沒有核心可滿足作業的最低核心需求,則會拒絕該作業。 互動式筆記本作業或 Lakehouse 作業將會遭到封鎖,並顯示無法提交此要求的錯誤訊息 ,因為目前正在使用所有可用的容量。取消目前正在執行的作業、增加可用的容量,或稍後再試一次。 批次作業會在核心可供使用後排入佇列並執行。

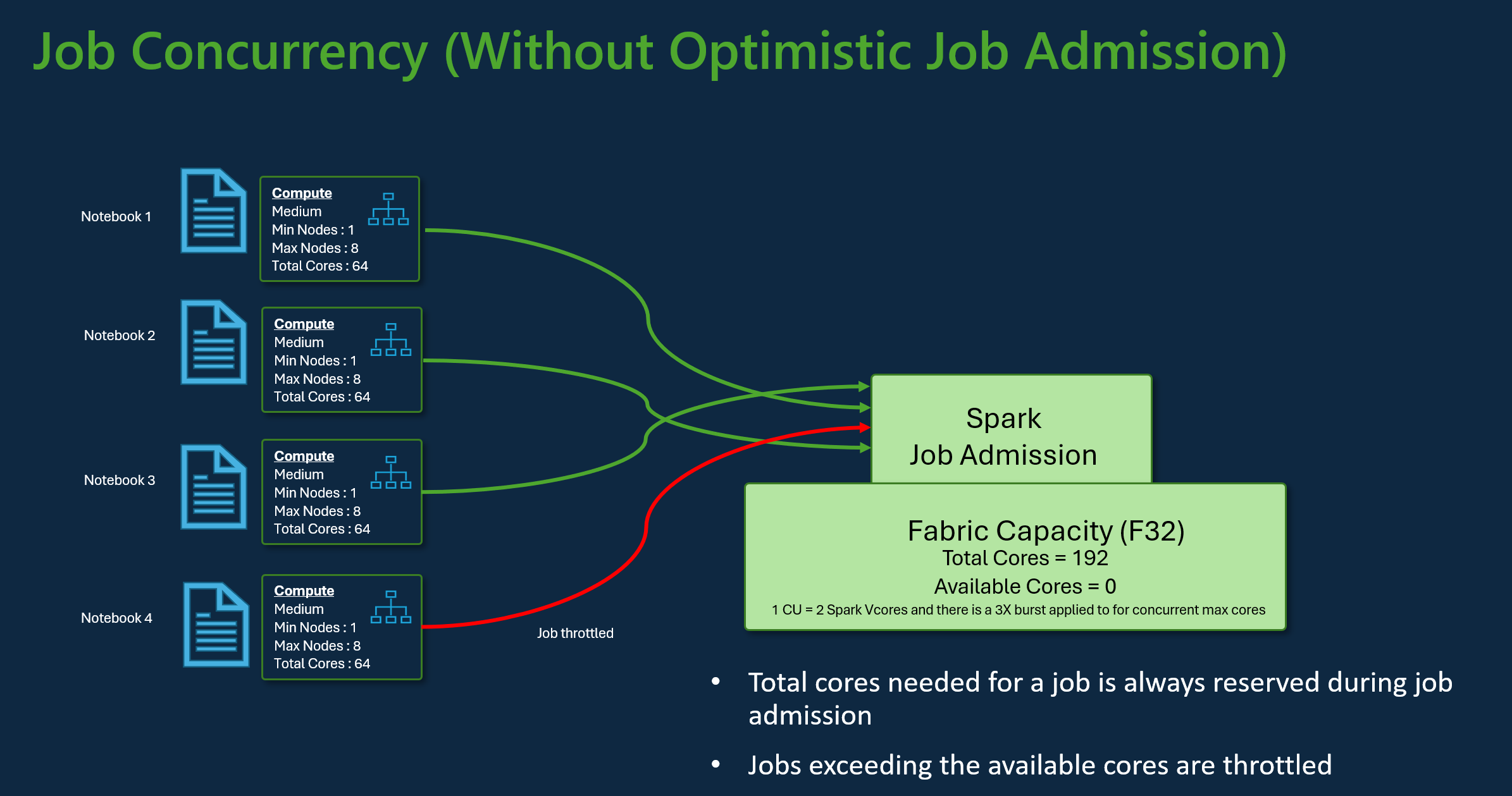

例如,請考慮使用網狀架構 F32 容量 SKU 的使用者案例。 假設所有作業都使用預設入門集區設定,而不需要開放式作業許可,容量就會支援三個作業的最大並行。 每個作業的核心數目上限會根據節點組態上限來配置。

使用與上述相同容量的開放式作業許可,可以在最大並行案例期間,使用其最小節點組態來承認和執行 24 個作業。 因為每個作業都需要 8 個 Spark 虛擬核心,其中一個最小節點組態為中型。

使用Spark自動調整作業

當您啟用 Spark 集區的自動調整時,作業會以最小節點組態執行。 在執行階段期間,可能會發生調整。 這些要求會通過作業許可控制。 已核准的要求會根據可用核心總數相應增加至最大限制。 拒絕的要求不會影響作用中作業;它們會繼續使用其目前的設定來執行,直到核心可供使用為止。

注意

若要根據作業的最大節點組態確保作業的核心配置上限,請停用自動調整,並在網狀架構容量 SKU 中設定最大節點。 在此情況下,由於作業沒有最低核心需求,因此一旦可用免費核心,就會開始執行,並相應增加為已設定的總計。 如果容量已完全使用,筆記本互動式作業可能會變慢或排入佇列。 佇列作業會在核心可供使用時自動重試。

相關內容

- 開始使用 Microsoft Fabric 中的 Spark 工作區系統管理設定。

- 瞭解適用於網狀架構資料工程和資料科學的 Spark 計算。

- 深入瞭解 Fabric Spark 的並行和佇列限制。