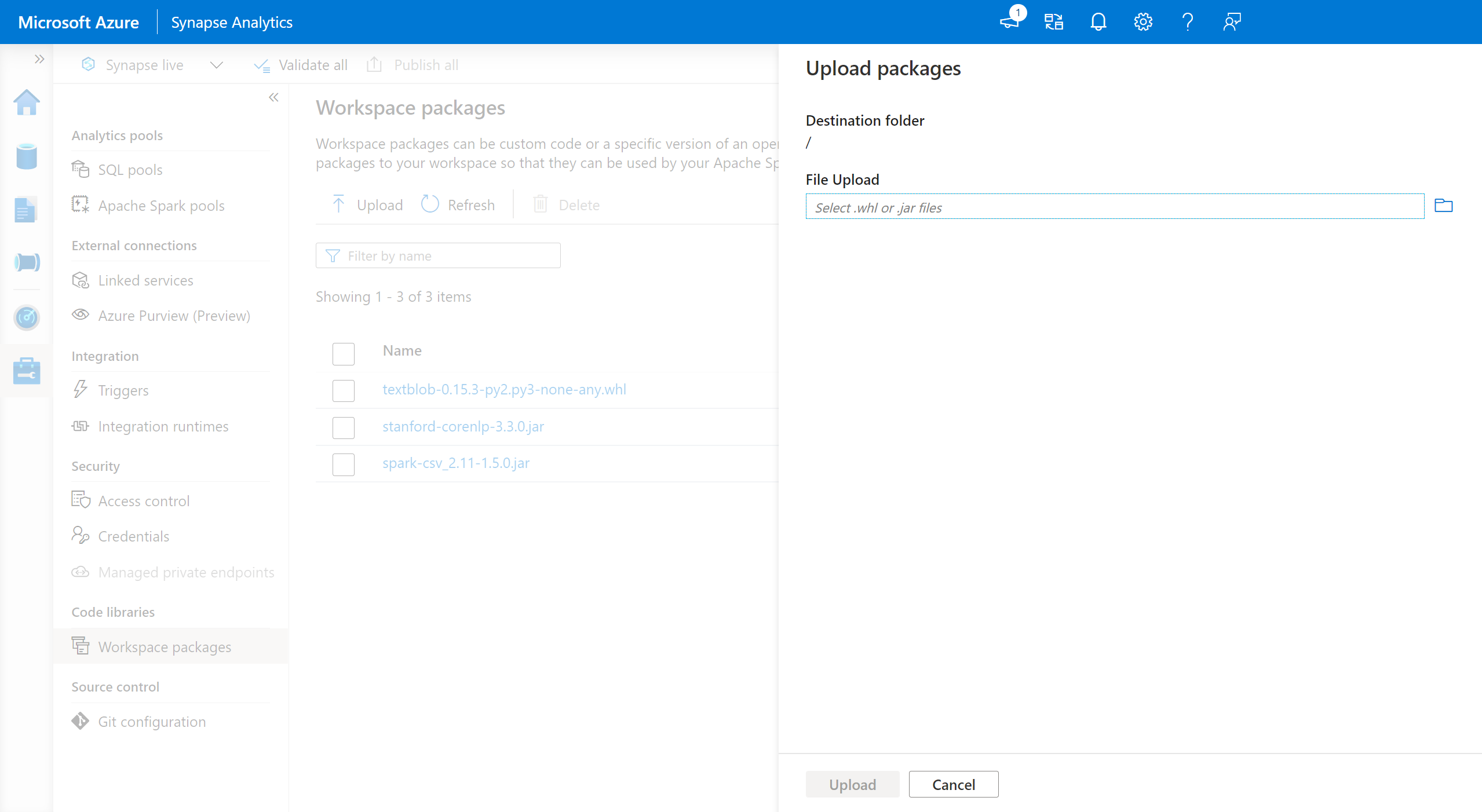

工作區套件

工作區套件可以是自訂或私人 Wheel (Python)、jar (Scala/JAVA) 或 tar.gz (R) 檔案。 您可以將這些套件上傳至工作區,稍後再指派給特定的 Spark 集區。

若要新增工作區套件:

- 瀏覽至 [管理]> [工作區封裝] 索引標籤。

- 使用檔案選取器上傳您的檔案。

- 將檔案上傳至 Azure Synapse 工作區之後,您可以將這些套件新增至 Apache Spark 集區。

警告

在 Azure Synapse Analytics 中,Apache Spark 集區可利用上傳為工作區封裝或在已知 Azure Data Lake Storage 路徑內上傳的自訂程式庫。 不過,相同 Apache Spark 集區內不能同時使用這兩個選項。 如果同時以這兩種方法提供封裝,則只會安裝工作區封裝清單中指定的 wheel 檔案。

一旦使用工作區封裝在指定的 Apache Spark 集區安裝封裝,您就無法再於相同集區上使用儲存體帳戶路徑來指定封裝。

注意

建議您不要在工作區中有多個具有相同名稱的套件。 如果您想要使用不同的相同套件版本,您必須刪除現有的版本並上傳新的版本。

儲存體帳戶

將所有檔案上傳至與 Synapse 工作區連結的 Azure Data Lake Storage (Gen2) 帳戶,即可在 Apache Spark 集區上安裝自定義建置套件。

檔案應該上傳至儲存體帳戶預設容器中的下列路徑:

abfss://<file_system>@<account_name>.dfs.core.windows.net/synapse/workspaces/<workspace_name>/sparkpools/<pool_name>/libraries/python/

警告

- 在某些情況下,您可能需要根據以上結構來建立檔案路徑 (如果不存在的話)。 例如,您可能需要在

libraries資料夾中加入資料夾python(如果不存在的話)。 - Azure Synapse Runtime for Apache Spark 3.0 不支援管理自定義檔案的方法。 請參閱工作區套件功能來管理自定義檔案。

重要

若要使用 Azure DataLake Storage 方法來安裝自訂程式庫,則在連結至 Azure Synapse Analytics 工作區的主要 Gen2 儲存體帳戶上,您必須具有儲存體 Blob 資料參與者或儲存體 Blob 資料擁有者權限。

下一步

- 檢視預設程式庫:Apache Spark 版本支援

- 程式庫安裝錯誤疑難排解:程式庫錯誤疑難排解

- 使用您的 Azure Data Lake Storage 帳戶建立私人 Conda 通道:Conda 私人通道