以 Delta Lake 格式從事件中樞擷取數據

本文說明如何使用無程式碼編輯器,從 Delta Lake 格式的 Azure Data Lake Storage Gen2 帳戶中,自動擷取事件中樞的串流資料。

必要條件

- 您的 Azure 事件中樞和 Azure Data Lake Storage Gen2 資源必須可公開存取,且無法在 Azure 虛擬網路中位於防火牆或安全後方。

- 事件中樞中的資料必須以 JSON、CSV 或 Avro 格式序列化。

設定作業以擷取資料

使用下列步驟來設定串流分析作業,以擷取 Azure Data Lake Storage Gen2 中的資料。

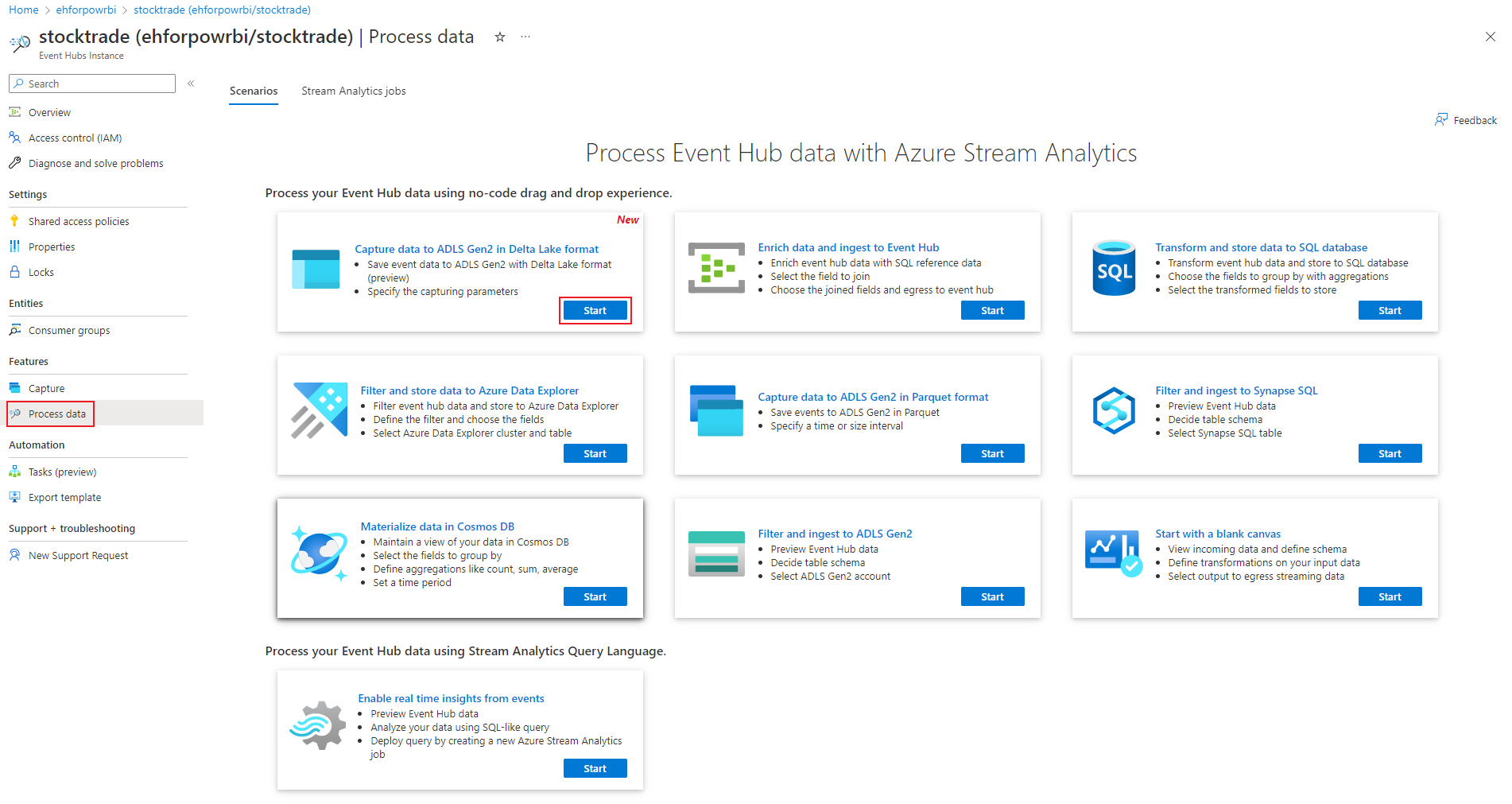

在 Azure 入口網站中,瀏覽至您的事件中樞。

選取 [功能]>[處理資料],然後在 [以 Delta Lake 格式將資料擷取至 ADLS Gen2] 卡片上選取 [開始]。

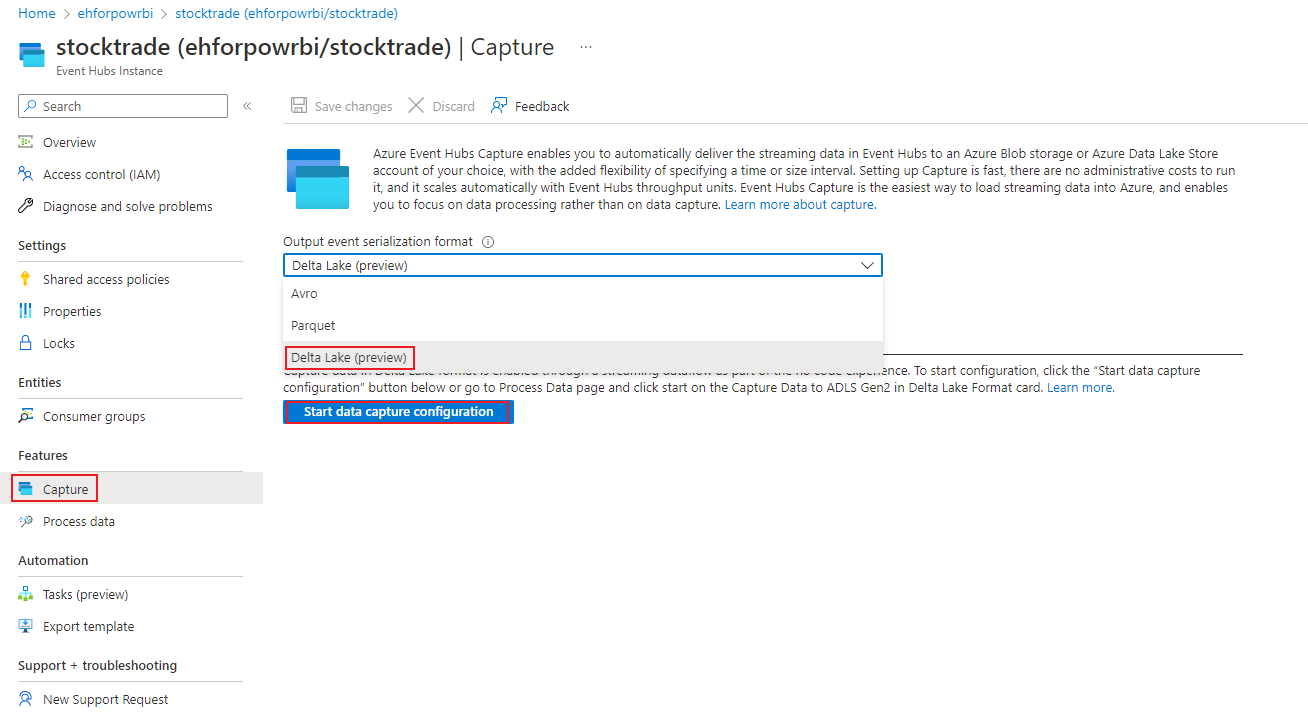

或者,選取 [功能]>[擷取],並選取 [輸出事件序列化格式] 下的 [Delta Lake] 選項,然後選取 [開始資料擷取設定]。

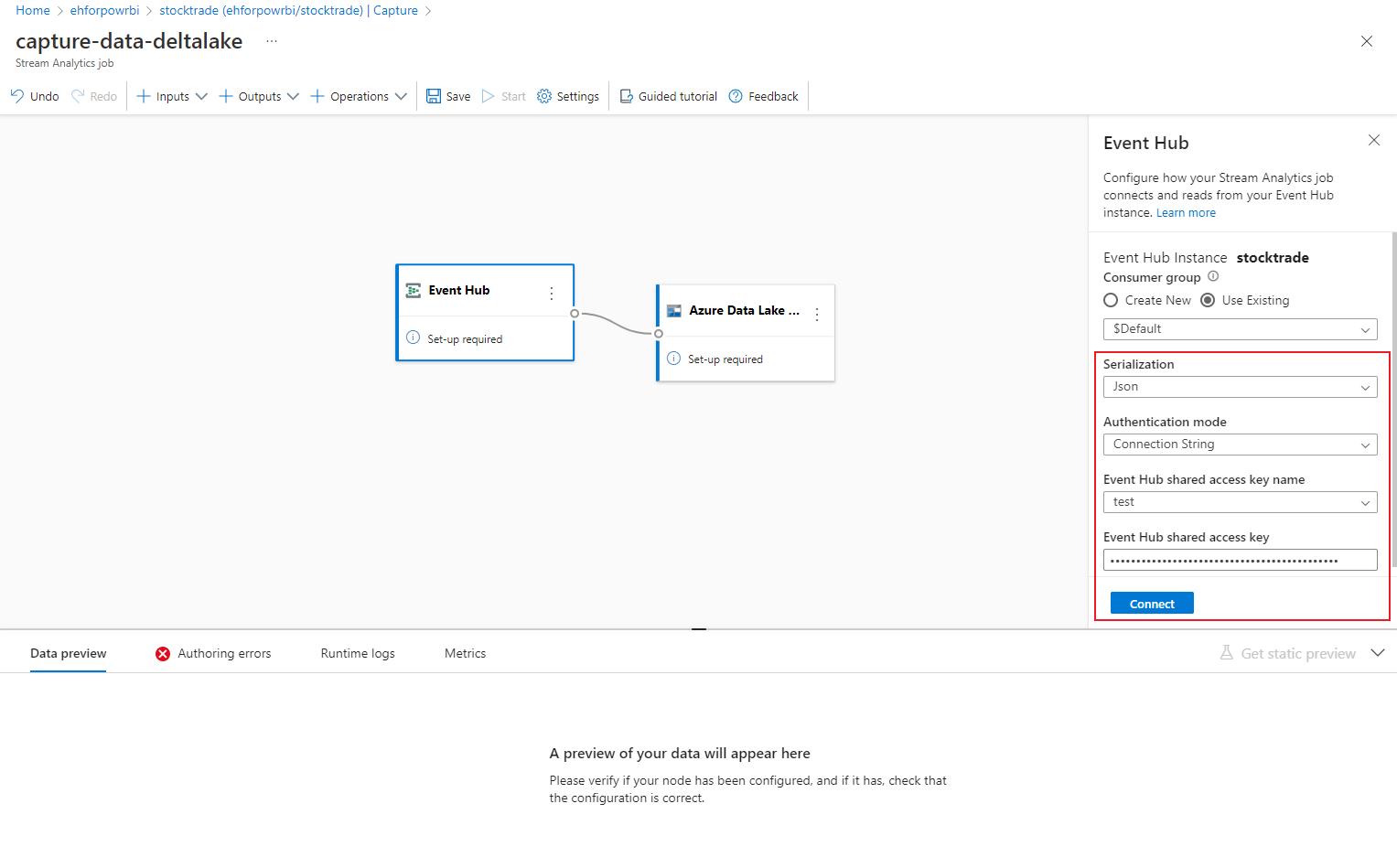

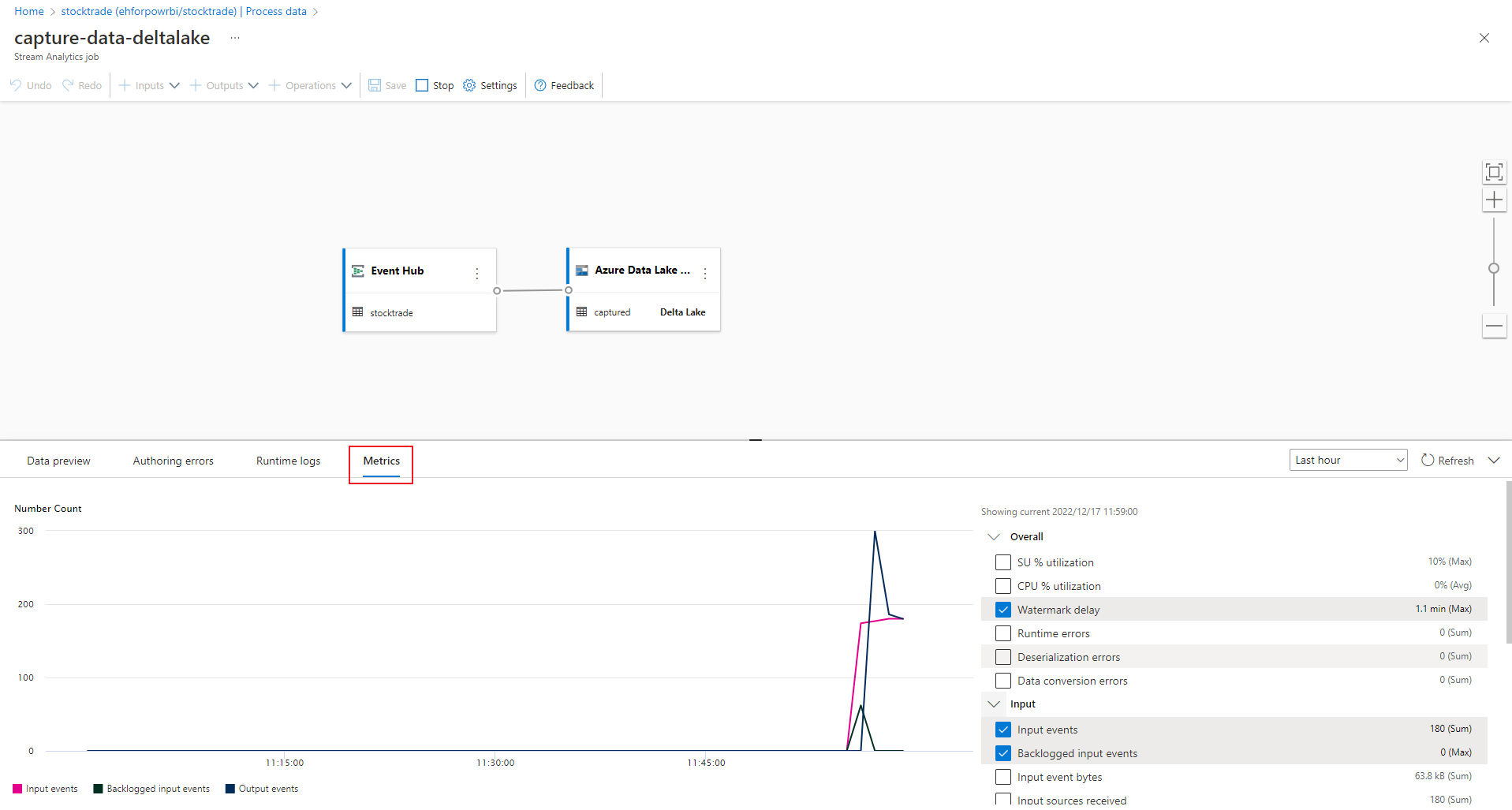

成功建立連線時,您會看到:

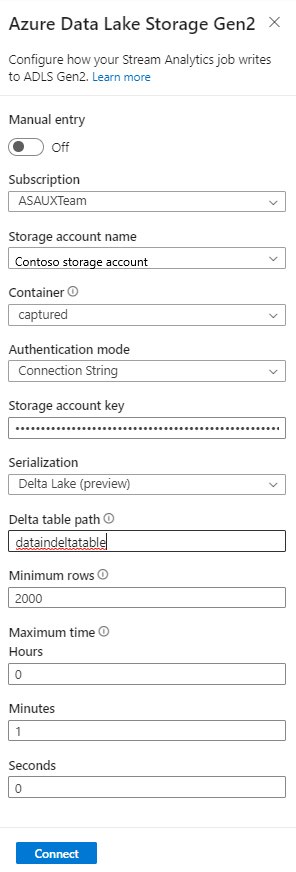

選取 [Azure Data Lake Storage Gen2] 圖格以編輯設定。

在 [Azure Data Lake Storage Gen2 設定] 頁面上,遵循下列步驟:

從下拉式功能表中選取 [訂用帳戶]、[儲存體帳戶名稱] 和 [容器]。

選取訂用帳戶之後,系統應會自動填入驗證方法和儲存體帳戶金鑰。

對於 Delta 資料表路徑,它會用來指定儲存在 Azure Data Lake Storage Gen2 中的 Delta Lake 資料表的位置和名稱。 您可以選擇使用一或多個路徑區段來定義 Delta 資料表的路徑和 Delta 資料表名稱。 若要深入瞭解,請參閱 寫入 Delta Lake 數據表。

選取 Connect。

建立連線時,您會看到輸出資料中存在的欄位。

在命令列上選取 [儲存],以便儲存設定。

在命令列上選取 [啟動],以便啟動串流流程來擷取資料。 然後在 [啟動串流分析] 作業視窗中:

- 選擇輸出開始時間。

- 選取作業執行時的串流單位 (SU) 數目。 SU 代表配置用來執行串流分析作業的計算資源。 如需詳細資訊,請參閱 Azure 串流分析串流單位。

![顯示 [開始串流分析] 作業視窗的螢幕快照,您可以在其中設定輸出開始時間、串流單位和錯誤處理。](media/capture-event-hub-data-delta-lake/start-job.png)

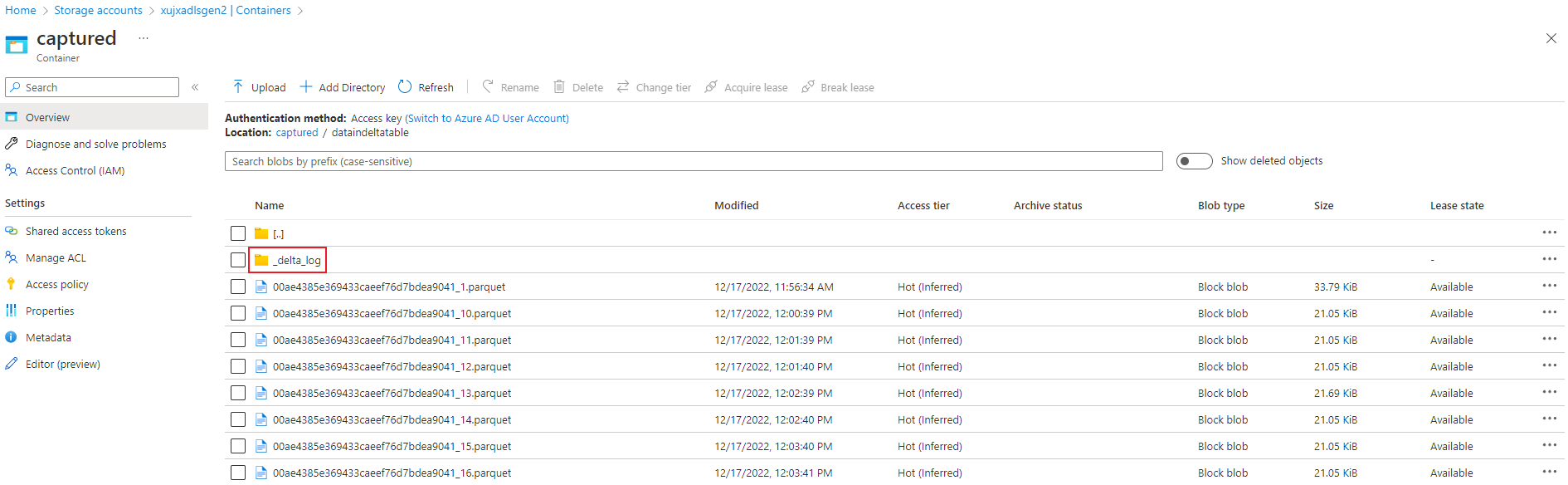

驗證輸出

確認具有 Delta Lake 格式的 parquet 檔案是在 Azure Data Lake Storage 容器中產生的。

使用事件中樞異地復寫功能的考慮

Azure 事件中樞 最近啟動公開預覽版中的異地復寫功能。 這項功能與 Azure 事件中樞的異地災害復原功能不同。

當故障轉移類型為強制且復寫一致性為異步時,串流分析作業不保證輸出至 Azure 事件中樞 輸出的確切一次。

Azure 串流分析,作為 具有事件中樞輸出的產生者 ,可能會在故障轉移期間和事件中樞節流期間觀察到作業的浮水印延遲,以防主要和次要之間的複寫延遲達到設定的延遲上限。

Azure 串流分析,作為 事件中樞作為輸入的取用者 ,可能會在故障轉移期間觀察作業的浮浮水印延遲,而且可能會在故障轉移完成後略過數據或尋找重複的數據。

由於這些注意事項,建議您在事件中樞故障轉移完成之後,立即以適當的開始時間重新啟動串流分析作業。 此外,由於事件中樞異地復寫功能處於公開預覽狀態,因此目前不建議將此模式用於生產串流分析作業。 在事件中樞異地復寫功能正式推出之前,目前的串流分析行為將會改善,並可用於串流分析生產作業。

下一步

現在,您已了解如何使用串流分析,而不需要程式碼編輯器來建立作業,以 Delta Lake 格式擷取至 Azure Data Lake Storage Gen2 的事件中樞資料。 接下來,您可以深入了解 Azure 串流分析,以及如何監視您所建立的作業。

![顯示您輸入作業名稱之 [新增串流分析作業] 視窗的螢幕快照。](media/capture-event-hub-data-delta-lake/new-stream-analytics-job-name.png)

![顯示 [數據預覽] 底下範例數據的螢幕快照。](media/capture-event-hub-data-delta-lake/edit-fields.png)

![顯示已選取 [開啟計量] 鏈接的螢幕快照。](media/capture-event-hub-data-delta-lake/open-metrics-link.png)