使用負責任 AI 儀表板評定 AI 系統

在實務上實作負責任 AI 需要嚴格的工程。 但是,若沒有適當的工具和基礎結構,嚴格的工程可能會很繁瑣、需手動執行且曠日耗時。

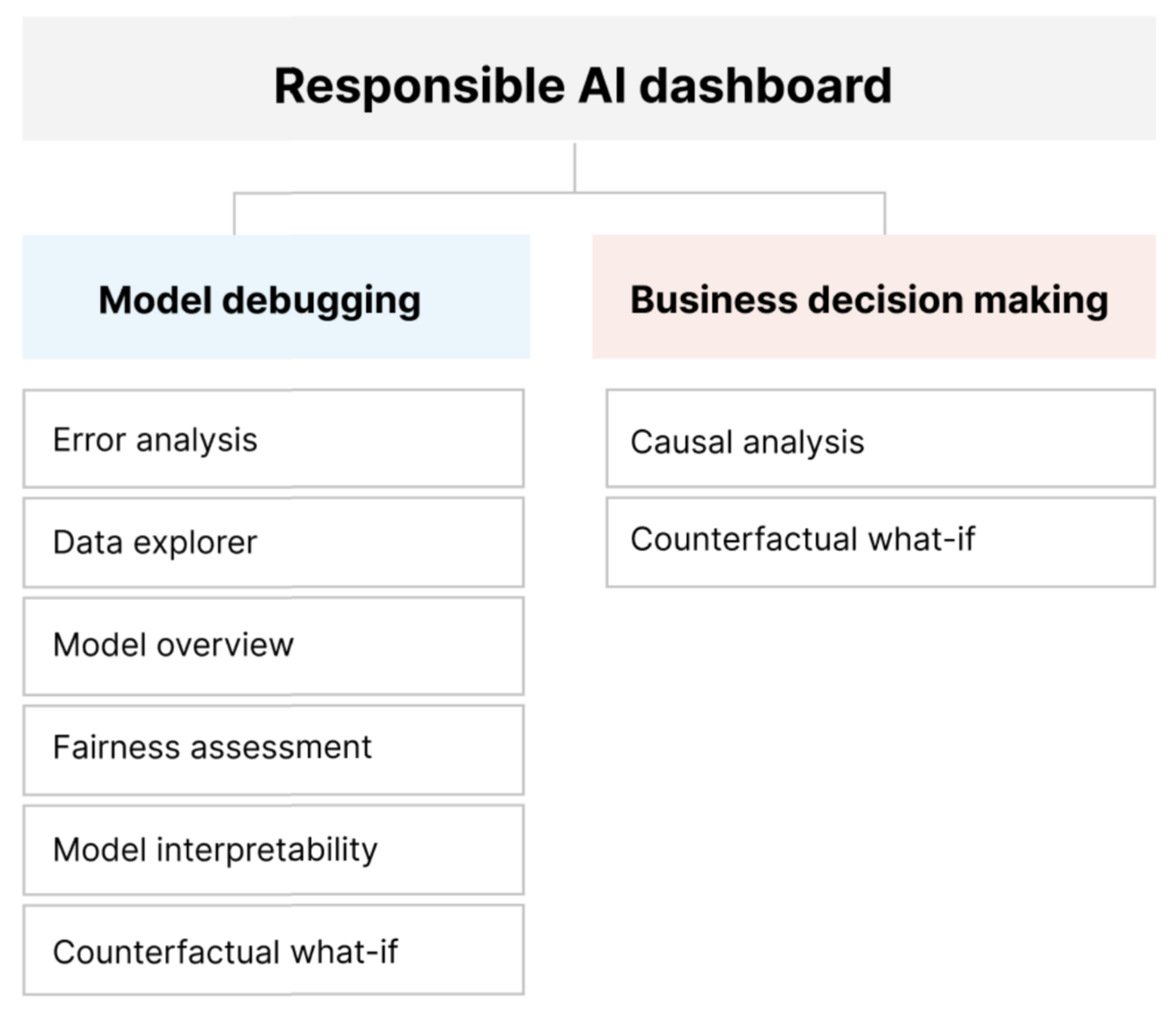

負責任 AI 儀表板提供單一介面,可協助您在實務上有效且有效率地實作負責任 AI。 其會將數個成熟的負責任 AI 工具結合在下列領域中:

- 模型效能與公平性評量 (英文)

- 資料探索

- 機器學習可解譯性 (英文)

- 錯誤分析

- 反事實分析與微擾 (英文)

- 原因推斷 (英文)

儀表板提供模型的整體評量和偵錯,讓您可以做出明智的資料驅動決策。 在一個介面中存取所有這些工具,可讓您:

透過識別模型錯誤與公平性問題、診斷那些錯誤發生的原因,以及通知您的風險降低步驟,以評估您的機器學習模型及對其進行偵錯。

透過解決下列問題來提升資料驅動決策制定能力:

「使用者可以套用至其特徵以從模型取得不同結果的最少量變更為何?」

「減少或增加特徵 (例如,食用紅肉) 對真實世界結果 (例如,糖尿病進程) 的因果影響為何?」

您可以自訂儀表板,只包含與您的使用案例相關的工具子集。

負責任 AI 儀表板隨附 PDF 計分卡 (部分機器翻譯)。 計分卡可讓您將負責任 AI 中繼資料與見解匯出到您的資料與模型。 您接著可以與產品和合規性專案關係人加以離線共用。

負責任的 AI 儀表板元件

負責任 AI 儀表板在全方位檢視中納入各種新工具與現有工具。 儀表板會將這些工具與 Azure Machine Learning CLI v2、Azure Machine Learning Python SDK v2 (部分機器翻譯) 和 Azure Machine Learning 工作室 (部分機器翻譯) 整合。 這些工具包括:

- 資料分析,以了解並探索您的資料集分布與統計資料。

- 模型概觀與公平性評量,以評估模型的效能,並評估模型的群組公平性問題 (您模型的預測如何影響不同人員群組)。

- 錯誤分析,以檢視並了解錯誤在您資料集中的分布方式。

- 模型可解譯性 (彙總與個別特徵的重要度值),以了解模型的預測,以及進行那些整體與個別預測的方式。

- 反事實假設狀況,以觀察特徵微擾如何影響模型預測,並提供具有相反或不同模型預測的最接近資料點。

- 原因分析,以使用歷史資料來檢視處理特徵對真實世界結果的因果影響。

這些工具可一起協助您對機器學習模型進行偵錯,同時讓您做出更好的資料驅動和模型驅動商務決策。 下圖顯示如何將它們併入您的 AI 生命週期,以改善模型並取得實在的資料深入解析。

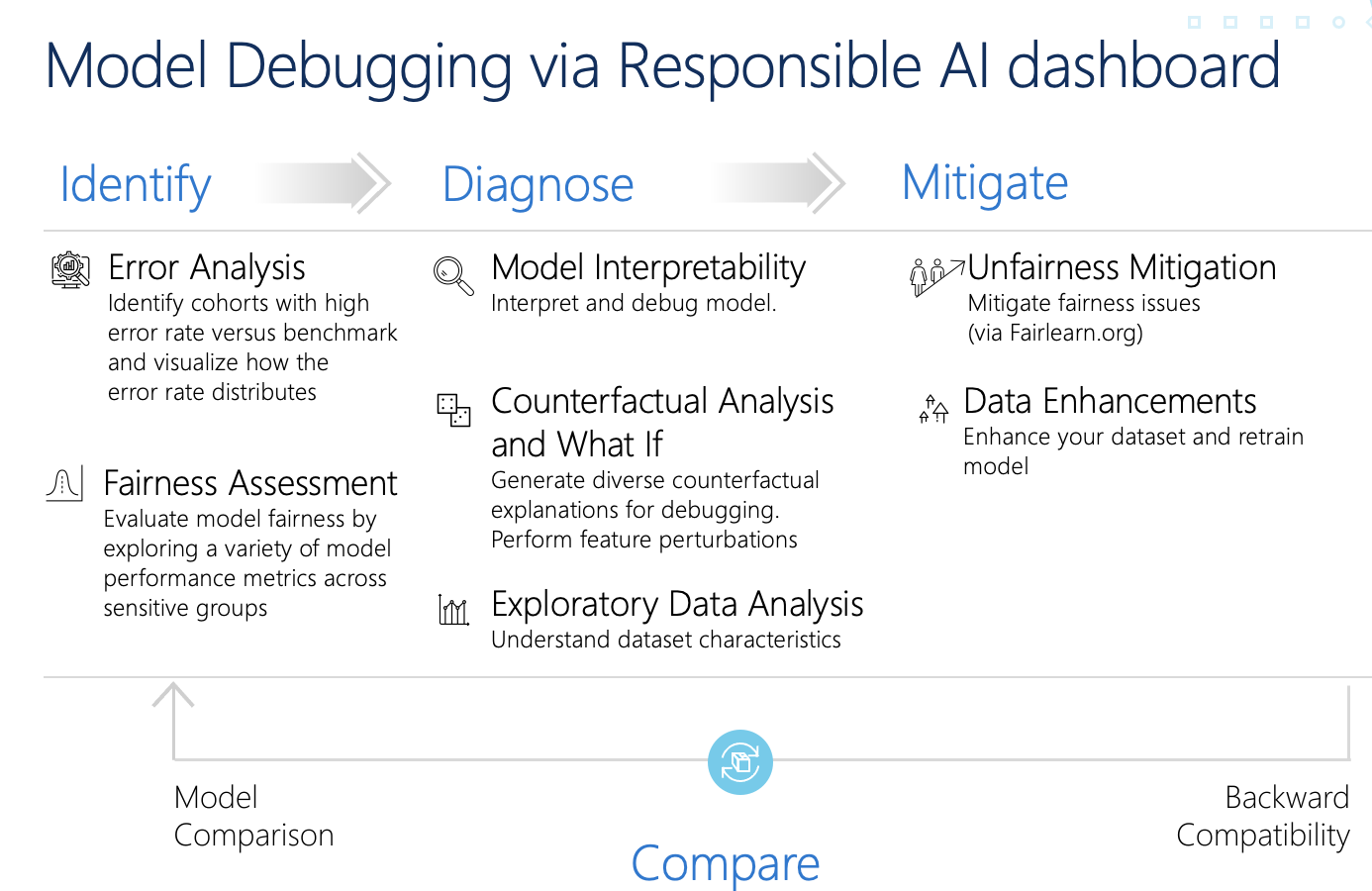

模型偵錯

評估和偵錯機器學習模型對於模型可靠性、可解釋性、公平性和合規性而言非常重要。 它有助於判斷 AI 系統的行為方式和原因。 然後,您可以使用此知識來改善模型效能。 從概念上講,模型偵錯包含三個階段:

識別,藉由解決下列問題來了解和辨識模型錯誤和/或公平性問題:

「我的模型有哪些錯誤?」

「哪些領域最常見到錯誤?」

診斷,藉由解決下列問題來探索所識別錯誤背後的原因:

「這些錯誤的原因為何?」

「我應該將資源放在何處以改善模型?」

風險降低,使用先前階段的識別和診斷深入解析,採取針對性的風險降低步驟並解決問題,例如:

「我該如何改善模型?」

「這些問題有哪些社交或技術解決方案?」

下表說明何時使用負責任 AI 儀表板元件來支援模型偵錯:

| 階段 | 元件 | 描述 |

|---|---|---|

| 確定 | 錯誤分析 | 錯誤分析元件可協助您深入了解模型失敗分布,並快速識別資料的錯誤世代 (子群組)。 儀表板中此元件的功能來自錯誤分析套件。 |

| 確定 | 公平性分析 | 公平性元件會根據敏感性屬性 (例如性別、種族與年齡) 定義群組。 其接著會評估模型預測如何影響這些群組,以及如何減輕差異。 其會透過探索群組之間的預測值和模型效能計量值的分布來評估模型的效能。 儀表板中此元件的功能來自 Fairlearn 套件。 |

| 確定 | 模型概觀 | 模型概觀元件會在高階模型預測分布檢視中彙總模型評量計量,以讓您能進一步調查其效能。 此件元件也會啟用群組公平性評估,並醒目提示不同敏感性群組之間的模型效能明細。 |

| 診斷 | 資料分析 | 資料分析會根據預測與實際結果、錯誤群組與具體特徵,將資料集視覺化。 您接著可以找出過度代表與代表性不足的問題,並了解資料如何在資料集中群集。 |

| 診斷 | 模型可解釋性 | 可解譯性元件會產生機器學習模型預測的人類可理解說明。 其會針對模型行為提供多種觀點: - 全域說明 (例如,哪些特徵會影響貸款配置模型的整體行為) - 局部說明 (例如,申請者的貸款申請為何通過核准或遭到拒絕) 儀表板中此元件的功能來自 InterpretML 套件。 |

| 診斷 | 反事實分析和假設 | 此元件由兩個功能所組成,可提供更好的錯誤診斷: - 產生一組範例,其中對特定點的最少量變更會改變模型的預測。 也就是說,這些範例會顯示具有相反模型預測的最接近資料點。 - 啟用個別資料點的互動式和自訂假設狀況擾動,以了解模型如何回應特徵變更。 儀表板中此元件的功能來自 DiCE 套件。 |

風險降低步驟可透過獨立工具 (例如 Fairlearn) 取得。 如需詳細資訊,請參閱不公平性風險降低演算法 (英文)。

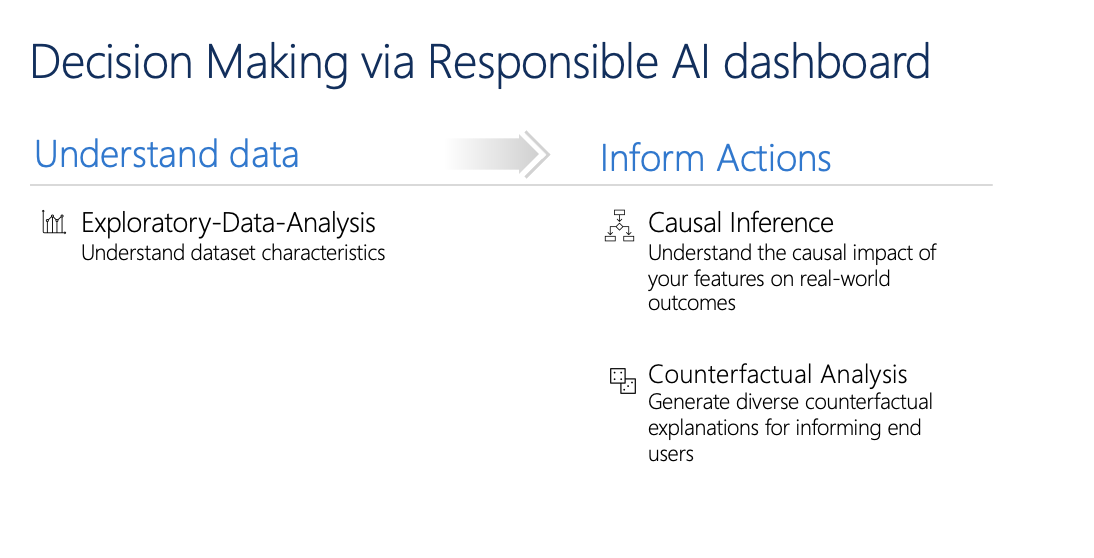

負責任的決策制定

決策是機器學習的最大承諾之一。 負責任 AI 儀表板可協助您透過下列方式做出明智的商業決策:

資料驅動見解,以單憑歷史資料來了解處理對結果的因果影響。 例如:

「某個藥物對於病患的血壓有何影響?」

「為特定客戶提供促銷價值如何影響營收?」

這些見解是透過儀表板的原因推斷元件提供。

模型驅動的深入解析,可回答使用者的問題 (例如「我下一次可以做什麼來從您的 AI 取得不同的結果」),以便採取動作。 這些見解是透過反事實假設狀況元件來提供給資料科學家。

探勘資料分析、原因推斷與反事實分析功能可協助您負責任地做出明智的模型驅動與資料驅動決策。

這些負責任 AI 儀表板元件支援負責任決策制定:

資料分析:您可以在這裡重複使用資料分析元件,以了解資料分布,以及識別過度代表與代表性不足。 資料探勘是決策制定的重要部分,但對於資料內代表性不足的世代做出明智的決策並不可行。

原因推斷:原因推斷元件會估計真實世界結果在出現干預時會如何變更。 它還能透過模擬對各種干預的特徵反應並制定規則來確定哪些人口群體將從特定干預中獲益,從而幫助建立看好的干預措施。 集合這些功能可讓您套用新的原則,並影響真實世界的變化。

此元件的功能來自 EconML 套件,可透過機器學習從觀測資料估計異質處理效果。

反事實分析:您可以在這裡重複使用反事實分析元件,以產生套用至資料點特徵並導致相反模型預測的最少量變更。 例如:如果 Taylor 年收入高出 $10,000 美元以上,且已開卡的信用卡再少兩張,則其會取得 AI 的貸款核准。

提供此資訊給使用者通知其觀點。 其教育它們如何採取動作以在未來從 AI 取得想要的結果。

此元件的功能來自 DiCE 套件。

使用負責任 AI 儀表板的原因

雖然負責任 AI 的特定領域個別工具有取得進展,但資料科學家通常需要使用各種工具來全面評估其模型和資料。 例如: 它們可能必須同時使用模型可解釋性和公平性評量。

如果資料科學家發現一個工具的公平性問題,則必須跳到不同的工具,以了解問題的根本資料或模型因素,再採取任何風險降低步驟。 下列因素讓這個具挑戰性的流程更加複雜化:

- 沒有一個統一的地方來探索和了解工具,因此延長了研究和學習新技術所需的時間。

- 不同的工具不會彼此通訊。 資料科學家必須在工具之間傳遞資料時擷取資料集、模型和其他中繼資料。

- 計量和視覺效果不容易比較,而且結果很難共用。

負責任 AI 儀表板會挑戰此現狀。 這是一個全面但可自定義的工具,可將分散的體驗整合在一起。 它可讓您順暢地上線至單一可自定義的架構,以進行模型偵錯和資料驅動的決策。

藉由使用負責任 AI 儀表板,您可以建立資料集世代、將這些世代傳遞至所有支援的元件,以及觀察已識別世代的模型健康情況。 您可以跨各種預先建置世代進一步比較來自所有支援元件的見解,以執行分類式分析,並找出模型的盲點。

當您準備好與其他專案關係人共用那些見解時,您可以使用負責任 AI PDF 計分卡輕鬆地加以擷取。 將 PDF 報告附加至您的合規性報告,或與同事共用,以建立信任並取得其核准。

自訂負責任 AI 儀表板的方式

負責任 AI 儀表板的優勢在於其可自訂性。 其可讓使用者設計量身打造的端對端模型偵錯,以及能解決其特定需求的決策工作流程。

需要一些靈感嗎? 以下的一些範例說明如何將儀表板元件組合在一起以各種方式分析案例:

| 負責任 AI 儀表板流程 | 使用案例 |

|---|---|

| 模型概觀 > 錯誤分析 > 資料分析 | 識別模型錯誤,並藉由了解基礎資料分佈來診斷這些錯誤 |

| 模型概觀 > 公平性評量 > 資料分析 | 識別模型公平性問題,並藉由了解基礎資料分佈來診斷這些錯誤 |

| 模型概觀 > 錯誤分析 > 反事實分析與假設狀況 | 使用反事實分析 (最小變更會導致不同的模型預測) 來診斷個別執行個體中的錯誤 |

| 模型概觀 > 資料分析 | 了解透過資料不平衡或缺少特定資料世代表示法所導致錯誤和公平性問題的根本原因 |

| 模型概觀 > 可解譯性 | 透過了解模型進行預測的方式來診斷模型錯誤 |

| 資料分析 > 原因推斷 | 區分資料中的相互關聯與原因,或決定所要套用來取得正面結果的最佳處理方式 |

| 可解譯性 > 原因推斷 | 了解模型用於預測制定的因素是否對真實世界結果有任何因果影響 |

| 資料分析 > 反事實分析與假設狀況 | 解決客戶對於下一次可執行哪些動作,以從 AI 系統取得不同結果的問題 |

應該使用負責任 AI 儀表板的人員

下列人員可以使用負責任 AI 儀表板及其對應的負責任 AI 計分卡,來建立與 AI 系統之間的信任:

- 有興趣在部署之前針對其機器學習模型進行偵錯及改善的機器學習專業人員與資料科學家

- 有興趣與產品經理和企業專案關係人分享其模型健康情況記錄,以建立信任並接收部署權限的機器學習專業人員與資料科學家

- 正在部署之前檢閱機器學習模型的產品經理和企業專案關係人

- 正在檢閱機器學習模型以了解公平性與可靠性問題的風險人員

- 想要向使用者說明模型決策或協助其改善結果的 AI 解決方案提供者

- 身處嚴格管制空間且需要與監管機關和稽核員共同檢閱機器學習模型的專業人員

支援的案例與限制

- 負責任 AI 儀表板目前支援在表格式結構化資料上定型的迴歸與分類 (二元與多類別) 模型。

- 負責任 AI 儀表板目前僅支援在 Azure Machine Learning 中使用 sklearn (scikit-learn) 類別註冊的 MLflow 模型。 scikit-learn 模型應該實作

predict()/predict_proba()方法,或者模型應該包裝在實作predict()/predict_proba()方法的類別內。 模型必須在元件環境中載入,而且必須是可進行二進位序列化及還原序列化 (Pickleable) 的。 - 負責任 AI 儀表板目前可在儀表板 UI 上將最多 5 千個資料點視覺化。 您應該先將資料集降級為 5 千個或更少,再加以傳遞至儀表板。

- 負責任 AI 儀表板的資料集輸入必須是 Parquet 格式的 pandas DataFrame。 目前不支援 NumPy 與 SciPy 疏鬆資料。

- 負責任 AI 儀表板目前支援數值或類別功能。 針對類別特徵,使用者必須明確指定特徵名稱。

- 負責任 AI 儀表板目前不支援具有超過 1 萬個資料行的資料集。

- 負責任 AI 儀表板目前不支援 AutoML MLFlow 模型。

- 負責任 AI 儀表板目前不支援從 UI 註冊的 AutoML 模型。

下一步

- 了解如何透過 CLI 和 SDK 或 Azure Machine Learning 工作室 UI 產生負責任 AI 儀表板。

- 了解如何根據在負責任 AI 儀表板中觀察到的見解來產生負責任 AI 計分卡。