適用於 Azure VMware 解決方案的 Azure NetApp Files 資料存放區效能效能評定

本文說明 Azure NetApp Files 資料存放區針對 Azure VMware 解決方案 (AVS) 上的虛擬機器所提供的效能基準。

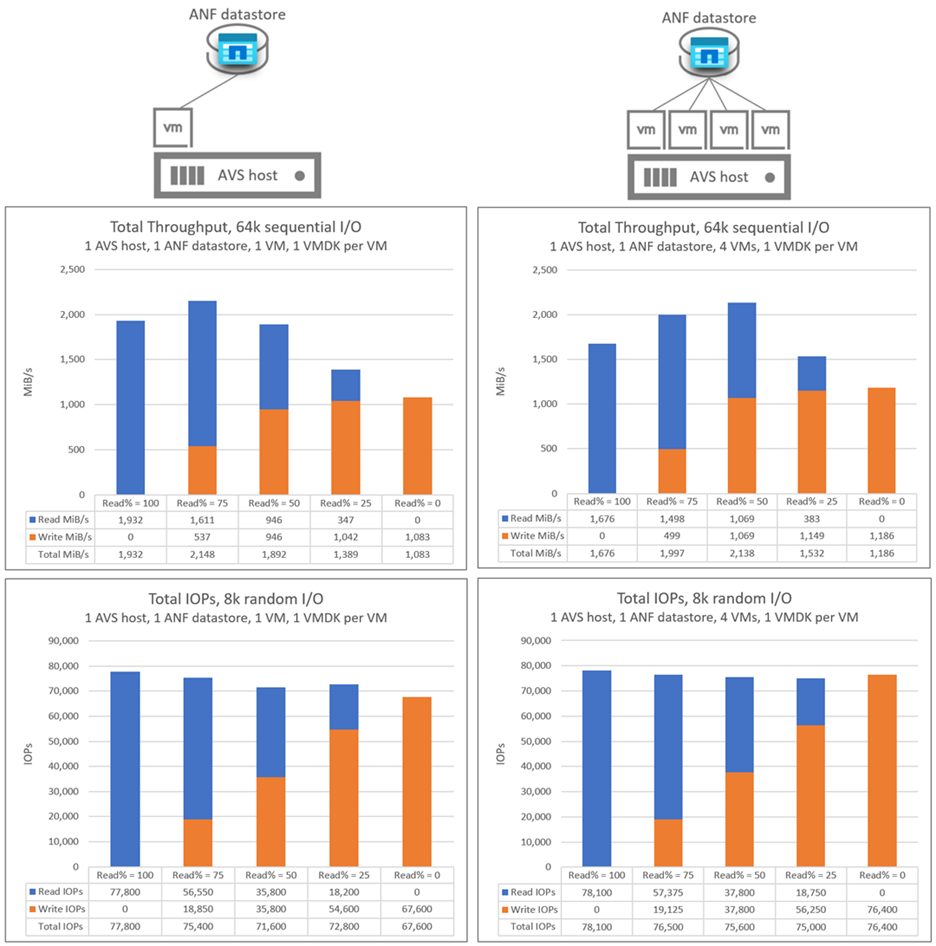

測試的案例如下所示:

- 在單一 AVS 主機和單一 Azure NetApp Files 資料存放區上執行的一對多虛擬機器

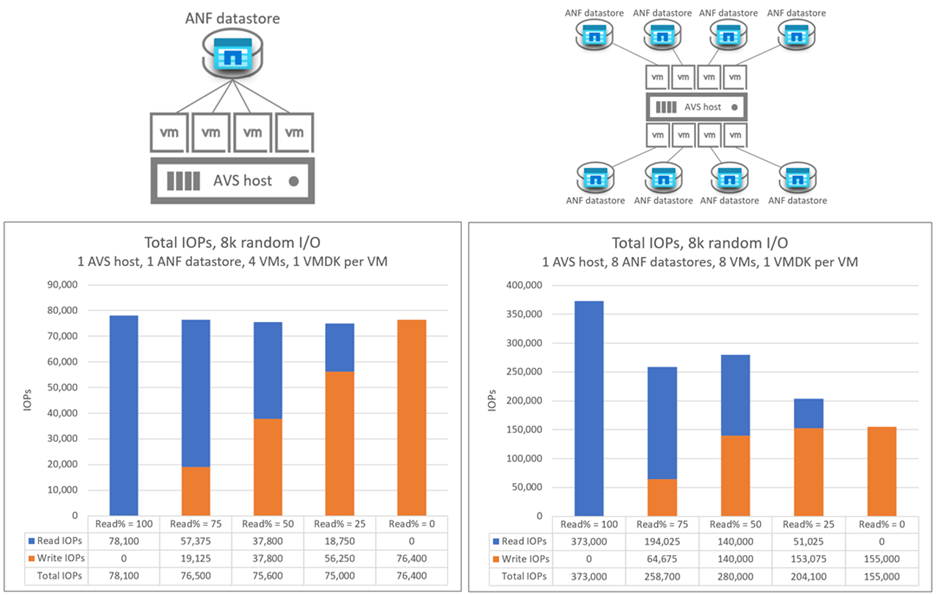

- 具有單一 AVS 主機的一對多 Azure NetApp Files 資料存放區

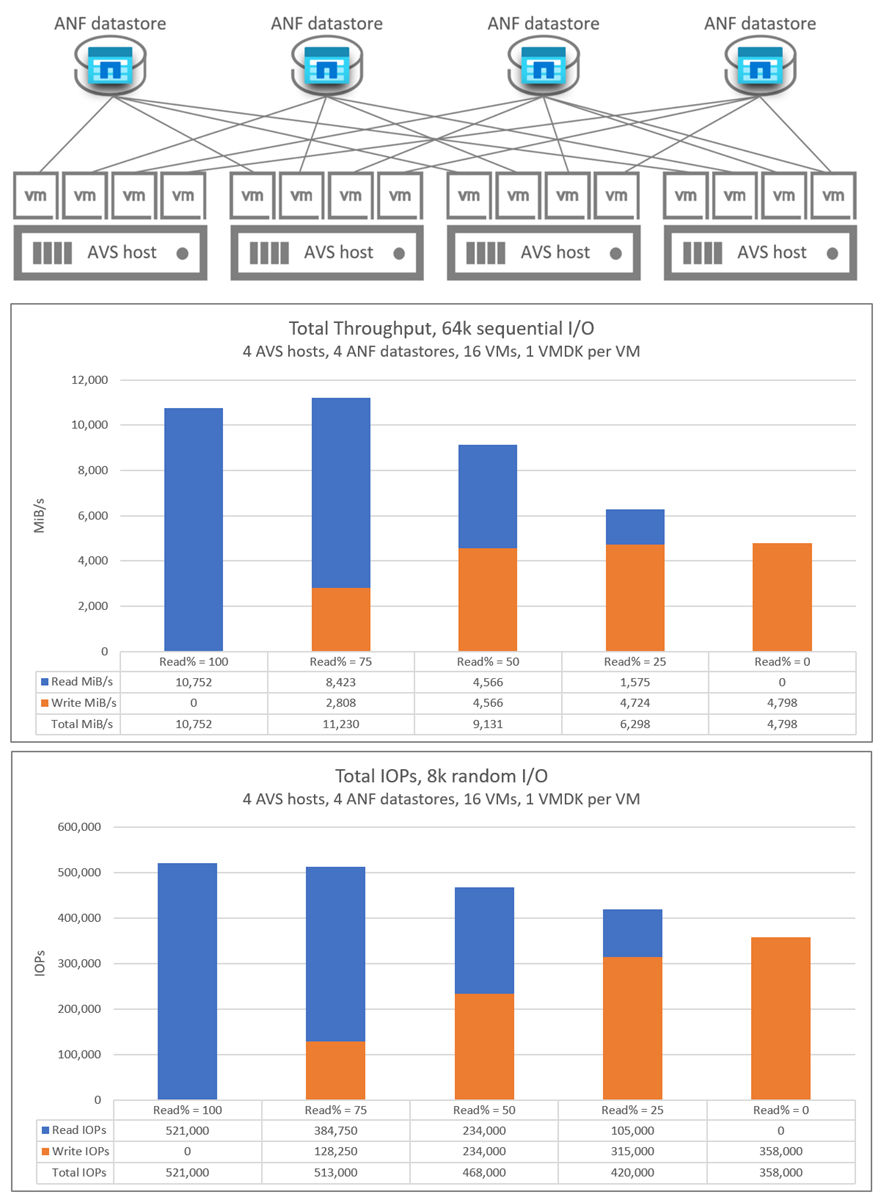

- 使用多個 AVS 主機擴增 Azure NetApp Files 資料存放區

已針對每個案例測試下列 read:write I/O 比率:100:0, 75:25, 50:50, 25:75, 0:100

本文所記載的基準是以足夠的磁碟區輸送量來執行,以防止軟性限制影響效能。 您可使用 Azure NetApp Files Premium 和 Ultra 服務等級來達到基準,而在某些情況下使用標準服務等級。 如需磁碟區輸送量詳細資訊,請參閱 Azure NetApp Files 的效能考量。

如需 Azure VMware 解決方案 TCO 估算器,請參閱 Azure NetApp Files 數據存放區,以瞭解 Azure NetApp Files 數據存放區的大小和相關聯成本優點。

延遲

從 AVS 到 Azure NetApp Files 數據存放區的流量延遲會因數百萬(針對負載最少的環境)最多 2-3 毫秒(針對中到負載繁重的環境) 而有所不同。 嘗試推送超過各種元件的輸送量限制的環境,延遲可能會更高。 延遲和輸送量可能會因 I/O 大小、讀取/寫入比率、競爭網路流量及其他因素而有所不同。

效能調整

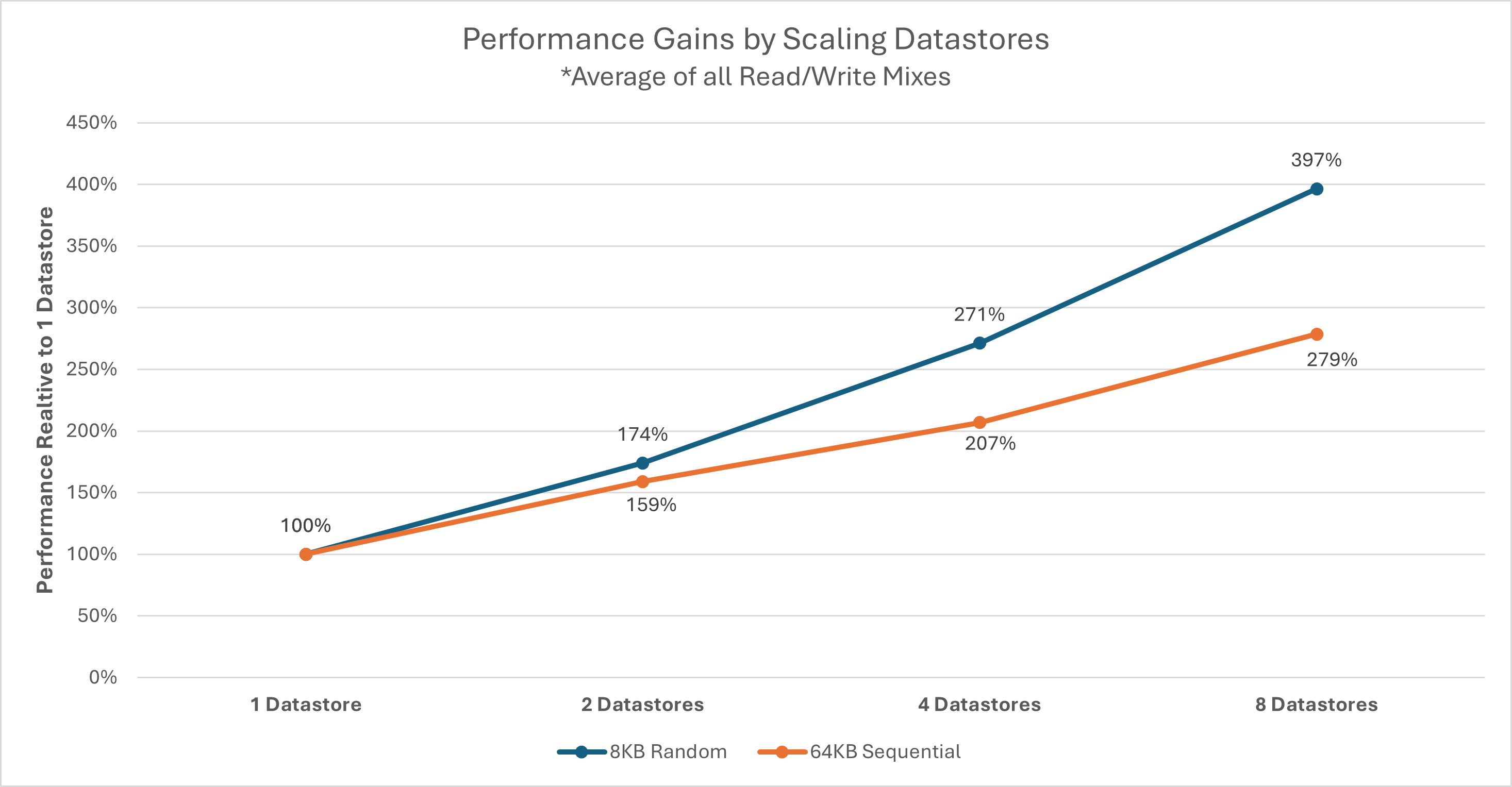

每個 AVS 主機都會使用固定數目的網路流程連線到每個 Azure NetApp Files 數據存放區,以限制個別 VM 磁碟的 (VMDK) 或 AVS 主機對每個數據存放區的輸送量。 視一組指定的工作負載及其效能需求而定,可能需要多個數據存放區。 每個 AVS 主機的整體記憶體效能可藉由將工作負載分散到多個資料存放區來增加。 您也可以將工作負載分散到 AVS 主機之間的每個數據存放區,藉以提升效能。 下圖顯示其他數據存放區的相對效能調整。

注意

外部數據存放區的輸送量上限可以受限於其他因素,包括 Azure NetApp Files 磁碟區的網路頻寬、SKU 限制或服務等級上限。

每個個別主機的輸送量可能會受到選取的 AVS SKU 影響。 AV64 SKU 有 100 Gb Gb 乙太網路 (GbE) 網路適配器 (NIC)。 其他 SKU 有 25 GbE NIC。 個別網路流程(例如 NFS 掛接)可能會受到 25 GbE NIC 的限制。

AV64 環境詳細數據

本文所述結果是以下列環境組態達成:

- Azure VMware 解決方案 主機大小:執行 VMware ESXi 7u3 版的 AV64

- Azure VMware 解決方案私人雲端連線:具有 FastPath 的 UltraPerformance 網路閘道

- 客體虛擬機:Rocky Linux 9、16 vCPU、64 GB 記憶體

- 工作負載產生器:

fio3.35

注意

AV64 測試僅著重於單一ESXi主機的評估。 在AV36一節中討論相應放大ESXi主機的數目。

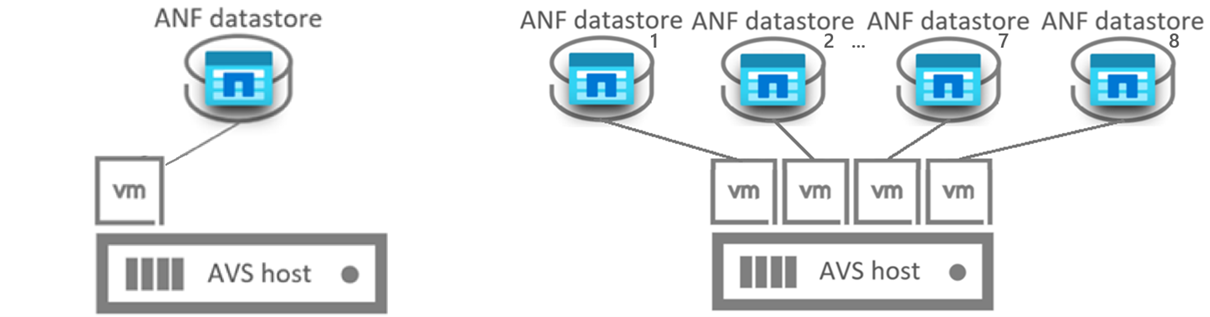

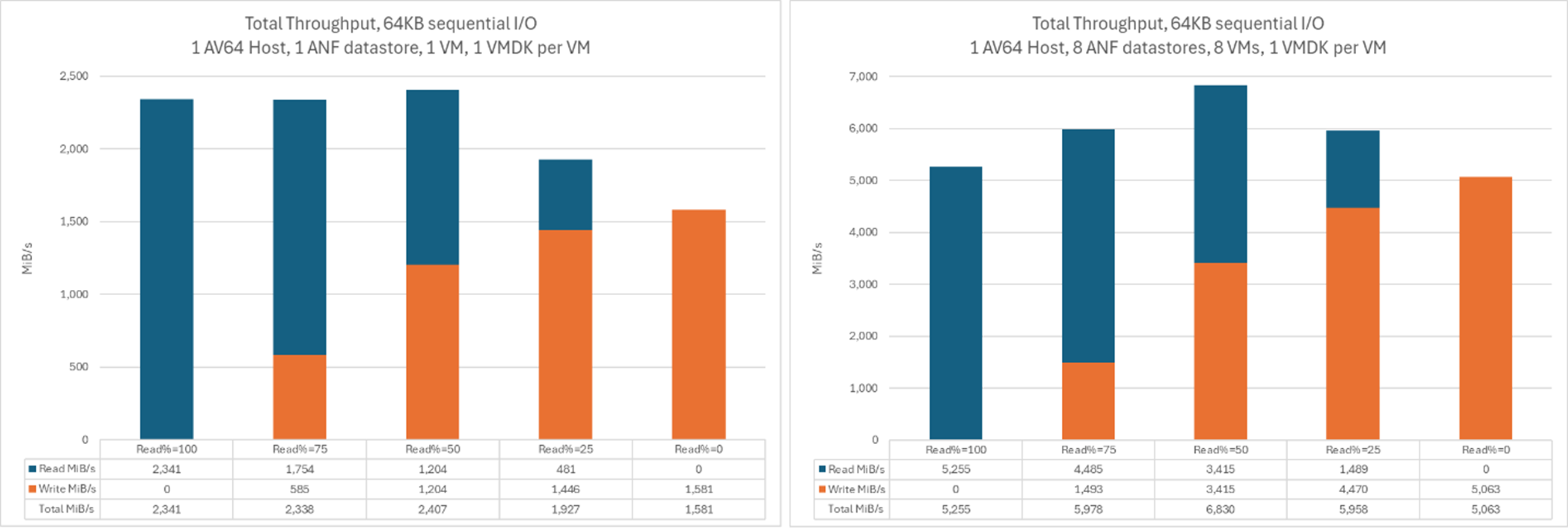

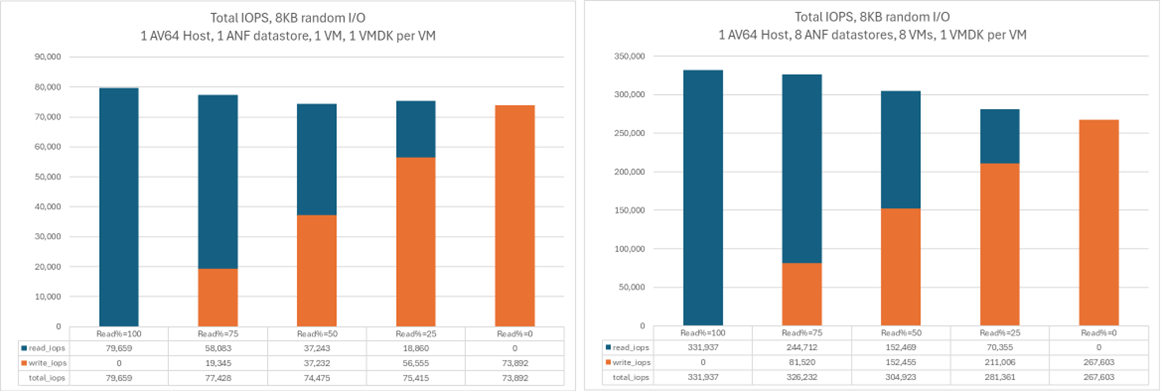

具有單一 AV64 主機的一對多 Azure NetApp Files 數據存放區

下圖比較單一 Azure NetApp Files 數據存放區上單一虛擬機的輸送量,以及八部 VM 的匯總輸送量,每個 VM 各自位於自己的 Azure NetApp Files 數據存放區上。 類似的輸送量可以透過較小的 VM 數目達成,而其他 VMDK 會分散在相同數目的資料存放區中。

此圖表會比較輸送量:

此圖表會比較 I/OPS:

AV36 環境詳細數據

這些測試是使用下列方式,使用下列環境設定來執行:

- Azure VMware 解決方案 主機大小:執行 VMware ESXi 7u3 版的 AV36

- Azure VMware 解決方案私人雲端連線:具有 FastPath 的 UltraPerformance 網路閘道

- 客體虛擬機:Ubuntu 21.04、16 個 vCPU、64 GB 記憶體

- 工作負載產生器:

fio

在單一 AV36 主機上執行的一對多虛擬機和單一 Azure NetApp Files 數據存放區

在單一 AVS 主機案例中,AVS 至 Azure NetApp Files 資料存放區 I/O 會透過單一網路流程發生。 這些圖表會比較單一虛擬機的輸送量和 I/OP 與四部虛擬機的匯總輸送量和 I/OPS。 在後續的案例中,隨著新增更多主機和資料存放區,網路流程數目會增加。

具有單一 AV36 主機的一對多 Azure NetApp Files 數據存放區

下圖比較單一 Azure NetApp Files 資料存放區上單一虛擬機器的輸送量與四個 Azure NetApp Files 資料存放區的彙總輸送量。 在這兩種情況下,每部虛擬機器在每個 Azure NetApp Files 資料存放區上都有 VMDK。

下圖比較單一 Azure NetApp Files 數據存放區上單一虛擬機的 I/OPS 與八個 Azure NetApp Files 數據存放區的匯總 I/OPS。 在這兩種情況下,每部虛擬機器在每個 Azure NetApp Files 資料存放區上都有 VMDK。

使用多個 AV36 主機向外延展 Azure NetApp Files 數據存放區

下圖顯示分散在四部 AVS 主機的 16 部虛擬機的匯總輸送量和 I/OPS。 每個 AVS 主機有四部虛擬機器,每部虛擬機器位於不同的 Azure NetApp Files 資料存放區上。 使用每個主機上的單一虛擬機器 (每部虛擬機器有四個 VMDK) 與個別資料存放區上的每個 VMDK,達到了幾乎相同的結果。