Azure 本機主機網路需求

適用於:Azure 本機版本 23H2 和 22H2

本主題討論 Azure 本機的主機網路考慮和需求。 如需數據中心架構和機器之間實體連線的資訊,請參閱 實體網路需求。

如需如何使用網路 ATC 簡化主機網路的資訊,請參閱 使用網路 ATC 簡化主機網路功能。

網路流量類型

Azure 局域網路流量可依其預定用途進行分類:

- 管理流量: 本機系統外部的流量。 例如,系統管理員用來管理系統的記憶體複本流量或流量,例如遠端桌面、Windows Admin Center、Active Directory 等。

- 計算流量: 源自或目的地為虛擬機的流量(VM)。

- 記憶體流量:使用伺服器消息塊的流量(SMB),例如 儲存空間直接存取 或以SMB為基礎的即時移轉。 此流量為第 2 層流量,且無法路由傳送。

重要

記憶體復本使用非 RDMA 型 SMB 流量。 這和流量(南北)的方向性使得它與上面所列的「管理」流量緊密對齊,類似於傳統檔案共用的流量。

選取網路適配器

網路適配器是由 網路流量類型 限定的(請參閱上圖),支援它們搭配使用。 當您檢閱 Windows Server 目錄時,Windows Server 2022 認證現在會指出下列一或多個角色。 在購買 Azure 本機電腦之前,您至少必須有一個適配卡符合管理、計算和記憶體的資格,因為 Azure 本機上需要這三種流量類型。 然後 ,您可以使用網路 ATC 來設定適用於適當流量類型的適配卡。

如需此角色型 NIC 資格的詳細資訊,請參閱此 Windows Server 部落格文章。

重要

不支援在其限定流量類型之外使用配接器。

| 層級 | 管理角色 | 計算角色 | 記憶體角色 |

|---|---|---|---|

| 角色型區別 | 管理 | 計算標準 | Storage Standard |

| 最高獎勵 | 不適用 | 計算 (進階) | 記憶體進階 |

注意

我們生態系統中任何適配卡的最高資格將包含管理、計算進階和記憶體進階資格。

驅動程式需求

不支援使用收件匣驅動程式與 Azure Local。 若要識別您的配接器是否使用收件匣驅動程式,請執行下列 Cmdlet。 如果 DriverProvider 屬性是Microsoft,配接器就會使用收件匣驅動程式。

Get-NetAdapter -Name <AdapterName> | Select *Driver*

主要網路適配器功能概觀

Azure 本機所使用的重要網路適配器功能包括:

- 動態虛擬機器多佇列 (動態 VMMQ 或 d.VMMQ)

- 遠端直接記憶體存取 (RDMA)

- 客體 RDMA

- 交換器嵌入式分組 (SET)

動態 VMMQ

所有具有計算 (Premium) 資格的網路適配器都支援動態 VMMQ。 動態 VMMQ 需要使用交換器內嵌小組。

適用的流量類型: 計算

所需的認證: 計算(進階版)

動態 VMMQ 是智慧型手機接收端技術。 其建置基礎是虛擬機佇列 (VMQ)、虛擬接收端調整 (vRSS) 和 VMMQ 的前置專案,以提供三個主要改善:

- 使用較少的CPU核心,將主機效率優化。

- 自動調整對 CPU 核心的網路流量處理,讓 VM 能夠符合和維護預期的輸送量。

- 可讓「高載」工作負載接收預期的流量量。

如需動態 VMMQ 的詳細資訊,請參閱部落格文章 綜合加速。

RDMA

RDMA 是網路適配器的網路堆疊卸除。 它允許SMB記憶體流量略過作業系統進行處理。

RDMA 使用最少的主機 CPU 資源,啟用高輸送量、低延遲的網路功能。 然後,這些主機 CPU 資源可用來執行其他 VM 或容器。

適用的流量類型: 主機記憶體

所需的認證: 記憶體(標準)

具有記憶體(標準)或記憶體(進階)資格的所有適配卡都支援主機端 RDMA。 如需搭配客體工作負載使用 RDMA 的詳細資訊,請參閱本文稍後的<客體 RDMA>一節。

Azure Local 支援具有因特網廣域 RDMA 通訊協定 (iWARP) 或 RDMA over Converged Ethernet (RoCE) 通訊協定實作的 RDMA。

重要

RDMA 配接器只能與其他實作相同 RDMA 通訊協定的 RDMA 適配卡(iWARP 或 RoCE) 搭配使用。

並非所有廠商的網路適配器都支援 RDMA。 下表列出提供經認證的 RDMA 配接器廠商(依字母順序排列)。 不過,此清單中未包含硬體廠商也支援 RDMA。 請參閱 Windows Server 目錄,以尋找具有需要 RDMA 支援的記憶體(標準)或記憶體(進階)資格的適配卡。

注意

Azure Local 不支援 InfiniBand (IB)。

| NIC 廠商 | iWARP | RoCE |

|---|---|---|

| Broadcom | No | Yes |

| Intel | Yes | 是 (一些模型) |

| 奇跡(Qlogic) | Yes | Yes |

| Nvidia | No | Yes |

如需為主機部署 RDMA 的詳細資訊,強烈建議您使用網路 ATC。 如需手動部署的資訊, 請參閱 SDN GitHub 存放庫。

iWARP

iWARP 使用傳輸控制通訊協定 (TCP),並可以選擇性地使用優先順序型流量控制 (PFC) 和增強傳輸服務 (ETS) 來增強。

如果:

- 您沒有管理 RDMA 網路的經驗。

- 您不管理或不舒服地管理機架頂端 (ToR) 交換器。

- 部署之後,您將不會管理解決方案。

- 您已經有使用 iWARP 的部署。

- 您不確定選擇哪一個選項。

RoCE

RoCE 使用使用者數據報通訊協定 (UDP),並要求 PFC 和 ETS 提供可靠性。

如果:

- 您已在資料中心內使用 RoCE 進行部署。

- 您很熟悉管理DCB網路需求。

客體 RDMA

客體 RDMA 可讓 VM 的 SMB 工作負載獲得在主機上使用 RDMA 的相同優點。

適用的流量類型: 客體型記憶體

所需的認證: 計算(進階版)

使用客體 RDMA 的主要優點包括:

- CPU 卸除至 NIC 以進行網路流量處理。

- 非常低的延遲。

- 高輸送量。

如需詳細資訊,請從 SDN GitHub 存放庫下載檔。

交換器嵌入式分組 (SET)

SET 是軟體型小組技術,自 Windows Server 2016 年以來一直包含在 Windows Server 操作系統中。 SET 是唯一由 Azure Local 支援的小組技術。 SET 適用於計算、記憶體和管理流量,且在相同小組中最多支援八個適配卡。

適用的流量類型: 計算、記憶體和管理

所需的認證: 計算(標準)或計算(進階)

SET 是唯一由 Azure Local 支援的小組技術。 SET 適用於計算、記憶體和管理流量。

重要

Azure 本機不支援使用舊版負載平衡/故障轉移 (LBFO) 的 NIC 小組。 如需 Azure 本機 LBFO 的詳細資訊,請參閱部落格文章 Teaming in Azure Local 。

SET 對於 Azure Local 很重要,因為它是唯一啟用下列專案的小組技術:

- RDMA 配接器小組(如有需要)。

- 來賓 RDMA。

- 動態 VMMQ。

- 其他重要的 Azure 本機功能(請參閱 Azure 本機小組)。

SET 需要使用對稱 (相同) 介面卡。 對稱網路介面卡是具有下列相同項目的介面卡:

- 製作 (廠商)

- 型號 (版本)

- 速度 (輸送量)

- 組態

在 22H2 中,網路 ATC 會自動偵測並通知您您選擇的適配卡是否非對稱。 手動識別適配卡是否對稱最簡單的方式,是速度與介面描述 是否完全 相符。 它們只能在描述中所列的數位中偏離。 Get-NetAdapterAdvancedProperty使用 Cmdlet 來確保所報告的組態會列出相同的屬性值。

請參閱下表,以取得僅依數位(#) 偏離的介面描述範例:

| 名稱 | 介面描述 | 連結速度 |

|---|---|---|

| NIC1 | 網路適配器 #1 | 25 Gbps |

| NIC2 | 網路適配器 #2 | 25 Gbps |

| NIC3 | 網路適配器 #3 | 25 Gbps |

| NIC4 | 網路適配器 #4 | 25 Gbps |

注意

SET 僅支援使用動態或 Hyper-V 埠負載平衡演算法的交換器獨立設定。 為了達到最佳效能,建議使用 Hyper-V 連接埠,以在所有於 10 Gbps 以上運作的 NIC 上使用。 網路 ATC 會針對 SET 進行所有必要的設定。

RDMA 流量考慮

如果您實作 DCB,您必須確定 PFC 和 ETS 組態已透過每個網路埠正確實作,包括網路交換器。 RoCE 需要 DCB,而 iWARP 則為選擇性專案。

如需如何部署 RDMA 的詳細資訊,請從 SDN GitHub 存放庫下載檔。

以 RoCE 為基礎的 Azure 本機實作需要設定三個 PFC 流量類別,包括跨網狀架構和所有主機的預設流量類別。

系統流量類別

此流量類別可確保有足夠的頻寬保留給系統活動訊號:

- 必要︰ 是

- 啟用 PFC:否

- 建議的流量優先順序:優先順序 7

- 建議的頻寬保留:

- 10 GbE 或較低的 RDMA 網路 = 2%

- 25 GbE 或更高版本的 RDMA 網路 = 1%

RDMA 流量類別

此流量類別可確保使用 SMB 直接傳輸為無遺失 RDMA 通訊保留足夠的頻寬:

- 必要︰ 是

- 啟用 PFC:是

- 建議的流量優先順序:優先順序 3 或 4

- 建議的頻寬保留:50%

默認流量類別

此流量類別會攜帶系統或 RDMA 流量類別中未定義的所有其他流量,包括 VM 流量和管理流量:

- 必要:根據預設,主機不需要設定)

- 流程控制 (PFC) 已啟用: 否

- 建議的流量類別:預設為 [優先順序 0]

- 建議的頻寬保留:根據預設(不需要主機設定)

記憶體流量模型

SMB 提供許多優點作為 Azure 本機的記憶體通訊協定,包括 SMB 多重通道。 本文未涵蓋SMB多重通道,但請務必瞭解SMB多重通道可以使用的每個可能連結之間多任務處理流量。

注意

我們建議使用多個子網和 VLAN 來分隔 Azure 本機中的記憶體流量。

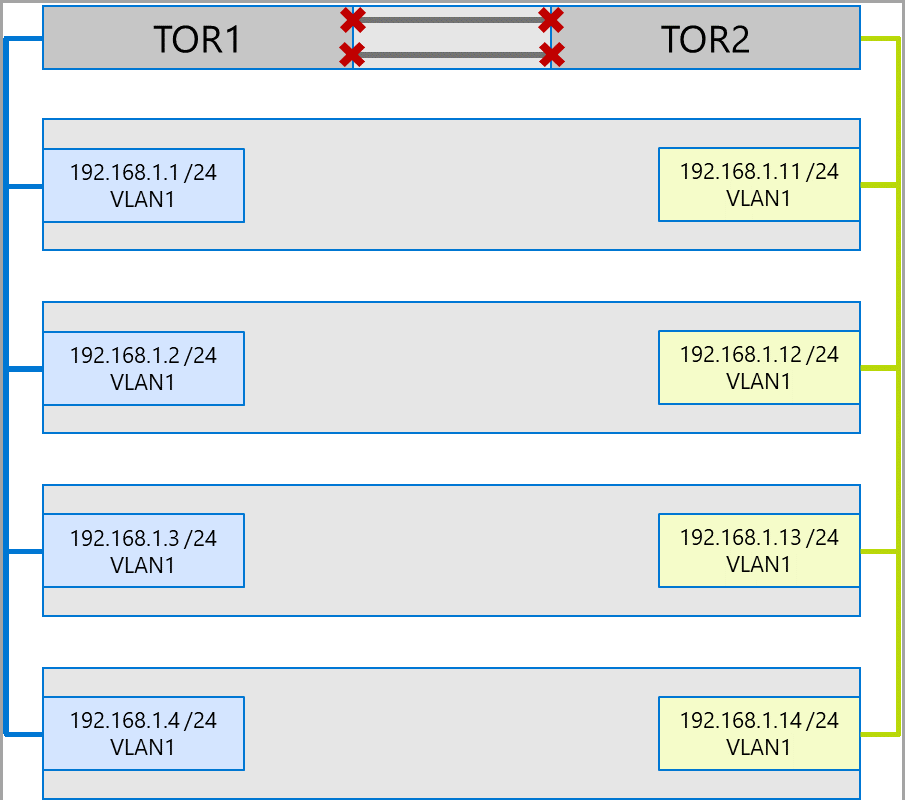

請考慮下列四個節點系統的範例。 每部機器都有兩個儲存埠(左側和右側)。 因為每個適配卡都位於相同的子網和 VLAN 上,SMB 多重通道會將連線分散到所有可用的連結。 因此,第一部機器上的左側埠(192.168.1.1)會與第二部機器上的左側埠連線(192.168.1.2)。 第一部電腦上的右側埠 (192.168.1.12) 會連線到第二部計算機上的右側埠。 針對第三部和第四部機器建立類似的連線。

不過,這會建立不必要的連線,並導致連接 ToR 交換器(標示為 X 的多重底座連結匯總群組或 MC-LAG)的擁堵。 請參閱下圖:

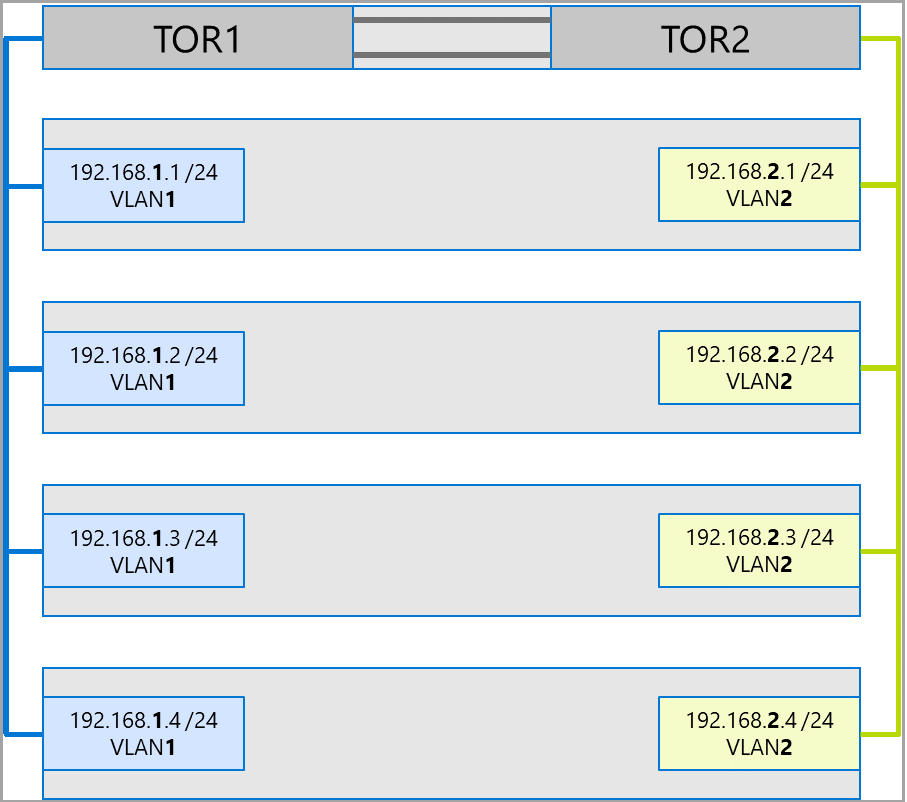

建議的方法是針對每組配接器使用不同的子網和 VLAN。 在下圖中,右側埠現在使用子網 192.168.2.x /24 和 VLAN2。 這可讓左側埠上的流量保留在 TOR1 上,而右側埠上的流量會保留在 TOR2 上。

流量頻寬配置

下表顯示 Azure Local 中使用常見配接器速度的各種流量類型頻寬配置範例。 請注意,這是交集解決方案的範例,其中所有流量類型(計算、記憶體和管理)都會在相同的實體適配卡上執行,並使用SET進行小組處理。

由於此使用案例構成最多條件約束,因此它代表良好的基準。 不過,考慮到適配卡數目和速度的排列,這應該視為範例,而不是支援需求。

下列假設是針對此範例進行的:

每個小組有兩張配接器。

記憶體總線層 (SBL)、叢集共用磁碟區 (CSV) 和 Hyper-V (實時移轉) 流量:

- 使用相同的實體配接器。

- 使用SMB。

使用DCB提供50%的頻寬配置SMB。

- SBL/CSV 是最高優先順序的流量,並接收 70% 的 SMB 頻寬保留。

- 即時移轉 (LM) 受限於使用

Set-SMBBandwidthLimitCmdlet,並接收剩餘頻寬的 29%。如果即時移轉的可用頻寬為 >= 5 Gbps,且網路適配器已啟用,請使用 RDMA。 使用下列 Cmdlet 來執行此動作:

Set-VMHost -VirtualMachineMigrationPerformanceOption SMB如果即時移轉的可用頻寬為 < 5 Gbps,請使用壓縮來減少停電時間。 使用下列 Cmdlet 來執行此動作:

Set-VMHost -VirtualMachineMigrationPerformanceOption Compression

如果您使用 RDMA 進行即時移轉流量,請確定即時移轉流量無法使用 SMB 頻寬限制來耗用配置給 RDMA 流量類別的整個頻寬。 請小心,因為此 Cmdlet 會採用每秒位元組為單位的專案(Bps),而網路適配器則以每秒位為單位列出(bps)。 使用下列 Cmdlet 來設定 6 Gbps 的頻寬限制,例如:

Set-SMBBandwidthLimit -Category LiveMigration -BytesPerSecond 750MB注意

此範例中的 750 MBps 相當於 6 Gbps。

以下是頻寬設定資料表範例:

| NIC 速度 | 小組帶寬 | SMB 帶寬保留** | SBL/CSV % | SBL/CSV 頻寬 | 即時移轉 % | 即時移轉頻寬上限 | 活動訊號 % | 活動訊號頻寬 |

|---|---|---|---|---|---|---|---|---|

| 10 Gbps | 20 Gbps | 10 Gbps | 70% | 7 Gbps | * | 200 Mbps | ||

| 25 Gbps | 50 Gbps | 25 Gbps | 70% | 17.5 Gbps | 29% | 7.25 Gbps | %1 | 250 Mbps |

| 40 Gbps | 80 Gbps | 40 Gbps | 70% | 28 Gbps | 29% | 11.6 Gbps | %1 | 400 Mbps |

| 50 Gbps | 100 Gbps | 50 Gbps | 70% | 35 Gbps | 29% | 14.5 Gbps | %1 | 500 Mbps |

| 100 Gbps | 200 Gbps | 100 Gbps | 70% | 70 Gbps | 29% | 29 Gbps | %1 | 1 Gbps |

| 200 Gbps | 400 Gbps | 200 Gbps | 70% | 140 Gbps | 29% | 58 Gbps | %1 | 2 Gbps |

* 使用壓縮而不是 RDMA,因為即時移轉流量的頻寬配置是 <5 Gbps。

** 50% 是頻寬保留的範例。

延展式叢集

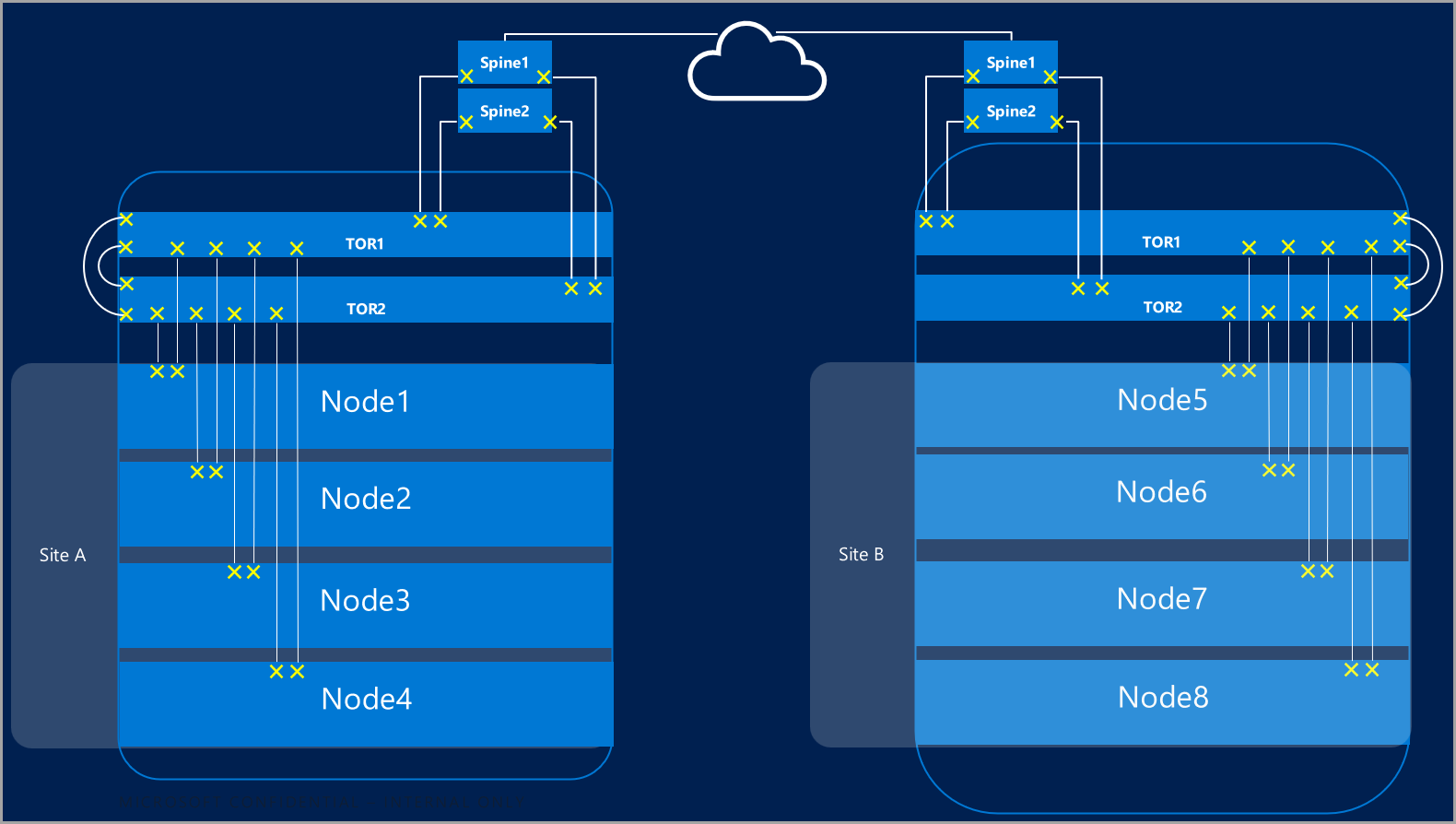

延展式叢集提供跨越多個數據中心的災害復原。 以最簡單的形式,Azure Local 的延展式叢集看起來像這樣:

延展式叢集需求

重要

延展式叢集功能僅適用於 Azure 本機 22H2 版。

延展式叢集具有下列需求和特性:

RDMA 僅限於單一月臺,且不支援跨不同月臺或子網。

相同站台中的機器必須位於相同的機架和第 2 層界限中。

月臺之間的主機通訊必須跨越第 3 層界限;不支援延展式第2層拓撲。

有足夠的頻寬可在其他月臺執行工作負載。 發生故障轉移時,替代月台必須執行所有流量。 建議您以 50% 的可用網路容量布建月臺。 不過,如果您能夠在故障轉移期間容許較低的效能,則這不是必要條件。

用於站台之間通訊的配接器:

可以是實體或虛擬(主機 vNIC)。 如果適配卡是虛擬的,您必須在每個實體 NIC 的子網和 VLAN 中布建一個 vNIC。

必須位於自己的子網和可在月臺之間路由的 VLAN。

必須使用 Cmdlet 來

Disable-NetAdapterRDMA停用 RDMA。 建議您使用 Cmdlet 明確要求記憶體複本使用Set-SRNetworkConstraint特定介面。必須符合記憶體複本的任何其他需求。

下一步

- 瞭解網路交換器和實體網路需求。 請參閱 實體網路需求。

- 瞭解如何使用網路 ATC 簡化主機網路。 請參閱 使用網路 ATC 簡化主機網路功能。

- 對 故障轉移叢集網路基本概念進行筆刷。

- 請參閱使用 Azure 入口網站 部署。

- 請參閱 使用 Azure Resource Manager 範本部署。