將您的 AI 專案設定為使用 Azure AI 模型推斷

如果您已經有 Azure AI Foundry 中的 AI 專案,模型目錄預設會將來自第三方模型提供者的模型部署為專案中的獨立端點。 每個模型部署都有自己的一組 URI 和認證來存取它。 另一方面,Azure OpenAI 模型會部署到 Azure AI 服務資源或 Azure OpenAI 服務資源。

您可以使用 Azure AI 模型推斷,變更此行為,並將這兩種類型的模型部署到 Azure AI 服務資源。 設定之後, 支援隨用隨付計費的模型即服務模型部署會改為連線的 Azure AI 服務資源 到專案本身,為您提供單一端點和認證,以存取 Azure AI Foundry 中部署的所有模型。 您可以使用相同方式管理 Azure OpenAI 和第三方模型提供者模型。

此外,將模型部署至 Azure AI 模型推斷會帶來額外的優點:

- 路由功能。

- 自訂內容篩選。

- 全域容量部署類型。

- 使用角色型訪問控制進行無密鑰驗證 。

在本文中,您將瞭解如何將專案設定為使用 Azure AI 模型推斷中部署在 Azure AI 服務中的模型。

必要條件

若要完成本教學課程,您需要:

Azure 訂用帳戶。 如果您使用 GitHub Models,您可以升級您的體驗,並在程式中建立 Azure 訂用帳戶。 如果是您的情況,請閱讀 從 GitHub 模型升級至 Azure AI 模型推斷 。

Azure AI 服務資源。 如需詳細資訊,請參閱 建立 Azure AI 服務資源。

Azure AI 專案和 Azure AI Hub。

提示

布建 AI 中樞時,會建立 Azure AI 服務資源,並連接兩個資源。 若要查看哪些 Azure AI 服務資源已連線到您的專案,請移至 Azure AI Foundry 入口>網站>管理中心連線的資源,並尋找 AI 服務類型的連線。

將項目設定為使用 Azure AI 模型推斷

若要將項目設定為使用 Azure AI 服務中的 Azure AI 模型推斷功能,請遵循下列步驟:

在頂端導覽列中,選取右上角的 [預覽功能 ] 圖示。 內容相關刀鋒視窗會顯示在畫面右側。

開啟將模型部署至 Azure AI 模型推斷服務的功能。

關閉面板。

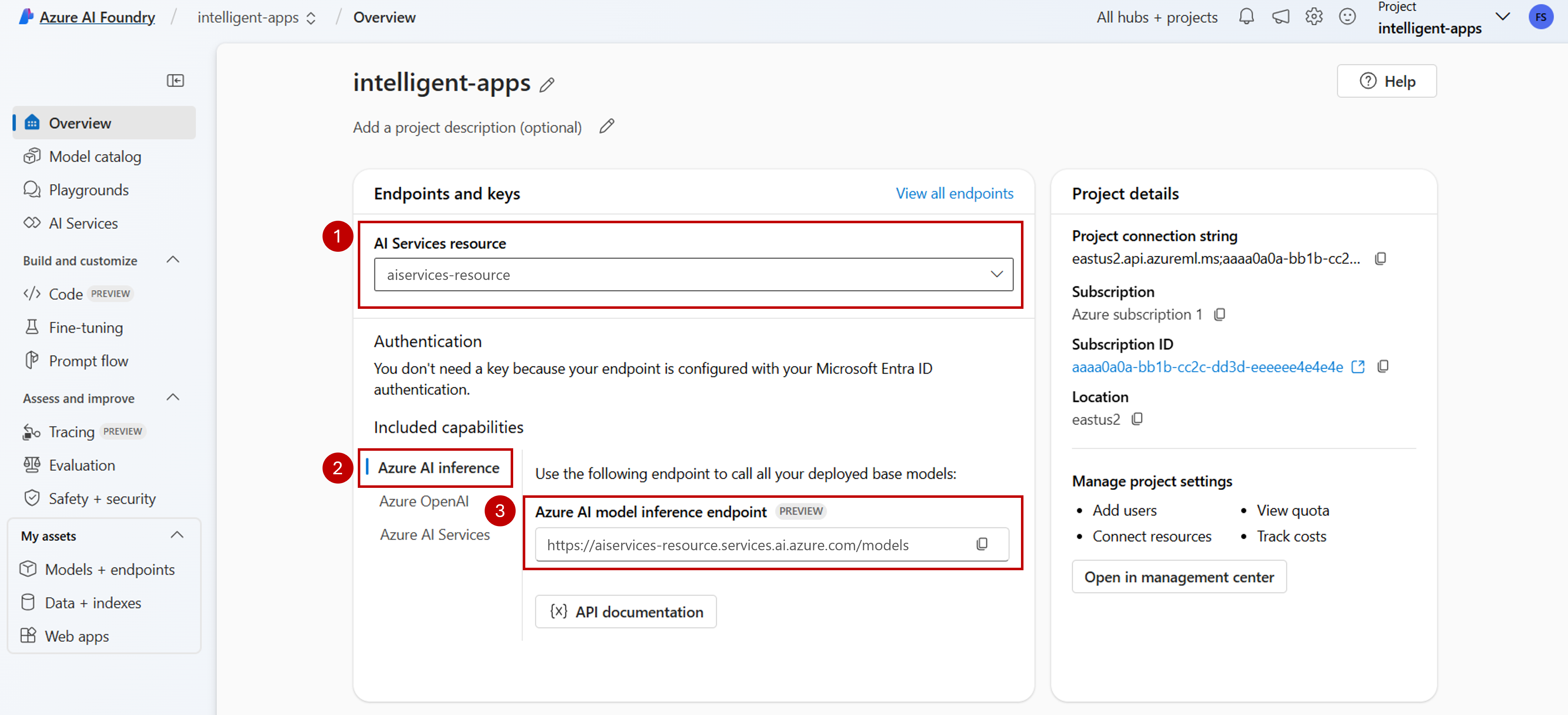

在專案的登陸頁面中,識別連線到您專案的 Azure AI 服務資源。 如果需要,請使用下拉式清單來變更您所連線的資源。

如果下拉式清單中未列出任何資源,您的 AI 中樞就不會連線到該資源。 透過下列方式建立新的連線:

在畫面左下角,選取 [管理中心]。

在 [連線] 區段中,選取 [新增連線]。

選取 [Azure AI 服務]。

在瀏覽器中,在您的訂用帳戶中尋找現有的 Azure AI Services 資源。

請選取新增連線。

新的聯機會新增至您的中樞。

返回專案的登陸頁面以繼續,現在選取新建立的連線。 如果頁面未立即顯示,請重新整理頁面。

在 [包含的功能] 下,確定您選取 [Azure AI 推斷]。 Azure AI 模型推斷端點 URI 會連同認證一起顯示,以取得其存取權。

提示

每個 Azure AI 服務資源都有單 一 Azure AI 模型推斷端點 ,可用來存取其上的任何模型部署。 相同的端點會根據所設定的模型來提供多個模型。 瞭解 端點的運作方式。

記下端點 URL 和認證。

在 Azure AI 模型推斷中建立模型部署

針對您想要在 Azure AI 模型推斷下部署的每個模型,請遵循下列步驟:

移至 Azure AI Foundry 入口網站中的 [模型目錄] 區段。

捲動至您感興趣的模型,然後加以選取。

您可以在模型卡片中檢閱模型的詳細數據。

選取 [部署]。

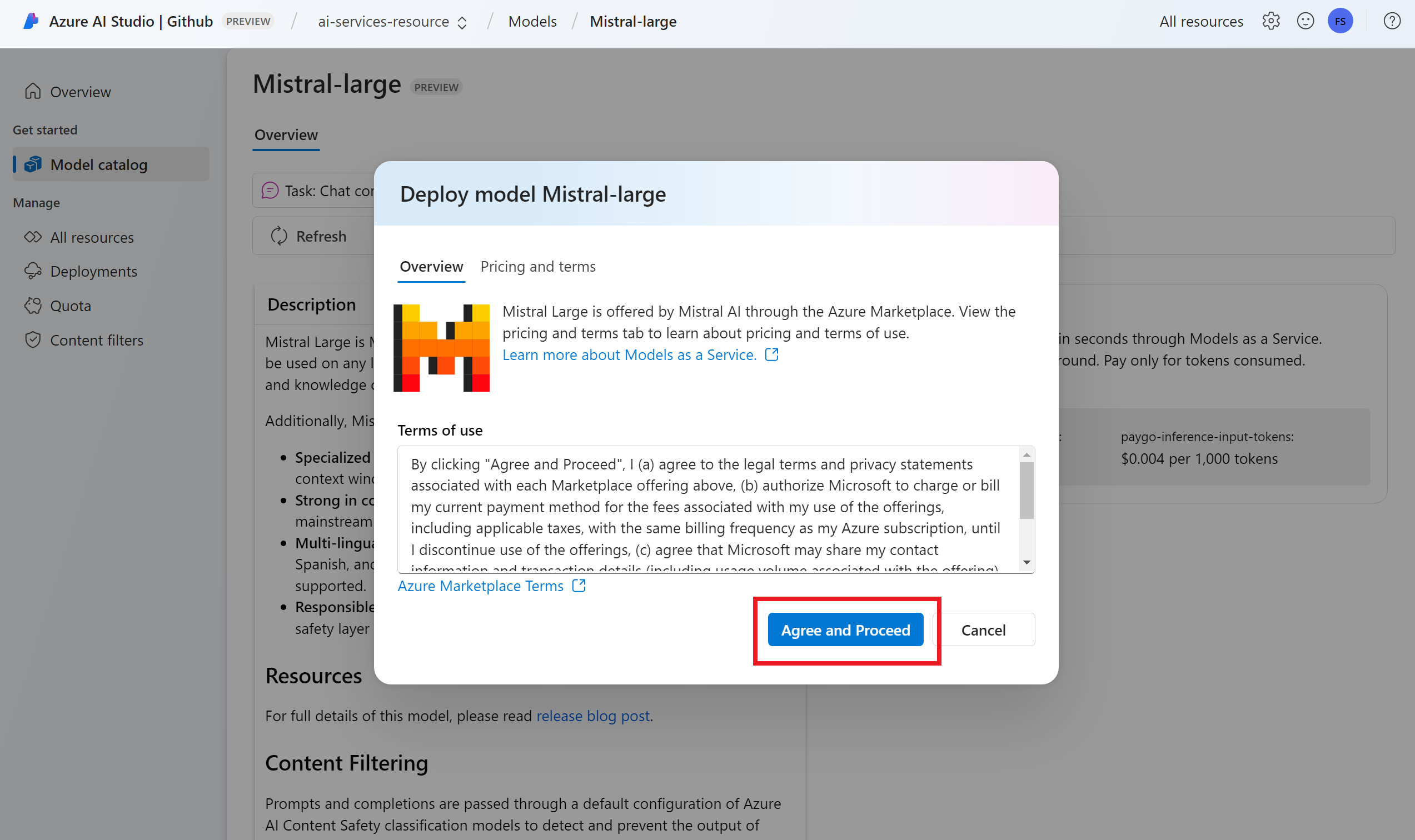

對於需要更多合約條款的模型提供者,系統會要求您接受這些條款。 選取 [訂閱並部署],以接受這些案例的條款。

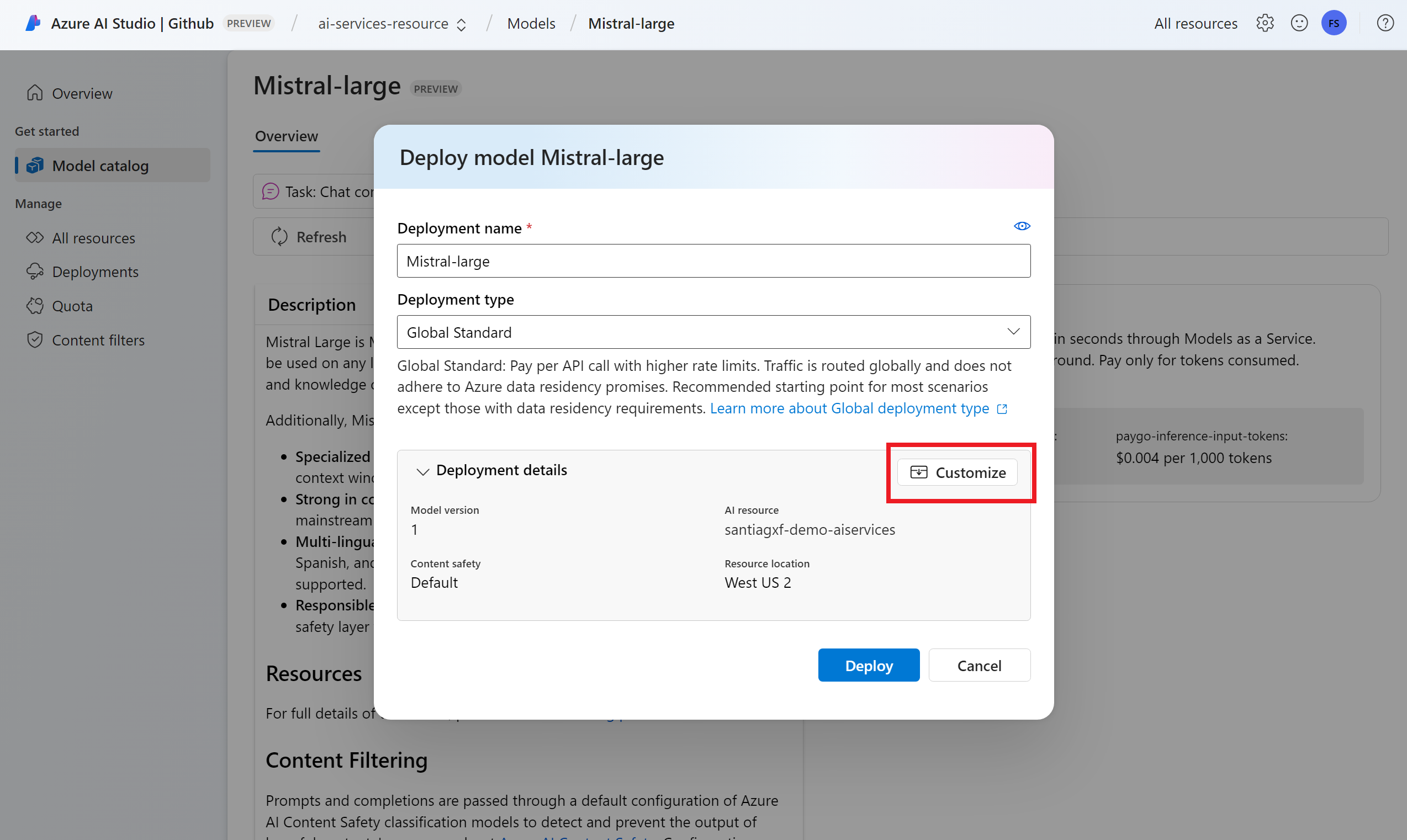

此時您可以設定部署設定。 根據預設,部署會接收您要部署的模型名稱。 部署名稱用於 參數中

model,要求路由至此特定模型部署。 它可讓您在附加特定組態時設定模型的特定名稱。 例如,o1-preview-safe針對具有嚴格內容安全性內容篩選的模型。我們會根據您的項目自動選取 Azure AI 服務連線,因為您已開啟將模型部署至 Azure AI 模型推斷服務的功能。 使用 [ 自定義] 選項,根據您的需求變更連線。 如果您要在標準部署類型下部署,模型必須在 Azure AI 服務資源的區域中提供。

選取 [部署]。

部署完成後,您會看到端點 URL 和認證,以取得模型的存取權。 請注意,現在提供的 URL 和認證與 Azure AI 模型推斷端點專案的登陸頁面相同。

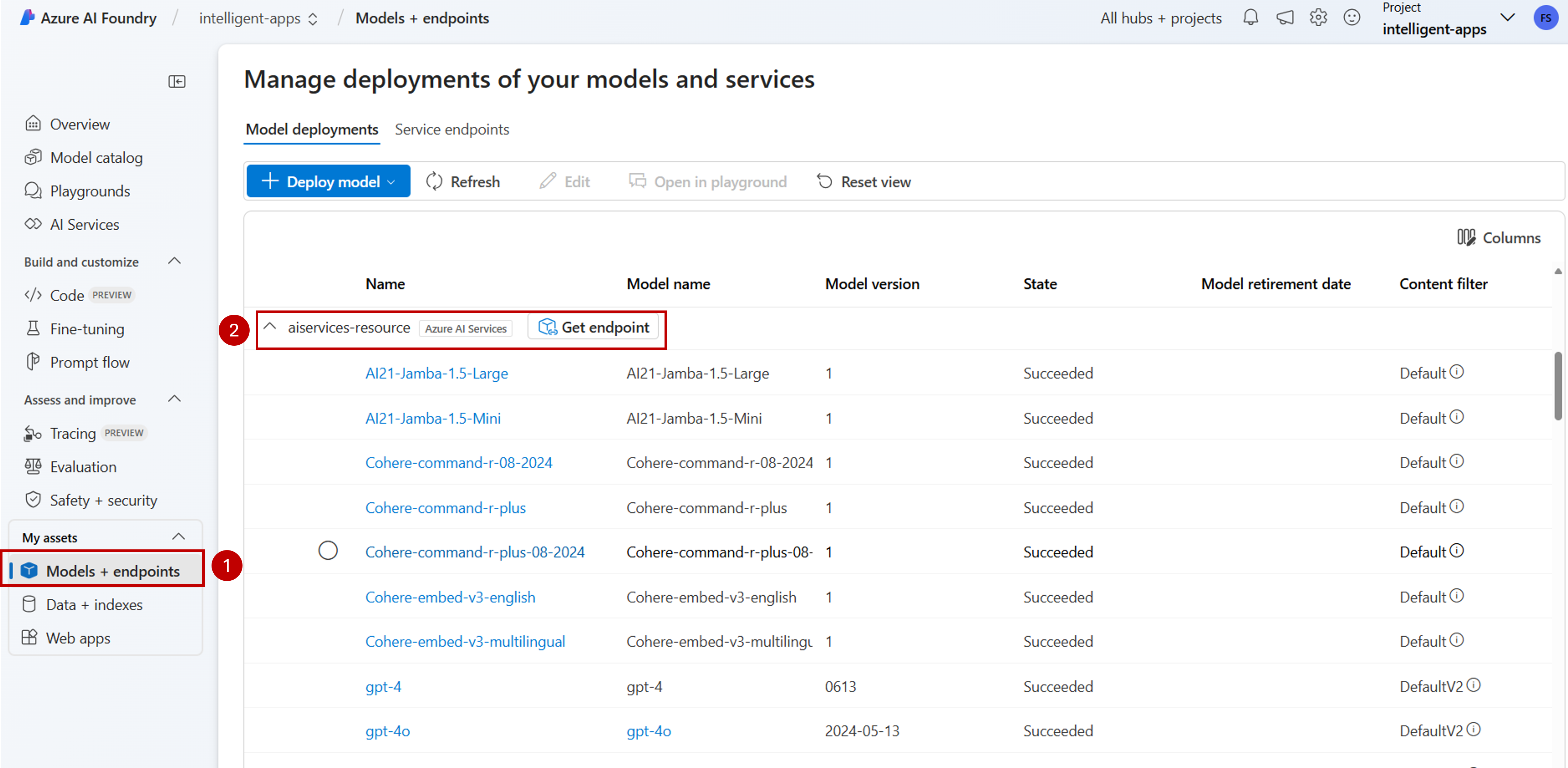

您可以移至 [模型 + 端點 ] 區段,並尋找與 AI Services 資源連線的群組,以檢視資源下可用的所有模型:

使用新的端點升級您的程序代碼

設定 Azure AI 服務資源之後,您就可以開始從程式代碼取用它。 您需要端點 URL 和金鑰,您可以在 [ 概觀 ] 區段中找到:

您可以使用任何支援的 SDK,從端點取得預測。 正式支援下列 SDK:

- OpenAI SDK

- Azure OpenAI SDK

- Azure AI 推斷 SDK

- Azure AI Foundry SDK

如需詳細資訊和範例,請參閱支援的語言和 SDK 一節。 下列範例示範如何搭配新部署的模型使用 Azure AI 模型推斷 SDK:

使用套件管理員安裝套件 azure-ai-inference,例如 pip:

pip install azure-ai-inference>=1.0.0b5

警告

Azure AI Services 資源需要適用於 Python 的版本 azure-ai-inference>=1.0.0b5 。

然後,您可以使用套件來取用模型。 下列範例會示範如何建立用戶端以取用聊天完成:

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

model = ChatCompletionsClient(

endpoint="https://<resource>.services.ai.azure.com/models",

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

產生您的第一個聊天完成:

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

使用 參數 model="<deployment-name> 將要求路由傳送至此部署。

部署可作為特定組態下指定模型的別名。 請參閱 路由 概念頁面,以瞭解 Azure AI Services 如何路由部署。

從無伺服器 API 端點移至 Azure AI 模型推斷

雖然您已將專案設定為使用 Azure AI 模型推斷,但現有的模型部署仍會以無伺服器 API 端點的形式存在於專案中。 這些部署不會為您移動。 因此,您可以逐步升級任何參考先前模型部署的現有程序代碼。 若要開始移動模型部署,我們建議使用下列工作流程:

在 Azure AI 模型推斷中重新建立模型部署。 此模型部署可在 Azure AI 模型推斷端點下存取。

升級您的程式代碼以使用新的端點。

藉由移除無伺服器 API 端點來清除專案。

使用新的端點升級您的程序代碼

在 Azure AI 服務下部署模型之後,您可以將程式代碼升級為使用 Azure AI 模型推斷端點。 無伺服器 API 端點與 Azure AI 模型推斷的運作方式主要差異在於端點 URL 和模型參數。 雖然無伺服器 API 端點在每個模型部署中都有一組 URI 和密鑰,但 Azure AI 模型推斷對於其中所有端點只有一個。

下表摘要說明您必須介紹的變更:

| 屬性 | 無伺服器 API 端點 | Azure AI 模型推斷 |

|---|---|---|

| 端點 | https://<endpoint-name>.<region>.inference.ai.azure.com |

https://<ai-resource>.services.ai.azure.com/models |

| 認證 | 每個模型/端點一個。 | 每個 Azure AI 服務資源一個。 您也可以使用Microsoft Entra ID。 |

| 模型參數 | 無。 | 必要。 使用模型部署的名稱。 |

從您的專案清除現有的無伺服器 API 端點

重構程式代碼之後,您可能會想要刪除專案內現有的無伺服器 API 端點(如果有的話)。

針對部署為無伺服器 API 端點的每個模型,請遵循下列步驟:

選取 [模型 + 端點]。

識別無伺服器類型的端點,然後選取您想要刪除的端點。

選取 [刪除] 選項。

警告

無法還原此作業。 請確定端點目前未由任何其他用戶或程式代碼段使用。

選取 [ 刪除] 以確認作業。

如果您從其他專案建立 與這個端點的無伺服器 API 連線 ,則不會移除這類連線,並繼續指向不存在的端點。 刪除任何連線以避免錯誤。

限制

將項目設定為使用 Azure AI 模型推斷時,請考慮下列限制:

- 只有支援隨用隨付計費的模型(模型即服務)可供部署至 Azure AI 模型推斷。 需要訂用帳戶 (Managed Compute) 計算配額的模型,包括自定義模型,只能在指定的專案中部署為受控在線端點,並且繼續使用自己的端點 URI 和認證集來存取。

- 依預設,隨用隨付計費和受控計算供應專案都可使用的模型會部署至 Azure AI 服務資源中的 Azure AI 模型推斷。 Azure AI Foundry 入口網站不提供將其部署至受控在線端點的方式。 您必須關閉設定專案以使用 Azure AI 模型推斷或使用 Azure CLI/Azure ML SDK/ARM 範本來執行部署中所述的功能。

下一步

- 將更多模型 新增至您的端點。