练习 - 图像审核

Contoso 露营商店为客户提供上传照片以补充产品评论的功能。 客户发现这一功能非常有用,因为它能让他们在一般营销图像之外,深入了解产品的外观和功能。 我们可以应用 AI 模型来检测客户发布的图像是否有害,然后根据检测结果采取必要的预防措施。

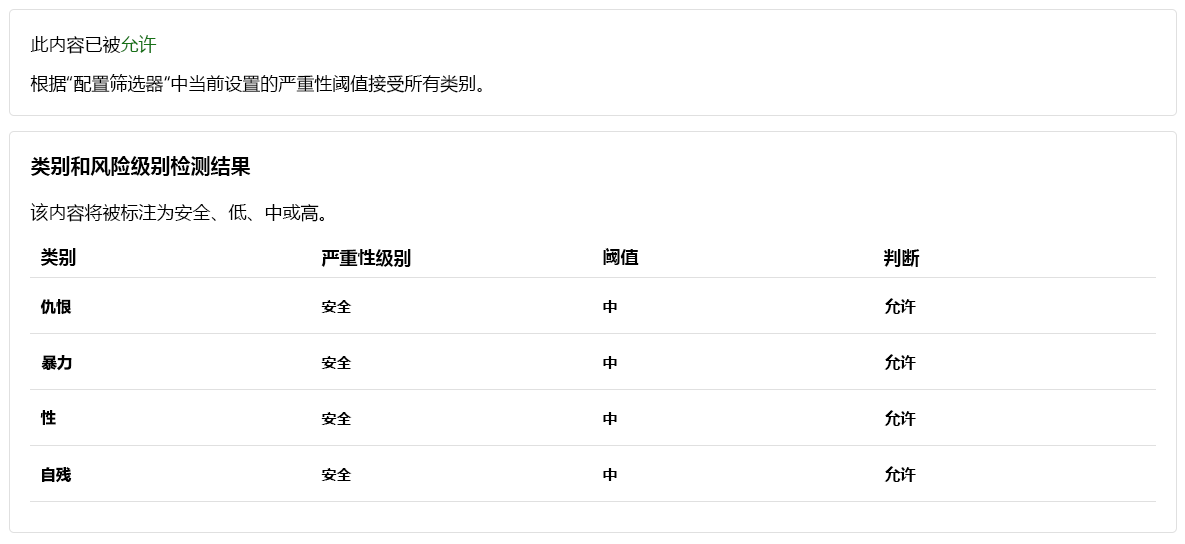

安全内容

我们先来测试一张家庭露营的图像!

果然,该图像内容在所有类别中都是“允许”,“严重性级别”是“安全”。

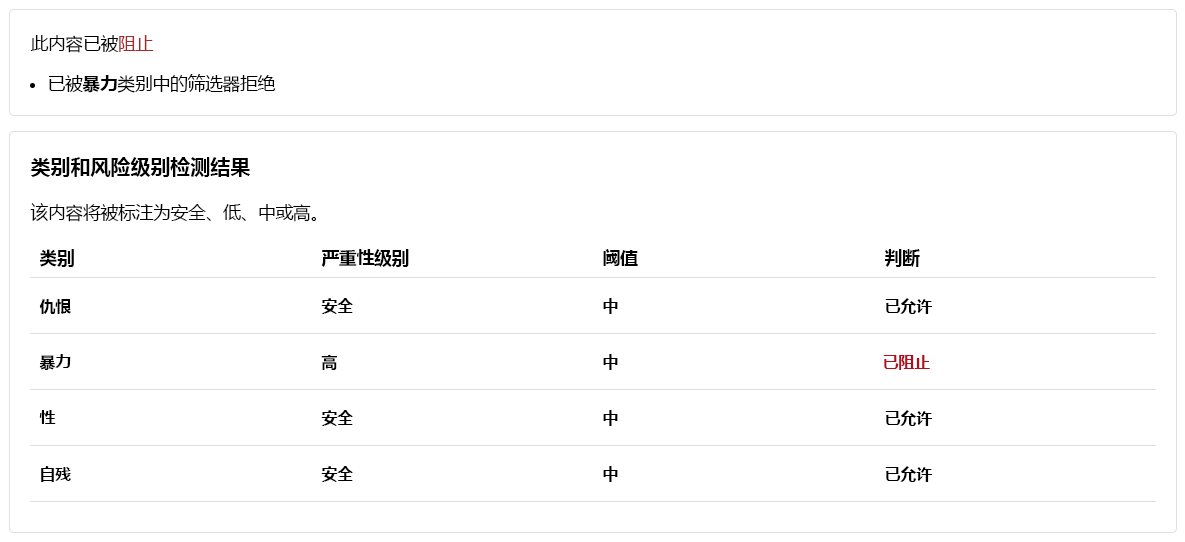

暴力内容

我们还应预见到客户可能会发布有害的图像内容。 为了确保我们能应对这种情况,我们来测试一下有害图像内容的检测。

注意

用于测试的图像包含一幅熊袭击的图片。 在“图像预览”中,图像会默认变模糊。 不过,你也可以使用“模糊图像”切换来更改这一设置。

- 选择“浏览文件”并上传

bear-attack-blood.JPG文件。 - 将所有“阈值级别”设置为“中等”。

- 选择“运行测试”。

果然,该内容“被屏蔽”,并被“严重性级别”为“高”的“暴力”筛选器拒绝。

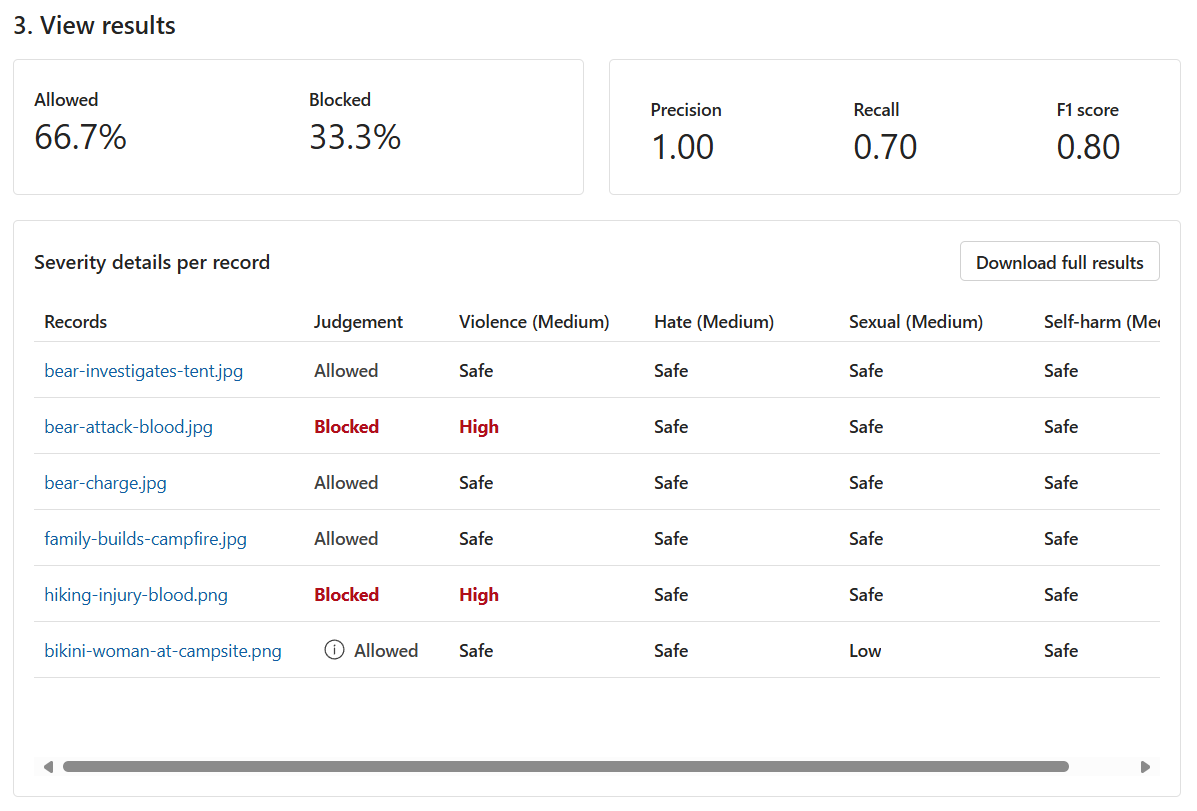

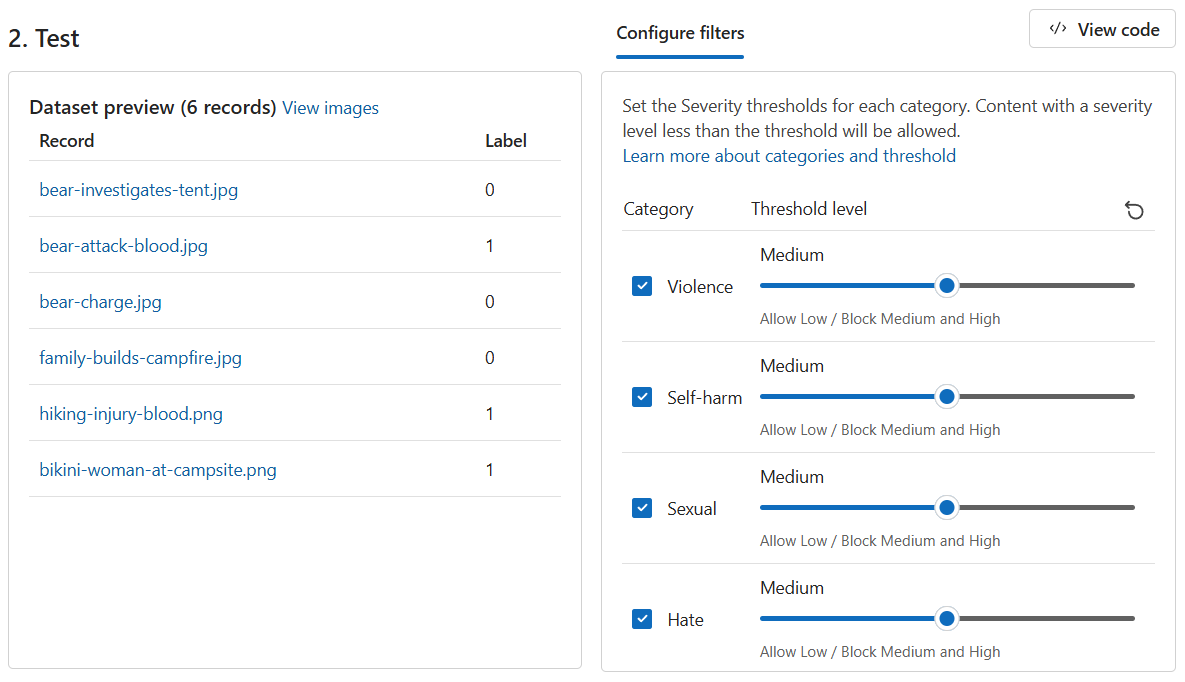

运行批量测试

到目前为止,我们已经测试了单个孤立图像的图像内容。 但是,如果有图像内容的批量数据集,我们就可以一次性测试批量数据集,并根据模型的性能获得指标。

我们有一个批量图像数据集,这些图像由客户提供。 该数据集还包含有害图像示例,用于测试模型检测有害内容的能力。 该数据集中的每个记录都包括一个标签,用于指示内容是否有害。 让我们再做一轮测试,但这次是使用数据集!

切换到“运行批量测试”选项卡。

选择“浏览文件”并上传

bulk-image-moderation-dataset.zip文件。在“数据集预览”部分,浏览“记录”及其相应的“标签”。 0 指示内容是可接受的(无害)。 1 指示内容是不可接受的(有害内容)。

将所有“阈值级别”设置为“中等”。

选择“运行测试”。

根据结果,是否还有改进的空间? 如果是,请调整“阈值级别”,直到“精准率”、“查全率”和“F1 分数”指标更接近 1。