引入和转换实时数据

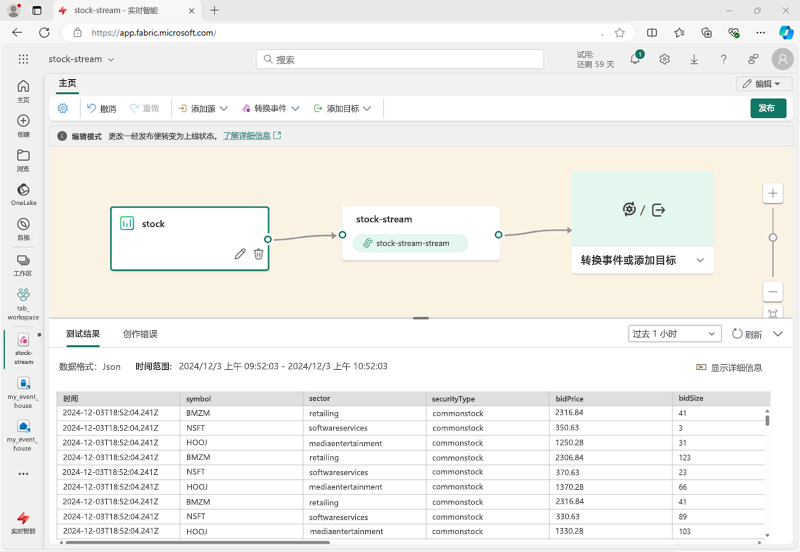

Microsoft Fabric 中的 Eventstream 用于捕获、转换和加载来自各种流数据源的实时数据。 在系统中设置 Eventstream 时,将定义永久运行的数据处理引擎来引入和转换实时数据。 你告知它从何处获取数据、向何处发送数据,以及如何根据需要更改数据。

Eventstream 的数据源

Microsoft Fabric 中的 Eventstream 支持各种数据源,包括:

- 外部服务,如 Azure 存储、Azure 事件中心、Azure IoT 中心、Apache Kafka 中心、关系数据库服务中的变更数据捕获 (CDC) 源等。

- Fabric 事件,例如对 Fabric 工作区中项的更改、OneLake 数据存储中的数据更改以及与 Fabric 作业关联的事件。

- 示例数据,其中包括可帮助你探索 Microsoft Fabric 中的实时分析场景的一系列示例。

提示

有关支持的源的详细信息,请参阅 Fabric 实时中心支持的源。

Eventstream 中的数据转换

你可以在数据于 Eventstream 中流动时对其进行转换,从而能够在存储数据之前对其进行过滤、汇总和重塑。 可用转换包括:

- 筛选:使用“筛选”转换可以根据输入中的字段值筛选事件。 根据数据类型(数字或文本),转换将保留与所选条件(例如

null或is not null)匹配的值。 - 管理字段:使用此转换可以添加、删除、更改数据类型,或重命名来自输入或其他转换的字段。

- 聚合:使用“聚合”转换可以在一段时间内每次发生新事件时计算聚合(总和、最小值、最大值或平均值)。 此操作还允许重命名这些计算列,并根据数据中的其他维度筛选或切片聚合。 在同一转换中可以有一个或多个聚合。

- 分组依据:使用分组依据转换来计算某个时间窗口内所有事件的聚合。 可以按一个或多个字段中的值进行分组。 就像聚合转换允许重命名列一样,但提供了更多聚合选项,并包含更复杂的时间窗口选项。 与“聚合”类似,你可以为每个转换添加多个聚合。

- 联合:使用“联合”转换可以连接两个或多个节点,并将具有共享字段(具有相同名称和数据类型)的事件添加到一个表中。 不匹配的字段将被删除,不包含在输出中。

- 扩展:使用此数组转换可为数组中的每个值创建一个新行。

- 联接:使用此转换可以根据两个流之间的匹配条件合并这两个流中的数据。

提示

有关支持的转换的详细信息,请参阅使用事件处理程序编辑器处理事件数据。

Eventstream 中的数据目标

可以将流中的数据加载到以下目标:

- Eventhouse:通过此目标,可以将实时事件数据引入 Eventhouse,可以使用 Kusto 查询语言 (KQL) 来查询和分析数据。

- 湖屋:通过此目标,你可以在将实时事件引入湖屋之前转换实时事件。 实时事件会转换为 Delta Lake 格式,然后存储在指定的湖屋表中。

- 派生流:派生流用于将 Eventstream 的输出重定向到另一个Eventstream。 派生流表示流处理后转换的默认流。

- Fabric 激活器:通过此目标,可以将实时事件数据直接连接到 Fabric 激活器;它是一种智能代理,可根据流中的值自动执行操作。

- 自定义终结点:使用此目标,可以将实时事件路由到自定义终结点。 如果要将实时数据定向到外部系统或 Microsoft Fabric 外部的自定义应用程序,此目标非常有用。

提示

有关支持的源的详细信息,请参阅在 Eventstream 中添加和管理目标。