浏览模型目录中的语言模型

为生成式 AI 应用选择语言模型非常重要,因为它会影响应用的工作效果。 当你使用 Azure AI Foundry 开发生成式 AI 应用时,将会生成一个聊天应用程序,该应用程序可以使用语言模型来实现多种目的:

- 理解用户的问题。

- 搜索相关上下文。

- 生成用户问题的答案。

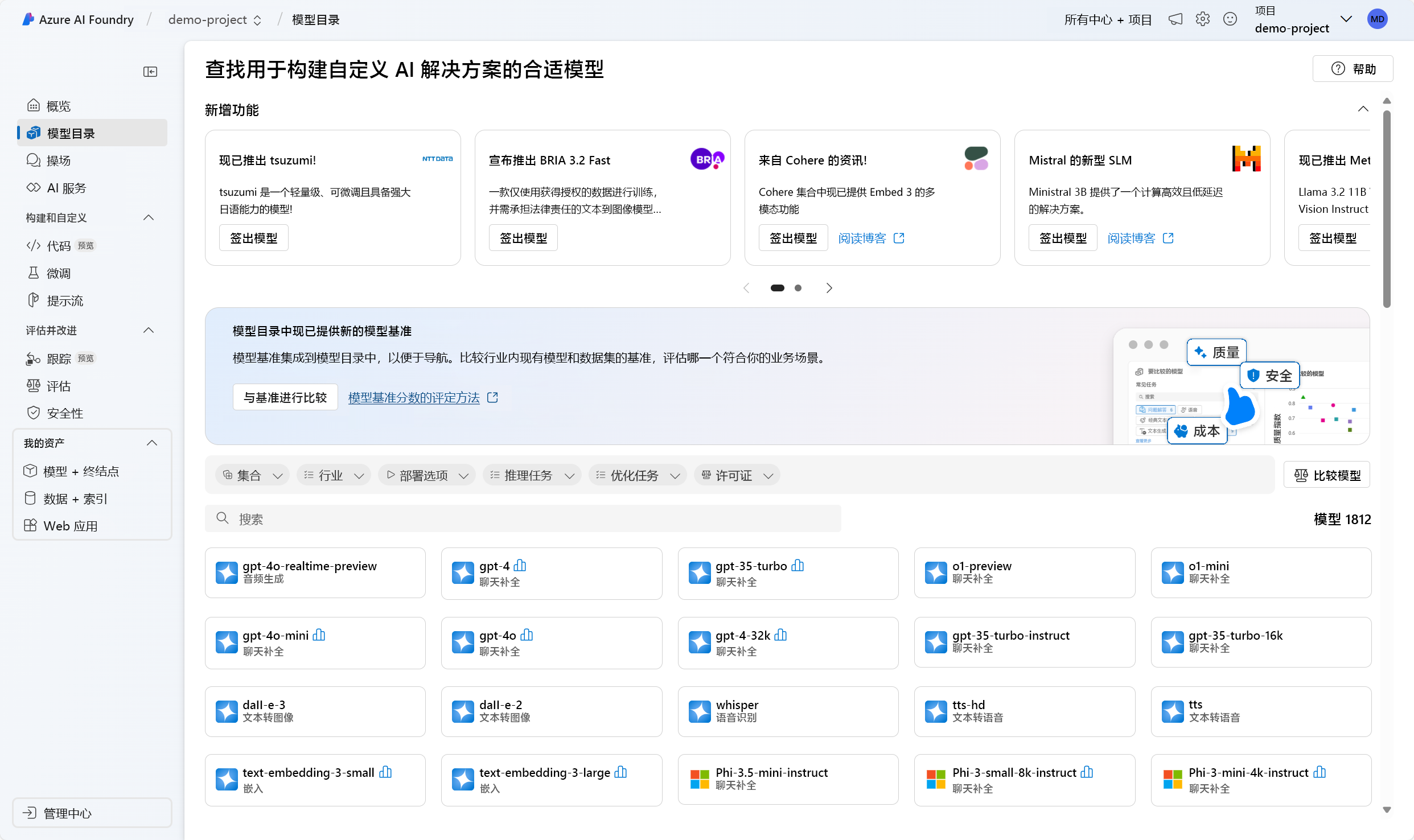

在 Azure AI Foundry 门户中,可以浏览模型目录中可用的语言模型。 让我们浏览通过 Azure AI 提供的模型目录和语言模型类型。

浏览模型目录

在 Azure AI Foundry 门户中,可以导航到模型目录以浏览所有可用的语言模型。 此外,可以将任何模型从 Hugging Face 开源库导入模型目录。

Azure AI Foundry 模型目录与 Hugging Face 和其他源提供的模型集成。 通过模型目录,可以浏览、微调和部署模型。

重要

模型可用性因位置(也称为区域)而异。 位置是在 AI 中心级别指定的。 创建新的 AI Hub 时,可以使用位置帮助程序指定要部署的模型,以获取可部署该模型的位置列表。 还可以浏览模型摘要表和区域可用性来了解详细信息。

浏览语言模型

模型目录中可用的基础模型或语言模型已预先经过训练。 可以将语言模型部署到终结点或微调模型,使其在处理专门的任务或者在提供特定领域的知识时表现更好。

选择哪个模型取决于你的用例和部署偏好。 首先,需要考虑你要让模型执行的任务。 例如:

- 文本分类

- 标记分类

- 问答

- 汇总

- 翻译

一些常用于处理各种任务的语言模型包括:

| 模型 | 说明 |

|---|---|

| BERT(来自 Transformer 的双向编码器表示形式) | 侧重于使用标记前后的上下文对信息进行编码(双向)。 常用于需要微调模型以执行特定任务(如文本分类和问题解答)的场景。 |

| GPT(生成式预训练 Transformer) | 经过专门训练以创建连贯且上下文相关的文本,最常用于文本生成和聊天补全等任务。 |

| LLaMA(大型语言模型 Meta AI) | 由 Meta 创建的模型系列。 训练 LLaMA 模型时,侧重点在于提供更多的训练数据,而不是增加模型的复杂性。 可以使用 LLaMA 模型进行文本生成和聊天补全。 |

| Phi-3-mini(phi 模型的 3.8B 参数变体) | 一个先进的轻型模型,已针对资源受限的环境和本地推理(例如在手机上)进行优化,支持最多包含 12.8 万个标记的长上下文提示。 开发该模型时重点考虑了其安全性、一致性以及从人类反馈中进行强化学习。 |

选择任务并筛选出适合你目标的可用模型后,可以查看 Azure AI Foundry 中的模型摘要,以考虑其他一些因素:

- 模型功能:评估语言模型的功能,以及它们与任务的符合程度。 例如,BERT 之类的模型更善于理解短文本。

- 预先训练数据:考虑用于预先训练语言模型的数据集。 例如,GPT-2 针对 Internet 中可能导致偏差的未经筛选内容进行训练。

- 局限性和偏见:注意语言模型中可能存在的任何局限性或偏见。

- 语言支持:了解哪些模型提供用例所需的特定语言支持或多语言功能。

提示

尽管 Azure AI Foundry 提供了模型目录中每个语言模型的说明,但你还可以通过相应的模型卡找到有关每个模型的详细信息。 模型卡在每个模型的概述中引用,并托管在 Hugging Face 的网站上

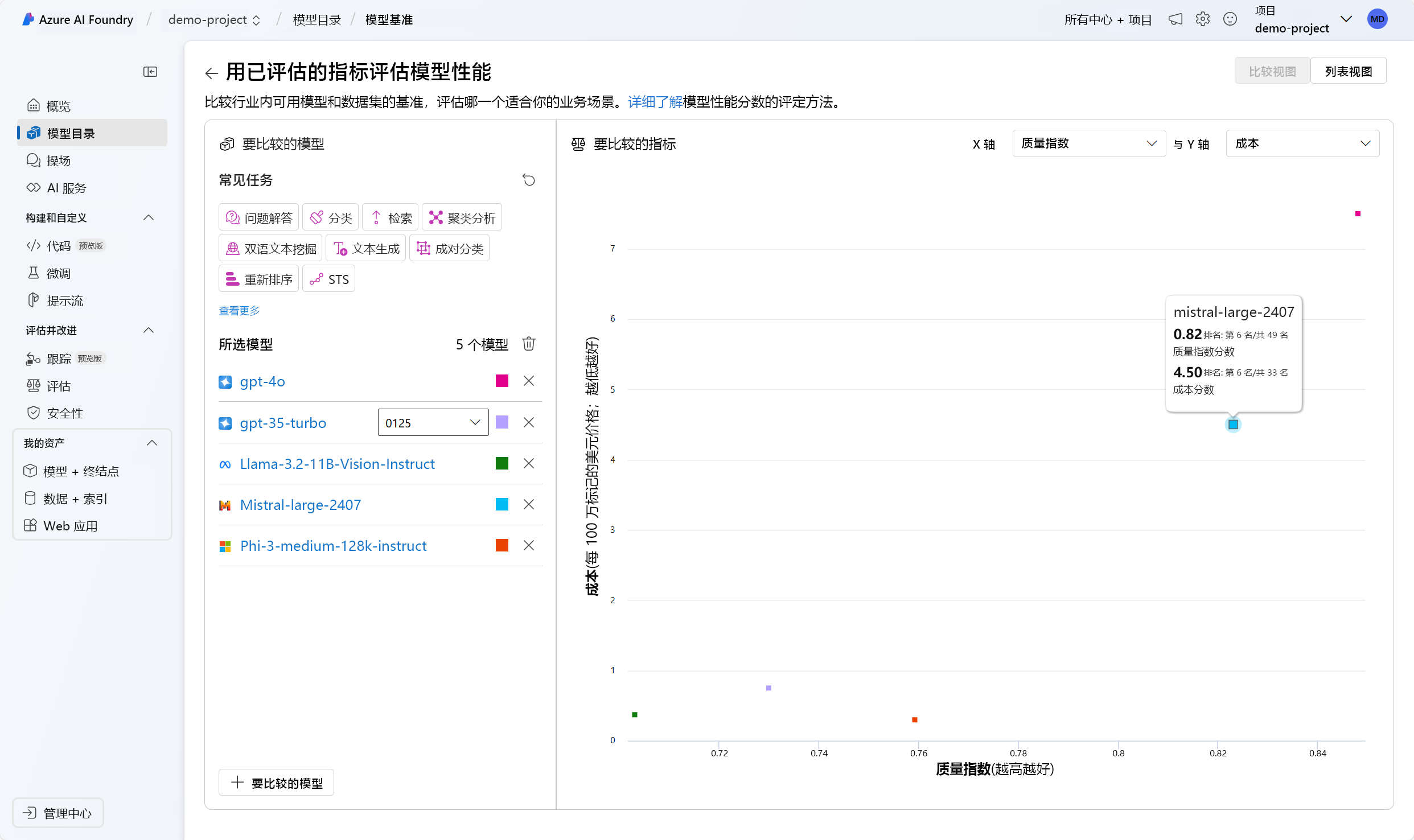

比较模型之间的基准

在浏览语言模型时,还可以在部署和集成模型之前,通过比较可用模型的基准来评估模型的质量。 基准相当于语言模型的成绩单。 基准可帮助你通过使用特定测试或任务将某个模型与其他模型进行比较,来了解该模型的性能。 Azure AI Foundry 门户中的模型基准根据基准测试指标,为给定任务提供特选的、表现最佳的模型列表。

用于评估语言模型性能的一些常用指标包括:

| 指标 | 描述 |

|---|---|

| 准确性 | 准确度评分在数据集和模型级别提供。 在数据集级别,评分是对数据集中所有示例计算的准确度指标的平均值。 除了使用 pass@1 指标的 HumanEval 数据集之外,所用准确度指标在所有情况下都是完全匹配的。 完全匹配只是根据数据集将模型生成的文本与正确答案进行比较,如果生成的文本与答案完全匹配,则报告 1,否则报告 0。 Pass@1 用于衡量在代码生成任务中通过了一组单元测试的模型解决方案的比例。 在模型级别,准确度评分是每个模型的数据集级准确度的平均值。 |

| 一致性 | 连贯性可评估语言模型可以在多大程度上生成流畅、可自然读取且类似于人类语言的输出。 |

| 流畅度 | 流利度可评估生成式 AI 预测答案的语言熟练程度。 它评估生成的文本在多大程度上符合语法规则、句法结构和用词适当,从而产生语言正确和自然的响应。 |

| GPTSimilarity | GPTSimilarity 可量化基本事实句子(或文档)与 AI 模型生成的预测句子之间的相似性。 在计算时,将首先对基本事实和模型预测使用嵌入 API 来计算句子级嵌入。 这些嵌入可捕获句子的语义和上下文,用于表示句子的高维矢量表示形式。 |

| 真实性 | 真实性可衡量语言模型生成的答案与来自输入源的信息的一致程度。 |

| 相关性 | 相关性可衡量语言模型生成的响应与给定问题相关和直接相关的程度。 |

注意

开发和评估使用语言模型的应用程序时,必须使用指标来衡量模型和应用程序的性能。 用于比较不同模型的基准所用的指标同样可用于在开发过程中评估单个模型的性能。 这些指标可帮助你了解模型的表现并找出需要改进的方面。

选择符合需求的模型可能是一个迭代过程。 接下来,你将了解如何部署模型,以便可以对它进行测试,并试着根据你的用例优化该模型。